Wie funktionieren die moderierten Inhalte bei Facebook? – How Does Facebook Moderate Content?

Sprachauswahl 📢

Veröffentlicht am: 11. März 2019 / Update vom: 11. März 2019 – Verfasser: Konrad Wolfenstein

Ein Kernthema, mit dem sich Facebook beschäftigt hat, war die Frage der Moderation von Inhalten, die gegen die Nutzungsbedingungen verstoßen. Eine heikle Frage, die mit Fragen der Meinungsfreiheit verknüpft ist und wie Facebook als öffentliches Forum funktioniert. Facebook verbietet gewalttätiges, sexuell eindeutiges und allgemein anstößiges Material. Dieser Inhalt wird von den Benutzern manuell markiert und von den Mitarbeitern überprüft, die feststellen, ob ein Beitrag gegen bestimmte Bestimmungen der Unternehmensrichtlinie verstoßen hat. Twitter und YouTube verwenden auch ein ähnliches System, um Inhalte in ihren sozialen Netzwerken zu überwachen.

Der größte Teil dieser Arbeit wird an Dritte ausgelagert. Content-Moderatoren auf Facebook werden weitaus schlechter bezahlt als normale Angestellte von Facebook. Die jährliche Vergütung für Content-Moderatoren reicht von nur 1.404 US-Dollar pro Jahr für die Moderatoren, die in anderen Ländern wie Indien und Bangladesch arbeiten, bis hin zu 28.800 US-Dollar pro Jahr für die Drittarbeiter, die in den USA bei Facebook arbeiten.

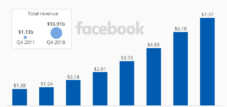

Facebook hat Mühe gehabt, sein Problem der Inhaltsmoderation anzugehen. Im Jahr 2009, als das Netzwerk nur 120 Millionen aktive Nutzer pro Monat hatte, beschäftigte es nur 12 Personen, um den Inhalt jedes markierten Beitrags eines Nutzers zu moderieren. Mit einer weltweiten Reichweite von rund 2,3 Milliarden Nutzern beschäftigt das Unternehmen rund 15.000 Mitarbeiter, um gewalttätige, sexuell explizite und anstößige Inhalte im Internet anzusehen und zu beseitigen.

A core issue Facebook has grappled with has been the question of moderating content that violates its terms and conditions, a thorny question that is intertwined with questions of free speech and how Facebook functions as a public forum. Facebook bans violent, sexually explicit, and generally offensive material. This content gets manually flagged by users and reviewed by employees, who determine whether a post has violated specific terms in company policy. Twitter and YouTube also employ a similar system to monitor content put on their social networks.

Most of that labor is outsourced to third parties. Content moderators on Facebook are paid abysmally less than regular salaried Facebook employees. Annual pay for content moderators ranges anywhere from just $1,404 per year, for the moderators who work in other countries like India and Bangladesh, to $28,800 per year for those third-party workers who work in the U.S. Facebook employees on average make $240,000 per year.

Facebook has struggled to address its content moderation problem. In 2009, when the network only had 120 million monthly active users, it employed only 12 people to moderate the content of every flagged post by a user. Now with a worldwide reach of about 2.3 billion users, the company employs around 15,000 workers to view and get rid of violent, sexually explicit, and offensive content on the internet.