Künstliche Intelligenz im Finanzjournalismus: Bloomberg kämpft mit fehlerhaften KI-Zusammenfassungen

Xpert Pre-Release

Sprachauswahl 📢

Veröffentlicht am: 6. April 2025 / Update vom: 6. April 2025 – Verfasser: Konrad Wolfenstein

KI im Finanzjournalismus: Bloomberg kämpft mit fehlerhaften KI-Zusammenfassungen – Bild: Xpert.Digital

Sind derzeit die Grenzen von KI im Journalismus erreicht?

Sind KI-Implementation alltagstauglich? Bloomberg’s holpriger Start mit automatisierten Zusammenfassungen

Die Integration von Künstlicher Intelligenz in den Journalismus stellt Medienunternehmen vor komplexe Herausforderungen, wie der aktuelle Fall von Bloomberg zeigt. Der Finanznachrichtendienst experimentiert seit Januar 2025 mit KI-generierten Zusammenfassungen für seine Artikel, musste jedoch bereits mindestens 36 fehlerhafte Zusammenfassungen korrigieren. Diese Situation verdeutlicht die Schwierigkeiten bei der Implementierung von KI-Systemen im redaktionellen Bereich, insbesondere bezüglich der Genauigkeit, Zuverlässigkeit und des Vertrauens in automatisierte Inhalte. Die folgenden Abschnitte beleuchten die spezifischen Probleme bei Bloomberg, setzen diese in den Kontext allgemeiner KI-Herausforderungen und diskutieren mögliche Lösungsansätze für eine erfolgreiche Integration von KI im Journalismus.

Passend dazu:

- Vertrauenswürdige KI: Europas Trumpfkarte und die Chance, eine führende Rolle bei der Künstlichen Intelligenz zu übernehmen

Bloomberg’s problematischer Einstieg in KI-generierte Inhalte

Die Fehleranfälligkeit von KI-Zusammenfassungen

Bloomberg, ein weltweit führendes Unternehmen für Finanznachrichten, begann Anfang 2025 damit, KI-generierte Bulletpoints als Zusammenfassungen am Anfang seiner Artikel zu platzieren. Seit dieser Einführung am 15. Januar musste das Unternehmen jedoch mindestens drei Dutzend dieser automatisierten Zusammenfassungen korrigieren, was auf erhebliche Probleme mit der Genauigkeit der KI-generierten Inhalte hindeutet. Diese Probleme sind besonders problematisch für ein Unternehmen wie Bloomberg, das für seine präzise Finanzberichterstattung bekannt ist und dessen Informationen oft direkte Auswirkungen auf Anlageentscheidungen haben können. Die Notwendigkeit zahlreicher Korrekturen untergräbt das Vertrauen in die Zuverlässigkeit dieser neuen Technologie und wirft Fragen zur voreiligen Implementierung von KI-Systemen im Journalismus auf.

Ein besonders signifikanter Fehler ereignete sich, als Bloomberg über Präsident Trumps geplante Autozölle berichtete. Während der eigentliche Artikel korrekt angab, dass Trump die Zölle möglicherweise noch am selben Tag ankündigen würde, enthielt die KI-generierte Zusammenfassung falsche Informationen über den Zeitpunkt einer umfassenderen Zollmaßnahme. In einem anderen Fall behauptete eine KI-Zusammenfassung fälschlicherweise, dass Präsident Trump bereits 2024 Zölle gegen Kanada verhängt hätte. Solche Fehler zeigen die Grenzen der KI bei der Interpretation komplexer Nachrichten und die Risiken, wenn unüberprüfte automatisierte Inhalte veröffentlicht werden.

Neben falschen Datumsangaben umfassten die Fehler auch inkorrekte Zahlen und falsche Zuschreibungen von Handlungen oder Aussagen zu Personen oder Organisationen. Diese Art von Fehlern, oft als “Halluzinationen” bezeichnet, stellen eine besondere Herausforderung für KI-Systeme dar, da sie plausibel klingen können und somit schwer zu erkennen sind, wenn keine gründliche menschliche Überprüfung stattfindet. Die Häufigkeit dieser Fehler bei Bloomberg unterstreicht die Notwendigkeit robuster Überprüfungsprozesse und wirft Fragen zur Reife der eingesetzten KI-Technologie auf.

Bloomberg’s Reaktion auf die KI-Probleme

In einer offiziellen Stellungnahme betonte Bloomberg, dass 99 Prozent der KI-generierten Zusammenfassungen den redaktionellen Standards entsprechen würden. Das Unternehmen veröffentlicht laut eigenen Angaben täglich Tausende von Artikeln und sieht die Fehlerquote daher als relativ gering an. Bloomberg legt nach eigenen Aussagen Wert auf Transparenz und korrigiert oder aktualisiert Artikel bei Bedarf. Zudem wurde betont, dass Journalisten die volle Kontrolle darüber haben, ob eine KI-generierte Zusammenfassung veröffentlicht wird oder nicht.

John Micklethwait, Chefredakteur von Bloomberg, beschrieb in einem Essay vom 10. Januar, der auf einer Vorlesung an der City St. George’s, University of London basierte, die Gründe für KI-Zusammenfassungen. Er erklärte, dass Kunden diese schätzen, da sie schnell erkennen können, worum es in einer Geschichte geht, während Journalisten skeptischer seien. Er räumte ein, dass Reporter befürchten, Leser könnten sich nur auf die Zusammenfassungen verlassen und nicht mehr die eigentliche Geschichte lesen. Dennoch hob Micklethwait hervor, dass der Wert einer KI-Zusammenfassung ausschließlich von der Qualität der zugrunde liegenden Geschichte abhängt – und für diese seien weiterhin Menschen entscheidend.

Eine Bloomberg-Sprecherin erklärte gegenüber der New York Times, dass das Feedback zu den Zusammenfassungen generell positiv gewesen sei und das Unternehmen weiterhin an der Verbesserung der Erfahrung arbeite. Diese Aussage deutet darauf hin, dass Bloomberg trotz der aufgetretenen Probleme an der Strategie, KI für Zusammenfassungen zu nutzen, festhalten will, jedoch mit einem verstärkten Fokus auf Qualitätssicherung und Verfeinerung der eingesetzten Technologie.

KI im Journalismus: Ein branchenweit relevantes Thema

Erfahrungen anderer Medienunternehmen mit KI

Bloomberg ist nicht das einzige Medienunternehmen, das mit der Integration von KI in seine journalistischen Prozesse experimentiert. Viele Nachrichtenorganisationen versuchen herauszufinden, wie sie diese neue Technologie am besten in ihre Berichterstattung und Redaktionsarbeit einbinden können. Die Zeitungskette Gannett verwendet ähnliche KI-generierte Zusammenfassungen für ihre Artikel, und die Washington Post hat ein Tool namens “Ask the Post” entwickelt, das Antworten auf Fragen aus veröffentlichten Post-Artikeln generiert. Diese breite Adoption zeigt das erhebliche Interesse der Medienbranche an KI-Technologien, trotz der damit verbundenen Risiken und Herausforderungen.

Auch bei anderen Medienunternehmen sind Probleme mit KI-Tools aufgetreten. Anfang März entfernte die Los Angeles Times ihr KI-Tool aus einem Meinungsartikel, nachdem die Technologie den Ku-Klux-Klan als etwas anderes als eine rassistische Organisation beschrieben hatte. Dieser Vorfall verdeutlicht, dass die Herausforderungen, denen Bloomberg gegenübersteht, nicht isoliert sind, sondern symptomatisch für breitere Probleme bei der Integration von KI in den Journalismus. Es zeigt sich ein Muster, bei dem die Technologie noch nicht ausgereift genug ist, um ohne menschliche Aufsicht zuverlässig zu funktionieren, besonders bei sensiblen oder komplexen Themen.

Diese Beispiele illustrieren die Spannung zwischen dem Wunsch nach Innovation und Effizienz durch KI einerseits und der Notwendigkeit, journalistische Standards und Genauigkeit zu wahren, andererseits. Medienunternehmen müssen einen Balanceakt vollführen: Sie wollen von den Vorteilen der KI profitieren, ohne dabei das Vertrauen ihrer Leserschaft zu riskieren oder journalistische Grundprinzipien zu kompromittieren. Die Erfahrungen von Bloomberg und anderen Nachrichtenorganisationen dienen als wichtige Lehren für die gesamte Branche über die Möglichkeiten und Grenzen von KI im Journalismus.

Passend dazu:

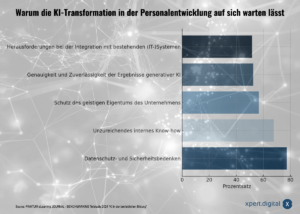

- Ein Grund für den zögerlichen KI-Einsatz: 68 % der Personalverantwortlichen beklagen mangelndes KI-Know-how in Unternehmen

Die besondere Herausforderung im Finanzjournalismus

Im Finanzsektor, wo Bloomberg als einer der führenden Nachrichtendienste agiert, sind die Anforderungen an Genauigkeit und Zuverlässigkeit besonders hoch. Die Auswirkungen falscher Informationen können hier erhebliche finanzielle Konsequenzen haben, da Anleger und Finanzexperten Entscheidungen auf Basis dieser Nachrichten treffen. Diese besondere Verantwortung macht die Integration von KI-Technologien im Finanzjournalismus zu einer noch größeren Herausforderung als in anderen Bereichen der Berichterstattung.

Interessanterweise hat die “Generalisten-KI” die Spezial-KI von Bloomberg ausgerechnet in deren Domäne, der Finanzberichtanalyse, übertroffen. Bloomberg hatte schätzungsweise mindestens 2,5 Millionen US-Dollar in die Entwicklung einer eigenen Finanz-KI investiert, doch nicht einmal ein Jahr nach der Vorstellung Ende März 2023 wurde deutlich, dass allgemeine KI-Modelle wie ChatGPT und GPT-4 in diesem Bereich bessere Ergebnisse liefern. Dies verdeutlicht die rasante Entwicklung im Bereich der künstlichen Intelligenz und die Schwierigkeit für Unternehmen, mit spezialisierten Lösungen Schritt zu halten, wenn die allgemeinen Modelle immer leistungsfähiger werden.

🎯🎯🎯 Profitieren Sie von der umfangreichen, fünffachen Expertise von Xpert.Digital in einem umfassenden Servicepaket | BD, R&D, XR, PR & Digitale Sichtbarkeitsoptimierung

Profitieren Sie von der umfangreichen, fünffachen Expertise von Xpert.Digital in einem umfassenden Servicepaket | R&D, XR, PR & Digitale Sichtbarkeitsoptimierung - Bild: Xpert.Digital

Xpert.Digital verfügt über tiefgehendes Wissen in verschiedenen Branchen. Dies erlaubt es uns, maßgeschneiderte Strategien zu entwickeln, die exakt auf die Anforderungen und Herausforderungen Ihres spezifischen Marktsegments zugeschnitten sind. Indem wir kontinuierlich Markttrends analysieren und Branchenentwicklungen verfolgen, können wir vorausschauend agieren und innovative Lösungen anbieten. Durch die Kombination aus Erfahrung und Wissen generieren wir einen Mehrwert und verschaffen unseren Kunden einen entscheidenden Wettbewerbsvorteil.

Mehr dazu hier:

Datenqualität und KI-Modelle: Die unsichtbaren Stolpersteine moderner Technologie

Fundamentale Herausforderungen der generativen KI

Das Halluzinationsproblem bei KI-Modellen

Eine der grundlegendsten Herausforderungen bei KI-Systemen, die auch bei Bloomberg’s Zusammenfassungen deutlich wurde, ist das Problem der “Halluzinationen” – also der Tendenz von KI-Modellen, plausibel klingende, aber faktisch falsche Informationen zu generieren. Dieses Problem tritt auf, wenn KI-Systeme Inhalte erzeugen, die über die ihnen zur Verfügung gestellten Informationen hinausgehen oder wenn sie Daten falsch interpretieren. Solche Halluzinationen sind besonders problematisch im Journalismus, wo Faktentreue und Genauigkeit von entscheidender Bedeutung sind.

Bei den von Bloomberg erlebten Problemen handelt es sich genau um solche Halluzinationen: Die KI “erfand” Daten wie das Einführungsdatum von Trumps Autozöllen oder behauptete fälschlicherweise, dass Trump bereits 2024 Zölle gegen Kanada verhängt hätte. Diese Art von Fehlern unterstreicht die Grenzen der aktuellen KI-Technologie, insbesondere wenn es um die präzise Interpretation komplexer Informationen geht.

Experten weisen darauf hin, dass Halluzinationen durch verschiedene Faktoren ausgelöst werden können, unter anderem durch die Art und Weise, wie Trainingsprompts und Texte kodiert sind. Large Language Models (LLMs) verknüpfen Begriffe mit einer Reihe von Zahlen, sogenannten Vektorkodierungen. Bei mehrdeutigen Wörtern wie “Bank” (die sowohl ein Finanzinstitut als auch eine Sitzgelegenheit bezeichnen kann) kann es eine Kodierung pro Bedeutung geben, um Mehrdeutigkeit zu vermeiden. Jeder Fehler bei der Kodierung und Dekodierung von Darstellungen und Texten kann dazu führen, dass die generative KI halluziniert.

Transparenz und Nachvollziehbarkeit von KI-Entscheidungen

Ein weiteres fundamentales Problem bei KI-Systemen ist die mangelnde Transparenz und Nachvollziehbarkeit ihrer Entscheidungsprozesse. Bei einigen KI-Methoden ist nicht mehr nachvollziehbar, wie eine bestimmte Vorhersage oder ein bestimmtes Ergebnis zustande kommt oder wieso ein KI-System bei einer konkreten Fragestellung zu einer bestimmten Antwort gelangt ist. Diese mangelnde Transparenz, oft als “Black-Box-Problem” bezeichnet, macht es schwierig, Fehler zu identifizieren und zu korrigieren, bevor sie veröffentlicht werden.

Die Nachvollziehbarkeit ist besonders wichtig in Bereichen wie dem Journalismus, wo Entscheidungen über Inhalte transparent und begründbar sein sollten. Wenn Bloomberg und andere Medienunternehmen nicht verstehen können, warum ihre KI falsche Zusammenfassungen generiert, wird es schwierig, systemische Verbesserungen vorzunehmen. Stattdessen sind sie auf reaktive Korrekturen angewiesen, nachdem Fehler bereits aufgetreten sind.

Diese Herausforderung wird auch von Expertinnen und Experten aus Wirtschaft und Wissenschaft als wesentlich identifiziert. Es handelt sich zwar in erster Linie um eine technische Herausforderung, sie kann jedoch in gewissen Anwendungsbereichen auch aus gesellschaftlicher oder rechtlicher Perspektive zu problematischen Resultaten führen. Im Fall von Bloomberg könnte dies zu einem Vertrauensverlust bei den Lesern führen oder im schlimmsten Fall zu finanziellen Entscheidungen auf Basis falscher Informationen.

Abhängigkeit von Datenqualität und -umfang

Überdies sind Anwendungen auf Basis von KI von der Qualität der Daten und Algorithmen abhängig. So können systematische Fehler in Daten oder Algorithmen angesichts der Größe und Komplexität der verwendeten Daten oft nicht erkannt werden. Dies ist eine weitere fundamentale Herausforderung, die Bloomberg und andere Unternehmen bei der Implementierung von KI-Systemen bewältigen müssen.

Das Problem mit der Datenmenge – die KI kann nur relativ kleine “Kontextfenster” bei der Verarbeitung von Befehlen, den Prompts, wirklich berücksichtigen – ist in den letzten Jahren zwar deutlich geschrumpft, bleibt aber eine Herausforderung. Das Google-KI-Modell “Gemini 1.5 Pro 1M” kann bereits einen Prompt im Umfang von 700.000 Wörtern oder einer Stunde Video verarbeiten – mehr als 7-mal so viel wie das aktuell beste GPT-Modell von OpenAI. Trotzdem zeigen Tests, dass die Künstliche Intelligenz zwar Daten durchsuchen kann, aber Schwierigkeiten bei der Erfassung von Zusammenhängen hat.

Passend dazu:

- Kostensenkung und Effizienzoptimierung sind dominierende Wirtschaftsprinzipien – KI-Risiko und die Wahl des richtigen KI-Modells

Lösungsansätze und zukünftige Entwicklungen

Menschliche Überwachung und Redaktionsprozesse

Eine naheliegende Lösung für die von Bloomberg erlebten Probleme ist eine verstärkte menschliche Überwachung der KI-generierten Inhalte. Bloomberg hat bereits betont, dass Journalisten die volle Kontrolle darüber haben, ob eine KI-generierte Zusammenfassung veröffentlicht wird oder nicht. Diese Kontrolle muss jedoch effektiv ausgeübt werden, was bedeutet, dass Redakteure ausreichend Zeit haben müssen, die KI-Zusammenfassungen zu überprüfen, bevor sie veröffentlicht werden.

Die Implementierung robuster redaktioneller Prozesse für die Überprüfung von KI-generierten Inhalten ist entscheidend, um Fehler zu minimieren. Dies könnte beinhalten, dass alle KI-Zusammenfassungen von mindestens einem menschlichen Redakteur überprüft werden müssen, bevor sie veröffentlicht werden, oder dass bestimmte Arten von Informationen (wie Daten, Zahlen oder Zuschreibungen) besonders gründlich überprüft werden. Solche Prozesse erhöhen zwar den Arbeitsaufwand und verringern somit einen Teil der Effizienzgewinne durch KI, sind aber notwendig, um die Genauigkeit und Glaubwürdigkeit zu wahren.

Technische Verbesserungen der KI-Modelle

Die technische Weiterentwicklung der KI-Modelle selbst ist ein weiterer wichtiger Ansatz zur Lösung der aktuellen Probleme. Bereits mit GPT-4 sind Halluzinationen im Vergleich zum Vorgänger GPT-3.5 deutlich zurückgegangen. Das jüngste Modell von Anthropic, “Claude 3 Opus”, zeigt in ersten Tests noch weniger Halluzinationen. Bald dürfte die Fehlerquote von Sprachmodellen niedriger sein als die des Durchschnittsmenschen. Dennoch werden KI-Sprachmodelle wohl bis auf Weiteres nicht fehlerfrei sein, anders als man es von Computern gewohnt ist.

Ein vielversprechender technischer Ansatz ist die “Mixture of Experts”: Dabei werden mehrere kleine Spezialmodelle an ein Gate-Netzwerk angebunden. Eine Eingabe an das System wird vom Gate analysiert und dann bei Bedarf an einen oder mehrere Experten weitergegeben. Am Schluss werden die Antworten zu einer Gesamtantwort kombiniert. So kann vermieden werden, dass stets das gesamte Modell in seiner Komplexität aktiv werden muss. Diese Art von Architektur könnte potenziell die Genauigkeit verbessern, indem sie spezialisierte Modelle für bestimmte Arten von Informationen oder Domänen einsetzt.

Realistische Erwartungen und transparente Kommunikation

Schließlich ist es wichtig, realistische Erwartungen an KI-Systeme zu haben und transparent über ihre Fähigkeiten und Grenzen zu kommunizieren. KI-Systeme sind heute jeweils spezifisch für einen bestimmten Anwendungskontext definiert und bei weitem nicht mit der menschlichen Intelligenz vergleichbar. Diese Erkenntnis sollte die Implementierung von KI im Journalismus und anderen Bereichen leiten.

Bloomberg und andere Medienunternehmen sollten transparent über ihre Nutzung von KI kommunizieren und deutlich machen, dass KI-generierte Inhalte fehlerhaft sein können. Dies könnte durch explizite Kennzeichnung von KI-generierten Inhalten, transparente Fehlerkorrekturprozesse und offene Kommunikation über die Grenzen der eingesetzten Technologie geschehen. Eine solche Transparenz kann dazu beitragen, das Vertrauen der Leser zu erhalten, auch wenn Fehler auftreten.

Warum KI-Integration in den Journalismus ohne Menschen scheitert

Die Erfahrungen von Bloomberg mit KI-generierten Zusammenfassungen verdeutlichen die komplexen Herausforderungen bei der Integration von künstlicher Intelligenz in den Journalismus. Die mindestens 36 Fehler, die seit Januar korrigiert werden mussten, zeigen, dass die Technologie trotz ihres Potenzials noch nicht ausgereift genug ist, um ohne gründliche menschliche Überwachung zuverlässig eingesetzt zu werden. Die Probleme, mit denen Bloomberg konfrontiert ist, sind nicht einzigartig, sondern spiegeln fundamentale Herausforderungen der KI wider, wie Halluzinationen, mangelnde Transparenz und die Abhängigkeit von hochwertigen Daten.

Für eine erfolgreiche Integration von KI in den Journalismus sind mehrere Ansätze erforderlich: robuste redaktionelle Prozesse für die Überprüfung von KI-generierten Inhalten, kontinuierliche technische Verbesserungen der KI-Modelle selbst und eine transparente Kommunikation über die Fähigkeiten und Grenzen der eingesetzten Technologie. Bloomberg’s Erfahrung kann als wertvolle Lektion für andere Medienunternehmen dienen, die ähnliche KI-Implementierungen planen.

Die Zukunft des KI-gestützten Journalismus hängt davon ab, wie gut es gelingt, die Effizienzgewinne und innovativen Möglichkeiten der KI zu nutzen, ohne dabei journalistische Standards zu kompromittieren. Der Schlüssel liegt in einem ausgewogenen Ansatz, der die Technologie als Werkzeug betrachtet, das menschliche Journalisten unterstützt, anstatt sie zu ersetzen. Wie John Micklethwait von Bloomberg treffend bemerkte: “Eine KI-Zusammenfassung ist nur so gut wie die Geschichte, auf der sie basiert. Und für die Geschichten sind immer noch die Menschen wichtig.”

Wir sind für Sie da - Beratung - Planung - Umsetzung - Projektmanagement

☑️ KMU Support in der Strategie, Beratung, Planung und Umsetzung

☑️ Erstellung oder Neuausrichtung der Digitalstrategie und Digitalisierung

☑️ Ausbau und Optimierung der internationalen Vertriebsprozesse

☑️ Globale & Digitale B2B-Handelsplattformen

☑️ Pioneer Business Development

Gerne stehe ich Ihnen als persönlicher Berater zur Verfügung.

Sie können mit mir Kontakt aufnehmen, indem Sie unten das Kontaktformular ausfüllen oder rufen Sie mich einfach unter +49 89 89 674 804 (München) an.

Ich freue mich auf unser gemeinsames Projekt.

Xpert.Digital - Konrad Wolfenstein

Xpert.Digital ist ein Hub für die Industrie mit den Schwerpunkten, Digitalisierung, Maschinenbau, Logistik/Intralogistik und Photovoltaik.

Mit unserer 360° Business Development Lösung unterstützen wir namhafte Unternehmen vom New Business bis After Sales.

Market Intelligence, Smarketing, Marketing Automation, Content Development, PR, Mail Campaigns, Personalized Social Media und Lead Nurturing sind ein Teil unserer digitalen Werkzeuge.

Mehr finden Sie unter: www.xpert.digital - www.xpert.solar - www.xpert.plus