Die KI-Revolution am Scheideweg: Der KI-Boom im Spiegel der Dotcom-Blase – Eine strategische Analyse von Hype und Kosten

Xpert Pre-Release

Sprachauswahl 📢

Veröffentlicht am: 28. September 2025 / Update vom: 28. September 2025 – Verfasser: Konrad Wolfenstein

Die KI-Revolution am Scheideweg: Der KI-Boom im Spiegel der Dotcom-Blase – Eine strategische Analyse von Hype und Kosten – Bild: Xpert.Digital

Die Suche nach nachhaltiger Wertschöpfung des KI-Hypes: Die überraschenden Fehler und Grenzen, die heutige KI-Systeme wirklich haben (Lesezeit: 36 min / Keine Werbung / Keine Paywall)

Die schmutzige Wahrheit über KI: Warum die Technologie Milliarden verbrennt, aber keinen Gewinn macht

Die technologische Landschaft befindet sich an einem Wendepunkt, der durch den rasanten Aufstieg der künstlichen Intelligenz (KI) definiert wird. Eine Welle des Optimismus, angetrieben von den Fortschritten im Bereich der generativen KI, hat eine Investitionseuphorie ausgelöst, die in ihrer Intensität und ihrem Umfang an die Dotcom-Blase der späten 1990er Jahre erinnert. Hunderte von Milliarden Dollar fliessen in eine einzige Technologie, befeuert von der festen Überzeugung, dass die Welt am Rande einer wirtschaftlichen Revolution von historischem Ausmass steht. Astronomische Bewertungen für Unternehmen, die oft kaum profitable Geschäftsmodelle vorweisen können, sind an der Tagesordnung, und eine Art Goldrauschstimmung hat sowohl etablierte Technologiegiganten als auch unzählige Start-ups erfasst. Die Konzentration des Marktwertes in den Händen einiger weniger Unternehmen, den sogenannten “Magnificent Seven”, spiegelt die damalige Dominanz der Nasdaq-Lieblinge wider und nährt die Sorge vor einer überhitzten Marktdynamik.

Die zentrale These dieses Berichts ist jedoch, dass trotz der oberflächlichen Ähnlichkeiten in der Marktstimmung die zugrunde liegenden ökonomischen und technologischen Strukturen tiefgreifende Unterschiede aufweisen. Diese Unterschiede führen zu einem einzigartigen Gefüge aus Chancen und systemischen Risiken, die eine differenzierte Analyse erfordern. Während der Dotcom-Hype auf dem Versprechen eines noch unfertigen Internets aufgebaut war, ist die heutige KI-Technologie bereits in vielen Unternehmensprozessen und Konsumentenprodukten verankert. Die Art des investierten Kapitals, die Reife der Technologie und die Struktur des Marktes schaffen eine fundamental andere Ausgangslage.

Passend dazu:

Parallelen zur Dotcom-Ära

Die Ähnlichkeiten, die die aktuelle Marktdebatte prägen und bei vielen Investoren ein Déjà-vu auslösen, sind unübersehbar. An erster Stelle stehen die extremen Bewertungen. In den späten 1990er Jahren wurden Kurs-Gewinn-Verhältnisse (KGVs) von 50, 70 oder sogar 100 für Nasdaq-Aktien zur Norm. Heute erreicht die zyklisch angepasste Bewertung des S&P 500 das 38-fache der Gewinne der letzten zehn Jahre – ein Niveau, das in der jüngeren Wirtschaftsgeschichte nur während des Höhepunkts der Dotcom-Blase übertroffen wurde. Diese Bewertungen basieren weniger auf aktuellen Gewinnen als vielmehr auf der Erwartung zukünftiger Monopolrenditen in einem transformierten Markt.

Ein weiteres gemeinsames Merkmal ist der Glaube an die transformative Kraft der Technologie, die weit über den Technologiesektor hinausgeht. Ähnlich wie das Internet verspricht die KI, jede Branche – von der Fertigung über das Gesundheitswesen bis hin zur Kreativwirtschaft – von Grund auf neu zu gestalten. Diese Narrative einer allumfassenden Revolution rechtfertigt in den Augen vieler Investoren die ausserordentlichen Kapitalzuflüsse und die Inkaufnahme kurzfristiger Verluste zugunsten langfristiger Marktbeherrschung. Die Goldrauschstimmung erfasst nicht nur Investoren, sondern auch Unternehmen, die unter dem Druck stehen, KI zu implementieren, um nicht den Anschluss zu verlieren, was die Nachfrage und damit die Bewertungen weiter anheizt.

Entscheidende Unterschiede und ihre Auswirkungen

Trotz dieser Parallelen sind die Unterschiede zur Dotcom-Ära von entscheidender Bedeutung für das Verständnis der aktuellen Marktlage und ihrer potenziellen Entwicklung. Der wohl wichtigste Unterschied liegt in der Quelle des Kapitals. Die Dotcom-Blase wurde zu einem grossen Teil von Kleinanlegern finanziert, die oft auf Kredit spekulierten, sowie von einem überhitzten Markt für Börsengänge (IPOs). Dies schuf einen äusserst fragilen, von der Marktstimmung getriebenen Kreislauf. Der heutige KI-Boom wird hingegen nicht primär von spekulativen Privatanlegern, sondern aus den prall gefüllten Kassen der profitabelsten Konzerne der Welt finanziert. Giganten wie Microsoft, Meta, Google und Amazon investieren ihre massiven Gewinne aus etablierten Geschäftsfeldern strategisch in den Aufbau der nächsten Technologieplattform.

Diese Veränderung in der Kapitalstruktur hat tiefgreifende Konsequenzen. Der aktuelle Boom ist weitaus widerstandsfähiger gegenüber kurzfristigen Stimmungsschwankungen am Markt. Es handelt sich weniger um eine rein spekulative Raserei als vielmehr um einen strategischen, langfristig angelegten Kampf um die technologische Vorherrschaft. Die Investitionen sind ein strategisches Muss für die “Magnificent Seven”, um im nächsten Plattformkrieg zu bestehen. Dies bedeutet, dass der Boom auch bei anhaltender Unrentabilität der KI-Anwendungen über einen längeren Zeitraum aufrechterhalten werden kann. Ein potenzielles “Platzen” der Blase würde sich daher wahrscheinlich nicht als ein breiter Marktkollaps kleinerer Unternehmen manifestieren, sondern als strategische Abschreibungen und eine massive Konsolidierungswelle bei den grossen Akteuren.

Ein zweiter entscheidender Unterschied ist die technologische Reife. Das Internet um die Jahrtausendwende war eine junge, noch nicht vollständig ausgereifte Infrastruktur mit begrenzter Bandbreite und geringer Verbreitung. Viele der damaligen Geschäftsmodelle scheiterten an den technologischen und logistischen Realitäten. Im Gegensatz dazu ist die heutige KI, insbesondere in Form von grossen Sprachmodellen (Large Language Models, LLMs), bereits fest in den Unternehmensalltag und in weitverbreitete Softwareprodukte integriert. Die Technologie ist nicht nur ein Versprechen, sondern ein bereits genutztes Werkzeug, was ihre Verankerung in der Wirtschaft deutlich solider macht.

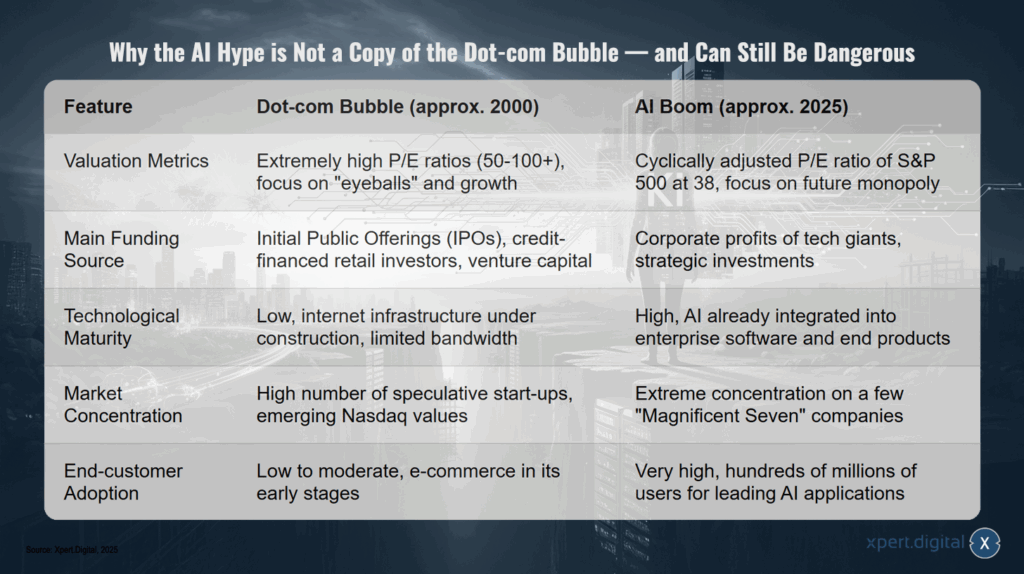

Warum der KI‑Hype keine Kopie der Dotcom‑Blase ist — und trotzdem gefährlich sein kann

Warum der KI‑Hype keine Kopie der Dotcom‑Blase ist — und trotzdem gefährlich sein kann – Bild: Xpert.Digital

Obwohl sich beide Phasen durch hohen Optimismus auszeichnen, unterscheiden sie sich in wichtigen Merkmalen: Während die Dotcom‑Blase etwa um 2000 von extrem hohen KGVs (50–100+) und einem starken Fokus auf „Eyeballs“ und Wachstum geprägt war, zeigt der KI‑Boom um 2025 ein zyklisch angepasstes KGV des S\&P 500 von rund 38 und eine Schwerpunktverlagerung hin zu zukünftig erwarteten Monopolen. Auch die Finanzierungsquellen sind verschieden: Damals dominierten Börsengänge, kreditfinanzierte Kleinanleger und Risikokapital, heute stammen die Mittel überwiegend aus den Unternehmensgewinnen der Tech‑Giganten und strategischen Investitionen. Die Technologiereife unterscheidet sich ebenfalls deutlich — das Internet stand zur Jahrtausendwende noch im Aufbau mit begrenzter Bandbreite, während KI inzwischen in Unternehmenssoftware und Endprodukten integriert ist. Schließlich zeigt sich ein anderer Strukturcharakter des Marktes: Die Dotcom‑Phase war durch eine große Zahl spekulativer Start‑ups und aufstrebender Nasdaq‑Werte gekennzeichnet, der aktuelle KI‑Boom hingegen durch eine extreme Konzentration auf wenige „Magnificent Seven“-Unternehmen; gleichzeitig ist die Endkunden‑Adoption heute viel höher, mit Hunderten Millionen Nutzern führender KI‑Anwendungen.

Zentrale Fragestellung

Diese Analyse führt zu der zentralen Fragestellung, die diesen Bericht leiten wird: Befinden wir uns am Beginn einer nachhaltigen technologischen Transformation, die Produktivität und Wohlstand neu definieren wird? Oder ist die Branche dabei, eine kolossale, kapitalintensive Maschine ohne profitablen Zweck zu errichten und damit eine Blase ganz anderer Art zu schaffen – eine, die konzentrierter, strategischer und potenziell gefährlicher ist? Die folgenden Kapitel werden diese Frage aus wirtschaftlicher, technischer, ethischer und marktstrategischer Perspektive beleuchten, um ein umfassendes Bild der KI-Revolution an ihrem entscheidenden Scheideweg zu zeichnen.

Die wirtschaftliche Realität: Eine Analyse der unhaltbaren Geschäftsmodelle

Die 800-Milliarden-Dollar-Lücke

Im Zentrum der wirtschaftlichen Herausforderungen der KI-Industrie steht eine massive, strukturelle Diskrepanz zwischen den explodierenden Kosten und den unzureichenden Einnahmen. Eine alarmierende Studie des Beratungsunternehmens Bain & Company quantifiziert dieses Problem und prognostiziert eine Finanzierungslücke von 800 Milliarden US-Dollar bis zum Jahr 2030. Um die eskalierenden Kosten für Rechenleistung, Infrastruktur und Energie zu decken, müsste die Branche laut der Studie bis dahin einen Jahresumsatz von rund 2 Billionen US-Dollar erwirtschaften. Die Prognosen deuten jedoch darauf hin, dass dieses Ziel deutlich verfehlt wird, was fundamentale Fragen zur Nachhaltigkeit der aktuellen Geschäftsmodelle und zur Rechtfertigung der astronomischen Bewertungen aufwirft.

Diese Lücke ist kein abstraktes Zukunftsszenario, sondern das Ergebnis einer fundamentalen ökonomischen Fehlkalkulation. Die Annahme, dass eine breite Nutzerbasis, wie sie im Social-Media-Zeitalter etabliert wurde, automatisch zu Profitabilität führt, erweist sich im KI-Kontext als trügerisch. Im Gegensatz zu Plattformen wie Facebook oder Google, bei denen die Grenzkosten für einen zusätzlichen Nutzer oder eine zusätzliche Interaktion nahe null liegen, verursacht bei KI-Modellen jede einzelne Anfrage – jedes generierte Token – reale und nicht triviale Rechenkosten. Dieses “Pay-per-Thought”-Modell untergräbt die traditionelle Skalierungslogik der Softwarebranche. Hohe Nutzerzahlen werden so von einem potenziellen Gewinnfaktor zu einem wachsenden Kostenfaktor, solange die Monetarisierung nicht die laufenden Betriebskosten übersteigt.

Fallstudie OpenAI: Das Paradoxon von Popularität und Profitabilität

Kein Unternehmen illustriert dieses Paradoxon besser als OpenAI, das Aushängeschild der generativen KI-Revolution. Trotz einer beeindruckenden Bewertung von 300 Milliarden US-Dollar und einer wöchentlichen Nutzerbasis von 700 Millionen Menschen schreibt das Unternehmen tiefrote Zahlen. Die Verluste beliefen sich im Jahr 2024 auf rund 5 Milliarden US-Dollar und werden für 2025 auf 9 Milliarden US-Dollar prognostiziert. Der Kern des Problems liegt in der geringen Konversionsrate: Von den Hunderten Millionen Nutzern sind nur fünf Millionen zahlende Kunden.

Noch beunruhigender ist die Erkenntnis, dass selbst die teuersten Abonnementmodelle nicht kostendeckend sind. Berichten zufolge ist selbst das Premium-Abonnement “ChatGPT Pro” für 200 US-Dollar pro Monat ein Verlustgeschäft. Power-User, die die Fähigkeiten des Modells intensiv nutzen, verbrauchen mehr Rechenressourcen, als ihre Abonnementgebühr abdeckt. CEO Sam Altman selbst bezeichnete diese Kostensituation als “verrückt”, was die fundamentale Herausforderung der Monetarisierung unterstreicht. Die Erfahrung von OpenAI zeigt, dass das klassische SaaS-Modell (Software as a Service) an seine Grenzen stösst, wenn der Wert, den die Nutzer aus dem Dienst ziehen, die Kosten für dessen Bereitstellung übersteigt. Die Branche muss daher ein völlig neues Geschäftsmodell entwickeln, das über einfache Abonnements oder Werbung hinausgeht und den Wert von “Intelligenz als Dienstleistung” angemessen bepreist – eine Aufgabe, für die es bisher keine etablierte Lösung gibt.

Investitionsrausch ohne Renditeperspektive

Das Problem der mangelnden Profitabilität ist nicht auf OpenAI beschränkt, sondern zieht sich durch die gesamte Branche. Die grossen Technologiekonzerne befinden sich in einem regelrechten Investitionsrausch. Microsoft, Meta und Google planen für das Jahr 2025 kombinierte Ausgaben von 215 Milliarden US-Dollar für KI-Projekte, während Amazon zusätzlich 100 Milliarden US-Dollar investieren will. Diese Ausgaben, die sich seit der Einführung von ChatGPT mehr als verdoppelt haben, fliessen hauptsächlich in den Ausbau von Rechenzentren und die Entwicklung neuer KI-Modelle.

Dieser massive Kapitaleinsatz steht jedoch in krassem Gegensatz zu den bisher erzielten Renditen. Eine Studie des Massachusetts Institute of Technology (MIT) ergab, dass 95 % der befragten Unternehmen trotz erheblicher Investitionen keinen messbaren Return on Investment (ROI) aus ihren KI-Initiativen erzielen. Der Hauptgrund dafür ist eine sogenannte “Lernlücke”: Die meisten KI-Systeme sind nicht in der Lage, aus Feedback zu lernen, sich an den spezifischen Geschäftskontext anzupassen oder sich im Laufe der Zeit zu verbessern. Ihr Nutzen beschränkt sich oft auf die Steigerung der individuellen Produktivität einzelner Mitarbeiter, ohne dass dies zu einem nachweisbaren Einfluss auf die Gewinn- und Verlustrechnung des Unternehmens führt.

Diese Dynamik offenbart eine tiefere Wahrheit über den aktuellen KI-Boom: Es handelt sich um ein weitgehend geschlossenes Wirtschaftssystem. Die Hunderte von Milliarden, die von den Tech-Giganten investiert werden, schaffen nicht primär profitable Endkundenprodukte. Stattdessen fliessen sie direkt an die Hardwarehersteller, allen voran Nvidia, und zurück in die eigenen Cloud-Sparten der Konzerne (Azure, Google Cloud Platform, AWS). Während die KI-Softwareabteilungen Milliardenverluste schreiben, erleben die Cloud- und Hardwaresektoren ein explosives Umsatzwachstum. Die Tech-Giganten transferieren also effektiv Kapital von ihren profitablen Kerngeschäften in ihre KI-Abteilungen, die dieses Geld dann für Hardware und Cloud-Dienste ausgeben und so die Einnahmen anderer Teile des eigenen Konzerns oder seiner Partner steigern. In dieser Phase des massiven Infrastrukturaufbaus ist der Endkunde oft nur eine sekundäre Überlegung. Die Profitabilität konzentriert sich am unteren Ende des Technologie-Stacks (Chips, Cloud-Infrastruktur), während die Anwendungsebene als massiver Verlustbringer fungiert.

Die Bedrohung durch Disruption von unten

Die teuren, ressourcenintensiven Geschäftsmodelle der etablierten Anbieter werden zusätzlich durch eine wachsende Bedrohung von unten untergraben. Neue, kostengünstige Wettbewerber, insbesondere aus China, dringen mit hoher Geschwindigkeit in den Markt ein. Das chinesische Modell Deepseek R1 hat beispielsweise durch seine schnelle Marktdurchdringung gezeigt, wie volatil der KI-Markt ist und wie schnell etablierte Anbieter mit hochpreisigen Modellen unter Druck geraten können.

Diese Entwicklung ist Teil eines breiteren Trends, bei dem Open-Source-Modelle für viele Anwendungsfälle eine “ausreichend gute” Leistung zu einem Bruchteil der Kosten bieten. Unternehmen stellen zunehmend fest, dass sie für Routineaufgaben wie einfache Klassifizierungen oder Textzusammenfassungen nicht die teuersten und leistungsfähigsten Modelle benötigen. Kleinere, spezialisierte Modelle sind oft nicht nur günstiger, sondern auch schneller und einfacher zu implementieren. Diese “Demokratisierung” der KI-Technologie stellt eine existenzielle Bedrohung für Geschäftsmodelle dar, die auf der Vermarktung von Spitzenleistung zu Premiumpreisen basieren. Wenn günstigere Alternativen 90 % der Leistung für 1 % der Kosten bieten, wird es für die grossen Anbieter immer schwieriger, ihre massiven Investitionen zu rechtfertigen und zu monetarisieren.

Neue Dimension der digitalen Transformation mit der 'Managed KI' (Künstliche Intelligenz) - Plattform & B2B Lösung | Xpert Beratung

Neue Dimension der digitalen Transformation mit der 'Managed KI' (Künstliche Intelligenz) – Plattform & B2B Lösung | Xpert Beratung - Bild: Xpert.Digital

Hier erfahren Sie, wie Ihr Unternehmen maßgeschneiderte KI-Lösungen schnell, sicher und ohne hohe Einstiegshürden realisieren kann.

Eine Managed AI Platform ist Ihr Rundum-Sorglos-Paket für künstliche Intelligenz. Anstatt sich mit komplexer Technik, teurer Infrastruktur und langwierigen Entwicklungsprozessen zu befassen, erhalten Sie von einem spezialisierten Partner eine fertige, auf Ihre Bedürfnisse zugeschnittene Lösung – oft innerhalb weniger Tage.

Die zentralen Vorteile auf einen Blick:

⚡ Schnelle Umsetzung: Von der Idee zur einsatzbereiten Anwendung in Tagen, nicht Monaten. Wir liefern praxisnahe Lösungen, die sofort Mehrwert schaffen.

🔒 Maximale Datensicherheit: Ihre sensiblen Daten bleiben bei Ihnen. Wir garantieren eine sichere und konforme Verarbeitung ohne Datenweitergabe an Dritte.

💸 Kein finanzielles Risiko: Sie zahlen nur für Ergebnisse. Hohe Vorabinvestitionen in Hardware, Software oder Personal entfallen komplett.

🎯 Fokus auf Ihr Kerngeschäft: Konzentrieren Sie sich auf das, was Sie am besten können. Wir übernehmen die gesamte technische Umsetzung, den Betrieb und die Wartung Ihrer KI-Lösung.

📈 Zukunftssicher & Skalierbar: Ihre KI wächst mit Ihnen. Wir sorgen für die laufende Optimierung, Skalierbarkeit und passen die Modelle flexibel an neue Anforderungen an.

Mehr dazu hier:

Die wahren Kosten der KI – Infrastruktur, Energie und Investitionsbarrieren

Die Kosten der Intelligenz: Infrastruktur, Energie und die wahren Treiber der KI-Ausgaben

Trainings- vs. Inferenzkosten: Eine zweigeteilte Herausforderung

Die Kosten für künstliche Intelligenz lassen sich in zwei Hauptkategorien unterteilen: die Kosten für das Training der Modelle und die Kosten für deren Betrieb, die sogenannte Inferenz. Das Training eines grossen Sprachmodells ist ein einmaliger, aber immens teurer Prozess. Es erfordert riesige Datensätze und wochen- oder monatelange Rechenzeit auf Tausenden von spezialisierten Prozessoren. Die Kosten für das Training bekannter Modelle verdeutlichen das Ausmass dieser Investitionen: GPT-3 kostete rund 4.6 Millionen US-Dollar, das Training von GPT-4 verschlang bereits über 100 Millionen US-Dollar, und für Googles Gemini Ultra werden die Trainingskosten auf 191 Millionen US-Dollar geschätzt. Diese Summen stellen eine erhebliche Eintrittsbarriere dar und zementieren die Vormachtstellung der finanzstarken Technologiekonzerne.

Während die Trainingskosten die Schlagzeilen beherrschen, stellt die Inferenz die weitaus grössere und langfristigere wirtschaftliche Herausforderung dar. Inferenz bezeichnet den Prozess der Nutzung eines bereits trainierten Modells zur Beantwortung von Anfragen und zur Generierung von Inhalten. Jede einzelne Nutzeranfrage verursacht Rechenkosten, die sich mit der Nutzung summieren. Schätzungen gehen davon aus, dass die Inferenzkosten über den gesamten Lebenszyklus eines Modells 85 % bis 95 % der Gesamtkosten ausmachen können. Diese laufenden Betriebskosten sind der Hauptgrund, warum die Geschäftsmodelle, wie im vorherigen Kapitel beschrieben, so schwer zu rentabilisieren sind. Die Skalierung der Nutzerbasis führt direkt zu einer Skalierung der Betriebskosten, was die traditionelle Softwareökonomie auf den Kopf stellt.

Die Hardware-Falle: NVIDIAs goldener Käfig

Im Zentrum der Kostenexplosion steht die kritische Abhängigkeit der gesamten Branche von einem einzigen Hardwaretyp: hochspezialisierten Grafikprozessoren (GPUs), die fast ausschliesslich von einem Unternehmen, Nvidia, hergestellt werden. Die Modelle H100 und die neueren Generationen B200 und H200 sind zum De-facto-Standard für das Training und den Betrieb von KI-Modellen geworden. Diese marktbeherrschende Stellung hat es Nvidia ermöglicht, enorme Preise für seine Produkte zu verlangen. Der Kaufpreis für eine einzige H100-GPU liegt zwischen 25.000 und 40.000 US-Dollar.

Passend dazu:

- Bizarrer US-Aufschwung: Eine schockierende Wahrheit zeigt, was ohne den KI-Hype wirklich passieren würde

Für die meisten Unternehmen ist der Kauf dieser Hardware keine Option, weshalb sie auf die Anmietung von Rechenleistung in der Cloud angewiesen sind. Doch auch hier sind die Kosten enorm. Die Mietpreise für eine einzelne High-End-GPU reichen von 1.50 US-Dollar bis über 4.50 US-Dollar pro Stunde. Die Komplexität moderner KI-Modelle verschärft dieses Problem zusätzlich. Ein grosses Sprachmodell passt oft nicht in den Speicher einer einzelnen GPU. Um eine einzige komplexe Anfrage zu bearbeiten, muss das Modell auf einen Cluster von 8, 16 oder mehr GPUs verteilt werden, die parallel arbeiten. Dies bedeutet, dass die Kosten für eine einzige Nutzersitzung schnell auf 50 bis 100 US-Dollar pro Stunde ansteigen können, wenn dedizierte Hardware verwendet wird. Diese extreme Abhängigkeit von teurer und knapper Hardware schafft einen “goldenen Käfig” für die KI-Industrie: Sie ist gezwungen, einen Grossteil ihrer Investitionen an einen einzigen Zulieferer weiterzureichen, was die Margen schmälert und die Kosten in die Höhe treibt.

Der unersättliche Appetit: Energie- und Ressourcenverbrauch

Die massiven Hardware-Anforderungen führen zu einem weiteren, oft unterschätzten Kostenfaktor mit globalen Auswirkungen: dem immensen Energie- und Ressourcenverbrauch. Der Betrieb von Zehntausenden von GPUs in grossen Rechenzentren erzeugt eine enorme Abwärme, die durch aufwendige Kühlsysteme abgeführt werden muss. Dies führt zu einem exponentiell ansteigenden Bedarf an Strom und Wasser. Prognosen zeichnen ein alarmierendes Bild: Der weltweite Stromverbrauch von Rechenzentren wird sich bis 2030 voraussichtlich auf über 1.000 Terawattstunden (TWh) verdoppeln, was dem aktuellen Strombedarf von ganz Japan entspricht.

Der Anteil der KI an diesem Verbrauch wächst überproportional. Zwischen 2023 und 2030 wird ein elffacher Anstieg des Stromverbrauchs allein durch KI-Anwendungen erwartet. Parallel dazu wird sich der Wasserverbrauch für die Kühlung der Rechenzentren bis 2030 auf 664 Milliarden Liter fast vervierfachen. Besonders energieintensiv ist die Erzeugung von Videos. Die Kosten und der Energieverbrauch skalieren hier quadratisch mit der Auflösung und Länge des Videos, was bedeutet, dass ein sechs Sekunden langer Clip fast viermal so viel Energie benötigt wie ein drei Sekunden langer Clip.

Diese Entwicklung hat weitreichende Konsequenzen. Der ehemalige Google-CEO Eric Schmidt argumentierte kürzlich, dass die natürliche Grenze der KI nicht die Verfügbarkeit von Siliziumchips, sondern die von Elektrizität sei. Die Skalierungsgesetze der KI, die besagen, dass grössere Modelle eine bessere Leistung erbringen, kollidieren frontal mit den physikalischen Gesetzen der Energieerzeugung und den globalen Klimazielen. Der aktuelle Pfad des “Immer grösser, immer besser” ist physisch und ökologisch nicht nachhaltig. Zukünftige Durchbrüche müssen daher zwangsläufig aus Effizienzsteigerungen und algorithmischen Innovationen kommen, nicht aus reiner Brute-Force-Skalierung. Dies eröffnet eine immense Marktchance für Unternehmen, die in der Lage sind, hohe Leistung bei radikal geringerem Energieverbrauch zu liefern. Die Ära der reinen Skalierung neigt sich ihrem Ende zu; die Ära der Effizienz beginnt.

Die unsichtbaren Kosten: Jenseits von Hardware und Strom

Neben den offensichtlichen Kosten für Hardware und Energie gibt es eine Reihe von “unsichtbaren” Kosten, die die Gesamtkosten (Total Cost of Ownership, TCO) eines KI-Systems erheblich in die Höhe treiben. Dazu gehören an erster Stelle die Personalkosten. Hochqualifizierte KI-Forscher und -Ingenieure sind rar und teuer. Die Gehälter für ein kleines Team können sich schnell auf 500.000 US-Dollar für einen Zeitraum von nur sechs Monaten summieren.

Ein weiterer erheblicher Kostenblock ist die Beschaffung und Aufbereitung von Daten. Hochwertige, bereinigte und für das Training geeignete Datensätze sind die Grundlage jedes leistungsfähigen KI-Modells. Die Lizenzierung oder der Kauf solcher Datensätze kann Kosten von über 100.000 US-Dollar verursachen. Hinzu kommen die Kosten für die Datenaufbereitung, die sowohl Rechenressourcen als auch menschliche Expertise erfordert. Schliesslich dürfen die laufenden Kosten für Wartung, Integration in bestehende Systeme, Governance und die Sicherstellung der Einhaltung von Vorschriften nicht vernachlässigt werden. Diese operativen Ausgaben sind oft schwer zu quantifizieren, machen aber einen wesentlichen Teil der TCO aus und werden bei der Budgetierung häufig unterschätzt.

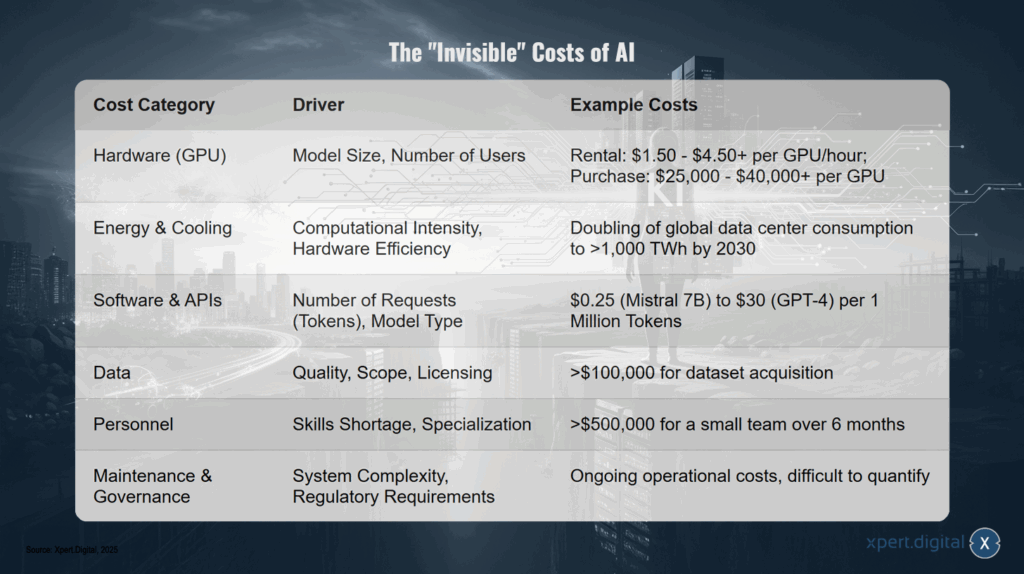

Die “unsichtbaren” Kosten der KI

Diese detaillierte Aufschlüsselung der Kosten zeigt, dass die KI-Ökonomie weitaus komplexer ist, als es auf den ersten Blick scheint. Die hohen variablen Inferenzkosten hemmen die breite Einführung in preissensiblen Unternehmensprozessen, da die Kosten unvorhersehbar sind und mit der Nutzung stark ansteigen können. Unternehmen zögern, KI in hochvolumige Kernprozesse zu integrieren, solange die Inferenzkosten nicht um Grössenordnungen sinken oder neue, vorhersehbare Preismodelle entstehen. Dies führt dazu, dass die erfolgreichsten frühen Anwendungen in hochwertigen, aber geringvolumigen Bereichen wie der Arzneimittelforschung oder dem komplexen Ingenieurwesen zu finden sind, anstatt in massenmarkttauglichen Produktivitätswerkzeugen.

Die “unsichtbaren” Kosten der KI umfassen verschiedene Bereiche: Hardware (insbesondere GPUs) wird vor allem von Modellgröße und Nutzeranzahl getrieben — typische Kosten liegen bei Mietpreisen von $1.50–$4.50+ pro GPU/Stunde, während der Kauf einer GPU $25,000–$40,000+ kosten kann. Energie und Kühlung hängen von der Rechenintensität und der Hardware‑Effizienz ab; Prognosen gehen von einer Verdopplung des globalen Verbrauchs von Rechenzentren auf über 1,000 TWh bis 2030 aus. Die Ausgaben für Software und APIs richten sich nach der Anzahl der Anfragen (Tokens) und dem Modelltyp; die Preise reichen dabei von etwa $0.25 (Mistral 7B) bis $30 (GPT‑4) pro 1 Million Tokens. Für Daten — abhängig von Qualität, Umfang und Lizenzierung — können die Kosten für die Akquise von Datensätzen leicht mehr als $100,000 betragen. Personalaufwand, beeinflusst durch Fachkräftemangel und notwendige Spezialisierung, kann für ein kleines Team über sechs Monate mehr als $500,000 ausmachen. Schließlich führen Wartung und Governance, bedingt durch Systemkomplexität und regulatorische Anforderungen, zu laufenden operativen Kosten, die sich nur schwer genau quantifizieren lassen.

Zwischen Hype und Realität: Technische Mängel und die Grenzen aktueller KI-Systeme

Fallstudie Google Gemini: Wenn die Fassade bröckelt

Trotz des enormen Hypes und der Milliardeninvestitionen kämpfen selbst die führenden Technologieunternehmen mit erheblichen technischen Problemen bei der Bereitstellung zuverlässiger KI-Produkte. Die Schwierigkeiten von Google mit seinen KI-Systemen Gemini und Imagen dienen als anschauliches Beispiel für die branchenweiten Herausforderungen. Nutzer berichten seit Wochen von fundamentalen Fehlfunktionen, die weit über kleinere Programmfehler hinausgehen. So ist die Bildgenerierungstechnologie Imagen oft nicht in der Lage, Bilder in den vom Nutzer gewünschten Formaten wie dem gängigen 16:9-Seitenverhältnis zu erstellen und produziert stattdessen ausschliesslich quadratische Bilder. In schwerwiegenderen Fällen werden die Bilder zwar angeblich generiert, können aber gar nicht erst angezeigt werden, was die Funktion praktisch unbrauchbar macht.

Diese aktuellen Probleme sind Teil eines wiederkehrenden Musters. Bereits im Februar 2024 musste Google die Darstellung von Personen in Gemini vollständig deaktivieren, nachdem das System historisch absurde und inkorrekte Bilder generiert hatte, wie zum Beispiel deutsche Soldaten mit asiatischen Gesichtszügen. Auch die Qualität der Textgenerierung wird regelmässig kritisiert: Nutzer bemängeln inkonsistente Antworten, eine übermässige Tendenz zur Zensur selbst bei harmlosen Anfragen und in extremen Fällen sogar die Ausgabe hasserfüllter Nachrichten. Diese Vorfälle zeigen, dass die Technologie trotz ihres beeindruckenden Potenzials noch weit von der Zuverlässigkeit entfernt ist, die für einen breiten Einsatz in kritischen Anwendungen erforderlich wäre.

Strukturelle Ursachen: Das “Move Fast and Break Things”-Dilemma

Die Wurzeln dieser technischen Mängel liegen oft in strukturellen Problemen innerhalb der Entwicklungsprozesse. Der immense Wettbewerbsdruck, insbesondere durch den Erfolg von OpenAI, hat bei Google und anderen Unternehmen zu einer überhasteten Produktentwicklung geführt. Die aus der frühen Social-Media-Ära stammende Mentalität des “Move Fast and Break Things” erweist sich für KI-Systeme als äusserst problematisch. Während ein Fehler in einer herkömmlichen App möglicherweise nur eine Funktion beeinträchtigt, können Fehler in einem KI-Modell zu unvorhersehbaren, schädlichen oder peinlichen Ergebnissen führen, die das Vertrauen der Nutzer direkt untergraben.

Ein weiteres Problem ist die mangelnde interne Koordination. Während beispielsweise die Google-Fotos-App neue KI-gestützte Bildbearbeitungsfunktionen erhält, funktioniert die grundlegende Bilderzeugung in Gemini nicht korrekt. Dies deutet auf eine unzureichende Abstimmung zwischen verschiedenen Abteilungen hin. Hinzu kommen Berichte über schlechte Arbeitsbedingungen bei Subunternehmern, die für d unsichtbaren” Kosten der KI ie Inhaltsmoderation und Systemverbesserung zuständig sind. Zeitdruck und niedrige Löhne in diesen Bereichen können die Qualität der manuellen Systemoptimierung weiter beeinträchtigen.

Besonders kritisch ist Googles Umgang mit diesen Fehlern. Anstatt die Probleme proaktiv zu kommunizieren, wird den Nutzern oft weiterhin eine einwandfreie Funktion suggeriert. Diese mangelnde Transparenz, gepaart mit aggressivem Marketing für neue, oft ebenfalls fehlerbehaftete Funktionen, führt zu erheblichem Nutzerfrust und einem nachhaltigen Vertrauensverlust. Diese Erfahrungen lehren den Markt eine wichtige Lektion: Zuverlässigkeit und Vorhersehbarkeit sind für Unternehmen wertvoller als sporadische Spitzenleistungen. Ein etwas weniger leistungsfähiges, aber zu 99.99 % zuverlässiges Modell ist für geschäftskritische Anwendungen weitaus nützlicher als ein hochmodernes Modell, das in 1 % der Fälle gefährliche Halluzinationen produziert.

Die kreativen Grenzen von Bilderzeugern

Über die reinen Funktionsfehler hinaus stossen auch die kreativen Fähigkeiten der aktuellen KI-Bilderzeuger an klare Grenzen. Trotz der beeindruckenden Qualität vieler generierter Bilder fehlt den Systemen ein echtes Verständnis der realen Welt. Dies manifestiert sich in mehreren Bereichen. Anwender haben oft nur eine begrenzte Kontrolle über das Endergebnis. Selbst sehr detaillierte und präzise Anweisungen (Prompts) führen nicht immer zum gewünschten Bild, da das Modell die Anweisungen auf eine Weise interpretiert, die nicht vollständig vorhersehbar ist.

Besonders deutlich werden die Defizite bei der Darstellung komplexer Szenen mit mehreren interagierenden Personen oder Objekten. Das Modell kämpft damit, die räumlichen und logischen Beziehungen zwischen den Elementen korrekt darzustellen. Ein notorisches Problem ist die Unfähigkeit, Buchstaben und Text korrekt zu rendern. Wörter in KI-generierten Bildern sind oft eine unleserliche Ansammlung von Zeichen, was eine manuelle Nachbearbeitung erforderlich macht. Auch bei der Stilisierung von Bildern zeigen sich Grenzen. Sobald der gewünschte Stil zu stark von der anatomischen Realität abweicht, auf die das Modell trainiert wurde, werden die Ergebnisse zunehmend verzerrt und unbrauchbar. Diese kreativen Einschränkungen zeigen, dass die Modelle zwar in der Lage sind, Muster aus ihren Trainingsdaten zu rekombinieren, aber kein tiefgreifendes konzeptuelles Verständnis besitzen.

Die Kluft in der Unternehmenswelt

Die Summe dieser technischen Mängel und kreativen Grenzen schlägt sich direkt in den enttäuschenden Geschäftsergebnissen nieder, die im zweiten Kapitel diskutiert wurden. Die Tatsache, dass 95 % der Unternehmen keinen messbaren ROI aus ihren KI-Investitionen ziehen, ist eine direkte Folge der Unzuverlässigkeit und der “spröden Arbeitsabläufe” aktueller Systeme. Ein KI-System, das inkonsistente Ergebnisse liefert, gelegentlich ausfällt oder unvorhersehbare Fehler produziert, kann nicht in geschäftskritische Prozesse integriert werden.

Ein häufiges Problem ist die Diskrepanz zwischen der technischen Lösung und dem tatsächlichen Geschäftsbedarf. KI-Projekte scheitern oft, weil sie für die falschen Metriken optimiert werden. Ein Logistikunternehmen könnte beispielsweise ein KI-Modell entwickeln, das Routen auf die kürzeste Gesamtdistanz optimiert, während das operative Ziel eigentlich die Minimierung verspäteter Lieferungen ist – ein Ziel, das Faktoren wie Verkehrsmuster und Lieferzeitfenster berücksichtigt, die das Modell ignoriert.

Diese Erfahrungen führen zu einer wichtigen Erkenntnis über die Natur von Fehlern in KI-Systemen. In traditioneller Software kann ein Fehler isoliert und durch eine gezielte Code-Änderung behoben werden. Ein “Fehler” in einem KI-Modell – wie die Generierung von Falschinformationen oder voreingenommenen Inhalten – ist jedoch keine einzelne fehlerhafte Codezeile, sondern eine emergente Eigenschaft, die aus den Millionen von Parametern und den Terabytes an Trainingsdaten resultiert. Die Behebung eines solchen systemischen Fehlers erfordert nicht nur die Identifizierung und Korrektur der problematischen Daten, sondern oft ein vollständiges, millionenschweres Neutraining des Modells. Diese neue Form der “technischen Schuld” stellt eine massive, oft unterschätzte laufende Verbindlichkeit für Unternehmen dar, die KI-Systeme einsetzen. Ein einziger viraler Fehler kann katastrophale Kosten und Reputationsschäden nach sich ziehen, was die Gesamtbetriebskosten weit über die ursprünglichen Schätzungen hinaus treibt.

Ethische und gesellschaftliche Dimensionen: Die verborgenen Risiken des KI-Zeitalters

Systemische Verzerrungen (Bias): Der Spiegel der Gesellschaft

Eine der tiefgreifendsten und am schwierigsten zu lösenden Herausforderungen der künstlichen Intelligenz ist ihre Tendenz, gesellschaftliche Vorurteile und Stereotypen nicht nur zu reproduzieren, sondern oft sogar zu verstärken. KI-Modelle lernen, indem sie Muster in riesigen Datenmengen erkennen, die von Menschen erstellt wurden. Da diese Daten die Gesamtheit menschlicher Kultur, Geschichte und Kommunikation umfassen, spiegeln sie unweigerlich auch deren inhärente Voreingenommenheiten wider.

Die Konsequenzen sind weitreichend und in vielen Anwendungen sichtbar. KI-Bilderzeuger, die aufgefordert werden, eine “erfolgreiche Person” darzustellen, generieren überwiegend Bilder von jungen, weissen Männern in Geschäftskleidung, was ein enges und stereotypes Bild von Erfolg vermittelt. Anfragen nach Personen in bestimmten Berufen führen zu extremer stereotyper Darstellung: Softwareentwickler werden fast ausschliesslich als Männer, Flugbegleiterinnen fast ausschliesslich als Frauen dargestellt, was die realen Verhältnisse in diesen Berufen stark verzerrt. Sprachmodelle können negative Eigenschaften überproportional mit bestimmten ethnischen Gruppen assoziieren oder geschlechtsspezifische Stereotypen in beruflichen Kontexten festschreiben.

Versuche der Entwickler, diese Verzerrungen durch einfache Regeln zu “korrigieren”, sind oft spektakulär gescheitert. Der Versuch, künstlich für mehr Diversität zu sorgen, führte zu historisch absurden Bildern wie ethnisch diversen Nazi-Soldaten, was die Komplexität des Problems unterstreicht. Diese Vorfälle offenbaren eine fundamentale Wahrheit: “Bias” ist kein technischer Fehler, der einfach behoben werden kann, sondern ein inhärentes Merkmal von Systemen, die auf menschlichen Daten trainiert werden. Die Suche nach einem einzigen, universell “unvoreingenommenen” KI-Modell ist daher wahrscheinlich eine Fehlannahme. Die Lösung liegt nicht in der unmöglichen Eliminierung von Voreingenommenheit, sondern in Transparenz und Kontrolle. Zukünftige Systeme müssen es den Nutzern ermöglichen, die inhärenten Tendenzen eines Modells zu verstehen und sein Verhalten für spezifische Kontexte anzupassen. Dies schafft eine dauerhafte Notwendigkeit für menschliche Aufsicht und Steuerung (“Human-in-the-Loop”), was der Vision einer vollständigen Automatisierung widerspricht.

Datenschutz und Privatsphäre: Die neue Frontlinie

Die Entwicklung grosser Sprachmodelle hat eine neue Dimension der Datenschutzrisiken eröffnet. Diese Modelle werden auf unvorstellbar grossen Datenmengen aus dem Internet trainiert, die oft ohne explizite Zustimmung der Urheber oder betroffenen Personen gesammelt wurden. Dies schliesst persönliche Blog-Posts, Forenbeiträge, private Korrespondenz und andere sensible Informationen mit ein. Aus dieser Praxis ergeben sich zwei zentrale Gefahren für die Privatsphäre.

Die erste Gefahr ist die “Daten-Memorierung”. Obwohl die Modelle darauf ausgelegt sind, allgemeine Muster zu lernen, können sie versehentlich spezifische, einzigartige Informationen aus ihren Trainingsdaten auswendig lernen und auf Anfrage wiedergeben. Dies kann zur unbeabsichtigten Offenlegung von persönlich identifizierbaren Informationen (PII) wie Namen, Adressen, Telefonnummern oder vertraulichen Geschäftsgeheimnissen führen, die im Trainingsdatensatz enthalten waren.

Die zweite, subtilere Gefahr sind sogenannte “Membership Inference Attacks” (MIAs). Dabei versuchen Angreifer herauszufinden, ob die Daten einer bestimmten Person Teil des Trainingsdatensatzes eines Modells waren. Ein erfolgreicher Angriff könnte beispielsweise aufdecken, dass eine Person in einem medizinischen Forum über eine bestimmte Krankheit geschrieben hat, selbst wenn der genaue Text nicht wiedergegeben wird. Dies stellt eine erhebliche Verletzung der Privatsphäre dar und untergräbt das Vertrauen in die Sicherheit von KI-Systemen.

Die Desinformations-Maschine

Eine der offensichtlichsten und unmittelbarsten Gefahren generativer KI ist ihr Potenzial zur Erzeugung und Verbreitung von Desinformation in einem bisher unvorstellbaren Ausmass. Grosse Sprachmodelle können auf Knopfdruck glaubwürdig klingende, aber völlig erfundene Texte, sogenannte “Halluzinationen”, produzieren. Während dies bei harmlosen Anfragen zu kuriosen Ergebnissen führen kann, wird es bei böswilliger Absicht zu einer mächtigen Waffe.

Die Technologie ermöglicht es, in grossem Stil gefälschte Nachrichtenartikel, Propagandatexte, gefälschte Produktbewertungen oder personalisierte Phishing-E-Mails zu erstellen, die von menschlich verfassten Texten kaum zu unterscheiden sind. In Kombination mit KI-generierten Bildern und Videos (Deepfakes) entsteht ein Arsenal an Werkzeugen, das die öffentliche Meinungsbildung manipulieren, das Vertrauen in Institutionen untergraben und demokratische Prozesse gefährden kann. Die Fähigkeit, Desinformation zu erzeugen, ist keine Fehlfunktion der Technologie, sondern eine ihrer Kernkompetenzen, was die Regulierung und Kontrolle zu einer dringenden gesellschaftlichen Aufgabe macht.

Urheberrecht und geistiges Eigentum: Ein rechtliches Minenfeld

Die Art und Weise, wie KI-Modelle trainiert werden, hat eine Welle von rechtlichen Auseinandersetzungen im Bereich des Urheberrechts ausgelöst. Da die Modelle auf Daten aus dem gesamten Internet trainiert werden, schliesst dies unweigerlich urheberrechtlich geschützte Werke wie Bücher, Artikel, Bilder und Code mit ein, oft ohne die Erlaubnis der Rechteinhaber. Zahlreiche Klagen von Autoren, Künstlern und Verlagen sind die Folge. Die zentrale rechtliche Frage, ob das Training von KI-Modellen unter die “Fair Use”-Doktrin fällt, ist noch ungeklärt und wird die Gerichte noch Jahre beschäftigen.

Gleichzeitig ist der rechtliche Status von KI-generierten Inhalten selbst unklar. Wer ist der Urheber eines von einer KI geschaffenen Bildes oder Textes? Der Nutzer, der den Prompt eingegeben hat? Das Unternehmen, das das Modell entwickelt hat? Oder kann ein nicht-menschliches System überhaupt Urheber sein? Diese Unsicherheit schafft ein rechtliches Vakuum und birgt erhebliche Risiken für Unternehmen, die KI-generierte Inhalte kommerziell nutzen wollen. Es drohen Klagen wegen Urheberrechtsverletzung, wenn das generierte Werk unbewusst Elemente aus den Trainingsdaten reproduziert.

Diese rechtlichen und datenschutzrechtlichen Risiken stellen eine Art “schlafende Verbindlichkeit” für die gesamte KI-Branche dar. Die aktuellen Bewertungen der führenden KI-Unternehmen spiegeln dieses systemische Risiko kaum wider. Eine wegweisende Gerichtsentscheidung gegen ein grosses KI-Unternehmen – sei es wegen massiver Urheberrechtsverletzung oder einer schwerwiegenden Datenschutzverletzung – könnte einen Präzedenzfall schaffen. Ein solches Urteil könnte Unternehmen zwingen, ihre Modelle von Grund auf mit lizenzierten, “sauberen” Daten neu zu trainieren, was astronomische Kosten verursachen und ihr wertvollstes Gut entwerten würde. Alternativ könnten massive Geldstrafen nach Datenschutzgesetzen wie der DSGVO verhängt werden. Diese unquantifizierte rechtliche Unsicherheit stellt eine erhebliche Bedrohung für die langfristige Rentabilität und Stabilität der Branche dar.

🎯🎯🎯 Profitieren Sie von der umfangreichen, fünffachen Expertise von Xpert.Digital in einem umfassenden Servicepaket | BD, R&D, XR, PR & Digitale Sichtbarkeitsoptimierung

Profitieren Sie von der umfangreichen, fünffachen Expertise von Xpert.Digital in einem umfassenden Servicepaket | R&D, XR, PR & Digitale Sichtbarkeitsoptimierung - Bild: Xpert.Digital

Xpert.Digital verfügt über tiefgehendes Wissen in verschiedenen Branchen. Dies erlaubt es uns, maßgeschneiderte Strategien zu entwickeln, die exakt auf die Anforderungen und Herausforderungen Ihres spezifischen Marktsegments zugeschnitten sind. Indem wir kontinuierlich Markttrends analysieren und Branchenentwicklungen verfolgen, können wir vorausschauend agieren und innovative Lösungen anbieten. Durch die Kombination aus Erfahrung und Wissen generieren wir einen Mehrwert und verschaffen unseren Kunden einen entscheidenden Wettbewerbsvorteil.

Mehr dazu hier:

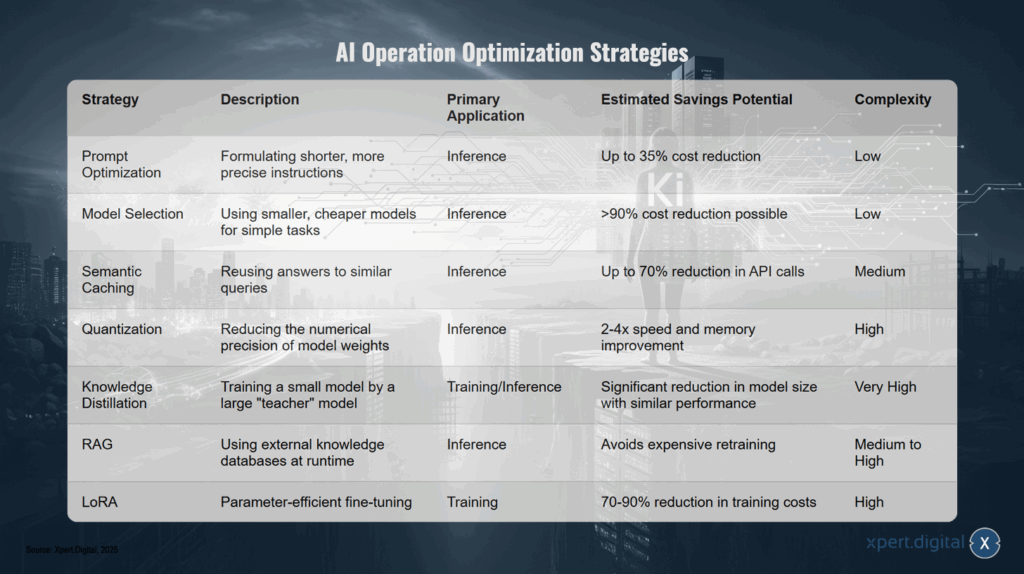

Prompt-Optimierung, Caching, Quantisierung: Praxis-Tools für günstigere KI – KI-Kosten um bis zu 90 % reduzieren

Strategien zur Optimierung: Wege zu effizienteren und kostengünstigeren KI-Modellen

Grundlagen der Kostenoptimierung auf Anwendungsebene

Angesichts der enormen Betriebs- und Entwicklungskosten von KI-Systemen ist die Optimierung zu einer entscheidenden Disziplin für die wirtschaftliche Tragfähigkeit geworden. Glücklicherweise gibt es eine Reihe von Strategien auf Anwendungsebene, die Unternehmen implementieren können, um die Kosten signifikant zu senken, ohne die Leistung wesentlich zu beeinträchtigen.

Eine der einfachsten und effektivsten Methoden ist die Prompt-Optimierung. Da die Kosten vieler KI-Dienste direkt von der Anzahl der verarbeiteten Ein- und Ausgabetoken abhängen, kann die Formulierung kürzerer und präziserer Anweisungen erhebliche Einsparungen bringen. Durch das Entfernen unnötiger Füllwörter und die klare Strukturierung von Anfragen können die Input-Token und damit die Kosten um bis zu 35 % reduziert werden.

Eine weitere grundlegende Strategie ist die Wahl des richtigen Modells für die jeweilige Aufgabe. Nicht jede Anwendung erfordert das leistungsstärkste und teuerste verfügbare Modell. Für einfache Aufgaben wie Textklassifizierung, Datenextraktion oder Standard-Frage-Antwort-Systeme sind kleinere, spezialisierte Modelle oft völlig ausreichend und weitaus kostengünstiger. Der Kostenunterschied kann dramatisch sein: Während ein Premium-Modell wie GPT-4 rund 30 US-Dollar pro Million Output-Token kostet, sind es bei einem kleineren Open-Source-Modell wie Mistral 7B nur 0.25 US-Dollar pro Million Token. Unternehmen können durch eine intelligente, aufgabenbasierte Modellauswahl massive Kosteneinsparungen erzielen, oft ohne einen spürbaren Leistungsunterschied für den Endnutzer.

Eine dritte leistungsstarke Technik ist das semantische Caching. Anstatt für jede Anfrage eine neue Antwort vom KI-Modell generieren zu lassen, speichert ein Caching-System die Antworten auf häufig gestellte oder semantisch ähnliche Fragen. Studien zeigen, dass bis zu 31 % der Anfragen an LLMs sich inhaltlich wiederholen. Durch die Implementierung eines semantischen Caches können Unternehmen die Anzahl der teuren API-Aufrufe um bis zu 70 % reduzieren, was sowohl die Kosten senkt als auch die Antwortgeschwindigkeit erhöht.

Passend dazu:

- Das Ende des KI-Trainings? KI-Strategien im Wandel: “Blueprint”-Ansatz statt Datenberge – Die Zukunft der KI in Unternehmen

Technische Tiefenanalyse: Modell-Quantisierung

Für Unternehmen, die ihre eigenen Modelle betreiben oder anpassen, bieten fortgeschrittenere technische Verfahren noch grösseres Optimierungspotenzial. Eine der wirkungsvollsten Techniken ist die Modell-Quantisierung. Dabei handelt es sich um einen Kompressionsprozess, bei dem die Präzision der numerischen Gewichte, aus denen ein neuronales Netz besteht, reduziert wird. Typischerweise werden die Gewichte von einem hochpräzisen 32-Bit-Gleitkommaformat (FP32) in ein niederpräziseres 8-Bit-Ganzzahlformat (INT8) umgewandelt.

Diese Reduzierung der Datengrösse hat zwei entscheidende Vorteile. Erstens verringert sie den Speicherbedarf des Modells drastisch, oft um den Faktor vier. Dies ermöglicht den Betrieb grösserer Modelle auf kostengünstigerer Hardware mit weniger Arbeitsspeicher. Zweitens beschleunigt die Quantisierung die Inferenzgeschwindigkeit, also die Zeit, die das Modell für eine Antwort benötigt, um den Faktor zwei bis drei. Dies liegt daran, dass Berechnungen mit Ganzzahlen auf moderner Hardware wesentlich effizienter durchgeführt werden können als mit Gleitkommazahlen. Der Kompromiss bei der Quantisierung ist ein potenzieller, aber oft minimaler Genauigkeitsverlust, der als “Quantisierungsfehler” bezeichnet wird. Es gibt verschiedene Methoden wie die Post-Training Quantization (PTQ), die auf ein bereits trainiertes Modell angewendet wird, und die Quantization-Aware Training (QAT), bei der die Quantisierung bereits während des Trainingsprozesses simuliert wird, um die Genauigkeit zu erhalten.

Technische Tiefenanalyse: Wissensdestillation

Eine weitere fortgeschrittene Optimierungstechnik ist die Wissensdestillation. Dieses Verfahren basiert auf einem “Lehrer-Schüler”-Paradigma. Ein sehr grosses, komplexes und teures “Lehrermodell” (z.B. GPT-4) wird verwendet, um ein wesentlich kleineres, effizienteres “Schülermodell” zu trainieren. Der Clou dabei ist, dass das Schülermodell nicht nur lernt, die endgültigen Antworten (die “harten Ziele”) des Lehrers zu imitieren. Stattdessen wird es darauf trainiert, die internen Denkprozesse und Wahrscheinlichkeitsverteilungen (die “weichen Ziele”) des Lehrermodells nachzubilden.

Indem das Schülermodell lernt, “wie” das Lehrermodell zu seinen Schlussfolgerungen kommt, kann es eine vergleichbare Leistung bei spezifischen Aufgaben erzielen, jedoch mit einem Bruchteil der Rechenressourcen und Kosten. Diese Technik ist besonders nützlich, um leistungsstarke, aber ressourcenintensive Allzweckmodelle auf spezifische Anwendungsfälle zuzuschneiden und sie für den Einsatz auf kostengünstigerer Hardware oder in Echtzeitanwendungen zu optimieren.

Weitere fortgeschrittene Architekturen und Techniken

Neben Quantisierung und Wissensdestillation gibt es eine Reihe weiterer vielversprechender Ansätze zur Effizienzsteigerung:

- Retrieval-Augmented Generation (RAG): Anstatt Wissen direkt im Modell zu speichern, was ein kostspieliges Training erfordert, greift das Modell bei Bedarf auf externe Wissensdatenbanken zu. Dies verbessert die Aktualität und Genauigkeit der Antworten und reduziert die Notwendigkeit für ständiges Neutraining.

- Low-Rank Adaptation (LoRA): Eine parameter-effiziente Feinabstimmungsmethode, bei der nicht alle Millionen von Parametern eines Modells, sondern nur eine kleine Teilmenge angepasst wird. Dies kann die Kosten für die Feinabstimmung um 70 % bis 90 % senken.

- Pruning und Mixture of Experts (MoE): Beim Pruning werden redundante oder unwichtige Parameter aus einem trainierten Modell entfernt, um es zu verkleinern. MoE-Architekturen teilen das Modell in spezialisierte “Experten”-Module auf und aktivieren bei jeder Anfrage nur die relevanten Teile, was die Rechenlast erheblich reduziert.

Die Verbreitung dieser Optimierungsstrategien signalisiert einen wichtigen Reifeprozess in der KI-Branche. Der Fokus verschiebt sich von der reinen Jagd nach Spitzenleistung in Benchmarks hin zur wirtschaftlichen Tragfähigkeit. Der Wettbewerbsvorteil liegt nicht mehr nur im grössten Modell, sondern zunehmend im effizientesten Modell für eine bestimmte Aufgabe. Dies könnte neuen Akteuren, die sich auf “KI-Effizienz” spezialisieren, die Tür öffnen und den Markt nicht über rohe Leistung, sondern über ein überlegenes Preis-Leistungs-Verhältnis herausfordern.

Gleichzeitig schaffen diese Optimierungsstrategien jedoch eine neue Form der Abhängigkeit. Techniken wie Wissensdestillation und Feinabstimmung machen das Ökosystem kleinerer, effizienter Modelle fundamental abhängig von der Existenz einiger weniger, ultra-teurer “Lehrermodelle” von OpenAI, Google und Anthropic. Anstatt einen dezentralen Markt zu fördern, könnte dies eine feudale Struktur zementieren, in der einige wenige “Herren” die Quelle der Intelligenz kontrollieren, während eine grosse Zahl von “Vasallen” für den Zugang bezahlt und darauf aufbauende, abhängige Dienste entwickelt.

KI-Betrieb Optimierungsstrategien

Zu den wichtigen KI-Betriebs-Optimierungsstrategien zählen unter anderem die Prompt-Optimierung, bei der kürzere und präzisere Anweisungen formuliert werden, um Inferenzkosten zu senken — dies kann zu einer Kostenreduktion von bis zu 35 % führen und ist vergleichsweise gering in der Komplexität. Die Modell-Auswahl setzt auf den Einsatz kleinerer, günstigerer Modelle für einfache Aufgaben während der Inferenz und kann dadurch mögliche Einsparungen von über 90 % erzielen bei ebenfalls niedriger Umsetzungskomplexität. Semantisches Caching ermöglicht die Wiederverwendung von Antworten auf ähnliche Anfragen, reduziert API-Aufrufe um bis zu etwa 70 % und verlangt einen mittleren Aufwand. Quantisierung verringert die numerische Präzision der Modellgewichte, was die Inferenz um den Faktor 2–4 in Geschwindigkeit und Speicherbedarf verbessert, jedoch mit hoher technischer Komplexität einhergeht. Wissensdestillation beschreibt das Training eines kleinen Modells durch ein großes „Lehrer“-Modell, wodurch sich die Modellgröße erheblich reduzieren lässt bei vergleichbarer Leistung — dieser Ansatz ist sehr komplex. RAG (Retrieval-Augmented Generation) nutzt externe Wissensdatenbanken zur Laufzeit, vermeidet teures Neutraining und hat eine mittlere bis hohe Komplexität. Schließlich bietet LoRA (Low-Rank Adapters) eine parameter-effiziente Feinabstimmung während des Trainings und kann die Trainingskosten um 70–90 % reduzieren, ist aber ebenfalls mit hoher Komplexität verbunden.

Marktdynamik und Ausblick: Konsolidierung, Wettbewerb und die Zukunft der künstlichen Intelligenz

Die Flut des Risikokapitals: Ein Beschleuniger der Konsolidierung

Die KI-Branche erlebt derzeit eine beispiellose Flut an Risikokapital, die die Marktdynamik nachhaltig prägt. Allein im ersten Halbjahr 2025 flossen weltweit 49.2 Milliarden US-Dollar an Wagniskapital in den Bereich der generativen KI, was bereits die Gesamtsumme des gesamten Jahres 2024 übertrifft. Im Silicon Valley, dem Epizentrum der technologischen Innovation, entfallen mittlerweile 93 % aller Investitionen in Scale-ups auf den KI-Sektor.

Diese Kapitalflut führt jedoch nicht zu einer breiten Diversifizierung des Marktes. Im Gegenteil, das Geld konzentriert sich zunehmend auf eine kleine Anzahl von bereits etablierten Unternehmen in Form von Mega-Finanzierungsrunden. Deals wie die 40-Milliarden-Dollar-Runde für OpenAI, die 14.3-Milliarden-Dollar-Investition in Scale AI oder die 10-Milliarden-Dollar-Runde für xAI dominieren die Landschaft. Während sich die durchschnittliche Grösse von Late-Stage-Deals verdreifacht hat, ist die Finanzierung für Start-ups in der Frühphase zurückgegangen. Diese Entwicklung hat weitreichende Konsequenzen: Anstatt als Motor für dezentrale Innovation zu fungieren, wirkt das Risikokapital im KI-Sektor als Brandbeschleuniger für die Zentralisierung von Macht und Ressourcen bei den etablierten Technologiegiganten und ihren engsten Partnern.

Die immense Kostenstruktur der KI-Entwicklung verstärkt diesen Trend. Start-ups sind vom ersten Tag an auf die teure Cloud-Infrastruktur und Hardware der grossen Tech-Konzerne wie Amazon (AWS), Google (GCP), Microsoft (Azure) und Nvidia angewiesen. Ein erheblicher Teil der riesigen Finanzierungsrunden, die von Unternehmen wie OpenAI oder Anthropic aufgenommen werden, fliesst direkt zurück an ihre eigenen Investoren in Form von Zahlungen für Rechenleistung. Das Wagniskapital schafft somit keine unabhängigen Wettbewerber, sondern finanziert die Kunden der Tech-Giganten, was deren Ökosystem und Marktposition weiter stärkt. Die erfolgreichsten Start-ups werden letztendlich oft von den grossen Playern übernommen, was die Marktkonzentration weiter vorantreibt. Das KI-Start-up-Ökosystem entwickelt sich so zu einer De-facto-Pipeline für Forschung, Entwicklung und Talentakquise für die “Magnificent Seven”. Das Endziel scheint kein lebendiger Markt mit vielen Akteuren zu sein, sondern ein konsolidiertes Oligopol, in dem einige wenige Unternehmen die Kerninfrastruktur der künstlichen Intelligenz kontrollieren.

M&A-Welle und der Kampf der Giganten

Parallel zur Konzentration des Risikokapitals rollt eine massive Welle von Fusionen und Übernahmen (M&A) durch den Markt. Das weltweite M&A-Transaktionsvolumen ist im Jahr 2025 auf 2.6 Billionen US-Dollar gestiegen, angetrieben durch den strategischen Zukauf von KI-Kompetenzen. Die “Magnificent Seven” stehen im Zentrum dieser Entwicklung. Sie nutzen ihre enormen Finanzreserven, um gezielt vielversprechende Start-ups, Technologien und Talentpools zu akquirieren.

Für diese Konzerne ist die Dominanz im KI-Bereich keine Option, sondern eine strategische Notwendigkeit. Ihre traditionellen, hochprofitablen Geschäftsmodelle – wie die Microsoft Office Suite, die Google-Suche oder die Social-Media-Plattformen von Meta – nähern sich dem Ende ihres Lebenszyklus oder stagnieren in ihrem Wachstum. Die KI wird als die nächste grosse Plattform gesehen, und jeder dieser Giganten strebt nach einer globalen Monopolstellung in diesem neuen Paradigma, um seinen Marktwert und seine Relevanz für die Zukunft zu sichern. Dieser Kampf der Giganten führt zu einem aggressiven Übernahmemarkt, der es unabhängigen Unternehmen erschwert, zu überleben und zu skalieren.

Wirtschaftliche Prognosen: Zwischen Produktivitätswunder und Ernüchterung

Die langfristigen wirtschaftlichen Prognosen für die Auswirkungen der KI sind von einer tiefen Ambivalenz geprägt. Auf der einen Seite stehen optimistische Vorhersagen, die ein neues Zeitalter des Produktivitätswachstums verheissen. Schätzungen gehen davon aus, dass die KI das Bruttoinlandsprodukt bis 2035 um 1.5 % steigern und das globale Wirtschaftswachstum insbesondere in den frühen 2030er Jahren signifikant ankurbeln könnte. Einige Analysen prognostizieren sogar, dass KI-Technologien bis 2030 einen zusätzlichen globalen Umsatz von über 15 Billionen US-Dollar generieren könnten.

Auf der anderen Seite steht die ernüchternde Realität der Gegenwart. Wie bereits analysiert, sehen 95 % der Unternehmen derzeit keinen messbaren ROI aus ihren KI-Investitionen. Im Gartner Hype Cycle, einem einflussreichen Modell zur Bewertung neuer Technologien, ist die generative KI bereits in das “Tal der Enttäuschungen” eingetreten. In dieser Phase weicht die anfängliche Euphorie der Erkenntnis, dass die Implementierung komplex, der Nutzen oft unklar und die Herausforderungen grösser sind als erwartet. Diese Diskrepanz zwischen dem langfristigen Potenzial und den kurzfristigen Schwierigkeiten wird die wirtschaftliche Entwicklung in den kommenden Jahren prägen.

Passend dazu:

- KI-Effizienz ohne KI-Strategie als Grundvoraussetzung? Warum Unternehmen nicht blind auf KI setzen sollten

Blase und Monopol: Das doppelte Gesicht der KI‑Revolution

Die Analyse der verschiedenen Dimensionen des KI-Booms führt zu einem komplexen und widersprüchlichen Gesamtbild. Die künstliche Intelligenz befindet sich an einem entscheidenden Scheideweg. Der aktuelle Pfad der reinen Skalierung – immer grössere Modelle, die immer mehr Daten und Energie verbrauchen – erweist sich als wirtschaftlich und ökologisch nicht nachhaltig. Die Zukunft gehört jenen Unternehmen, die den schmalen Grat zwischen Hype und Realität meistern und sich darauf konzentrieren, durch effiziente, zuverlässige und ethisch verantwortungsvolle KI-Systeme einen greifbaren Geschäftswert zu schaffen.

Die Konsolidierungsdynamik hat zudem eine geopolitische Dimension. Die Dominanz der USA im KI-Sektor wird durch die Konzentration von Kapital und Talent zementiert. Von 39 weltweit anerkannten KI-Einhörnern haben 29 ihren Sitz in den USA, die zwei Drittel der globalen VC-Investitionen in diesem Sektor auf sich vereinen. Für Europa und andere Regionen wird es zunehmend schwieriger, bei der Entwicklung von Grundlagenmodellen mitzuhalten. Dies schafft neue technologische und wirtschaftliche Abhängigkeiten und macht die Kontrolle über KI zu einem zentralen geopolitischen Machtfaktor, vergleichbar mit der Kontrolle über Energie oder Finanzsysteme.

Der Bericht schliesst mit der Erkenntnis eines zentralen Paradoxons: Die KI-Industrie ist gleichzeitig eine spekulative Blase auf der Anwendungsebene, wo die meisten Unternehmen Verluste schreiben, und eine revolutionäre, monopolbildende Plattformverschiebung auf der Infrastrukturebene, wo wenige Unternehmen enorme Gewinne erzielen. Die strategische Hauptaufgabe für Entscheidungsträger in Wirtschaft und Politik wird in den kommenden Jahren darin bestehen, diese duale Natur der KI-Revolution zu verstehen und zu steuern. Es geht nicht mehr nur darum, eine neue Technologie zu adoptieren, sondern darum, die wirtschaftlichen, gesellschaftlichen und geopolitischen Spielregeln für das Zeitalter der künstlichen Intelligenz neu zu definieren.

Ihr globaler Marketing und Business Development Partner

☑️ Unsere Geschäftssprache ist Englisch oder Deutsch

☑️ NEU: Schriftverkehr in Ihrer Landessprache!

Gerne stehe ich Ihnen und mein Team als persönlicher Berater zur Verfügung.

Sie können mit mir Kontakt aufnehmen, indem Sie hier das Kontaktformular ausfüllen oder rufen Sie mich einfach unter +49 89 89 674 804 (München) an. Meine E-Mail Adresse lautet: wolfenstein∂xpert.digital

Ich freue mich auf unser gemeinsames Projekt.

☑️ KMU Support in der Strategie, Beratung, Planung und Umsetzung

☑️ Erstellung oder Neuausrichtung der Digitalstrategie und Digitalisierung

☑️ Ausbau und Optimierung der internationalen Vertriebsprozesse

☑️ Globale & Digitale B2B-Handelsplattformen

☑️ Pioneer Business Development / Marketing / PR / Messen

Unsere globale Branchen- und Wirtschafts-Expertise in Business Development, Vertrieb und Marketing

Unsere globale Branchen- und Wirtschafts-Expertise in Business Development, Vertrieb und Marketing - Bild: Xpert.Digital

Branchenschwerpunkte: B2B, Digitalisierung (von KI bis XR), Maschinenbau, Logistik, Erneuerbare Energien und Industrie

Mehr dazu hier:

Ein Themenhub mit Einblicken und Fachwissen:

- Wissensplattform rund um die globale wie regionale Wirtschaft, Innovation und branchenspezifische Trends

- Sammlung von Analysen, Impulsen und Hintergründen aus unseren Schwerpunktbereichen

- Ein Ort für Expertise und Informationen zu aktuellen Entwicklungen in Wirtschaft und Technologie

- Themenhub für Unternehmen, die sich zu Märkten, Digitalisierung und Brancheninnovationen informieren möchten