Unabhängige KI-Plattformen als strategische Alternative für europäische Unternehmen

Xpert Pre-Release

Sprachauswahl 📢

Veröffentlicht am: 15. April 2025 / Update vom: 16. April 2025 – Verfasser: Konrad Wolfenstein

Unabhängige KI-Plattformen als strategische Alternative für europäische Unternehmen – Bild: Xpert.Digital

Unabhängige KI-Plattformen vs. Hyperscaler: Welche Lösung passt? (Lesezeit: 35 min / Keine Werbung / Keine Paywall)

Unabhängige KI-Plattformen im Vergleich zu Alternativen

Die Auswahl der richtigen Plattform für die Entwicklung und den Betrieb von Anwendungen der Künstlichen Intelligenz (KI) ist eine strategische Entscheidung mit weitreichenden Konsequenzen. Unternehmen stehen vor der Wahl zwischen den Angeboten großer Hyperscaler, vollständig intern entwickelten Lösungen und sogenannten unabhängigen KI-Plattformen. Um eine fundierte Entscheidung treffen zu können, ist eine klare Abgrenzung dieser Ansätze unerlässlich.

Passend dazu:

- KI-Integration einer unabhängigen und Datenquellen-übergreifenden KI-Plattform für alle Unternehmensbelange

Charakterisierung unabhängiger KI-Plattformen (inkl. souveräner/privater KI-Konzepte)

Unabhängige KI-Plattformen werden typischerweise von Anbietern bereitgestellt, die außerhalb des dominanten Ökosystems der Hyperscaler wie Amazon Web Services (AWS), Microsoft Azure und Google Cloud Platform (GCP) agieren. Ihr Fokus liegt oft auf der Bereitstellung spezifischer Fähigkeiten für die Entwicklung, das Deployment und das Management von KI- und Machine-Learning-(ML)-Modellen, wobei Aspekte wie Datenkontrolle, Anpassbarkeit oder vertikale Branchenintegration stärker betont werden können. Diese Plattformen können auf privater Cloud-Infrastruktur, On-Premises oder, in einigen Fällen, auch auf der Infrastruktur von Hyperscalern betrieben werden, bieten dabei jedoch eine distinkte Management- und Kontrollschicht.

Ein zentrales Konzept, das insbesondere im europäischen Kontext an Bedeutung gewinnt und oft mit unabhängigen Plattformen assoziiert wird, ist die „souveräne KI“. Dieser Begriff unterstreicht die Notwendigkeit der Kontrolle über Daten und Technologie. Arvato Systems beispielsweise unterscheidet zwischen „öffentlicher KI“ (vergleichbar mit Hyperscaler-Ansätzen, die Nutzereingaben potenziell zum Training verwenden) und „souveräner KI“. Souveräne KI lässt sich weiter differenzieren:

- Selbstbestimmte souveräne KI: Hierbei handelt es sich um mandantenfähige Lösungen, die eventuell auf Hyperscaler-Infrastruktur betrieben werden, jedoch mit garantierten EU-Datengrenzen („EU Data Boundary“) oder im reinen EU-Betrieb. Oft bauen sie auf öffentlichen Large Language Models (LLMs) auf, die für spezifische Zwecke feinjustiert („fine-tuned“) werden. Dieser Ansatz sucht einen Kompromiss zwischen den Fähigkeiten moderner KI und der notwendigen Kontrolle über die Daten.

- Autarke souveräne KI: Diese Stufe repräsentiert die maximale Kontrolle. Die KI-Modelle werden lokal betrieben, ohne Abhängigkeiten von Dritten, und sind auf Basis eigener Daten trainiert. Sie sind oft hochspezialisiert auf eine bestimmte Aufgabe. Diese Autarkie maximiert die Kontrolle, kann aber potenziell zu Lasten der allgemeinen Leistungsfähigkeit oder Breite der Anwendbarkeit gehen.

Im Gegensatz zu Hyperscalern, die auf breite, horizontale Serviceportfolios abzielen, konzentrieren sich unabhängige Plattformen häufiger auf spezifische Nischen, bieten spezialisierte Werkzeuge, vertikale Lösungen oder positionieren sich explizit über Merkmale wie Datenschutz und Datenkontrolle als Kernnutzenversprechen. Localmind etwa wirbt explizit mit der Möglichkeit, KI-Assistenten auf eigenen Servern zu betreiben. Die Nutzung oder Ermöglichung von Private-Cloud-Deployments ist dabei ein häufiges Merkmal, das Organisationen die volle Kontrolle über Datenspeicherung und -verarbeitung gibt.

Abgrenzung von Hyperscaler-Plattformen (AWS, Azure, Google Cloud)

Hyperscaler sind große Cloud-Anbieter, die Eigentümer und Betreiber massiver, global verteilter Rechenzentren sind. Sie bieten hochgradig skalierbare, standardisierte Cloud-Computing-Ressourcen als Infrastructure-as-a-Service (IaaS), Platform-as-a-Service (PaaS) und Software-as-a-Service (SaaS) an, einschließlich umfangreicher Dienste für KI und ML. Zu den prominentesten Vertretern zählen AWS, Google Cloud, Microsoft Azure, aber auch IBM Cloud und Alibaba Cloud.

Ihr Hauptmerkmal ist die enorme horizontale Skalierbarkeit und ein sehr breites Portfolio an integrierten Diensten. Sie spielen eine zentrale Rolle in vielen digitalen Transformationsstrategien, da sie eine flexible und sichere Infrastruktur bereitstellen können. Im KI-Bereich bieten Hyperscaler typischerweise Machine-Learning-as-a-Service (MLaaS) an. Dies umfasst cloudbasierten Zugriff auf Datenspeicher, Rechenkapazität, Algorithmen und Schnittstellen, ohne dass lokale Installationen erforderlich sind. Das Angebot beinhaltet oft vortrainierte Modelle, Werkzeuge zur Modellerstellung (z.B. Azure AI, Google Vertex AI, AWS SageMaker) und die notwendige Infrastruktur für das Deployment.

Ein wesentliches Merkmal ist die tiefe Integration der KI-Dienste in das breitere Ökosystem des Hyperscalers (Compute, Storage, Networking, Datenbanken). Diese Integration kann Vorteile durch Nahtlosigkeit bieten, birgt aber gleichzeitig das Risiko einer starken Anbieterabhängigkeit („Vendor Lock-in“). Ein kritischer Unterscheidungspunkt betrifft die Datennutzung: Es bestehen Bedenken, dass Hyperscaler Kundendaten – oder zumindest Metadaten und Nutzungsmuster – zur Verbesserung ihrer eigenen Dienste verwenden könnten. Souveräne und unabhängige Plattformen adressieren diese Bedenken oft explizit. Microsoft beispielsweise gibt an, Kundendaten ohne Zustimmung nicht für das Training von Basismodellen zu verwenden, dennoch bleibt bei vielen Anwendern eine Restunsicherheit bestehen.

Vergleich mit intern entwickelten Lösungen (In-house)

Intern entwickelte Lösungen sind vollständig maßgeschneiderte KI-Plattformen, die von den internen IT- oder Data-Science-Teams einer Organisation selbst gebaut und verwaltet werden. Theoretisch bieten sie die maximale Kontrolle über jeden Aspekt der Plattform, ähnlich dem Konzept der autarken souveränen KI.

Die Herausforderungen dieses Ansatzes sind jedoch erheblich. Er erfordert signifikante Investitionen in spezialisiertes Personal (Data Scientists, ML-Ingenieure, Infrastruktur-Experten), lange Entwicklungszeiten und kontinuierlichen Aufwand für Wartung und Weiterentwicklung. Die Entwicklung und Skalierung können langsam sein, wodurch man Gefahr läuft, hinter der rasanten Innovation im KI-Bereich zurückzufallen. Sofern keine extremen Skaleneffekte oder sehr spezifische Anforderungen vorliegen, resultiert dieser Ansatz oft in höheren Gesamtbetriebskosten (Total Cost of Ownership, TCO) im Vergleich zur Nutzung externer Plattformen. Es besteht zudem das Risiko, Lösungen zu entwickeln, die nicht wettbewerbsfähig sind oder schnell veralten.

Die Grenzen zwischen diesen Plattformtypen können verschwimmen. Eine “unabhängige” Plattform kann durchaus auf der Infrastruktur eines Hyperscalers betrieben werden, aber einen eigenständigen Mehrwert durch spezifische Kontrollmechanismen, Features oder Compliance-Abstraktionen bieten. Localmind etwa ermöglicht den Betrieb auf eigenen Servern, aber auch die Nutzung proprietärer Modelle, was Cloud-Zugriff impliziert. Der entscheidende Unterschied liegt oft nicht nur im physischen Standort der Hardware, sondern vielmehr in der Kontrollschicht (Management Plane), dem Daten-Governance-Modell (wer kontrolliert die Daten und deren Nutzung?) und der Beziehung zum Anbieter. Eine Plattform kann funktional unabhängig sein, selbst wenn sie auf AWS-, Azure- oder GCP-Infrastruktur läuft, solange sie den Nutzer vom direkten Hyperscaler-Lock-in isoliert und einzigartige Kontroll-, Anpassungs- oder Compliance-Funktionen bietet. Der Kern der Unterscheidung liegt darin, wer die zentralen KI-Plattformdienste bereitstellt, welche Daten-Governance-Richtlinien gelten und wie viel Flexibilität außerhalb der standardisierten Hyperscaler-Angebote existiert.

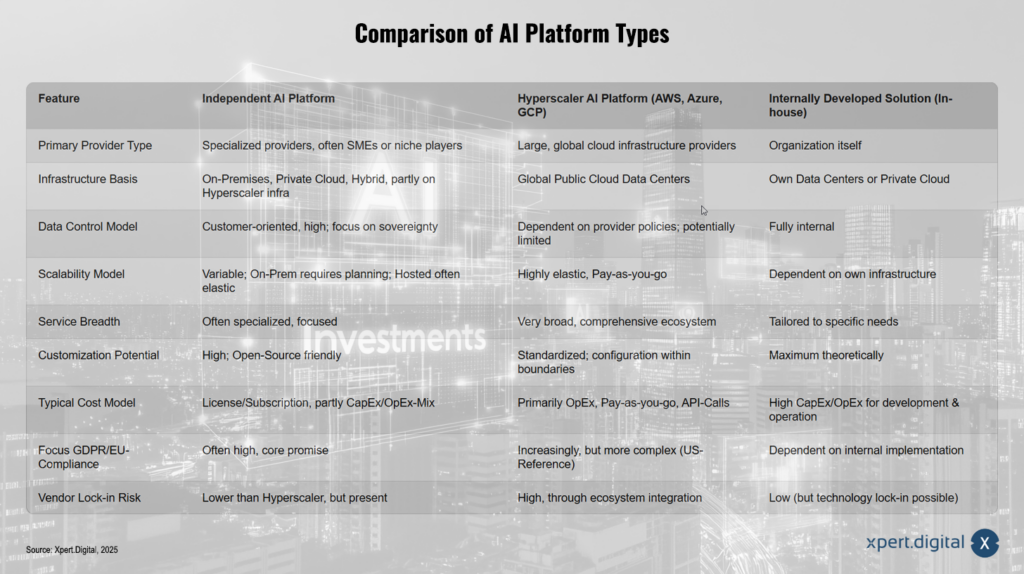

Vergleich der KI-Plattformtypen

Diese tabellarische Übersicht dient als Grundlage für die detaillierte Analyse der Vor- und Nachteile der verschiedenen Ansätze in den folgenden Abschnitten. Sie verdeutlicht die grundlegenden Unterschiede in Bezug auf Kontrolle, Flexibilität, Skalierbarkeit und potenzielle Abhängigkeiten.

Der Vergleich der KI-Plattformtypen zeigt Unterschiede zwischen unabhängigen KI-Plattformen, Hyperscaler-KI-Plattformen wie AWS, Azure und GCP sowie intern entwickelten Lösungen auf. Unabhängige KI-Plattformen werden meist von spezialisierten Anbietern, häufig KMU oder Nischenplayern, bereitgestellt, während Hyperscaler-Plattformen globale Cloud-Infrastruktur-Anbieter nutzen und intern entwickelte Lösungen von der Organisation selbst stammen. Bei der Infrastruktur setzen unabhängige Plattformen auf On-Premises, Private Cloud oder hybride Ansätze, die teils Hyperscaler-Infrastrukturen einbeziehen. Hyperscaler nutzen globale Public-Cloud-Rechenzentren, während intern entwickelte Lösungen auf eigenen Rechenzentren oder einer Private Cloud basieren. Hinsichtlich der Datenkontrolle bieten unabhängige Plattformen oft hohe Kundenorientierung und einen Fokus auf Datenhoheit, während Hyperscaler je nach Anbieterrichtlinien potenziell eingeschränkte Kontrolle bieten. Intern entwickelte Lösungen ermöglichen vollständige interne Datenkontrolle. Beim Skalierbarkeitsmodell sind unabhängige Plattformen variabel: On-Premises erfordert Planung, hosted Modelle sind oft elastisch. Hyperscaler bieten hochgradige Elastizität mit Pay-as-you-go-Modellen, während intern entwickelte Lösungen von der eigenen Infrastruktur abhängig sind. Die Service-Breite ist bei unabhängigen Plattformen oft spezialisiert und fokussiert, bei Hyperscalern hingegen sehr breit mit umfassendem Ökosystem. Intern entwickelte Lösungen sind auf spezifische Bedürfnisse zugeschnitten. Das Anpassungspotenzial ist bei unabhängigen Plattformen hoch, oft Open-Source-freundlich, während Hyperscaler standardisierte Konfigurationen innerhalb bestimmter Grenzen bieten. Intern entwickelte Lösungen ermöglichen das theoretisch maximale Anpassungspotenzial. Die Kostenmodelle variieren: Unabhängige Plattformen setzen oft auf Lizenz- oder Subskriptionsmodelle mit einem Mix aus CapEx und OpEx, während Hyperscaler primär OpEx-basierte Pay-as-you-go-Modelle nutzen. Intern entwickelte Lösungen erfordern hohe CapEx- und OpEx-Investitionen für Entwicklung und Betrieb. Der Fokus auf GDPR und EU-Compliance ist bei unabhängigen Plattformen oft hoch und ein Kernversprechen, während Hyperscaler zunehmend darauf eingehen, dies jedoch aufgrund des US-Bezugs komplexer sein kann. Bei intern entwickelten Lösungen hängt dies von der internen Umsetzung ab. Das Risiko eines Vendor Lock-ins ist bei unabhängigen Plattformen geringer als bei Hyperscalern, jedoch dennoch vorhanden. Hyperscaler bergen ein hohes Risiko durch ihre Ökosystem-Integration. Intern entwickelte Lösungen weisen ein geringes Vendor-Lock-in-Risiko auf, jedoch besteht die Möglichkeit eines Technologie-Lock-ins.

Vorteil bei Datensouveränität und Compliance im europäischen Kontext

Für Unternehmen, die in Europa tätig sind, stellen Datenschutz und die Einhaltung regulatorischer Vorgaben wie der Datenschutz-Grundverordnung (DSGVO) und des kommenden EU AI Acts zentrale Anforderungen dar. Unabhängige KI-Plattformen können in diesem Bereich signifikante Vorteile bieten.

Verbesserung von Datenschutz und Datensicherheit

Ein wesentlicher Vorteil unabhängiger Plattformen, insbesondere bei privatem oder On-Premises-Deployment, ist die granulare Kontrolle über den Speicherort und die Verarbeitung von Daten. Dies ermöglicht es Unternehmen, Datenlokalisierungsanforderungen, die sich aus der DSGVO oder branchenspezifischen Regulierungen ergeben können, direkt zu adressieren. In einer Private-Cloud-Umgebung behält die Organisation die volle Kontrolle darüber, wo ihre Daten gespeichert und wie sie verarbeitet werden.

Darüber hinaus erlauben private oder dedizierte Umgebungen die Implementierung von Sicherheitskonfigurationen, die exakt auf die spezifischen Bedürfnisse und Risikoprofile des Unternehmens zugeschnitten sind. Diese können unter Umständen über die generischen Sicherheitsmaßnahmen hinausgehen, die in Public-Cloud-Umgebungen standardmäßig angeboten werden. Auch wenn Hyperscaler wie Microsoft betonen, dass Sicherheit und Datenschutz “by design” berücksichtigt werden, bietet eine private Umgebung naturgemäß mehr direkte Kontroll- und Konfigurationsmöglichkeiten. Unabhängige Plattformen können zudem spezifische Sicherheitsmerkmale anbieten, die auf europäische Standards ausgerichtet sind, wie etwa erweiterte Governance-Funktionen.

Die Begrenzung der Datenexposition gegenüber großen, potenziell außerhalb der EU ansässigen Technologiekonzernen reduziert die Angriffsfläche für mögliche Datenschutzverletzungen, unbefugten Zugriff oder eine unbeabsichtigte Weiternutzung von Daten durch den Plattformanbieter. Die Nutzung internationaler Rechenzentren, die möglicherweise nicht die von der europäischen Datenschutzgesetzgebung geforderten Sicherheitsstandards erfüllen, stellt ein Risiko dar, das durch kontrollierte Umgebungen gemindert wird.

Erfüllung der Anforderungen von DSGVO und europäischen Regulierungen

Unabhängige oder souveräne KI-Plattformen können so gestaltet werden, dass sie die Grundprinzipien der DSGVO inhärent unterstützen:

- Datenminimierung (Art. 5 Abs. 1 lit. c DSGVO): In einer kontrollierten Umgebung ist es einfacher, sicherzustellen und zu auditieren, dass nur die für den Verarbeitungszweck notwendigen personenbezogenen Daten verwendet werden.

- Zweckbindung (Art. 5 Abs. 1 lit. b DSGVO): Die Durchsetzung spezifischer Verarbeitungszwecke und die Verhinderung einer Zweckentfremdung sind leichter zu gewährleisten.

- Transparenz (Art. 5 Abs. 1 lit. a, Art. 13, 14 DSGVO): Obwohl die Nachvollziehbarkeit von KI-Algorithmen („Explainable AI“) eine generelle Herausforderung bleibt, erleichtert die Kontrolle über die Plattform die Dokumentation von Datenflüssen und Verarbeitungslogiken. Dies ist essenziell für die Erfüllung der Informationspflichten gegenüber Betroffenen und für Audits. Betroffene müssen klar und verständlich darüber informiert werden, wie ihre Daten verarbeitet werden.

- Integrität und Vertraulichkeit (Art. 5 Abs. 1 lit. f DSGVO): Die Implementierung geeigneter technischer und organisatorischer Maßnahmen (TOMs) zum Schutz der Datensicherheit ist direkter steuerbar.

- Betroffenenrechte (Kapitel III DSGVO): Die Umsetzung von Rechten wie Auskunft, Berichtigung und Löschung („Recht auf Vergessenwerden“) kann durch die direkte Kontrolle über die Daten vereinfacht werden.

Mit Blick auf den EU AI Act, der risikobasierte Anforderungen an KI-Systeme stellt, sind Plattformen im Vorteil, die Transparenz, Kontrolle und auditierbare Prozesse bieten. Dies gilt insbesondere für den Einsatz von Hochrisiko-KI-Systemen, wie sie in Bereichen wie Bildung, Beschäftigung, kritische Infrastrukturen oder Rechtsdurchsetzung definiert sind. Unabhängige Plattformen könnten gezielt Funktionen zur Unterstützung der AI-Act-Compliance entwickeln oder anbieten.

Ein weiterer wesentlicher Punkt ist die Vermeidung problematischer Datentransfers in Drittländer. Die Nutzung von Plattformen, die innerhalb der EU gehostet werden oder On-Premises laufen, umgeht die Notwendigkeit komplexer rechtlicher Konstrukte (wie Standardvertragsklauseln oder Angemessenheitsbeschlüsse) für die Übermittlung personenbezogener Daten in Länder ohne adäquates Datenschutzniveau, wie z.B. die USA. Dies bleibt trotz Regelungen wie dem EU-US Data Privacy Framework eine persistente Herausforderung bei der Nutzung globaler Hyperscaler-Dienste.

Mechanismen zur Sicherstellung der Compliance

Unabhängige Plattformen bieten verschiedene Mechanismen, um die Einhaltung von Datenschutzvorschriften zu unterstützen:

- Private Cloud / On-Premises Deployment: Dies ist der direkteste Weg, um Datensouveränität und Kontrolle sicherzustellen. Die Organisation behält die physische oder logische Kontrolle über die Infrastruktur.

- Datenlokalisierung / EU Boundaries: Einige Anbieter garantieren vertraglich, dass Daten ausschließlich innerhalb der EU oder spezifischer Ländergrenzen verarbeitet werden, selbst wenn die zugrundeliegende Infrastruktur von einem Hyperscaler stammt. Microsoft Azure bietet beispielsweise europäische Serverstandorte an.

- Anonymisierungs- und Pseudonymisierungswerkzeuge: Plattformen können integrierte Funktionen zur Anonymisierung oder Pseudonymisierung von Daten anbieten, bevor diese in KI-Prozesse einfließen. Dies kann den Anwendungsbereich der DSGVO reduzieren. Federated Learning, bei dem Modelle lokal trainiert werden, ohne dass Rohdaten das Gerät verlassen, ist ein weiterer Ansatz.

- Compliance by Design / Privacy by Design: Plattformen können von Grund auf so konzipiert sein, dass sie Datenschutzprinzipien berücksichtigen („Privacy by Design“) und datenschutzfreundliche Voreinstellungen bieten („Privacy by Default“). Dies kann durch automatisierte Datenfilterung, detaillierte Audit-Logs zur Nachverfolgung von Datenverarbeitungsaktivitäten, granulare Zugriffskontrollen und Werkzeuge für das Data Governance und Consent Management unterstützt werden.

- Zertifizierungen: Offizielle Zertifizierungen gemäß Art. 42 DSGVO können die Einhaltung von Datenschutzstandards nach außen transparent belegen und als Wettbewerbsvorteil dienen. Solche Zertifikate können von Plattformanbietern angestrebt oder auf kontrollierten Plattformen leichter durch den Nutzer selbst erlangt werden. Sie können insbesondere für Auftragsverarbeiter den Nachweis der Einhaltung ihrer Pflichten gemäß Art. 28 DSGVO erleichtern. Auch etablierte Standards wie ISO 27001 sind in diesem Kontext relevant.

Die Fähigkeit, Compliance nicht nur zu erreichen, sondern auch nachzuweisen, entwickelt sich im europäischen Markt von einer reinen Notwendigkeit zu einem strategischen Vorteil. Datenschutz und vertrauenswürdige KI sind entscheidend für das Vertrauen von Kunden, Partnern und der Öffentlichkeit. Unabhängige Plattformen, die gezielt auf die europäischen regulatorischen Anforderungen eingehen und klare Compliance-Pfade bieten (z.B. durch garantierte Datenlokalisierung, transparente Verarbeitungsschritte, integrierte Kontrollmechanismen), ermöglichen es Unternehmen, Compliance-Risiken zu minimieren und Vertrauen aufzubauen. Sie können somit dazu beitragen, Compliance von einem reinen Kostenfaktor zu einem strategischen Asset zu transformieren, insbesondere in sensiblen Branchen oder bei der Verarbeitung kritischer Daten. Die Wahl einer Plattform, die Compliance vereinfacht und nachweisbar sicherstellt, ist somit eine strategische Entscheidung, die potenziell auch die Gesamt-Compliance-Kosten senken kann im Vergleich zur komplexen Navigation in globalen Hyperscaler-Umgebungen, um das gleiche Maß an Sicherheit und Nachweisbarkeit zu erreichen.

🎯🎯🎯 Profitieren Sie von der umfangreichen, fünffachen Expertise von Xpert.Digital in einem umfassenden Servicepaket | BD, R&D, XR, PR & Digitale Sichtbarkeitsoptimierung

Profitieren Sie von der umfangreichen, fünffachen Expertise von Xpert.Digital in einem umfassenden Servicepaket | R&D, XR, PR & Digitale Sichtbarkeitsoptimierung - Bild: Xpert.Digital

Xpert.Digital verfügt über tiefgehendes Wissen in verschiedenen Branchen. Dies erlaubt es uns, maßgeschneiderte Strategien zu entwickeln, die exakt auf die Anforderungen und Herausforderungen Ihres spezifischen Marktsegments zugeschnitten sind. Indem wir kontinuierlich Markttrends analysieren und Branchenentwicklungen verfolgen, können wir vorausschauend agieren und innovative Lösungen anbieten. Durch die Kombination aus Erfahrung und Wissen generieren wir einen Mehrwert und verschaffen unseren Kunden einen entscheidenden Wettbewerbsvorteil.

Mehr dazu hier:

Unabhängige KI-Plattformen: Mehr Kontrolle, weniger Abhängigkeit

Flexibilität, Anpassung und Kontrolle

Über die Aspekte der Datensouveränität hinaus bieten unabhängige KI-Plattformen oft ein höheres Maß an Flexibilität, Anpassbarkeit und Kontrolle im Vergleich zu den standardisierten Angeboten der Hyperscaler oder den potenziell ressourcenintensiven Eigenentwicklungen.

Maßgeschneiderte KI-Lösungen: Jenseits standardisierter Angebote

Unabhängige Plattformen können mehr Spielraum bei der Konfiguration der Entwicklungsumgebung, der Integration spezifischer Werkzeuge Dritter oder der Modifikation von Arbeitsabläufen bieten, als dies bei den oft stärker standardisierten PaaS- und SaaS-Diensten der Hyperscaler der Fall ist. Während manche Baukasten-Systeme, wie im Bereich der KI-Website-Builder beobachtet, Geschwindigkeit auf Kosten der Anpassbarkeit priorisieren, zielen andere unabhängige Lösungen darauf ab, Nutzern mehr Kontrolle zu geben.

Diese Flexibilität ermöglicht eine tiefere Anpassung an domänenspezifische Anforderungen. Unternehmen können Modelle oder ganze Plattform-Setups für hochspezialisierte Aufgaben oder Branchen optimieren, was über die allgemeinen Fähigkeiten der oft auf breite Anwendbarkeit ausgelegten Modelle der Hyperscaler hinausgehen kann. Das Konzept der autarken souveränen KI zielt explizit auf hochspezialisierte, auf eigenen Daten trainierte Modelle ab. Die Möglichkeit, KI-Modelle branchenübergreifend zu übertragen und anzupassen, unterstreicht diese Flexibilität.

Ein weiterer Aspekt ist die Möglichkeit, gezielt nur die benötigten Komponenten auszuwählen und zu nutzen, anstatt potenziell überladene oder fest vorgegebene Service-Pakete großer Plattformen in Kauf nehmen zu müssen. Dies kann helfen, unnötige Komplexität und Kosten zu vermeiden. Umgekehrt muss jedoch berücksichtigt werden, dass Hyperscaler oft eine größere Bandbreite an sofort verfügbaren Standardfunktionen und Diensten bieten, was im Abschnitt zu den Herausforderungen (IX) näher beleuchtet wird.

Passend dazu:

- Künstliche Intelligenz transformiert Microsoft SharePoint mit Premium KI zu einer intelligenten Content-Management-Plattform

Nutzung von Open-Source-Modellen und -Technologien

Ein signifikanter Vorteil vieler unabhängiger Plattformen ist die erleichterte Nutzung einer breiten Palette von KI-Modellen, insbesondere führender Open-Source-Modelle wie Llama (Meta) oder Mistral. Dies steht im Kontrast zu Hyperscalern, die tendenziell ihre eigenen proprietären Modelle oder die Modelle enger Partner bevorzugen. Die freie Modellwahl ermöglicht es Organisationen, Entscheidungen basierend auf Kriterien wie Leistung, Kosten, Lizenzbedingungen oder spezifischer Eignung für die Aufgabe zu treffen. Localmind unterstützt beispielsweise explizit Llama und Mistral neben proprietären Optionen. Das europäische Projekt OpenGPT-X zielt darauf ab, leistungsfähige Open-Source-Alternativen wie Teuken-7B bereitzustellen, die speziell auf europäische Sprachen und Bedürfnisse zugeschnitten sind.

Open-Source-Modelle bieten zudem ein höheres Maß an Transparenz hinsichtlich ihrer Architektur und potenziell auch der Trainingsdaten (abhängig von der Qualität der Dokumentation, z.B. “Model Cards”). Diese Transparenz kann für Compliance-Zwecke, Debugging und das grundlegende Verständnis des Modellverhaltens entscheidend sein.

Aus Kostensicht können Open-Source-Modelle, insbesondere bei großvolumiger Nutzung, deutlich günstiger sein als die Abrechnung über proprietäre APIs. Der Vergleich zwischen DeepSeek-R1 (Open-Source-orientiert) und OpenAI o1 (proprietär) zeigt erhebliche Preisunterschiede pro verarbeitetem Token. Schließlich ermöglicht die Nutzung von Open Source das Partizipieren an den schnellen Innovationszyklen der globalen KI-Community.

Kontrolle über Infrastruktur und Modell-Deployment

Unabhängige Plattformen bieten oft eine größere Flexibilität bei der Wahl der Deployment-Umgebung. Optionen reichen von On-Premises über Private Clouds bis hin zu Multi-Cloud-Szenarien, bei denen Ressourcen verschiedener Anbieter genutzt werden. DeepSeek beispielsweise kann lokal in Docker-Containern betrieben werden, was die Datenkontrolle maximiert. Diese Wahlfreiheit gibt Unternehmen mehr Kontrolle über Aspekte wie Performance, Latenz, Kosten und Datensicherheit.

Dies geht Hand in Hand mit der Möglichkeit, die zugrundeliegende Hardware (z.B. spezifische GPUs, Speicherlösungen) und Softwarekonfigurationen (Betriebssysteme, Frameworks) gezielt für bestimmte Workloads zu optimieren. Anstatt auf die standardisierten Instanztypen und Preismodelle der Hyperscaler beschränkt zu sein, können Unternehmen potenziell effizientere oder kostengünstigere Setups realisieren.

Die Kontrolle über die Entwicklungsumgebung ermöglicht zudem tiefere Experimente und die nahtlose Integration von benutzerdefinierten Werkzeugen oder Bibliotheken, die für spezifische Forschungs- oder Entwicklungsaufgaben benötigt werden.

Die erweiterte Flexibilität und Kontrolle, die unabhängige Plattformen bieten, geht jedoch oft mit einer erhöhten Verantwortung und potenziell auch Komplexität einher. Während Hyperscaler viele Infrastrukturdetails durch Managed Services abstrahieren, erfordern unabhängige Plattformen, insbesondere bei On-Premises- oder stark individualisierten Deployments, möglicherweise mehr internes Fachwissen für Einrichtung, Konfiguration, Betrieb und Wartung. Der Vorteil der Flexibilität ist somit am größten für Organisationen, die über die notwendigen Fähigkeiten und den strategischen Willen verfügen, diese Kontrolle auch aktiv auszuüben. Fehlt dieses Know-how oder liegt der Fokus primär auf schneller Markteinführung mit Standardanwendungen, könnte die Einfachheit der gemanagten Hyperscaler-Dienste attraktiver sein. Die Entscheidung hängt also stark von den strategischen Prioritäten ab: maximale Kontrolle und Anpassbarkeit versus Benutzerfreundlichkeit und Breite der gemanagten Dienste. Dieser Kompromiss beeinflusst auch die Gesamtbetriebskosten (Abschnitt VIII) und die potenziellen Herausforderungen (Abschnitt IX).

Minderung des Vendor Lock-in: Strategische und Kostenauswirkungen

Die Abhängigkeit von einem einzelnen Technologieanbieter, bekannt als Vendor Lock-in, stellt ein erhebliches strategisches Risiko dar, insbesondere im dynamischen Feld der KI und Cloud-Technologien. Unabhängige KI-Plattformen werden oft als Mittel zur Minderung dieses Risikos positioniert.

Verständnis der Risiken der Hyperscaler-Abhängigkeit

Vendor Lock-in beschreibt eine Situation, in der der Wechsel von der Technologie oder den Dienstleistungen eines Anbieters zu einem anderen mit prohibitiv hohen Kosten oder technischer Komplexität verbunden ist. Diese Abhängigkeit verschafft dem Anbieter eine erhebliche Verhandlungsmacht gegenüber dem Kunden.

Die Ursachen für Lock-in sind vielfältig. Dazu gehören proprietäre Technologien, Schnittstellen (APIs) und Datenformate, die Inkompatibilität mit anderen Systemen erzeugen. Die tiefe Integration verschiedener Dienste innerhalb des Ökosystems eines Hyperscalers erschwert die Ablösung einzelner Komponenten. Hohe Kosten für den Datentransfer aus der Cloud (Egress Costs) wirken als finanzielle Barriere. Hinzu kommen Investitionen in spezifisches Wissen und Training der Mitarbeiter, das nicht ohne Weiteres auf andere Plattformen übertragbar ist, sowie langfristige Verträge oder Lizenzbedingungen. Je mehr Dienste eines Anbieters genutzt und je stärker diese miteinander verknüpft werden, desto komplexer wird ein potenzieller Wechsel.

Die strategischen Risiken einer solchen Abhängigkeit sind beträchtlich. Sie umfassen eine reduzierte Agilität und Flexibilität, da das Unternehmen an die Roadmap und die technologischen Entscheidungen des Anbieters gebunden ist. Die Fähigkeit, innovative oder kostengünstigere Lösungen von Wettbewerbern zu adaptieren, wird eingeschränkt, was die eigene Innovationsgeschwindigkeit verlangsamen kann. Unternehmen werden anfällig für Preiserhöhungen oder ungünstige Änderungen der Vertragsbedingungen, da ihre Verhandlungsposition geschwächt ist. Regulatorische Anforderungen, insbesondere im Finanzsektor, können sogar explizite Exit-Strategien vorschreiben, um die Risiken eines Lock-in zu managen.

Die Kostenimplikationen gehen über die regulären Betriebskosten hinaus. Ein Plattformwechsel (Replatforming) verursacht erhebliche Migrationskosten, die durch Lock-in-Effekte noch verstärkt werden. Dazu zählen Kosten für den Datentransfer, die potenzielle Neuentwicklung oder Anpassung von Funktionalitäten und Integrationen, die auf proprietären Technologien basierten, sowie umfassende Schulungen für Mitarbeiter. Indirekte Kosten durch Betriebsunterbrechungen während der Migration oder langfristige Ineffizienzen bei unzureichender Planung kommen hinzu. Auch potenzielle Kosten für den Ausstieg aus einer Cloud-Plattform müssen berücksichtigt werden.

Wie unabhängige Plattformen strategische Autonomie fördern

Unabhängige KI-Plattformen können auf verschiedene Weisen dazu beitragen, die strategische Autonomie zu wahren und Lock-in-Risiken zu reduzieren:

- Nutzung offener Standards: Plattformen, die auf offenen Standards basieren – beispielsweise standardisierte Containerformate (wie Docker), offene APIs oder die Unterstützung von Open-Source-Modellen und -Frameworks – verringern die Abhängigkeit von proprietären Technologien des Anbieters.

- Datenportabilität: Die Verwendung weniger proprietärer Datenformate oder die explizite Unterstützung des Datenexports in Standardformaten erleichtert die Migration von Daten zu anderen Systemen oder Anbietern. Standardisierte Datenformate sind hierbei ein Schlüsselelement.

- Infrastrukturflexibilität: Die Möglichkeit, die Plattform auf unterschiedlichen Infrastrukturen zu betreiben (On-Premises, Private Cloud, potenziell Multi-Cloud), reduziert naturgemäß die Bindung an die Infrastruktur eines einzelnen Anbieters. Containerisierung von Anwendungen wird hierbei als wichtige Technik genannt.

- Vermeidung von Ökosystem-Verschränkungen: Unabhängige Plattformen üben tendenziell weniger Druck aus, eine Vielzahl tief integrierter Dienste desselben Anbieters zu nutzen. Dies ermöglicht eine modularere Architektur und eine größere Wahlfreiheit bei einzelnen Komponenten. Das Konzept der souveränen KI zielt explizit auf die Unabhängigkeit von einzelnen Providern ab.

Langfristige Kostenvorteile durch Vermeidung von Lock-in

Die Vermeidung einer starken Anbieterabhängigkeit kann langfristig zu Kostenvorteilen führen:

- Bessere Verhandlungsposition: Die glaubhafte Möglichkeit, den Anbieter wechseln zu können, erhält den Wettbewerbsdruck aufrecht und stärkt die eigene Position bei Preis- und Vertragsverhandlungen. Einige Analysen legen nahe, dass mittelständische oder spezialisierte Anbieter mehr Verhandlungsspielraum bieten könnten als globale Hyperscaler.

- Optimierte Ausgaben: Die Freiheit, für jede Aufgabe die kosteneffektivsten Komponenten (Modelle, Infrastruktur, Tools) auswählen zu können, ermöglicht eine bessere Kostenoptimierung. Dies schließt die Nutzung potenziell günstigerer Open-Source-Optionen oder effizienterer, selbst gewählter Hardware ein.

- Reduzierte Migrationskosten: Wenn ein Wechsel notwendig oder wünschenswert wird, sind die finanziellen und technischen Hürden geringer, was die Adaption neuerer, besserer oder günstigerer Technologien erleichtert.

- Vorhersehbare Budgetierung: Die geringere Anfälligkeit für unerwartete Preiserhöhungen oder Gebührenänderungen eines Anbieters, an den man gebunden ist, ermöglicht eine stabilere Finanzplanung.

Es ist jedoch wichtig zu erkennen, dass Vendor Lock-in ein Spektrum darstellt und keine binäre Eigenschaft ist. Auch bei der Wahl eines unabhängigen Anbieters entsteht eine gewisse Abhängigkeit – von dessen spezifischen Plattformfunktionen, APIs, Supportqualität und letztlich seiner wirtschaftlichen Stabilität. Eine wirksame Strategie zur Minderung von Lock-in beinhaltet daher mehr als nur die Auswahl eines unabhängigen Anbieters. Sie erfordert eine bewusste Architektur, die auf offenen Standards, Containerisierung, Datenportabilität und potenziell Multi-Cloud-Ansätzen basiert. Unabhängige Plattformen können die Umsetzung solcher Strategien erleichtern, eliminieren das Risiko aber nicht automatisch vollständig. Das Ziel sollte eine gemanagte Abhängigkeit sein, bei der Flexibilität und Ausstiegsmöglichkeiten bewusst erhalten bleiben, anstatt einer Illusion von völliger Unabhängigkeit nachzujagen.

Passend dazu:

Neutralität bei der Modell- und Infrastrukturauswahl

Die Wahl der optimalen KI-Modelle und der zugrundeliegenden Infrastruktur ist entscheidend für die Leistungsfähigkeit und Wirtschaftlichkeit von KI-Anwendungen. Unabhängige Plattformen können hier eine größere Neutralität bieten als die eng integrierten Ökosysteme der Hyperscaler.

Vermeidung von Ökosystem-Bias: Zugang zu vielfältigen KI-Modellen

Hyperscaler haben naturgemäß ein Interesse daran, ihre eigenen KI-Modelle oder die Modelle enger strategischer Partner (wie Microsoft mit OpenAI oder Google mit Gemini) innerhalb ihrer Plattformen zu fördern und zu optimieren. Dies kann dazu führen, dass diese Modelle bevorzugt präsentiert, technisch besser integriert oder preislich attraktiver gestaltet werden als Alternativen.

Unabhängige Plattformen hingegen haben oft nicht den gleichen Anreiz, ein bestimmtes Basismodell zu favorisieren. Sie können daher einen neutraleren Zugang zu einer breiteren Palette von Modellen ermöglichen, einschließlich führender Open-Source-Optionen. Dies erlaubt Unternehmen, die Modellauswahl stärker an objektiven Kriterien wie Leistung für die spezifische Aufgabe, Kosten, Transparenz oder Lizenzbedingungen auszurichten. Plattformen wie Localmind demonstrieren dies, indem sie explizit Unterstützung für Open-Source-Modelle wie Llama und Mistral neben proprietären Modellen wie ChatGPT, Claude und Gemini anbieten. Initiativen wie OpenGPT-X in Europa konzentrieren sich sogar darauf, wettbewerbsfähige europäische Open-Source-Alternativen zu schaffen.

Objektive Infrastrukturentscheidungen

Die Neutralität erstreckt sich oft auch auf die Wahl der Infrastruktur:

- Hardware-Agnostizismus: Unabhängige Plattformen, die On-Premises oder in Private Clouds betrieben werden, ermöglichen es Unternehmen, die Hardware (CPUs, GPUs, spezialisierte Prozessoren, Speicher) basierend auf eigenen Benchmarks und Kosten-Nutzen-Analysen auszuwählen. Sie sind nicht auf die vorgegebenen Instanztypen, Konfigurationen und Preisstrukturen eines einzelnen Hyperscalers beschränkt. Anbieter wie Pure Storage betonen die Bedeutung einer optimierten Storage-Infrastruktur speziell für KI-Workloads.

- Optimierter Technologie-Stack: Es besteht die Möglichkeit, einen Infrastruktur-Stack (Hardware, Netzwerk, Storage, Software-Frameworks) zu konzipieren, der präzise auf die spezifischen Anforderungen der KI-Workloads zugeschnitten ist. Dies kann potenziell zu besserer Leistung oder höherer Kosteneffizienz führen als die Nutzung standardisierter Cloud-Bausteine.

- Vermeidung gebündelter Abhängigkeiten: Der Druck, spezifische Daten-, Netzwerk- oder Sicherheitsdienste des Plattformanbieters nutzen zu müssen, ist tendenziell geringer. Dies erlaubt eine objektivere Auswahl von Komponenten basierend auf technischen Erfordernissen und Leistungsmerkmalen.

Die wahre Optimierung von KI-Anwendungen erfordert die bestmögliche Abstimmung von Modell, Daten, Werkzeugen und Infrastruktur für die jeweilige Aufgabe. Der inhärente Ökosystem-Bias in den eng integrierten Plattformen der Hyperscaler kann Entscheidungen subtil in Richtung von Lösungen lenken, die zwar bequem sind, aber möglicherweise nicht die technisch oder wirtschaftlich optimale Wahl darstellen, sondern primär dem Stack des Anbieters zugutekommen. Unabhängige Plattformen können durch ihre größere Neutralität Unternehmen befähigen, objektivere, stärker leistungsorientierte und potenziell kosteneffizientere Entscheidungen über den gesamten KI-Lebenszyklus hinweg zu treffen. Diese Neutralität ist nicht nur ein philosophisches Prinzip, sondern hat praktische Konsequenzen. Sie eröffnet die Möglichkeit, beispielsweise ein leistungsfähiges Open-Source-Modell mit maßgeschneiderter On-Premises-Hardware oder einem spezifischen Private-Cloud-Setup zu kombinieren – eine Konstellation, die innerhalb der “walled gardens” eines Hyperscalers möglicherweise schwierig zu realisieren oder nicht gefördert wird. Dieses Potenzial zur objektiven Optimierung stellt einen wesentlichen strategischen Vorteil der Neutralität dar.

Passend dazu:

Nahtlose Integration in das Unternehmensökosystem

Der Wert von KI-Anwendungen im Unternehmenskontext entfaltet sich oft erst durch die Integration mit bestehenden IT-Systemen und Datenquellen. Unabhängige KI-Plattformen müssen daher robuste und flexible Integrationsfähigkeiten bieten, um eine praktikable Alternative zu den Ökosystemen der Hyperscaler darzustellen.

Anbindung an bestehende IT-Systeme (ERP, CRM etc.)

Die Integration mit Kernsystemen des Unternehmens, wie Enterprise Resource Planning (ERP)-Systemen (z.B. SAP) und Customer Relationship Management (CRM)-Systemen (z.B. Salesforce), ist von entscheidender Bedeutung. Nur so können relevante Unternehmensdaten für das Training und die Anwendung von KI genutzt und die gewonnenen Erkenntnisse oder Automatisierungen direkt in die Geschäftsprozesse zurückgespielt werden. KI kann beispielsweise genutzt werden, um Nachfrageprognosen zu verbessern, die direkt in die ERP-Planung einfließen, oder um Kundendaten im CRM anzureichern.

Unabhängige Plattformen adressieren diese Notwendigkeit typischerweise durch verschiedene Mechanismen:

- APIs (Application Programming Interfaces): Die Bereitstellung gut dokumentierter, standardbasierter APIs (z.B. REST) ist fundamental, um die Kommunikation mit anderen Systemen zu ermöglichen.

- Konnektoren: Vorgefertigte Konnektoren zu weit verbreiteten Unternehmensanwendungen wie SAP, Salesforce, Microsoft Dynamics oder Microsoft 365 können den Integrationsaufwand erheblich reduzieren. Anbieter wie SEEBURGER oder Jitterbit spezialisieren sich auf Integrationslösungen und bieten zertifizierte SAP-Konnektoren an, die eine tiefe Integration ermöglichen. SAP selbst bietet ebenfalls eine eigene Integrationsplattform (SAP Integration Suite, ehemals CPI) an, die Konnektoren zu verschiedenen Systemen bereitstellt.

- Middleware/iPaaS-Kompatibilität: Die Fähigkeit, mit bestehenden unternehmensweiten Middleware-Lösungen oder Integration Platform as a Service (iPaaS)-Angeboten zusammenzuarbeiten, ist wichtig für Unternehmen mit etablierten Integrationsstrategien.

- Bidirektionale Synchronisation: Für viele Anwendungsfälle ist es entscheidend, dass Daten nicht nur aus den Quellsystemen gelesen, sondern auch dorthin zurückgeschrieben werden können (z.B. Aktualisierung von Kundenkontakten oder Bestellstatus).

Anbindung an diverse Datenquellen

KI-Modelle benötigen Zugriff auf relevante Daten, die oft in einer Vielzahl von Systemen und Formaten im Unternehmen verteilt sind: relationale Datenbanken, Data Warehouses, Data Lakes, Cloud-Speicher, operative Systeme, aber auch unstrukturierte Quellen wie Dokumente oder Bilder. Unabhängige KI-Plattformen müssen daher in der Lage sein, sich mit diesen heterogenen Datenquellen zu verbinden und Daten unterschiedlicher Art zu verarbeiten. Plattformen wie Localmind heben hervor, dass sie unstrukturierte Texte, komplexe Dokumente mit Bildern und Diagrammen sowie Bilder und Videos verarbeiten können. SAPs angekündigte Business Data Cloud zielt ebenfalls darauf ab, den Zugriff auf Unternehmensdaten unabhängig von Format oder Speicherort zu vereinheitlichen.

Kompatibilität mit Entwicklungs- und Analysewerkzeugen

Für die Produktivität von Data-Science- und Entwicklungsteams ist die Kompatibilität mit gängigen Werkzeugen und Frameworks essenziell. Dazu gehört die Unterstützung verbreiteter KI/ML-Frameworks wie TensorFlow oder PyTorch, Programmiersprachen wie Python oder Java und Entwicklungsumgebungen wie Jupyter Notebooks.

Ebenso wichtig ist die Integration mit Business-Intelligence-(BI)- und Analysewerkzeugen. Die Ergebnisse von KI-Modellen müssen oft in Dashboards visualisiert oder für Berichte aufbereitet werden. Umgekehrt können BI-Tools Daten für die KI-Analyse bereitstellen. Die Unterstützung offener Standards erleichtert generell die Anbindung an eine breitere Palette von Drittanbieter-Werkzeugen.

Während Hyperscaler von der nahtlosen Integration innerhalb ihrer eigenen, umfangreichen Ökosysteme profitieren, müssen unabhängige Plattformen ihre Stärke in der flexiblen Anbindung an die bestehende, heterogene Unternehmenslandschaft beweisen. Ihr Erfolg hängt maßgeblich davon ab, ob sie sich mindestens genauso effektiv, idealerweise aber flexibler, in etablierte Systeme wie SAP und Salesforce integrieren lassen als die Angebote der Hyperscaler. Die “Unabhängigkeit” einer Plattform könnte sich sonst als Nachteil erweisen, wenn sie zu Integrationshürden führt. Führende unabhängige Anbieter müssen daher Exzellenz in der Interoperabilität demonstrieren, starke APIs, Konnektoren und möglicherweise Partnerschaften mit Integrationsspezialisten anbieten. Ihre Fähigkeit zur reibungslosen Integration in komplexe, gewachsene Umgebungen ist ein kritischer Erfolgsfaktor und kann in heterogenen Landschaften sogar einen Vorteil gegenüber einem Hyperscaler darstellen, der primär auf die Integration innerhalb seines eigenen Stacks fokussiert ist.

🎯📊 Integration einer unabhängigen und Datenquellen-übergreifenden KI-Plattform 🤖🌐 für alle Unternehmensbelange

Integration einer unabhängigen und Datenquellen-übergreifenden KI-Plattform für alle Unternehmensbelange - Bild: Xpert.Digital

KI-Gamechanger: Die flexibelste KI-Plattform - Maßgeschneiderte Lösungen, die Kosten senken, Ihre Entscheidungen verbessern und die Effizienz steigern

Unabhängige KI-Plattform: Integriert alle relevanten Unternehmensdatenquellen

- Diese KI-Plattform interagiert mit allen spezifischen Datenquellen

- Von SAP, Microsoft, Jira, Confluence, Salesforce, Zoom, Dropbox und vielen andere Daten-Management-Systmen

- Schnelle KI-Integration: Maßgeschneiderte KI-Lösungen für Unternehmen in Stunden oder Tagen, anstatt Monaten

- Flexible Infrastruktur: Cloud-basiert oder Hosting im eigenen Rechenzentrum (Deutschland, Europa, freie Standortwahl)

- Höchste Datensicherheit: Einsatz in Anwaltskanzleien ist der sichere Beweis

- Einsatz über die unterschiedlichsten Unternehmensdatenquellen hinweg

- Wahl der eigenen bzw. verschiedenen KI-Modelle (DE,EU,USA,CN)

Herausforderungen, die unsere KI-Plattform löst

- Mangelnde Passgenauigkeit herkömmlicher KI-Lösungen

- Datenschutz und sichere Verwaltung sensibler Daten

- Hohe Kosten und Komplexität individueller KI-Entwicklung

- Mangel an qualifizierten KI-Fachkräften

- Integration von KI in bestehende IT-Systeme

Mehr dazu hier:

Umfassender Kostenvergleich für KI-Plattformen: Hyperscaler vs. Unabhängige Lösungen

Vergleichende Kostenanalyse: Eine TCO-Perspektive

Die Kosten sind ein entscheidender Faktor bei der Wahl einer KI-Plattform. Eine reine Betrachtung der Listenpreise greift jedoch zu kurz. Eine umfassende Analyse der Gesamtbetriebskosten (Total Cost of Ownership, TCO) über den gesamten Lebenszyklus ist notwendig, um die wirtschaftlichste Option für den spezifischen Anwendungsfall zu ermitteln.

Passend dazu:

Kostenstrukturen unabhängiger Plattformen (Entwicklung, Betrieb, Wartung)

Die Kostenstruktur unabhängiger Plattformen kann stark variieren, abhängig vom Anbieter und dem Deployment-Modell:

- Software-Lizenzkosten: Diese können potenziell niedriger sein als bei proprietären Hyperscaler-Diensten, insbesondere wenn die Plattform stark auf Open-Source-Modellen oder -Komponenten basiert. Einige Anbieter, wie Scale Computing im HCI-Bereich, positionieren sich damit, Lizenzkosten alternativer Anbieter (z.B. VMware) zu eliminieren.

- Infrastrukturkosten: Bei On-Premises- oder Private-Cloud-Deployments fallen Investitionskosten (CapEx) oder Leasing-Raten (OpEx) für Server, Speicher, Netzwerkkomponenten und Rechenzentrumskapazitäten (Raum, Strom, Kühlung) an. Die Kühlung allein kann einen erheblichen Anteil des Stromverbrauchs ausmachen. Bei gehosteten unabhängigen Plattformen fallen typischerweise Subskriptionsgebühren an, die Infrastrukturkosten beinhalten.

- Betriebskosten: Laufende Kosten umfassen Strom, Kühlung, Wartung der Hardware und Software. Hinzu kommen potenziell höhere interne Personalkosten für Management, Überwachung und spezialisiertes Know-how im Vergleich zu vollständig gemanagten Hyperscaler-Diensten. Diese operativen Kosten werden oft bei TCO-Berechnungen übersehen.

- Entwicklungs- und Integrationskosten: Die initiale Einrichtung, die Integration in bestehende Systeme und eventuell notwendige Anpassungen können signifikanten Aufwand und damit Kosten verursachen.

- Skalierbarkeitskosten: Die Erweiterung der Kapazität erfordert bei On-Premises-Lösungen oft den Kauf zusätzlicher Hardware (Nodes, Server). Diese Kosten sind zwar planbar, erfordern aber Vorabinvestitionen oder flexible Leasing-Modelle.

Benchmarking anhand der Preismodelle von Hyperscalern

Hyperscaler-Plattformen zeichnen sich typischerweise durch ein OpEx-dominiertes Modell aus:

- Pay-as-you-go: Kosten fallen primär für die tatsächliche Nutzung von Rechenzeit (CPU/GPU), Speicherplatz, Datenübertragung und API-Aufrufen an. Dies bietet hohe Elastizität, kann aber bei unzureichendem Management zu unvorhersehbaren und hohen Kosten führen.

- Potenzielle versteckte Kosten: Insbesondere die Kosten für den Datenabfluss aus der Cloud (Egress Fees) können erheblich sein und den Wechsel zu einem anderen Anbieter erschweren, was zum Lock-in beiträgt. Premium-Support, spezialisierte oder hochperformante Instanztypen und erweiterte Sicherheits- oder Management-Features verursachen oft zusätzliche Kosten. Das Risiko von Überausgaben ist real, wenn die Ressourcennutzung nicht kontinuierlich überwacht und optimiert wird.

- Komplexe Preisgestaltung: Die Preismodelle der Hyperscaler sind oft sehr komplex mit einer Vielzahl von Service-Tiers, Optionen für reservierte oder Spot-Instanzen und unterschiedlichen Abrechnungseinheiten. Dies erschwert eine genaue TCO-Kalkulation.

- Kosten für Modell-APIs: Die Nutzung proprietärer Basismodelle über API-Calls kann bei hohem Volumen sehr kostspielig werden. Vergleiche zeigen, dass Open-Source-Alternativen pro verarbeitetem Token signifikant günstiger sein können.

Bewertung der Kosten für Eigenentwicklungen

Der Aufbau einer eigenen KI-Plattform ist in der Regel mit den höchsten Anfangsinvestitionen verbunden. Dies umfasst Kosten für Forschung und Entwicklung, die Akquise hochspezialisierter Talente und den Aufbau der notwendigen Infrastruktur. Hinzu kommen erhebliche laufende Kosten für Wartung, Updates, Sicherheitspatches und die Bindung des Personals. Nicht zu unterschätzen sind auch die Opportunitätskosten: Ressourcen, die in den Plattformbau fließen, stehen nicht für andere wertschöpfende Aktivitäten zur Verfügung. Zudem ist die Zeit bis zur Einsatzfähigkeit (Time-to-Market) meist deutlich länger als bei der Nutzung bestehender Plattformen.

Es gibt keine universell günstigste Option. Die TCO-Berechnung ist stark kontextabhängig. Hyperscaler bieten oft niedrigere Einstiegskosten und eine unübertroffene Elastizität, was sie für Start-ups, Pilotprojekte oder Anwendungen mit stark schwankender Last attraktiv macht. Unabhängige oder private Plattformen können jedoch bei planbaren, großvolumigen Workloads langfristig eine niedrigere TCO aufweisen. Dies gilt insbesondere, wenn man Faktoren wie hohe Daten-Egress-Kosten bei Hyperscalern, Kosten für Premium-Dienste, die potenziellen Kostenvorteile von Open-Source-Modellen oder die Möglichkeit zur Nutzung optimierter, eigener Hardware berücksichtigt. Studien deuten darauf hin, dass die TCO für Public und Private Clouds bei gleicher Kapazität theoretisch ähnlich sein können; die tatsächlichen Kosten hängen jedoch stark von der Auslastung, dem Management und den spezifischen Preismodellen ab. Eine gründliche TCO-Analyse, die alle direkten und indirekten Kosten über den geplanten Nutzungszeitraum (z.B. 3-5 Jahre) umfasst – einschließlich Infrastruktur, Lizenzen, Personal, Training, Migration, Compliance-Aufwand und potenzieller Ausstiegskosten – ist unerlässlich für eine fundierte Entscheidung.

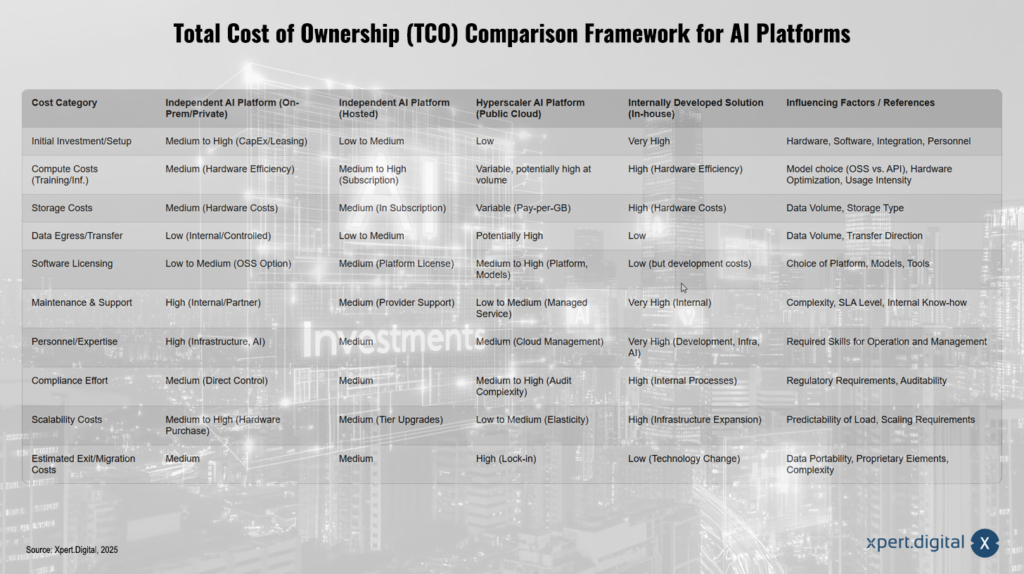

Gesamtbetriebskosten-Vergleichsrahmen für KI-Plattformen

Diese Tabelle bietet einen qualitativen Rahmen zur Bewertung der Kostenprofile. Die tatsächlichen Zahlen hängen stark vom spezifischen Szenario ab, aber die Muster verdeutlichen die unterschiedlichen finanziellen Implikationen und Risiken der jeweiligen Plattformtypen.

Ein Gesamtbetriebskosten-Vergleichsrahmen für KI-Plattformen zeigt die unterschiedlichen Kostenkategorien und Einflussfaktoren auf, die bei der Auswahl einer Plattform zu berücksichtigen sind. Die initiale Investition ist bei unabhängigen On-Premise- oder privaten Plattformen mittel bis hoch, während sie bei gehosteten Plattformen oder Hyperscaler-basierten Lösungen gering bis variabel sein kann. Intern entwickelte Lösungen bringen jedoch sehr hohe Anfangskosten mit sich. Bei Compute-Kosten, die das Training und die Inferenz betreffen, variieren die Ausgaben je nach Plattform. Bei unabhängigen Plattformen sind diese mittel, bei gehosteten Lösungen und Public-Cloud-Optionen können sie mittelhoch bis potenziell hoch ausfallen – insbesondere bei großem Volumen. Intern entwickelte Lösungen sind ebenfalls kostenintensiv.

Speicherkosten sind bei unabhängigen Plattformen sowie gehosteten Optionen mittel, allerdings in der Public Cloud oft variabel und zahlen sich pro genutztem Gigabyte aus. Intern entwickelte Lösungen weisen hohe Speicherkosten auf. In Bezug auf den Daten-Egress oder den Transfer liegen die Kosten bei unabhängigen Plattformen und internen Lösungen niedrig, können jedoch in einer Public-Cloud-Umgebung bei hohem Datenvolumen deutlich ansteigen.

Die Software-Lizenzierung zeigt ebenfalls Unterschiede: Während Open-Source-Optionen die Ausgaben bei unabhängigen Plattformen niedrig bis mittel halten, steigen diese bei gehosteten oder Public-Cloud-Lösungen, besonders wenn plattformspezifische oder API-Modelle genutzt werden. Gleichzeitig fallen bei intern entwickelten Lösungen geringere Ausgaben an, dafür jedoch höhere Entwicklungskosten. Ähnliches trifft auf Wartung und Support zu – hier sind interne Lösungen und unabhängige Plattformen besonders kostenintensiv, wohingegen Managed Services von Hyperscalern geringere Ausgaben mit sich bringen.

Das benötigte Personal und dessen Expertise ist ein bedeutender Faktor bei den Betriebskosten. Unabhängige Plattformen und intern entwickelte Lösungen erfordern hohe Kompetenz in Infrastruktur und KI, während dies bei gehosteten und Public-Cloud-Optionen moderater ist. Der Compliance-Aufwand variiert je nach Plattform in Abhängigkeit von regulatorischen Anforderungen und Audit-Komplexität. Skalierbarkeitskosten hingegen zeigen bei Public-Cloud-Lösungen klare Vorteile, da sie elastisch anpassbar sind, während sie bei internen und On-Prem-Lösungen aufgrund von Hardware- und Infrastrukturausbau höher ausfallen.

Auch die Exit- und Migrationskosten spielen eine Rolle, gerade bei Public-Cloud-Plattformen, wo ein gewisses Lock-in-Risiko besteht und diese hoch ausfallen können, wohingegen unabhängige Plattformen und intern entwickelte Lösungen in diesem Bereich eher moderate bis niedrige Kosten mit sich bringen. Letztendlich verdeutlichen die genannten Kategorien die finanziellen Implikationen und Risiken, die bei der Wahl einer Plattform zu bedenken sind. Der qualitative Rahmen dient zur Orientierung; die tatsächlichen Kosten variieren jedoch je nach spezifischem Anwendungsfall.

Unabhängige KI-Plattformen bieten viele Vorteile, aber auch Herausforderungen, die berücksichtigt werden müssen. Eine realistische Einschätzung solcher Plattformen erfordert daher einen ausgewogenen Blick, der sowohl die positiven Aspekte als auch mögliche Hürden miteinbezieht.

Adressierung der Herausforderungen unabhängiger Plattformen

Obwohl unabhängige KI-Plattformen attraktive Vorteile bieten, sind sie nicht ohne potenzielle Herausforderungen. Eine ausgewogene Betrachtung muss auch diese Nachteile oder Hürden berücksichtigen, um eine realistische Einschätzung vornehmen zu können.

Support, Community und Ökosystem-Reife

Die Qualität und Verfügbarkeit des Supports können bei unabhängigen Anbietern variieren und erreichen möglicherweise nicht immer das Niveau der globalen Support-Organisationen der Hyperscaler. Insbesondere bei kleineren oder neueren Anbietern könnten Reaktionszeiten oder die Tiefe des technischen Know-hows für komplexe Probleme eine Herausforderung darstellen. Selbst große Organisationen können bei der Einführung neuer KI-Support-Systeme auf anfängliche Einschränkungen stoßen, etwa bei der Sprachunterstützung oder dem Umfang der bearbeitbaren Anfragen.

Die Größe der Community rund um eine spezifische unabhängige Plattform ist oft kleiner als die riesigen Entwickler- und Nutzergemeinschaften, die sich um die Dienste von AWS, Azure oder GCP gebildet haben. Während Open-Source-Komponenten, die von der Plattform genutzt werden, möglicherweise große und aktive Communities haben, kann die spezifische Plattform-Community kleiner sein. Dies kann die Verfügbarkeit von Drittanbieter-Tools, vorgefertigten Integrationen, Tutorials und dem allgemeinen Wissensaustausch beeinflussen. Es ist jedoch anzumerken, dass kleinere, fokussierte Communities oft sehr engagiert und hilfreich sein können.

Das umgebende Ökosystem – einschließlich Marktplätzen für Erweiterungen, zertifizierten Partnern und verfügbaren Fachkräften mit Plattformkenntnissen – ist bei Hyperscalern in der Regel deutlich breiter und tiefer ausgebaut. Open-Source-Projekte, auf die unabhängige Plattformen möglicherweise setzen, sind zudem von der Aktivität der Community abhängig und bieten keine Garantie für langfristige Kontinuität.

Breite und Tiefe der Funktionen im Vergleich zu Hyperscalern

Unabhängige Plattformen bieten möglicherweise nicht die schiere Anzahl an sofort verfügbaren, vorgefertigten KI-Diensten, spezialisierten Modellen oder ergänzenden Cloud-Tools, die auf den großen Hyperscaler-Plattformen zu finden sind. Ihr Fokus liegt oft auf Kernfunktionalitäten der KI-Entwicklung und -Bereitstellung oder auf spezifischen Nischen.

Hyperscaler investieren massiv in Forschung und Entwicklung und sind oft die ersten, die neuartige, gemanagte KI-Dienste auf den Markt bringen. Unabhängige Plattformen könnten bei der Bereitstellung der absolut neuesten, hochspezialisierten Managed Services einen gewissen Zeitverzug aufweisen. Dies wird jedoch teilweise dadurch kompensiert, dass sie oft flexibler bei der Integration neuester Open-Source-Entwicklungen sind. Es ist auch möglich, dass bestimmte Nischenfunktionen oder Länderabdeckungen bei unabhängigen Anbietern (noch) nicht verfügbar sind.

Potenzielle Implementierungs- und Managementkomplexität

Die Einrichtung und Konfiguration unabhängiger Plattformen, insbesondere bei On-Premises- oder Private-Cloud-Deployments, kann technisch anspruchsvoller sein und mehr initialen Aufwand erfordern als die Nutzung der oft stark abstrahierten und vorkonfigurierten Managed Services der Hyperscaler. Mangelnde Expertise oder fehlerhafte Implementierung können hier Risiken bergen.

Der laufende Betrieb erfordert zudem interne Ressourcen oder einen kompetenten Partner für das Management der Infrastruktur, die Durchführung von Updates, die Gewährleistung der Sicherheit und die Überwachung des Betriebs. Dies steht im Gegensatz zu vollständig gemanagten PaaS- oder SaaS-Angeboten, bei denen der Anbieter diese Aufgaben übernimmt. Die Verwaltung komplexer, möglicherweise auf Microservices basierender KI-Architekturen erfordert entsprechendes Know-how.

Obwohl, wie in Abschnitt VII dargelegt, starke Integrationsfähigkeiten möglich sind, birgt die Sicherstellung eines reibungslosen Zusammenspiels in einer heterogenen IT-Landschaft immer eine gewisse Komplexität und potenzielle Fehlerquellen. Fehlerhafte Konfigurationen oder eine unzureichende Systeminfrastruktur können die Zuverlässigkeit beeinträchtigen.

Die Nutzung unabhängiger Plattformen kann daher einen höheren Bedarf an spezialisierten internen Fähigkeiten (KI-Experten, Infrastruktur-Management) mit sich bringen, als wenn man sich auf die Managed Services der Hyperscaler verlässt.

Weitere Überlegungen

- Anbieter-Viabilität: Bei der Auswahl eines unabhängigen Anbieters, insbesondere eines kleineren oder neueren, ist eine sorgfältige Prüfung seiner langfristigen wirtschaftlichen Stabilität, seiner Produkt-Roadmap und seiner Zukunftsperspektiven wichtig.

- Ethische Risiken und Bias: Unabhängige Plattformen sind, wie alle KI-Systeme, nicht immun gegen Risiken wie algorithmischen Bias (wenn Modelle auf verzerrten Daten trainiert wurden), mangelnde Erklärbarkeit (insbesondere bei Deep-Learning-Modellen – das “Black-Box”-Problem) oder das Potenzial für Missbrauch. Auch wenn sie potenziell mehr Transparenz bieten, müssen diese allgemeinen KI-Risiken bei der Plattformwahl und Implementierung berücksichtigt werden.

Es ist entscheidend zu verstehen, dass die “Herausforderungen” unabhängiger Plattformen oft die Kehrseite ihrer “Vorteile” sind. Die Notwendigkeit für mehr internes Know-how (IX.C) ist direkt mit der gewonnenen Kontrolle und Anpassbarkeit (IV.C) verbunden. Ein potenziell schmaleres initiales Feature-Set (IX.B) kann einer fokussierteren, weniger überladenen Plattform entsprechen (IV.A). Die Bewertung dieser Herausforderungen muss daher immer im Kontext der strategischen Prioritäten, der Risikobereitschaft und der internen Fähigkeiten der Organisation erfolgen. Ein Unternehmen, für das maximale Kontrolle und Anpassung oberste Priorität haben, wird die Notwendigkeit für internes Fachwissen möglicherweise als notwendige Investition und nicht als Nachteil betrachten. Die Entscheidung für eine Plattform ist somit keine Suche nach einer Lösung ohne Nachteile, sondern die Auswahl der Plattform, deren spezifische Herausforderungen angesichts der eigenen Ziele und Ressourcen akzeptabel oder beherrschbar sind und deren Vorteile am besten mit der Unternehmensstrategie übereinstimmen.

Passend dazu:

- Top Ten KI-Wettbewerber und Drittanbieter-Lösungen als Alternativen zu Microsoft SharePoint Premium – Künstliche Intelligenz

Strategische Empfehlungen

Die Wahl der richtigen KI-Plattform ist eine strategische Weichenstellung. Basierend auf der Analyse der verschiedenen Plattformtypen – unabhängige Plattformen, Hyperscaler-Angebote und Eigenentwicklungen – lassen sich Entscheidungskriterien und Empfehlungen ableiten, insbesondere für Unternehmen im europäischen Kontext.

Entscheidungsrahmen: Wann eine unabhängige KI-Plattform wählen?

Die Entscheidung für eine unabhängige KI-Plattform ist besonders dann zu erwägen, wenn folgende Faktoren eine hohe Priorität haben:

- Datensouveränität und Compliance: Wenn die Einhaltung der DSGVO, des EU AI Acts oder branchenspezifischer Vorschriften höchste Priorität hat und maximale Kontrolle über Datenlokalisierung, -verarbeitung und Transparenz erforderlich ist (siehe Abschnitt III).

- Vermeidung von Vendor Lock-in: Wenn die strategische Unabhängigkeit von den großen Hyperscalern ein zentrales Ziel ist, um Flexibilität zu wahren und langfristige Kostenrisiken zu minimieren (siehe Abschnitt V).

- Hoher Anpassungsbedarf: Wenn ein hohes Maß an Individualisierung der Plattform, der Modelle oder der Infrastruktur für spezifische Anwendungsfälle oder zur Optimierung benötigt wird (siehe Abschnitt IV).

- Präferenz für Open Source: Wenn spezifische Open-Source-Modelle oder -Technologien aus Kosten-, Transparenz-, Leistungs- oder Lizenzgründen bevorzugt werden (siehe Abschnitt IV.B).

- Optimierte TCO bei planbaren Lasten: Wenn langfristige Gesamtbetriebskosten für stabile, großvolumige Workloads im Vordergrund stehen und Analysen ergeben, dass ein unabhängiger Ansatz (On-Prem/Private) günstiger ist als eine dauerhafte Hyperscaler-Nutzung (siehe Abschnitt VIII).

- Flexible Integration in heterogene Landschaften: Wenn die nahtlose Integration in eine komplexe, bestehende IT-Landschaft mit Systemen verschiedener Anbieter spezifische Flexibilität erfordert (siehe Abschnitt VII).

- Neutralität bei Komponentenwahl: Wenn die objektive Auswahl der besten Modelle und Infrastrukturkomponenten, frei von Ökosystem-Bias, für die Leistungs- und Kostenoptimierung entscheidend ist (siehe Abschnitt VI).

Zurückhaltung bei der Wahl einer unabhängigen Plattform ist geboten, wenn:

- Umfassende Managed Services benötigt werden und internes Know-how für KI oder Infrastrukturmanagement begrenzt ist.

- Die sofortige Verfügbarkeit der absolut breitesten Palette an vorgefertigten KI-Diensten entscheidend ist.

- Die Minimierung der initialen Kosten und maximale Elastizität für stark variable oder unvorhersehbare Workloads Priorität haben.

- Erhebliche Bedenken hinsichtlich der wirtschaftlichen Stabilität, der Supportqualität oder der Community-Größe eines spezifischen unabhängigen Anbieters bestehen.

Schlüsselerwägungen für europäische Unternehmen

Für Unternehmen in Europa ergeben sich spezifische Handlungsempfehlungen:

- Regulatorisches Umfeld priorisieren: Die Anforderungen der DSGVO, des EU AI Acts und potenzieller nationaler oder sektoraler Vorschriften müssen im Mittelpunkt der Plattformbewertung stehen. Datensouveränität sollte ein primärer Entscheidungsfaktor sein. Es sollte nach Plattformen gesucht werden, die klare und nachweisbare Compliance-Pfade bieten.

- Europäische Initiativen und Anbieter prüfen: Initiativen wie Gaia-X oder OpenGPT-X sowie Anbieter, die sich explizit auf den europäischen Markt und dessen Bedürfnisse konzentrieren (z.B. einige der in genannten oder ähnliche), sollten evaluiert werden. Sie könnten eine bessere Übereinstimmung mit lokalen Anforderungen und Werten bieten.

- Verfügbarkeit von Fachkräften bewerten: Die Verfügbarkeit von Personal mit den notwendigen Fähigkeiten zur Verwaltung und Nutzung der gewählten Plattform muss realistisch eingeschätzt werden.

- Strategische Partnerschaften eingehen: Die Zusammenarbeit mit unabhängigen Anbietern, Systemintegratoren oder Beratungsunternehmen, die den europäischen Kontext verstehen und Erfahrung mit den relevanten Technologien und Regularien haben, kann erfolgskritisch sein.

Europas KI-Plattformen: Strategische Autonomie durch souveräne Technologien

Die Landschaft der KI-Plattformen entwickelt sich rasant weiter. Folgende Trends zeichnen sich ab:

- Zunahme souveräner und hybrider Lösungen: Die Nachfrage nach Plattformen, die Datensouveränität gewährleisten und flexible Hybrid-Cloud-Modelle ermöglichen (Kombination von On-Premises/Private-Cloud-Kontrolle mit Public-Cloud-Flexibilität), wird voraussichtlich weiter steigen.

- Wachsende Bedeutung von Open Source: Open-Source-Modelle und -Plattformen werden eine immer wichtigere Rolle spielen. Sie treiben Innovationen voran, fördern die Transparenz und bieten Alternativen zur Reduzierung von Vendor Lock-in.

- Fokus auf verantwortungsvolle KI: Aspekte wie Compliance, Ethik, Transparenz, Fairness und die Minderung von Bias werden zu entscheidenden Differenzierungsmerkmalen für KI-Plattformen und -Anwendungen.

- Integration bleibt entscheidend: Die Fähigkeit zur nahtlosen Integration von KI in bestehende Unternehmensprozesse und -systeme wird eine Grundvoraussetzung für die Realisierung des vollen Geschäftswerts bleiben.

Zusammenfassend lässt sich feststellen: Unabhängige KI-Plattformen stellen eine überzeugende Alternative für europäische Unternehmen dar, die vor strengen regulatorischen Anforderungen stehen und strategische Autonomie anstreben. Ihre Stärken liegen insbesondere in der verbesserten Datenkontrolle, der höheren Flexibilität und Anpassbarkeit sowie der Minderung von Vendor Lock-in-Risiken. Auch wenn Herausforderungen hinsichtlich der Ökosystemreife, der initialen Funktionsbreite und der Managementkomplexität bestehen können, machen ihre Vorteile sie zu einer essenziellen Option im Entscheidungsprozess für die richtige KI-Infrastruktur. Eine sorgfältige Abwägung der spezifischen Unternehmensanforderungen, der internen Fähigkeiten und eine detaillierte TCO-Analyse sind unerlässlich, um die strategisch und wirtschaftlich optimale Wahl zu treffen.

Wir sind für Sie da - Beratung - Planung - Umsetzung - Projektmanagement

☑️ KMU Support in der Strategie, Beratung, Planung und Umsetzung

☑️ Erstellung oder Neuausrichtung der KI-Strategie

☑️ Pioneer Business Development

Gerne stehe ich Ihnen als persönlicher Berater zur Verfügung.

Sie können mit mir Kontakt aufnehmen, indem Sie unten das Kontaktformular ausfüllen oder rufen Sie mich einfach unter +49 89 89 674 804 (München) an.

Ich freue mich auf unser gemeinsames Projekt.

Xpert.Digital - Konrad Wolfenstein

Xpert.Digital ist ein Hub für die Industrie mit den Schwerpunkten, Digitalisierung, Maschinenbau, Logistik/Intralogistik und Photovoltaik.

Mit unserer 360° Business Development Lösung unterstützen wir namhafte Unternehmen vom New Business bis After Sales.

Market Intelligence, Smarketing, Marketing Automation, Content Development, PR, Mail Campaigns, Personalized Social Media und Lead Nurturing sind ein Teil unserer digitalen Werkzeuge.

Mehr finden Sie unter: www.xpert.digital - www.xpert.solar - www.xpert.plus