AI 和 SEO with BERT – 来自 Transformers 的双向编码器表示 – 自然语言处理 (NLP) 领域的模型

语言选择 📢

发表于:2024年10月4日 /更新,发表于:2024年10月4日 - 作者: Konrad Wolfenstein

🚀💬 由 Google 开发:BERT 及其对 NLP 的重要性 - 为什么双向文本理解至关重要

🔍🗣️ BERT,全称 Bi Direction Encoder Representations from Transformers 的缩写,是 Google 开发的自然语言处理(NLP)领域的主要模型。它彻底改变了机器理解语言的方式。与之前从左到右顺序分析文本的模型不同,BERT 支持双向处理。这意味着它从前后文本序列中捕获单词的上下文。这种能力显着提高了对复杂语言环境的理解。

🔍BERT 的架构

近年来,自然语言处理 (NLP) 领域最重要的发展之一是 Transformer 模型的引入,如PDF 2017 - Attention is all you need - paper (维基百科)中所述。该模型通过丢弃以前使用的结构(例如机器翻译)从根本上改变了该领域。相反,它完全依赖于注意力机制。从那时起,Transformer 的设计成为了许多模型的基础,这些模型代表了语言生成、翻译等各个领域的最新技术。

BERT 就是基于这个 Transformer 架构的。该架构使用所谓的自注意力机制来分析句子中单词之间的关系。注意整个句子上下文中的每个单词,从而更准确地理解句法和语义关系。

本文“您需要的全部注意”的作者是:

- Ashish Vaswani(谷歌大脑)

- 诺姆·沙泽尔(谷歌大脑)

- 尼基·帕尔玛(谷歌研究)

- Jakob Uszkoreit(谷歌研究)

- 狮子琼斯(谷歌研究)

- Aidan N. Gomez(多伦多大学,部分工作在 Google Brain 完成)

- 卢卡斯·凯撒(谷歌大脑)

- Illia Polosukhin(独立人士,之前在 Google Research 工作)

这些作者对本文提出的 Transformer 模型的开发做出了重大贡献。

🔄 双向处理

BERT 的一个突出特点是其双向处理能力。循环神经网络 (RNN) 或长短期记忆 (LSTM) 网络等传统模型仅在一个方向上处理文本,而 BERT 可以在两个方向上分析单词的上下文。这使得模型能够更好地捕捉含义的细微差别,从而做出更准确的预测。

🕵️♂️ 屏蔽语言建模

BERT 的另一个创新方面是掩码语言模型(MLM)技术。它涉及屏蔽句子中随机选择的单词,并训练模型根据周围的上下文预测这些单词。这种方法迫使 BERT 深入理解句子中每个单词的上下文和含义。

🚀 BERT 的训练和定制

BERT 经历两个阶段的训练过程:预训练和微调。

📚 预训练

在预训练中,BERT 使用大量文本进行训练,以学习通用语言模式。这包括维基百科文本和其他广泛的文本语料库。在此阶段,模型学习基本的语言结构和上下文。

🔧 微调

经过预训练后,BERT 会针对特定的 NLP 任务进行定制,例如文本分类或情感分析。该模型使用较小的、与任务相关的数据集进行训练,以优化其针对特定应用程序的性能。

🌍 BERT的应用领域

事实证明,BERT 在自然语言处理的许多领域都非常有用:

搜索引擎优化

Google 使用 BERT 来更好地理解搜索查询并显示更相关的结果。这极大地提高了用户体验。

文本分类

BERT 可以按主题对文档进行分类或分析文本中的情绪。

命名实体识别 (NER)

该模型对文本中的命名实体进行识别和分类,例如个人、地点或组织名称。

问答系统

BERT 用于为提出的问题提供准确的答案。

🧠 BERT 对于人工智能未来的重要性

BERT 为 NLP 模型设定了新标准,并为进一步创新铺平了道路。通过其双向处理能力和对语言上下文的深入理解,它显着提高了人工智能应用的效率和准确性。

🔜 未来发展

BERT 和类似模型的进一步开发可能旨在创建更强大的系统。它们可以处理更复杂的语言任务,并可用于各种新的应用领域。将这些模型集成到日常技术中可以从根本上改变我们与计算机交互的方式。

🌟人工智能发展的里程碑

BERT 是人工智能发展的里程碑,彻底改变了机器处理自然语言的方式。其双向架构可以更深入地理解语言关系,使其成为各种应用不可或缺的一部分。随着研究的进展,像 BERT 这样的模型将继续在改进人工智能系统并为其使用开辟新的可能性方面发挥核心作用。

📣 类似主题

- 📚 隆重介绍 BERT:突破性的 NLP 模型

- 🔍 BERT 和双向性在 NLP 中的作用

- 🧠 Transformer 模型:BERT 的基石

- 🚀 掩码语言模型:BERT 成功的关键

- 📈 BERT 的定制:从预训练到微调

- 🌐BERT在现代技术中的应用领域

- 🤖 BERT 对人工智能未来的影响

- 💡未来展望:BERT的进一步发展

- 🏆 BERT 成为人工智能发展的里程碑

- 📰 Transformer 论文《Attention Is All You Need》的作者:BERT 背后的思想

#️⃣ 标签:#NLP #ArtificialIntelligence #Language Modeling #Transformer #MachineLearning

🎯🎯🎯 受益于 Xpert.Digital 全面服务包中广泛的五重专业知识 | 研发、XR、PR 和 SEM

Xpert.Digital 对各个行业都有深入的了解。 这使我们能够制定量身定制的策略,专门针对您特定细分市场的要求和挑战。 通过不断分析市场趋势并跟踪行业发展,我们可以前瞻性地采取行动并提供创新的解决方案。 通过经验和知识的结合,我们创造附加值并为客户提供决定性的竞争优势。

更多相关信息请点击这里:

BERT:革命性的🌟 NLP 技术

🚀 BERT 是 Bi Direction Encoder Representations from Transformers 的缩写,是 Google 开发的一种高级语言模型,自 2018 年推出以来,已成为自然语言处理(NLP)领域的重大突破。它基于 Transformer 架构,彻底改变了机器理解和处理文本的方式。但到底是什么让 BERT 如此特别,它到底有什么用途呢?要回答这个问题,我们需要深入研究BERT的技术原理、功能和应用领域。

📚 1.自然语言处理基础知识

为了充分掌握 BERT 的含义,简要回顾一下自然语言处理(NLP)的基础知识是有帮助的。 NLP 处理计算机和人类语言之间的交互。目标是教会机器分析、理解和响应文本数据。在引入 BERT 等模型之前,语言的机器处理经常面临重大挑战,特别是由于人类语言的歧义性、上下文依赖性和复杂结构。

📈 2. NLP模型的发展

在 BERT 出现之前,大多数 NLP 模型都基于所谓的单向架构。这意味着这些模型只能从左到右或从右到左读取文本,这意味着它们在处理句子中的单词时只能考虑有限的上下文。这种限制通常导致模型无法完全捕获句子的完整语义上下文。这使得准确解释歧义或上下文相关的单词变得困难。

BERT 之前 NLP 研究的另一个重要发展是 word2vec 模型,它允许计算机将单词翻译成反映语义相似性的向量。但这里的上下文也仅限于单词的直接周围。后来,循环神经网络(RNN),特别是长短期记忆(LSTM)模型被开发出来,使得通过存储多个单词的信息来更好地理解文本序列成为可能。然而,这些模型也有其局限性,特别是在处理长文本并同时理解两个方向的上下文时。

🔄 3. Transformer 架构带来的革命

2017 年 Transformer 架构的推出带来了突破,它构成了 BERT 的基础。 Transformer 模型旨在实现文本的并行处理,同时考虑前后文本中单词的上下文。这是通过所谓的自注意力机制来完成的,该机制根据句子中每个单词相对于句子中其他单词的重要性为该单词分配一个权重值。

与以前的方法相比,Transformer 模型不是单向的,而是双向的。这意味着他们可以从单词的左右上下文中提取信息,从而生成单词及其含义的更完整和准确的表示。

🧠 4. BERT:双向模型

BERT 将 Transformer 架构的性能提升到了一个新的水平。该模型的设计目的不仅是从左到右或从右到左捕获单词的上下文,而是同时在两个方向捕获单词的上下文。这使得 BERT 能够考虑句子中单词的完整上下文,从而显着提高语言处理任务的准确性。

BERT 的一个核心特征是使用所谓的屏蔽语言模型(MLM)。在训练 BERT 时,句子中随机选择的单词被替换为掩码,并且训练模型根据上下文猜测这些掩码单词。这项技术使 BERT 能够学习句子中单词之间更深入、更精确的关系。

此外,BERT 使用一种称为下一句预测 (NSP) 的方法,其中模型学习预测一个句子是否跟随另一个句子。这提高了 BERT 理解较长文本和识别句子之间更复杂关系的能力。

🌐5.BERT在实践中的应用

事实证明,BERT 对于各种 NLP 任务非常有用。以下是一些主要应用领域:

📊 a) 文本分类

BERT 最常见的用途之一是文本分类,其中文本被分为预定义的类别。这方面的例子包括情感分析(例如识别文本是积极的还是消极的)或客户反馈的分类。 BERT 通过对单词上下文的深入理解,可以提供比以前的模型更精确的结果。

❓ b) 问答系统

BERT 还用于问答系统,模型从文本中提取所提出问题的答案。这种能力在搜索引擎、聊天机器人或虚拟助手等应用中尤其重要。得益于其双向架构,BERT 可以从文本中提取相关信息,即使问题是间接表述的。

🌍 c) 文本翻译

虽然 BERT 本身并不是直接设计为翻译模型,但它可以与其他技术结合使用来改进机器翻译。通过更好地理解句子中的语义关系,BERT 可以帮助生成更准确的翻译,尤其是对于歧义或复杂的措辞。

🏷️ d) 命名实体识别 (NER)

另一个应用领域是命名实体识别(NER),它涉及识别文本中的特定实体,例如名称、地点或组织。事实证明,BERT 在这项任务上特别有效,因为它充分考虑了句子的上下文,使其能够更好地识别实体,即使它们在不同上下文中具有不同的含义。

✂️ e) 文字摘要

BERT 理解文本整个上下文的能力也使其成为自动文本摘要的强大工具。它可用于从长文本中提取最重要的信息并创建简洁的摘要。

🌟 6. BERT 对于研究和工业的重要性

BERT 的引入开创了 NLP 研究的新时代。它是首批充分利用双向 Transformer 架构强大功能的型号之一,为许多后续型号树立了标杆。许多公司和研究机构已将 BERT 集成到其 NLP 流程中,以提高其应用程序的性能。

此外,BERT还为语言模型领域的进一步创新铺平了道路。例如,随后开发了 GPT(生成式预训练变压器)和 T5(文本到文本传输变压器)等模型,它们基于相似的原理,但针对不同的用例提供了具体的改进。

🚧 7. BERT 的挑战和局限性

尽管 BERT 有许多优点,但它也存在一些挑战和局限性。最大的障碍之一是训练和应用模型所需的大量计算工作。由于 BERT 是一个非常庞大的模型,拥有数百万个参数,因此它需要强大的硬件和大量的计算资源,特别是在处理大量数据时。

另一个问题是训练数据中可能存在的潜在偏差。由于 BERT 是基于大量文本数据进行训练的,因此它有时会反映该数据中存在的偏见和刻板印象。然而,研究人员正在不断努力识别和解决这些问题。

🔍 现代语言处理应用的必备工具

BERT 显着改善了机器理解人类语言的方式。凭借其双向架构和创新的训练方法,它能够深入、准确地捕捉句子中单词的上下文,从而在许多 NLP 任务中获得更高的准确性。无论是在文本分类、问答系统还是实体识别领域,BERT 都已成为现代语言处理应用不可或缺的工具。

自然语言处理的研究无疑会继续前进,BERT 为未来的许多创新奠定了基础。尽管存在现有的挑战和限制,BERT 令人印象深刻地展示了该技术在短时间内取得的进步以及未来仍将出现哪些令人兴奋的机会。

🌀 Transformer:自然语言处理的一场革命

🌟 近年来,自然语言处理(NLP)领域最重要的发展之一就是 Transformer 模型的引入,正如 2017 年论文《Attention Is All You Need》中所述。该模型通过丢弃以前用于序列转导任务(例如机器翻译)的循环或卷积结构,从根本上改变了该领域。相反,它完全依赖于注意力机制。从那时起,Transformer 的设计成为了许多模型的基础,这些模型代表了语言生成、翻译等各个领域的最新技术。

🔄 变形金刚:范式转变

在引入 Transformer 之前,大多数排序任务模型都是基于循环神经网络 (RNN) 或长短期记忆网络 (LSTM),它们本质上是顺序的。这些模型逐步处理输入数据,创建沿序列传播的隐藏状态。尽管这种方法很有效,但计算量大且难以并行化,尤其是对于长序列。此外,由于所谓的“梯度消失”问题,RNN 很难学习长期依赖关系。

Transformer 的核心创新在于使用自注意力机制,该机制允许模型权衡句子中不同单词相对于彼此的重要性,而不管它们的位置如何。这使得模型能够比 RNN 或 LSTM 更有效地捕获广泛分布的单词之间的关系,并且以并行方式而不是顺序方式执行此操作。这不仅提高了训练效率,还提高了机器翻译等任务的性能。

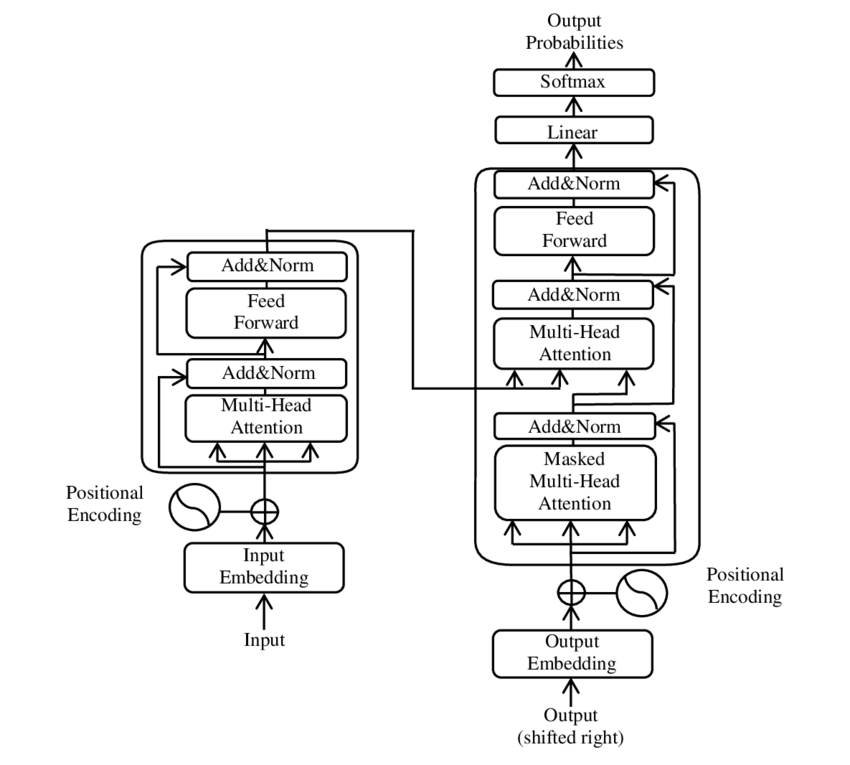

🧩 模型架构

Transformer 由两个主要组件组成:编码器和解码器,两者都由多层组成,并且严重依赖多头注意力机制。

⚙️编码器

编码器由六个相同的层组成,每个层都有两个子层:

1. 多头自注意力

这种机制允许模型在处理每个单词时关注输入句子的不同部分。多头注意力不是在单个空间中计算注意力,而是将输入投射到多个不同的空间中,从而允许捕获单词之间不同类型的关系。

2. 位置式全连接前馈网络

在注意力层之后,在每个位置独立应用全连接的前馈网络。这有助于模型处理上下文中的每个单词并利用注意力机制中的信息。

为了保留输入序列的结构,模型还包含位置输入(位置编码)。由于 Transformer 不会按顺序处理单词,因此这些编码对于为模型提供有关句子中单词顺序的信息至关重要。位置输入被添加到词嵌入中,以便模型可以区分序列中的不同位置。

🔍 解码器

与编码器一样,解码器也由六层组成,每层都有一个额外的注意力机制,允许模型在生成输出时关注输入序列的相关部分。解码器还使用掩蔽技术来防止其考虑未来位置,从而保留序列生成的自回归性质。

🧠 多头注意力和点积注意力

Transformer 的核心是多头注意力机制,它是更简单的点积注意力的扩展。注意力函数可以看作是查询和一组键值对(键和值)之间的映射,其中每个键代表序列中的一个单词,值代表相关的上下文信息。

多头注意力机制允许模型同时关注序列的不同部分。通过将输入投影到多个子空间中,模型可以捕获单词之间更丰富的关系集。这在机器翻译等任务中特别有用,其中理解单词的上下文需要许多不同的因素,例如句法结构和语义。

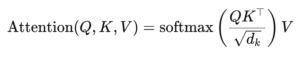

点积注意力的公式为:

这里(Q)是查询矩阵,(K)是键矩阵,(V)是值矩阵。 (sqrt{d_k}) 项是一个缩放因子,可防止点积变得太大,否则会导致梯度非常小和学习速度变慢。应用softmax函数来确保注意力权重之和为1。

🚀 变压器的优点

与 RNN 和 LSTM 等传统模型相比,Transformer 具有几个关键优势:

1. 并行化

由于 Transformer 同时处理序列中的所有标记,因此它可以高度并行化,因此训练速度比 RNN 或 LSTM 快得多,尤其是在大型数据集上。

2. 长期依赖

自注意力机制使模型能够比 RNN 更有效地捕获遥远单词之间的关系,而 RNN 受到计算顺序性质的限制。

3. 可扩展性

Transformer 可以轻松扩展到非常大的数据集和更长的序列,而不会遇到与 RNN 相关的性能瓶颈。

🌍 应用及效果

自推出以来,Transformer 已成为各种 NLP 模型的基础。最值得注意的例子之一是 BERT(来自 Transformers 的双向编码器表示),它使用改进的 Transformer 架构在许多 NLP 任务中实现了最先进的技术,包括问答和文本分类。

另一个重要的发展是 GPT(生成预训练 Transformer),它使用 Transformer 的解码器限制版本来生成文本。 GPT 模型(包括 GPT-3)现在用于各种应用程序,从内容创建到代码完成。

🔍 强大而灵活的模型

Transformer 从根本上改变了我们处理 NLP 任务的方式。它提供了一个强大而灵活的模型,可以应用于各种问题。它处理长期依赖关系和训练效率的能力使其成为许多最现代模型的首选架构方法。随着研究的进展,我们可能会看到 Transformer 的进一步改进和调整,特别是在图像和语言处理等领域,注意力机制在这些领域显示出了有希望的结果。

我们随时为您服务 - 建议 - 规划 - 实施 - 项目管理

☑️ 行业专家,这里有他自己的 Xpert。数字行业中心拥有超过 2,500 篇专业文章

我很乐意担任您的个人顾问。

您可以通过填写下面的联系表与我联系,或者直接致电+49 89 89 674 804 (慕尼黑) 。

我很期待我们的联合项目。

Xpert.Digital - 康拉德德军总部

Xpert.Digital 是一个专注于数字化、机械工程、物流/内部物流和光伏的工业中心。

凭借我们的360°业务发展解决方案,我们为知名企业提供从新业务到售后的支持。

市场情报、营销、营销自动化、内容开发、公关、邮件活动、个性化社交媒体和潜在客户培育是我们数字工具的一部分。

您可以通过以下网址了解更多信息: www.xpert.digital - www.xpert.solar - www.xpert.plus