Farklı analiz araçlarındaki trafik rakamları arasındaki tutarsızlıklar ve bunların gizli nedenleri

Xpert ön sürümü

Dil seçimi 📢

Yayınlanma tarihi: 11 Eylül 2025 / Güncellenme tarihi: 11 Eylül 2025 – Yazar: Konrad Wolfenstein

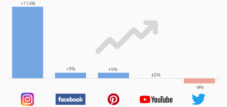

Farklı analiz araçlarındaki trafik rakamları arasındaki tutarsızlık ve bunların gizli nedenleri – Görsel: Xpert.Digital

Ziyaretçileriniz gerçek mi? Hepsi gerçek mi? Bot algılama hatalarıyla ilgili şaşırtıcı gerçek

### Google Analytics'e güveniyor musunuz? Bu pahalı hata tüm stratejinizi bozuyor ### Analiz araçlarınız neden gerçek ziyaretçi sayılarınızı bilmiyor ### Botlardan GDPR'ye: Web analizlerinizi sabote eden görünmez düşmanlar ### Analiz kaosu: Trafik sayılarınızın asla toplanamamasının gizli nedenleri ###

Sayılardan daha fazlası: Web analizlerinizin sizden gizlediği şey aslında ne?

Bir web sitesi işleten herkes bu sinir bozucu hissi bilir: Google Analytics'e bir göz attığınızda bir sayı, sunucu kaydında başka bir sayı ve pazarlama aracında da üçüncü bir sayı görürsünüz. Teknik bir hata veya basit bir yanlışlık gibi görünen şey aslında karmaşık bir buzdağının görünen kısmıdır. Trafik rakamları arasındaki tutarsızlık bir hata değil, modern internetin mimarisine kök salmış sistematik bir sorundur. "Kaç ziyaretçim var?" gibi basit bir sorunun artık basit bir cevabı yoktur.

Sebepler, görünmez oldukları kadar çeşitlidir. Gerçek kişileri yanlışlıkla filtreleyen agresif bot tespit sistemlerinden, çerez reklamlarıyla büyük veri boşlukları oluşturan GDPR gibi katı veri koruma yasalarına ve gizlilik nedeniyle izlemeyi aktif olarak engelleyen modern tarayıcılara kadar çeşitlilik gösterir. Bunlara, hatalı alanlar arası izleme, veri örneklemesinin istatistiksel tuzakları ve bazı ziyaretçilerinizin sunucularınız için görünmez olmasını sağlayan önbellekleme sistemlerinin görünmez rolü gibi teknik tuzaklar da eklenebilir.

Bu yanlışlıklar, bir rapordaki yüzeysel kusurlardan çok daha fazlasıdır. Yanlış sonuçlara, yanlış yönlendirilmiş pazarlama yatırımlarına ve kullanıcı davranışının temelden çarpıtılmış bir resmine yol açarlar. Rakamlarınızın neden farklı olduğunu anlamıyorsanız, körü körüne kararlar alıyorsunuz demektir. Bu makale, bu tutarsızlıkların gizli nedenlerini derinlemesine inceliyor, perde arkasındaki karmaşıklığı ortaya koyuyor ve eksik verilerle dolu bir dünyada bilinçli ve stratejik açıdan akıllıca kararlar almayı gösteriyor.

İçin uygun:

- SST Öncüleri | Çerez çağının sonu: Şirketler neden sunucu tarafı izlemeye güveniyor – Facebook, Pinterest ve TikTok

Trafik neden trafikle aynı şey değildir?

Web sitesi trafiğini ölçmek ilk bakışta basit gibi görünse de, gerçek daha karmaşıktır; farklı analiz araçları aynı web sitesi için farklı sonuçlar üretebilir. Bu tutarsızlıklar tesadüflerden veya teknik hatalardan değil, trafiğin yakalanma, işlenme ve yorumlanma biçimindeki temel farklılıklardan kaynaklanmaktadır.

Sorun, geçerli trafik olarak neyin sayılması gerektiğinin tanımıyla başlıyor. Bir araç her sayfa görüntülemesini ziyaret olarak sayarken, bir diğeri otomatik erişimi filtreliyor veya yalnızca JavaScript'i etkinleştirmiş ziyaretçileri dikkate alıyor. Bu farklı yaklaşımlar, ilk bakışta çelişkili görünen sayılara yol açsa da hepsinin kendi gerekçeleri var.

Modern web sitelerinin artık basit HTML sayfaları değil, birden fazla alan adı, alt alan adı ve entegre hizmetlere sahip karmaşık uygulamalar olduğu düşünüldüğünde, zorluk daha da karmaşık hale geliyor. Bir kullanıcı yolculuğuna ana web sitesinde başlayabilir, harici bir ödeme hizmeti sağlayıcısına geçebilir ve ardından bir onay sayfasına geri dönebilir. Bu adımların her biri, kullanılan araca ve nasıl yapılandırıldığına bağlı olarak farklı şekilde izlenebilir.

Bot tespitinin gizli tuzakları

İnsanlar bot olduğunda

Bot trafiğini otomatik olarak tespit etmek, web analitiğindeki en karmaşık görevlerden biridir. Modern bot tespit sistemleri, çeşitli sinyallere (fare hareketleri, kaydırma davranışı, sayfalarda geçirilen süre, tarayıcı parmak izi ve diğer birçok parametre) dayalı gelişmiş algoritmalar kullanır. Bu sistemler, insan kullanıcıların daha gerçekçi bir resmini elde etmek için otomatik trafiği tespit edip filtrelemek üzere tasarlanmıştır.

Ancak sorun, bu tespit sistemlerinin kusurlu olmasından kaynaklanıyor. Yanlış pozitifler veya gerçek kullanıcıların bot olarak yanlış tanımlanması yaygın bir sorundur. Çerezler veya JavaScript devre dışı bırakılmış bir web sitesinde çok hızlı gezinen bir kullanıcı kolayca bot olarak sınıflandırılabilir. Belirli tarama alışkanlıklarına sahip kullanıcılar özellikle etkilenir: erişilebilirlik teknolojilerini kullananlar, klavye kısayollarını tercih eden ileri düzey kullanıcılar veya alışılmadık yükleme kalıplarına neden olan yavaş internet bağlantısı olan bölgelerdeki kullanıcılar.

Etkisi önemli. Çalışmalar, Botometer gibi popüler bot tespit araçları kullanıldığında, kullanılan eşik değerine ve analiz edilen veri setine bağlı olarak sınıflandırma hata oranının %15 ila %85 arasında değişebileceğini gösteriyor. Bu, "bot trafiği" olarak filtrelenen ziyaretlerin önemli bir kısmının, davranışları sistem tarafından yanlış yorumlanan gerçek kişilerden oluştuğu anlamına geliyor.

Bot manzarasının gelişimi

Bot dünyası kökten değişti. İlk botlar, kullanıcı aracısı dizeleri veya IP adresleri gibi basit parametrelerle kolayca tespit edilebilirken, modern botlar çok daha karmaşık. Gerçek tarayıcı motorları kullanıyor, insan davranış kalıplarını simüle ediyor ve konut IP adreslerini kullanıyorlar. Aynı zamanda, insan davranışını neredeyse mükemmel bir şekilde taklit ederken karmaşık görevleri yerine getirebilen yapay zeka destekli aracılar ortaya çıktı.

Bu gelişme, tespit sistemleri için yeni zorluklar ortaya çıkarıyor. Tarayıcı parmak izlerini veya davranış kalıplarını analiz etmek gibi geleneksel yöntemler, botlar daha karmaşık hale geldikçe daha az güvenilir hale geliyor. Bu durum, tespit sistemlerinin ya çok muhafazakar bir şekilde yapılandırılmasına ve birçok botun geçişine izin verilmesine ya da çok agresif bir şekilde yapılandırılmasına ve meşru kullanıcıların yanlışlıkla engellenmesine yol açıyor.

İntranetlerin ve kapalı ağların görünmez dünyası

Güvenlik duvarlarının ardında ölçüm

İnternet trafiğinin büyük bir kısmı, geleneksel analiz araçlarının göremediği kapalı ağlarda gerçekleşir. Kurumsal intranetler, özel ağlar ve kapalı gruplar, geleneksel istatistiklerde yakalanmayan önemli miktarda trafik üretir. Bu ağlar genellikle kendi analiz çözümlerini kullanır veya güvenlik ve gizliliği sağlamak için kapsamlı izlemeyi tamamen göz ardı eder.

İntranet trafiğini ölçmenin zorlukları çok çeşitlidir. Güvenlik duvarları aktif sorgulama girişimlerini engelleyebilir, Ağ Adresi Çevirisi ana bilgisayarların gerçek sayısını ve yapısını gizler ve yönetim politikaları genellikle ağ bileşenlerinin görünürlüğünü kısıtlar. Birçok kuruluş, trafik analizini daha da karmaşık hale getiren proxy sunucuları veya trafik şekillendirme araçları gibi ek güvenlik önlemleri uygular.

Dahili analiz yöntemleri

Şirket içi trafiğini ölçmek isteyen şirketler, özel yöntemlere başvurmalıdır. Paket dinleme ve ağ akışı analizi yaygın tekniklerdir, ancak trafiği web tabanlı analiz araçlarından farklı bir düzeyde yakalarlar. JavaScript tabanlı araçlar bireysel kullanıcı oturumlarını ve sayfa görüntülemelerini izlerken, ağ izleme araçları tüm trafiği paket düzeyinde analiz eder.

Bu farklı yaklaşımlar, temelde farklı ölçümlere yol açar. Örneğin, bir ağ izleme aracı iki sunucu arasında yüksek hacimli veri aktarımı olduğunu gösterebilir, ancak bu verinin büyük bir videoyu izleyen tek bir kullanıcıdan mı yoksa aynı anda küçük dosyalar indiren yüz kullanıcıdan mı geldiğini ayırt edemez.

Önerimiz: 🌍 Sınırsız erişim 🔗 Ağ bağlantılı 🌐 Çok dilli 💪 Güçlü satışlar: 💡 Stratejiyle özgün 🚀 Yenilik buluşuyor 🧠 Sezgi

Yerelden küresele: KOBİ'ler akıllı stratejilerle küresel pazarı ele geçiriyor - Resim: Xpert.Digital

Bir şirketin dijital varlığının başarısını belirlediği bir zamanda, zorluk bu varlığın nasıl özgün, bireysel ve geniş kapsamlı hale getirileceğidir. Xpert.Digital, kendisini bir endüstri merkezi, bir blog ve bir marka elçisi arasında bir kesişim noktası olarak konumlandıran yenilikçi bir çözüm sunuyor. İletişim ve satış kanallarının avantajlarını tek platformda birleştirerek 18 farklı dilde yayın yapılmasına olanak sağlar. Ortak portallarla yapılan işbirliği ve Google Haberler'de makale yayınlama olanağı ve yaklaşık 8.000 gazeteci ve okuyucudan oluşan bir basın dağıtım listesi, içeriğin erişimini ve görünürlüğünü en üst düzeye çıkarıyor. Bu, dış satış ve pazarlamada (SMarketing) önemli bir faktörü temsil eder.

Bununla ilgili daha fazla bilgiyi burada bulabilirsiniz:

Veri kalitesinin korunması: GDPR'ye karşı stratejiler ve gizlilik araçları

Veri koruma düzenlemesi trafik katili olarak

GDPR'nin veri toplama üzerindeki etkisi

Genel Veri Koruma Yönetmeliği ve benzeri yasaların yürürlüğe girmesi, web analitiğinin görünümünü kökten değiştirdi. Web sitelerinin artık kullanıcı takibi için açık rıza alması gerekiyor ve bu da mevcut verilerde önemli bir düşüşe yol açıyor. Araştırmalar, ziyaretçilerin yalnızca küçük bir kısmının izleme çerezlerine onay verdiğini gösteriyor ve bu da analitik verilerde büyük boşluklar yaratıyor.

Sorun, salt veri toplamanın ötesine geçiyor. GDPR, onayın belirli ve bilgilendirilmiş olmasını şart koşuyor; bu da yinelemeli veri analizleriyle sağlanması zor bir durum. Şirketler artık yalnızca "gelecekteki tüm analiz amaçları" için izin talep edemez, verilerin nasıl kullanılacağını da açıkça belirtmek zorunda. Bu gereklilik, yasal sınırları aşmadan kapsamlı analizler yapmayı neredeyse imkansız hale getiriyor.

Çerez engelleme ve gizlilik araçları

Modern tarayıcılar, yasal gerekliliklerin çok ötesine geçen kapsamlı gizlilik koruma önlemleri uyguladı. Safari ve Firefox, varsayılan olarak üçüncü taraf çerezlerini engelliyor; Chrome da aynısını yapacağını duyurdu ve Brave gibi gizlilik odaklı tarayıcılar, koruma önlemlerini daha da ileri götürüyor.

Veri kalitesi üzerindeki etkisi önemlidir. Web siteleri, hedef kitleye ve kullanılan izleme yöntemlerine bağlı olarak toplayabildikleri verilerde %30-70 oranında bir azalma yaşarlar. Özellikle sorunlu olan, bu azalmanın tüm kullanıcı grupları arasında eşit olarak dağılmamış olmasıdır. Teknoloji meraklısı kullanıcıların gizlilik araçlarını kullanma olasılığı daha yüksektir ve bu da sistematik veri bozulmasına yol açar.

İçin uygun:

- Yeni Dijital Görünürlük - SEO, LLMO, GEO, AIO ve AEO - SEO'nun tek başına deşifre edilmesi artık yeterli değil

Veri örneklemesinin tuzakları

Bütün bir parça olduğunda

Veri örnekleme, birçok analiz aracı tarafından büyük miktarda veriyi işlemek için kullanılan istatistiksel bir tekniktir. Mevcut tüm verileri analiz etmek yerine, yalnızca temsili bir örneklem değerlendirilir ve sonuçlar genelleştirilir. Örneğin, Google Analytics, hesaplama süresini kısaltmak için karmaşık raporlar veya büyük miktarda veri için otomatik olarak örneklemeye başlar.

Sorun, örneğin temsili olduğu varsayımında yatmaktadır. Ancak web analitiğinde, tüm ziyaretçi ve trafik türlerinin örneklemde eşit olarak temsil edilmesini sağlamak zordur. Örneğin, bir örnekleme algoritması belirli bir reklam kampanyasından gelen ziyaretleri orantısız bir şekilde yakalayarak çarpık sonuçlara yol açabilir.

Örnekleme hata payları önemli olabilir. Büyük örneklemlerde doğruluk nispeten yüksek olsa da, daha küçük segmentler veya belirli zaman dilimleri için %30'a varan sapmalar meydana gelebilir. İş kararları için hassas verilere güvenen şirketler için bu yanlışlıklar maliyetli hatalara yol açabilir.

Örneklemenin sınırları

Örnekleme sorunları, özellikle birden fazla filtre veya segment aynı anda uygulandığında belirginleşir. Bölgeye, cihaz türüne ve kampanyaya göre segmentlere ayrılmış bir rapor, nihayetinde orijinal verilerin yalnızca çok küçük bir bölümüne dayanabilir. Bu büyük ölçüde küçültülmüş veri kümeleri, istatistiksel dalgalanmalara karşı hassastır ve yanıltıcı eğilimler gösterebilir.

Modern analiz araçları, örneklemeyi azaltmanın veya ortadan kaldırmanın yollarını sunsa da, bunlar genellikle daha yüksek maliyetler veya daha uzun işlem süreleri gerektirir. Birçok şirket, ilgili göstergeler genellikle göz ardı edildiği veya yeterince belirgin bir şekilde gösterilmediği için raporlarının örneklenmiş verilere dayandığının farkında değildir.

Alanlar arası izleme ve kullanıcı deneyiminin parçalanması

Alanlar arası izleme zorluğu

Modern web siteleri nadiren tek bir alan adından oluşur. E-ticaret siteleri, ürün katalogları ve ödeme işlemleri için ayrı alan adları kullanır, şirketler farklı iş birimleri için farklı alt alan adlarına sahiptir ve birçok hizmet içerik dağıtım ağlarına veya bulut platformlarına dış kaynaklı olarak verilir. Bu alan adları arasındaki herhangi bir değişiklik, kullanıcı takibinde kesintiye yol açabilir.

Sorun tarayıcı güvenlik politikalarında yatıyor. Çerezler ve diğer izleme mekanizmaları, varsayılan olarak, ayarlandığı alan adıyla sınırlıdır. Bir kullanıcı shop.example.com adresinden payment.example.com adresine gittiğinde, analiz araçları bunu aynı kullanıcı oturumu olmasına rağmen iki ayrı ziyaret olarak algılar.

Alanlar arası izlemeyi uygulamak teknik olarak zorlu ve hataya açıktır. Yaygın sorunlar arasında yanlış yapılandırılmış yönlendirici hariç tutma listeleri, eksik alan yapılandırmaları veya istemci kimliklerini alanlar arasında aktarma sorunları bulunur. Bu teknik engeller, birçok web sitesinin kullanıcı yolculukları hakkında eksik veya çarpık veriler toplamasına yol açar.

Veri kalitesi üzerindeki etkisi

Alanlar arası izleme doğru şekilde çalışmazsa, analiz verilerinde sistematik önyargılar ortaya çıkar. Doğrudan trafik genellikle aşırı temsil edilir çünkü bir alandan diğerine geçen kullanıcılar yeni doğrudan ziyaretçi olarak sayılır. Aynı zamanda, orijinal yönlendiren bilgileri kaybolduğu için diğer trafik kaynakları yeterince temsil edilmez.

Bu önyargılar, pazarlama kampanyalarının etkinliği hakkında yanlış sonuçlara yol açabilir. Kullanıcıları önce bir açılış sayfasına, ardından farklı bir alan adındaki bir ödeme sistemine yönlendiren bir reklam kampanyası, dönüşüm doğrudan trafiğe atfedildiği için analizlerde gerçekte olduğundan daha düşük performans gösterebilir.

Sunucu günlükleri ve istemci tarafı analizleri

Veri toplamanın iki dünyası

Veri toplama türü, hangi trafiğin kaydedileceğini temelde etkiler. Sunucu günlük analitiği ve JavaScript tabanlı izleme sistemleri genellikle web sitesi kullanımının farklı yönlerini ölçer. Sunucu günlükleri, ister bir insandan ister bir bottan kaynaklansın, sunucuya ulaşan her HTTP isteğini kaydeder. JavaScript tabanlı araçlar ise yalnızca tarayıcı kodunun yürütülmesini içeren etkileşimleri ölçer.

Bu farklılıklar, ilgili sistemlerde çeşitli kör noktalara yol açar. Sunucu günlükleri ayrıca, JavaScript'i devre dışı bırakan, reklam engelleyici kullanan veya sayfada çok hızlı gezinen kullanıcıların erişimini de kaydeder. JavaScript tabanlı araçlar ise kaydırma derinliği, belirli öğelere tıklamalar veya belirli içerikleri görüntüleme süresi gibi kullanıcı etkileşimleri hakkında daha ayrıntılı bilgiler toplayabilir.

Farklı sistemlerdeki bot sorunu

Bot trafiğini yönetmek, sunucu günlük analizi ve istemci tarafı araçları arasında önemli ölçüde farklılık gösterir. Sunucu günlükleri, her otomatik istek kaydedildiği için doğal olarak çok daha fazla bot trafiği içerir. Sunucu günlüklerinden botları filtrelemek, uzmanlık gerektiren karmaşık ve zaman alıcı bir iştir.

İstemci tarafı analiz araçları, JavaScript çalıştırmadıkları için birçok basit botu otomatik olarak filtreleme avantajına sahiptir. Ancak bu, tarayıcıları JavaScript'i desteklemeyen veya devre dışı bırakmış olan meşru kullanıcıları da kapsam dışı bırakır. Öte yandan, tam tarayıcı motorlarını kullanan modern ve gelişmiş botlar, her iki sistem tarafından da normal kullanıcılar olarak kaydedilir.

İçerik dağıtım ağlarının ve önbelleğe almanın rolü

Görünmez altyapı

İçerik dağıtım ağları ve önbellekleme sistemleri modern internetin ayrılmaz bir parçası haline gelmiştir, ancak trafik ölçümünde ek karmaşıklık yaratmaktadırlar. İçerik önbellekten iletildiğinde, ilgili istekler izleme sisteminin kurulu olduğu orijinal sunucuya asla ulaşamayabilir.

Kenar önbelleğe alma ve CDN hizmetleri, gerçek sayfa görüntülemelerinin önemli bir kısmının sunucu günlüklerinden kaybolmasına neden olabilir. Aynı zamanda, önbelleğe alınmış sayfalarda çalışan JavaScript tabanlı izleme kodları bu ziyaretleri yakalayarak farklı ölçüm yöntemleri arasında tutarsızlıklara yol açabilir.

Coğrafi dağılım ve ölçüm sorunları

CDN'ler, yükleme sürelerini optimize etmek için içeriği coğrafi olarak dağıtır. Ancak bu dağılım, trafik modellerinin bölgeye göre farklı kaydedilmesine neden olabilir. Avrupa'daki bir kullanıcı Almanya'daki bir CDN sunucusuna erişebilirken, ziyareti ABD'deki orijinal sunucunun kayıtlarında görünmeyebilir.

Bu coğrafi parçalanma, bir web sitesinin gerçek erişim ve etkisini doğru bir şekilde ölçmeyi zorlaştırmaktadır. Yalnızca sunucu kayıtlarına dayanan analiz araçları, belirli bölgelerden gelen trafiği sistematik olarak düşük tahmin edebilirken, küresel altyapıya sahip araçlar daha eksiksiz bir resim sunabilir.

'Yönetilen AI' (Yapay Zeka) ile dijital dönüşümün yeni bir boyutu - Platform ve B2B Çözümü | Xpert Consulting

'Yönetilen AI' (Yapay Zeka) ile dijital dönüşümün yeni bir boyutu – Platform ve B2B Çözümü | Xpert Consulting - Görsel: Xpert.Digital

Burada, şirketinizin özelleştirilmiş yapay zeka çözümlerini hızlı, güvenli ve yüksek giriş engelleri olmadan nasıl uygulayabileceğini öğreneceksiniz.

Yönetilen Yapay Zeka Platformu, yapay zeka için kapsamlı ve sorunsuz bir pakettir. Karmaşık teknolojiler, pahalı altyapılar ve uzun geliştirme süreçleriyle uğraşmak yerine, uzman bir iş ortağından ihtiyaçlarınıza göre uyarlanmış, genellikle birkaç gün içinde anahtar teslim bir çözüm alırsınız.

Başlıca faydalarına bir göz atalım:

⚡ Hızlı uygulama: Fikirden operasyonel uygulamaya aylar değil, günler içinde. Anında değer yaratan pratik çözümler sunuyoruz.

🔒 Maksimum veri güvenliği: Hassas verileriniz sizinle kalır. Üçüncü taraflarla veri paylaşımı yapmadan güvenli ve uyumlu bir işlem garantisi veriyoruz.

💸 Finansal risk yok: Sadece sonuçlara göre ödeme yaparsınız. Donanım, yazılım veya personele yapılan yüksek ön yatırımlar tamamen ortadan kalkar.

🎯 Ana işinize odaklanın: En iyi yaptığınız işe odaklanın. Yapay zeka çözümünüzün tüm teknik uygulamasını, işletimini ve bakımını biz üstleniyoruz.

📈 Geleceğe Hazır ve Ölçeklenebilir: Yapay zekanız sizinle birlikte büyür. Sürekli optimizasyon ve ölçeklenebilirlik sağlar, modelleri yeni gereksinimlere esnek bir şekilde uyarlarız.

Bununla ilgili daha fazla bilgiyi burada bulabilirsiniz:

Sunucu taraflı izleme: çözüm mü yoksa yeni bir karmaşıklık mı?

Gizlilik Öncelikli İzleme ve SınırlarıSunucu Tarafı İzleme: Çözüm mü Yoksa Yeni Bir Karmaşıklık mı?

Birinci taraf verilere geçiş

Gizlilik düzenlemelerine ve tarayıcı değişikliklerine yanıt olarak, birçok şirket birinci taraf veri toplama yöntemine geçmeye çalışıyor. Bu yaklaşım, verileri yalnızca doğrudan kendi web sitelerinden topluyor ve üçüncü taraf hizmetlere ihtiyaç duymuyor. Bu yaklaşım gizlilik açısından daha uyumlu olsa da, yeni zorluklar da beraberinde getiriyor.

Birinci taraf izleme, genellikle üçüncü taraf çözümlerden daha az kapsamlıdır. Kullanıcıları farklı web sitelerinde izleyemez, bu da atıf ve hedef kitle analizi olanaklarını sınırlar. Ayrıca, tüm şirketlerin karşılayamayacağı önemli teknik uzmanlık ve altyapı yatırımları gerektirir.

Alternatif olarak sunucu tarafı izleme

Sunucu tarafı izleme, gizlilik ve engelleme sorunlarına bir çözüm olarak giderek daha fazla öne çıkıyor. Bu yaklaşım, verileri sunucu tarafında toplayıp işleyerek tarayıcı tabanlı engelleme mekanizmalarına karşı daha az savunmasız hale getiriyor. Ancak bu yaklaşım, beraberinde karmaşıklıklar da getiriyor.

Sunucu tarafı izlemeyi uygulamak önemli teknik kaynaklar ve uzmanlık gerektirir. Şirketler, veri toplama ve işleme için kendi altyapılarını oluşturmak zorundadır; bu da maliyet ve bakım gerektirir. Ayrıca, sunucu tarafı sistemleri, eksiksiz analiz için kritik öneme sahip bazı istemci tarafı etkileşimlerini yakalayamaz.

İçin uygun:

- Sunucu tarafı izleme engelsiz nasıl çalışır: Reklam engelleyiciler ve çerez izleme kontrolü zamanlarında etkili izleme

Teknik altyapı ve etkileri

Tek arıza noktaları

Birçok web sitesi, analizleri için harici hizmetlere güvenir. Bu hizmetler başarısız olduğunda veya engellendiğinde, verilerde genellikle sonradan fark edilen boşluklar oluşur. Kesintinin çeşitli nedenleri olabilir: sağlayıcıyla ilgili teknik sorunlar, ağ sorunları veya güvenlik duvarları ya da gizlilik araçları tarafından engellenme.

Bu bağımlılıklar veri bütünlüğü açısından riskler yaratır. Önemli bir pazarlama kampanyası sırasında Google Analytics'te kısa süreli bir kesinti, kampanyanın performansının sistematik olarak küçümsenmesine yol açabilir. Yalnızca tek bir analiz aracına güvenen şirketler, bu tür veri kayıplarına karşı özellikle savunmasızdır.

Uygulama hataları ve sonuçları

İzleme kodlarının uygulanmasındaki hatalar yaygındır ve önemli veri kayıplarına yol açabilir. Yaygın sorunlar arasında belirli sayfalarda eksik izleme kodları, yinelenen uygulamalar veya hatalı yapılandırmalar bulunur. Bu hatalar, etkileri genellikle hemen görülemediği için uzun süre fark edilmeyebilir.

Analitik uygulamalarının kalite güvencesi genellikle hafife alınan bir görevdir. Birçok şirket, yeterli test ve doğrulama yapmadan izleme kodu uygulamaktadır. Web sitesi yapısındaki değişiklikler, yeni sayfalar veya içerik yönetim sistemlerindeki güncellemeler, mevcut izleme uygulamalarını anında fark edilmeden bozabilir.

Trafik ölçümünün geleceği

Yeni teknolojiler ve yaklaşımlar

Trafik ölçümü, yeni zorlukların üstesinden gelmek için sürekli olarak gelişiyor. Makine öğrenimi ve yapay zekâ, bot trafiğini belirlemek ve veri boşluklarını kapatmak için giderek daha fazla kullanılıyor. Bu teknolojiler, insanların tespit etmekte zorlandığı büyük miktardaki verilerdeki kalıpları tespit edebiliyor.

Aynı zamanda, gizliliği koruyan yeni ölçüm teknolojileri ortaya çıkıyor. Farklı gizlilik, birleşik öğrenme ve diğer yaklaşımlar, bireysel kullanıcıları tanımlamadan faydalı bilgiler sağlamayı amaçlıyor. Bu teknolojiler hala geliştirme aşamasında olsa da web analitiğinin geleceğini şekillendirebilir.

Düzenleyici gelişmeler

Veri koruma alanındaki düzenleyici ortam gelişmeye devam ediyor. Çeşitli ülke ve bölgelerdeki yeni yasalar, veri toplama ve işleme konusunda ek gereklilikler getiriyor. Şirketler, uyumlu kalabilmek için analitik stratejilerini sürekli olarak uyarlamak zorunda.

Bu düzenleyici değişiklikler, mevcut verilerin daha da parçalanmasına yol açacaktır. Kapsamlı ve ayrıntılı trafik verilerinin kolayca erişilebilir olduğu günler artık geçmişte kalmış olabilir. Şirketlerin, eksik ve eksik verilerle çalışmayı öğrenmeleri ve karar alma süreçlerini buna göre uyarlamaları gerekecektir.

Şirketler için pratik çıkarımlar

Veri belirsizliğiyle başa çıkma stratejileri

Veri tutarsızlıklarının çeşitli kaynakları göz önüne alındığında, şirketler analitik verilerini yorumlamak için yeni yaklaşımlar geliştirmelidir. Bir analitik araçtan tek bir "gerçeği" çıkarmanın günleri artık geride kaldı. Bunun yerine, birden fazla veri kaynağının ilişkilendirilip yorumlanması gerekiyor.

Sağlam bir yaklaşım, birden fazla analiz aracı kullanmayı ve verileri sunucu günlükleri, satış verileri veya müşteri geri bildirimleri gibi diğer metriklerle düzenli olarak doğrulamayı içerir. Şirketler ayrıca araçlarının sınırlarını ve bunların veri yorumlamasını nasıl etkilediğini anlamalıdır.

Veri kalitesinin önemi

Analitik verilerin niceliğinden ziyade niteliği giderek daha önemli hale geliyor. Şirketler, verilerinin doğru bir şekilde toplanıp yorumlanmasını sağlayan altyapı ve süreçlere yatırım yapmalıdır. Bu, izleme uygulamalarının düzenli denetimlerini, verilerle çalışan ekiplerin eğitimini ve kalite güvence süreçlerinin geliştirilmesini içerir.

Veri kalitesine yatırım yapmak uzun vadede karşılığını verir, çünkü daha iyi veriler daha iyi kararlara yol açar. Analitik verilerinin sınırlarını anlayan ve buna göre hareket eden şirketler, yüzeysel veya yanlış ölçümlere güvenen şirketlere göre rekabet avantajına sahiptir.

Web sitesi trafiğinin neden tek bir gerçeği yoktur?

Görünüşte basit olan web sitesi ziyaretçi sayısı sorusu, aslında birçok yönü olan karmaşık bir konudur. Tüm trafik eşit yaratılmamıştır ve farklı analiz araçlarındaki sayılar haklı nedenlerle farklılık gösterebilir. Zorluklar, bot tespiti ve alanlar arası izleme gibi teknik konulardan veri koruma yasalarının getirdiği yasal gerekliliklere kadar uzanmaktadır.

Şirketler için bu, analitik stratejilerini yeniden gözden geçirmeleri ve çeşitlendirmeleri gerektiği anlamına geliyor. Tek bir araca veya veri kaynağına güvenmek risklidir ve hatalı iş kararlarına yol açabilir. Bunun yerine, birden fazla veri kaynağı kullanmalı ve her kaynağın sınırlamalarını anlamalıdırlar.

Web analitiğinin geleceği muhtemelen daha da karmaşık olacak. Gizlilik düzenlemeleri daha katı hale geliyor, tarayıcılar daha fazla koruma sağlıyor ve kullanıcılar dijital gizliliklerinin daha fazla farkına varıyor. Aynı zamanda, veri toplama ve analizi için yeni fırsatlar sunan yeni teknolojiler ve yöntemler ortaya çıkıyor.

Bu gelişmeleri anlayan ve bunlara hazırlıklı olan şirketler, parçalanmış ve sınırlı analitik verilerin olduğu bir dünyada başarıya daha iyi ulaşacaklardır. Önemli olan mükemmel veriler beklemek değil, mevcut verileri doğru yorumlayıp doğru sonuçlar çıkarmaktır.

Çeşitli trafik rakamları arasındaki tutarsızlık bir hata değil, modern internetin bir özelliğidir. Dijital dünyanın karmaşıklığını ve çeşitliliğini yansıtır. Bu karmaşıklığı bir fırsat olarak değerlendiren ve uygun stratejiler geliştiren şirketler, uzun vadede karmaşık sorulara basit cevaplar arayan şirketlere göre daha başarılı olacaktır.

Sizin için oradayız - tavsiye - planlama - uygulama - proje yönetimi

☑️ Strateji, danışmanlık, planlama ve uygulama konularında KOBİ desteği

☑️ Dijital stratejinin ve dijitalleşmenin oluşturulması veya yeniden düzenlenmesi

☑️ Uluslararası satış süreçlerinin genişletilmesi ve optimizasyonu

☑️ Küresel ve Dijital B2B ticaret platformları

☑️ Öncü İş Geliştirme

Kişisel danışmanınız olarak hizmet etmekten mutluluk duyarım.

Aşağıdaki iletişim formunu doldurarak benimle iletişime geçebilir veya +49 89 89 674 804 (Münih) .

Ortak projemizi sabırsızlıkla bekliyorum.

Xpert.Digital - Konrad Wolfenstein

Xpert.Digital, dijitalleşme, makine mühendisliği, lojistik/intralojistik ve fotovoltaik konularına odaklanan bir endüstri merkezidir.

360° iş geliştirme çözümümüzle, tanınmış firmalara yeni işlerden satış sonrasına kadar destek veriyoruz.

Pazar istihbaratı, pazarlama, pazarlama otomasyonu, içerik geliştirme, halkla ilişkiler, posta kampanyaları, kişiselleştirilmiş sosyal medya ve öncü yetiştirme dijital araçlarımızın bir parçasıdır.

Daha fazla bilgiyi şu adreste bulabilirsiniz: www.xpert.digital - www.xpert.solar - www.xpert.plus