KI och SEO med BERT - Bidirectional Encoder Representations from Transformers - Model in the Field of Natural Language Processing (NLP)

Röstval 📢

Publicerad den: 4 oktober 2024 / Uppdaterad den: 4 oktober 2024 – Författare: Konrad Wolfenstein

KI och SEO med BERT - Bidirectional Encoder Representations from Transformers - Model in the Field of Natural Language Processing (NLP) - Bild: Xpert.digital

🚀💬 Utvecklad av Google: BERT och dess betydelse för NLP - Varför dubbelriktad textförståelse är avgörande

🔍🗣️ BERT, förkortning för Bidirectional Encoder Representations from Transformers, är en viktig modell inom området naturlig språkbehandling (NLP) som utvecklats av Google. Den har revolutionerat hur maskiner förstår språk. Till skillnad från tidigare modeller som analyserade text sekventiellt från vänster till höger eller vice versa, möjliggör BERT dubbelriktad bearbetning. Det betyder att den förstår sammanhanget för ett ord från både föregående och efterföljande textsekvenser. Denna funktion förbättrar avsevärt förståelsen av komplexa språkliga relationer.

🔍 BERT:s arkitektur

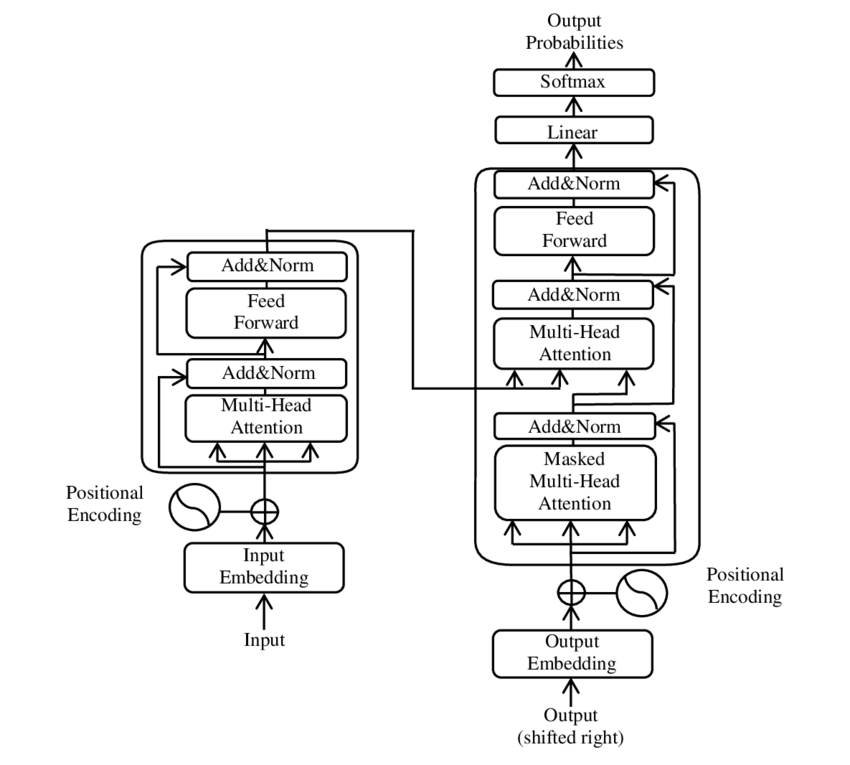

Under senare år har en av de viktigaste utvecklingarna inom naturlig språkbehandling (NLP) varit introduktionen av Transformer-modellen, som beskrivs i PDF-artikeln "Attention is all you need" ( Wikipedia ) från 2017. Denna modell förändrade fundamentalt området genom att förkasta tidigare använda strukturer, såsom maskinöversättning. Istället förlitar den sig uteslutande på uppmärksamhetsmekanismer. Transformer-designen har sedan dess legat till grund för många modeller som representerar den senaste tekniken inom olika områden, inklusive talgenerering, översättning och mer därtill.

BERT bygger på denna transformatorarkitektur. Denna arkitektur använder så kallade självuppmärksamhetmekanismer för att analysera relationerna mellan ord i en mening. Varje ord uppmärksammas inom ramen för hela meningen, vilket leder till en mer exakt förståelse av syntaktiska och semantiska relationer.

Författarna till artikeln ”Uppmärksamhet är allt du behöver” är:

- Ashish Vaswani (Google Brain)

- Noam Shazeer (Google Brain)

- Niki Parmar (Google Research)

- Jakob Uszkoreit (Google Research)

- Lion Jones (Google Research)

- Aidan N. Gomez (University of Toronto, arbete delvis utfört vid Google Brain)

- Łukasz Kaiser (Google Brain)

- Illia Polosukhin (Oberoende, tidigare arbete på Google Research)

Dessa författare har gjort betydande bidrag till utvecklingen av Transformer-modellen som presenteras i denna artikel.

🔄 Dubbelriktad bearbetning

En viktig funktion hos BERT är dess förmåga att bearbeta text dubbelriktat. Medan traditionella modeller som återkommande neurala nätverk (RNN) eller långtidsminnesnätverk (LSTM) bearbetar text i endast en riktning, analyserar BERT ett ords sammanhang i båda riktningarna. Detta gör att modellen bättre kan fånga subtila nyanser av betydelse och därmed göra mer exakta förutsägelser.

🕵️♂️ Maskerad talmodellering

En annan innovativ aspekt av BERT är Masked Language Model (MLM)-tekniken. Här maskeras slumpmässigt utvalda ord i en mening, och modellen tränas att förutsäga dessa ord baserat på det omgivande sammanhanget. Denna metod tvingar BERT att utveckla en djup förståelse för sammanhanget och betydelsen av varje ord i meningen.

🚀 Utbildning och anpassning av BERT

BERT genomgår en tvåstegsutbildningsprocess: förutbildning och finjustering.

📚 Förberedelser inför träningen

I förträningen tränas BERT med stora mängder text för att lära sig allmänna språkmönster. Detta inkluderar Wikipedia-artiklar och andra omfattande textkorpusar. Under denna fas lär sig modellen grundläggande språkliga strukturer och sammanhang.

🔧 Finjustering

Efter förträning anpassas BERT för specifika NLP-uppgifter, såsom textklassificering eller sentimentanalys. Modellen tränas med mindre, uppgiftsrelaterade datamängder för att optimera prestandan för specifika tillämpningar.

🌍 Användningsområden för BERT

BERT har visat sig vara extremt användbart inom många områden av naturlig språkbehandling:

Sökmotoroptimering

Google använder BERT för att bättre förstå sökfrågor och visa mer relevanta resultat. Detta förbättrar användarupplevelsen avsevärt.

Textklassificering

BERT kan kategorisera dokument efter ämne eller analysera stämningen i texter.

Namngiven enhetsigenkänning (NER)

Modellen identifierar och klassificerar namngivna entiteter i texter, såsom namn på personer, platser eller organisationer.

Fråge-svar-system

BERT används för att ge exakta svar på ställda frågor.

🧠 BERT:s betydelse för AI:s framtid

BERT har satt nya standarder för NLP-modeller och banat väg för ytterligare innovationer. Genom sin förmåga till dubbelriktad bearbetning och sin djupa förståelse av språkliga sammanhang har det avsevärt ökat effektiviteten och noggrannheten hos AI-applikationer.

🔜 Framtida utvecklingar

Vidareutveckling av BERT och liknande modeller förväntas syfta till att skapa ännu kraftfullare system. Dessa skulle kunna hantera mer komplexa språkuppgifter och användas inom en mängd olika nya tillämpningsområden. Att integrera sådana modeller i vardagsteknik skulle i grunden kunna förändra hur vi interagerar med datorer.

🌟 Milstolpe i utvecklingen av artificiell intelligens

BERT är en milstolpe i utvecklingen av artificiell intelligens och har revolutionerat hur maskiner bearbetar naturligt språk. Dess dubbelriktade arkitektur möjliggör en djupare förståelse av språkliga relationer, vilket gör den oumbärlig för en mängd olika tillämpningar. Allt eftersom forskningen fortskrider kommer modeller som BERT att fortsätta spela en central roll i att förbättra AI-system och öppna upp nya möjligheter för deras användning.

📣 Liknande ämnen

- 📚 Introduktion till BERT: Den banbrytande NLP-modellen

- 🔍 BERT och rollen av dubbelriktadhet i NLP

- 🧠 Transformermodellen: Grunden för BERT

- 🚀 Maskerad språkmodellering: BERTs nyckel till framgång

- 📈 BERT-anpassning: Från förberedande träning till finjustering

- 🌐 BERT:s tillämpningsområden inom modern teknik

- 🤖 BERTs inflytande på framtiden för artificiell intelligens

- 💡 Framtidsutsikter: Vidareutveckling av BERT

- 🏆 BERT som en milstolpe inom AI-utveckling

- 📰 Författarna till Transformer-artikeln ”Uppmärksamhet är allt du behöver”: Hjärnorna bakom BERT

#️⃣ Hashtaggar: #NLP #ArtificiellIntelligens #Språkmodellering #Transformer #Maskininlärning

🎯🎯🎯 Dra nytta av Xpert.Digitals omfattande, femfaldiga expertis i ett heltäckande tjänstepaket | BD, R&D, XR, PR och optimering av digital synlighet

Dra nytta av Xpert.Digitals omfattande, femfaldiga expertis i ett heltäckande tjänstepaket | FoU, XR, PR och optimering av digital synlighet - Bild: Xpert.Digital

Xpert.Digital har djup kunskap i olika branscher. Detta gör att vi kan utveckla skräddarsydda strategier som är anpassade efter kraven och utmaningarna för ditt specifika marknadssegment. Genom att kontinuerligt analysera marknadstrender och bedriva branschutveckling kan vi agera med framsyn och erbjuda innovativa lösningar. Med kombinationen av erfarenhet och kunskap genererar vi mervärde och ger våra kunder en avgörande konkurrensfördel.

Mer om detta här:

BERT: Revolutionerande 🌟 NLP-teknik

🚀 BERT, förkortning för Bidirectional Encoder Representations from Transformers, är en avancerad språkmodell utvecklad av Google som har blivit ett betydande genombrott inom naturlig språkbehandling (NLP) sedan introduktionen 2018. Den är baserad på Transformer-arkitekturen, som revolutionerade hur maskiner förstår och bearbetar text. Men vad gör BERT så speciellt, och vad används det till? För att besvara denna fråga måste vi titta närmare på BERTs tekniska grunder, hur det fungerar och dess tillämpningar.

📚 1. Grunderna i naturlig språkbehandling

För att fullt ut förstå betydelsen av BERT är det bra att kortfattat gå igenom grunderna i naturlig språkbehandling (NLP). NLP handlar om interaktionen mellan datorer och mänskligt språk. Dess mål är att lära maskiner att analysera, förstå och reagera på textdata. Innan modeller som BERT introducerades var maskinell språkbehandling ofta behäftad med betydande utmaningar, särskilt på grund av tvetydigheten, kontextberoendet och den komplexa strukturen hos mänskligt språk.

📈 2. Utvecklingen av NLP-modeller

Innan BERT uppstod baserades de flesta NLP-modeller på så kallade unidirektionella arkitekturer. Detta innebar att dessa modeller läste text antingen från vänster till höger eller från höger till vänster, vilket innebar att de bara kunde ta hänsyn till en begränsad mängd kontext när de bearbetade ett ord i en mening. Denna begränsning resulterade ofta i att modellerna inte helt fångade meningens semantiska kontext. Detta gjorde den korrekta tolkningen av tvetydiga eller kontextkänsliga ord svår.

En annan viktig utveckling inom NLP-forskningen före BERT var word2vec-modellen, som gjorde det möjligt för datorer att översätta ord till vektorer som återspeglade semantiska likheter. Men även här var kontexten begränsad till ordets omedelbara omgivning. Senare utvecklades modeller för återkommande neurala nätverk (RNN) och i synnerhet modeller för långt korttidsminne (LSTM), vilket gjorde det möjligt att bättre förstå textsekvenser genom att lagra information över flera ord. Dessa modeller hade dock också sina begränsningar, särskilt när man hanterade långa texter och samtidigt förstådde kontext i båda riktningarna.

🔄 3. Revolutionen genom transformatorarkitektur

Genombrottet kom med introduktionen av Transformer-arkitekturen år 2017, som utgör grunden för BERT. Transformer-modeller är utformade för att möjliggöra parallell textbehandling, med hänsyn till ett ords sammanhang från både föregående och efterföljande text. Detta uppnås genom så kallade självuppmärksamhetmekanismer, som tilldelar ett viktvärde till varje ord i en mening baserat på dess betydelse i förhållande till de andra orden i meningen.

Till skillnad från tidigare metoder är transformatormodeller inte enkelriktade utan dubbelriktade. Det betyder att de kan hämta information från både vänster och höger kontext av ett ord för att skapa en mer fullständig och korrekt representation av ordet och dess betydelse.

🧠 4. BERT: En dubbelriktad modell

BERT tar prestandan hos Transformer-arkitekturen till en ny nivå. Modellen är utformad för att fånga ett ords sammanhang, inte bara från vänster till höger eller höger till vänster, utan i båda riktningarna samtidigt. Detta gör det möjligt för BERT att beakta hela sammanhanget för ett ord i en mening, vilket resulterar i avsevärt förbättrad noggrannhet i språkbearbetningsuppgifter.

En viktig funktion i BERT är dess användning av den så kallade Masked Language Model (MLM). Under BERT-träning ersätts slumpmässigt utvalda ord i en mening med en mask, och modellen tränas att gissa dessa maskerade ord baserat på sammanhanget. Denna teknik gör det möjligt för BERT att lära sig djupare och mer exakta relationer mellan orden i en mening.

Dessutom använder BERT en metod som kallas Next Sentence Prediction (NSP), där modellen lär sig att förutsäga om en mening följer på en annan. Detta förbättrar BERTs förmåga att förstå längre texter och känna igen mer komplexa samband mellan meningar.

🌐 5. Praktisk tillämpning av BERT

BERT har visat sig vara extremt användbart för en mängd olika NLP-uppgifter. Här är några av de viktigaste tillämpningsområdena:

📊 a) Textklassificering

En av de vanligaste tillämpningarna av BERT är textklassificering, där texter delas in i fördefinierade kategorier. Exempel inkluderar sentimentanalys (t.ex. att identifiera om en text är positiv eller negativ) eller kategorisering av kundfeedback. Tack vare sin djupa förståelse av ordens sammanhang kan BERT leverera mer exakta resultat än tidigare modeller.

❓ b) Fråge-svar-system

BERT används också i frågesvarssystem, där modellen extraherar svar på ställda frågor från en text. Denna funktion är särskilt viktig i applikationer som sökmotorer, chatbotar och virtuella assistenter. Tack vare sin dubbelriktade arkitektur kan BERT extrahera relevant information från en text även om frågan är formulerad indirekt.

🌍 c) Textöversättning

Även om BERT i sig inte är direkt utformat som en översättningsmodell, kan det användas i kombination med andra tekniker för att förbättra maskinöversättning. Genom att bättre förstå de semantiska relationerna inom en mening kan BERT bidra till att generera mer exakta översättningar, särskilt med tvetydig eller komplex frasering.

🏷️ d) Identifiering av namngiven enhet (NER)

Ett annat tillämpningsområde är namngiven entitetsigenkänning (NER), vilket innebär att identifiera specifika entiteter såsom namn, platser eller organisationer i en text. BERT har visat sig särskilt effektivt i denna uppgift eftersom det fullt ut tar hänsyn till en menings sammanhang och därmed bättre kan känna igen entiteter, även om de har olika betydelser i olika sammanhang.

✂️ e) Textsammanfattning

BERTs förmåga att förstå hela sammanhanget i en text gör det också till ett kraftfullt verktyg för automatisk textsammanfattning. Det kan användas för att extrahera den viktigaste informationen från en lång text och skapa en koncis sammanfattning.

🌟 6. BERT:s betydelse för forskning och industri

Introduktionen av BERT inledde en ny era inom NLP-forskning. Det var en av de första modellerna som fullt ut utnyttjade kraften i den dubbelriktade transformatorarkitekturen och satte standarden för många efterföljande modeller. Många företag och forskningsinstitutioner har integrerat BERT i sina NLP-pipelines för att förbättra prestandan hos sina applikationer.

Dessutom banade BERT väg för ytterligare innovationer inom språkmodeller. Till exempel utvecklades modeller som GPT (Generative Pretrained Transformer) och T5 (Text-to-Text Transfer Transformer) senare, vilka bygger på liknande principer men erbjuder specifika förbättringar för olika användningsfall.

🚧 7. Utmaningar och begränsningar med BERT

Trots sina många fördelar har BERT också vissa utmaningar och begränsningar. Ett av de största hindren är den höga beräkningskraft som krävs för att träna och tillämpa modellen. Eftersom BERT är en mycket stor modell med miljontals parametrar kräver den kraftfull hårdvara och betydande datorresurser, särskilt vid bearbetning av stora datamängder.

Ett annat problem är den potentiella bias som kan finnas i träningsdata. Eftersom BERT tränas på stora mängder textdata, återspeglar det ibland de fördomar och stereotyper som finns i dessa data. Forskare arbetar dock kontinuerligt med att identifiera och åtgärda dessa problem.

🔍 Ett oumbärligt verktyg för moderna talbehandlingsapplikationer

BERT har avsevärt förbättrat hur maskiner förstår mänskligt språk. Med sin dubbelriktade arkitektur och innovativa träningsmetoder kan den förstå ordens sammanhang i en mening på djupet och noggrant, vilket leder till större precision i många NLP-uppgifter. Oavsett om det gäller textklassificering, frågesvarssystem eller entitetsigenkänning har BERT etablerat sig som ett oumbärligt verktyg för moderna applikationer för naturlig språkbehandling.

Forskningen inom området naturlig språkbehandling kommer utan tvekan att fortsätta att gå framåt, och BERT har lagt grunden för många framtida innovationer. Trots de befintliga utmaningarna och begränsningarna visar BERT imponerande hur långt tekniken har kommit på kort tid och vilka spännande möjligheter som fortfarande kommer att öppnas upp i framtiden.

🌀 Transformatorn: En revolution inom naturlig språkbehandling

🌟 Under senare år har en av de viktigaste utvecklingarna inom naturlig språkbehandling (NLP) varit introduktionen av Transformer-modellen, som beskrivs i artikeln "Attention Is All You Need" från 2017. Denna modell förändrade fundamentalt området genom att slopa de tidigare använda återkommande eller faltningsstrukturerna för sekvenstransduktionsuppgifter, såsom maskinöversättning. Istället förlitar den sig uteslutande på uppmärksamhetsmekanismer. Transformer-designen har sedan dess legat till grund för många modeller som representerar den senaste tekniken inom olika områden, inklusive talgenerering, översättning och mer därtill.

🔄 Transformatorn: Ett paradigmskifte

Innan transformatorn introducerades baserades de flesta modeller för sekvensuppgifter på återkommande neurala nätverk (RNN) eller långa korttidsminnesnätverk (LSTM), vilka i sig fungerar sekventiellt. Dessa modeller bearbetar indata steg för steg och skapar dolda tillstånd som sprids längs sekvensen. Även om denna metod är effektiv är den beräkningsmässigt dyr och svår att parallellisera, särskilt för långa sekvenser. Dessutom kämpar RNN med att lära sig långsiktiga beroenden på grund av problemet med försvinnande gradienter.

Transformerns viktigaste innovation ligger i dess användning av självuppmärksamhetmekanismer, vilket gör det möjligt för modellen att väga vikten av olika ord i en mening i förhållande till varandra, oavsett deras position. Detta gör det möjligt för modellen att fånga relationer mellan vitt separerade ord mer effektivt än RNN:er eller LSTM:er, och att göra det parallellt snarare än sekventiellt. Detta förbättrar inte bara träningseffektiviteten utan även prestandan i uppgifter som maskinöversättning.

🧩 Modellarkitektur

Transformatorn består av två huvudkomponenter: en kodare och en avkodare, vilka båda är uppbyggda av flera lager och i hög grad förlitar sig på uppmärksamhetsmekanismer med flera huvuden.

⚙️ Kodare

Kodaren består av sex identiska lager, vart och ett med två underlager:

1. Flerhuvuds självuppmärksamhet

Denna mekanism gör det möjligt för modellen att fokusera på olika delar av den inmatade meningen när varje ord bearbetas. Istället för att beräkna uppmärksamhet i ett enda utrymme, projicerar multihead-uppmärksamhet inmatningen till flera olika utrymmen, och fångar därmed upp olika typer av relationer mellan ord.

2. Positionsmässigt helt anslutna framåtkopplade nätverk

Efter uppmärksamhetslagret appliceras ett helt sammankopplat feedforward-nätverk oberoende av varandra vid varje position. Detta hjälper modellen att bearbeta varje ord i sitt sammanhang och utnyttja informationen från uppmärksamhetsmekanismen.

För att bevara strukturen i inmatningssekvensen inkluderar modellen även positionskodningar. Eftersom transformatorn inte bearbetar orden sekventiellt är dessa kodningar avgörande för att förse modellen med information om ordföljden i en mening. Positionskodningarna läggs till i ordinbäddningarna så att modellen kan skilja mellan de olika positionerna i sekvensen.

🔍 Avkodare

Liksom kodaren består avkodaren av sex lager, vart och ett med en extra uppmärksamhetsmekanism som gör att modellen kan fokusera på relevanta delar av ingångssekvensen samtidigt som den genererar utdata. Avkodaren använder också en maskeringsteknik för att förhindra att den tar hänsyn till framtida positioner, vilket bevarar sekvensgenereringens autoregressiva natur.

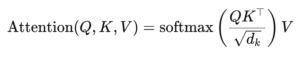

🧠 Flerhuvudsuppmärksamhet och skalär produktuppmärksamhet

Kärnan i Transformer är uppmärksamhetsmekanismen med flera huvuden, som är en utvidgning av den enklare skalära produktuppmärksamhet. Uppmärksamhetfunktionen kan ses som en mappning mellan en fråga och en uppsättning nyckel-värde-par, där varje nyckel representerar ett ord i sekvensen och värdet representerar motsvarande kontextuell information.

Flerhuvudsuppmärksamhetmekanismen gör att modellen kan fokusera på olika delar av sekvensen samtidigt. Genom att projicera inmatningen i flera delrymder kan modellen fånga en rikare uppsättning relationer mellan ord. Detta är särskilt användbart för uppgifter som maskinöversättning, där förståelsen av ett ords sammanhang kräver många olika faktorer, såsom syntaktisk struktur och semantisk betydelse.

Formeln för skalär produktuppmärksamhet är:

Här är (Q) frågematrisen, (K) nyckelmatrisen och (V) värdematrisen. Termen (sqrt{d_k}) är en skalningsfaktor som förhindrar att skalärprodukterna blir för stora, vilket skulle leda till mycket små gradienter och långsammare inlärning. Softmax-funktionen används för att säkerställa att uppmärksamhetsvikterna summerar till ett.

🚀 Fördelar med transformatorn

Transformern erbjuder flera avgörande fördelar jämfört med traditionella modeller som RNN och LSTM:er:

1. Parallellisering

Eftersom transformatorn bearbetar alla tokens i en sekvens samtidigt kan den parallelliseras i hög grad och är därför mycket snabbare att träna än RNN:er eller LSTM:er, särskilt med stora datamängder.

2. Långvariga beroenden

Självuppmärksamhetmekanismen gör det möjligt för modellen att fånga relationer mellan avlägsna ord mer effektivt än RNN:er, vilka begränsas av den sekventiella naturen hos deras beräkningar.

3. Skalbarhet

Transformatorn kan enkelt skalas till mycket stora datamängder och längre sekvenser utan att drabbas av de prestandaflaskhalsar som är förknippade med RNN:er.

🌍 Applikationer och effekter

Sedan introduktionen har Transformer blivit grunden för en mängd olika NLP-modeller. Ett av de mest anmärkningsvärda exemplen är BERT (Bidirectional Encoder Representations from Transformers), som använder en modifierad Transformer-arkitektur för att uppnå toppmodern prestanda i många NLP-uppgifter, inklusive frågebesvarande och textklassificering.

En annan betydande utveckling är GPT (Generative Pretrained Transformer), som använder en avkodarbegränsad version av transformatorn för textgenerering. GPT-modeller, inklusive GPT-3, används nu för ett flertal tillämpningar, från innehållsskapande till kodkomplettering.

🔍 En kraftfull och flexibel modell

Transformer har fundamentalt förändrat hur vi närmar oss NLP-uppgifter. Den erbjuder en kraftfull och flexibel modell som kan tillämpas på en mängd olika problem. Dess förmåga att hantera långsiktiga beroenden och dess effektivitet i träning har gjort den till den föredragna arkitekturmetoden för många av de modernaste modellerna. Allt eftersom forskningen fortskrider kommer vi sannolikt att se ytterligare förbättringar och anpassningar av Transformer, särskilt inom områden som bild- och talbehandling, där uppmärksamhetsmekanismer visar lovande resultat.

Vi är där för dig - Råd - Planering - Implementering - Projektledning

☑ Branschekspert, här med sitt eget Xpert.Digital Industrial Hub på över 2500 specialbidrag

Jag hjälper dig gärna som personlig konsult.

Du kan kontakta mig genom att fylla i kontaktformuläret nedan eller helt enkelt ringa mig på +49 89 674 804 (München) .

Jag ser fram emot vårt gemensamma projekt.

Xpert.Digital - Konrad Wolfenstein

Xpert.Digital är ett nav för bransch med fokus, digitalisering, maskinteknik, logistik/intralogistik och fotovoltaik.

Med vår 360 ° affärsutvecklingslösning stöder vi välkända företag från ny verksamhet till efter försäljning.

Marknadsintelligens, smarketing, marknadsföringsautomation, innehållsutveckling, PR, postkampanjer, personliga sociala medier och blyomsorg är en del av våra digitala verktyg.

Du kan hitta mer på: www.xpert.digital - www.xpert.solar - www.xpert.plus