AI и SEO с BERT — представления двунаправленного кодировщика от Transformers — модель в области обработки естественного языка (NLP)

Выбор голоса 📢

Опубликовано: 4 октября 2024 г. / Обновлено: 4 октября 2024 г. – Автор: Konrad Wolfenstein

AI и SEO с BERT – Представления двунаправленного кодировщика от Transformers – Модель в области обработки естественного языка (NLP) – Изображение: Xpert.Digital

🚀💬 Разработано Google: BERT и его важность для НЛП. Почему понимание двунаправленного текста имеет решающее значение

🔍🗣️ BERT, сокращение от «Представления двунаправленного кодировщика от Transformers», — это основная модель в области обработки естественного языка (NLP), разработанная Google. Он произвел революцию в том, как машины понимают язык. В отличие от предыдущих моделей, которые анализировали текст последовательно слева направо или наоборот, BERT обеспечивает двунаправленную обработку. Это означает, что он фиксирует контекст слова как из предыдущей, так и из последующей текстовой последовательности. Эта способность значительно улучшает понимание сложных языковых контекстов.

🔍Архитектура BERT

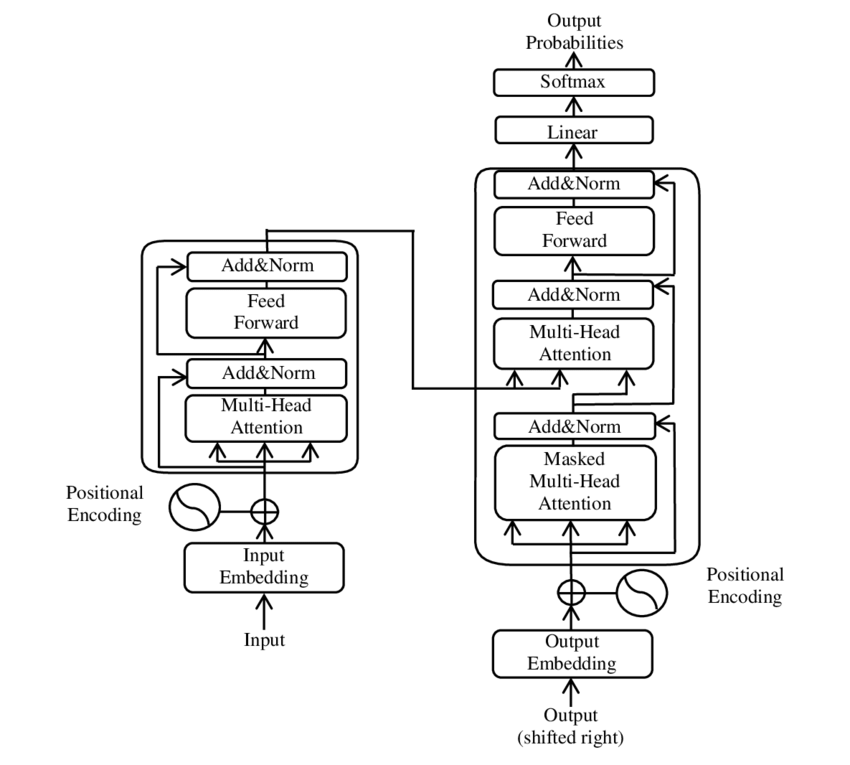

За последние годы одно из наиболее значительных событий в области обработки естественного языка (НЛП) произошло с появлением модели Трансформера, представленной в PDF 2017 — Внимание — это все, что вам нужно — бумага ( Википедия ). Эта модель фундаментально изменила эту область, отказавшись от ранее использовавшихся структур, таких как машинный перевод. Вместо этого он полагается исключительно на механизмы внимания. С тех пор конструкция Трансформера легла в основу многих моделей, которые представляют собой новейшие достижения в различных областях, таких как генерация языка, перевод и другие.

BERT основан на этой архитектуре Transformer. Эта архитектура использует так называемые механизмы самообслуживания для анализа отношений между словами в предложении. Внимание уделяется каждому слову в контексте всего предложения, что приводит к более точному пониманию синтаксических и смысловых связей.

Авторы статьи «Внимание - это все, что вам нужно», это:

- Ашиш Васвани (Google Brain)

- Ноам Шазир (Google Brain)

- Ники Пармар (Google Research)

- Якоб Ушкорейт (Google Research)

- Лайон Джонс (Исследование Google)

- Эйдан Н. Гомес (Университет Торонто, работа частично выполнена в Google Brain)

- Лукаш Кайзер (Google Brain)

- Илья Полосухин (независимый, ранее работал в Google Research)

Эти авторы внесли значительный вклад в разработку модели Трансформатора, представленной в этой статье.

🔄 Двунаправленная обработка

Отличительной особенностью BERT является возможность двунаправленной обработки. В то время как традиционные модели, такие как рекуррентные нейронные сети (RNN) или сети долгосрочной краткосрочной памяти (LSTM), обрабатывают текст только в одном направлении, BERT анализирует контекст слова в обоих направлениях. Это позволяет модели лучше улавливать тонкие смысловые нюансы и, следовательно, делать более точные прогнозы.

🕵️♂️ Моделирование языка в масках

Еще одним инновационным аспектом BERT является метод модели языка в маске (MLM). Он включает в себя маскирование случайно выбранных слов в предложении и обучение модели прогнозированию этих слов на основе окружающего контекста. Этот метод заставляет BERT развивать глубокое понимание контекста и значения каждого слова в предложении.

🚀 Обучение и настройка BERT

BERT проходит двухэтапный процесс обучения: предварительное обучение и тонкая настройка.

📚Предварительная тренировка

На этапе предварительного обучения BERT обучается на больших объемах текста для изучения общих языковых шаблонов. Сюда входят тексты Википедии и другие обширные текстовые корпуса. На этом этапе модель изучает основные лингвистические структуры и контексты.

🔧 Тонкая настройка

После предварительного обучения BERT настраивается для конкретных задач НЛП, таких как классификация текста или анализ настроений. Модель обучается на небольших наборах данных, связанных с задачами, чтобы оптимизировать ее производительность для конкретных приложений.

🌍 Области применения BERT

BERT оказался чрезвычайно полезным во многих областях обработки естественного языка:

Поисковая оптимизация

Google использует BERT, чтобы лучше понимать поисковые запросы и показывать более релевантные результаты. Это значительно улучшает пользовательский опыт.

Классификация текста

BERT может классифицировать документы по темам или анализировать настроение текстов.

Распознавание именованных объектов (NER)

Модель идентифицирует и классифицирует именованные сущности в текстах, например, личные названия, названия мест или организаций.

Системы вопросов и ответов

BERT используется для предоставления точных ответов на задаваемые вопросы.

🧠 Важность BERT для будущего искусственного интеллекта

BERT установил новые стандарты для моделей НЛП и проложил путь для дальнейших инноваций. Благодаря возможностям двунаправленной обработки и глубокому пониманию языкового контекста он значительно повысил эффективность и точность приложений ИИ.

🔜 Будущие разработки

Дальнейшее развитие BERT и подобных моделей, вероятно, будет направлено на создание еще более мощных систем. Они могут решать более сложные языковые задачи и использоваться во множестве новых областей применения. Интеграция таких моделей в повседневные технологии может фундаментально изменить способ нашего взаимодействия с компьютерами.

🌟 Веха в развитии искусственного интеллекта

BERT является важной вехой в развитии искусственного интеллекта и произвел революцию в том, как машины обрабатывают естественный язык. Его двунаправленная архитектура обеспечивает более глубокое понимание языковых отношений, что делает его незаменимым для различных приложений. По мере развития исследований такие модели, как BERT, будут продолжать играть центральную роль в совершенствовании систем искусственного интеллекта и открытии новых возможностей для их использования.

📣 Похожие темы

- 📚 Представляем BERT: революционную модель НЛП

- 🔍 BERT и роль двунаправленности в НЛП

- 🧠 Модель Трансформера: краеугольный камень BERT

- 🚀 Моделирование языка в масках: ключ к успеху BERT

- 📈 Настройка BERT: от предварительного обучения до тонкой настройки

- 🌐 Области применения BERT в современных технологиях

- 🤖 Влияние BERT на будущее искусственного интеллекта

- 💡 Перспективы на будущее: дальнейшее развитие BERT

- 🏆 BERT как веха в развитии ИИ

- 📰 Авторы статьи Transformer «Внимание — это все, что вам нужно»: умы, стоящие за BERT

#️⃣ Хэштеги: #НЛП #Искусственный интеллект #Моделирование языка #Трансформатор #Машинное обучение

🎯🎯🎯 Воспользуйтесь преимуществами обширного пятистороннего опыта Xpert.Digital в комплексном пакете услуг | BD, R&D, XR, PR и оптимизация цифровой видимости

Воспользуйтесь преимуществами обширного пятистороннего опыта Xpert.Digital в комплексном пакете услуг | НИОКР, XR, PR и оптимизация цифровой видимости — Изображение: Xpert.Digital

Xpert.Digital обладает глубокими знаниями различных отраслей. Это позволяет нам разрабатывать индивидуальные стратегии, которые точно соответствуют требованиям и задачам вашего конкретного сегмента рынка. Постоянно анализируя тенденции рынка и следя за развитием отрасли, мы можем действовать дальновидно и предлагать инновационные решения. Благодаря сочетанию опыта и знаний мы создаем добавленную стоимость и даем нашим клиентам решающее конкурентное преимущество.

Подробнее об этом здесь:

БЕРТ: Революционная 🌟 технология НЛП.

🚀 BERT, сокращение от «Представления двунаправленного кодировщика от Transformers», представляет собой усовершенствованную языковую модель, разработанную Google, которая стала значительным прорывом в области обработки естественного языка (NLP) с момента ее запуска в 2018 году. Он основан на архитектуре Transformer, которая произвела революцию в том, как машины понимают и обрабатывают текст. Но что именно делает BERT таким особенным и для чего именно он используется? Чтобы ответить на этот вопрос, нам необходимо углубиться в технические принципы, функциональность и области применения BERT.

📚 1. Основы обработки естественного языка.

Чтобы полностью понять значение BERT, полезно кратко рассмотреть основы обработки естественного языка (NLP). НЛП занимается взаимодействием компьютеров и человеческого языка. Цель — научить машины анализировать, понимать текстовые данные и реагировать на них. До появления таких моделей, как BERT, машинная обработка языка часто представляла собой серьезные проблемы, особенно из-за двусмысленности, зависимости от контекста и сложной структуры человеческого языка.

📈 2. Разработка моделей НЛП

До появления BERT большинство моделей НЛП основывались на так называемых однонаправленных архитектурах. Это означает, что эти модели читают текст только слева направо или справа налево, а это означает, что они могут учитывать только ограниченное количество контекста при обработке слова в предложении. Это ограничение часто приводило к тому, что модели не полностью отражали полный семантический контекст предложения. Это затрудняло точную интерпретацию неоднозначных или контекстно-зависимых слов.

Еще одним важным достижением в исследованиях НЛП до BERT была модель word2vec, которая позволяла компьютерам переводить слова в векторы, отражающие семантическое сходство. Но и здесь контекст ограничивался непосредственным окружением слова. Позже были разработаны модели рекуррентных нейронных сетей (RNN) и, в частности, модели долгосрочной краткосрочной памяти (LSTM), которые позволили лучше понимать текстовые последовательности за счет хранения информации в нескольких словах. Однако эти модели также имели свои ограничения, особенно при работе с длинными текстами и понимании контекста в обоих направлениях одновременно.

🔄 3. Революция через архитектуру Transformer

Прорыв произошел с появлением в 2017 году архитектуры Transformer, которая составляет основу BERT. Модели-трансформеры предназначены для обеспечения параллельной обработки текста с учетом контекста слова как из предыдущего, так и из последующего текста. Это делается с помощью так называемых механизмов самообслуживания, которые присваивают весовое значение каждому слову в предложении в зависимости от того, насколько оно важно по отношению к другим словам в предложении.

В отличие от предыдущих подходов, модели Трансформера являются не однонаправленными, а двунаправленными. Это означает, что они могут извлекать информацию как из левого, так и из правого контекста слова, создавая более полное и точное представление слова и его значения.

🧠 4. BERT: двунаправленная модель.

BERT выводит производительность архитектуры Transformer на новый уровень. Модель предназначена для захвата контекста слова не только слева направо или справа налево, но и в обоих направлениях одновременно. Это позволяет BERT учитывать полный контекст слова в предложении, что значительно повышает точность выполнения задач языковой обработки.

Центральной особенностью BERT является использование так называемой модели языка в маске (MLM). При обучении BERT случайно выбранные слова в предложении заменяются маской, и модель обучается угадывать эти замаскированные слова на основе контекста. Этот метод позволяет BERT изучить более глубокие и точные связи между словами в предложении.

Кроме того, BERT использует метод под названием «Прогнозирование следующего предложения» (NSP), где модель учится предсказывать, следует ли одно предложение за другим или нет. Это улучшает способность BERT понимать более длинные тексты и распознавать более сложные связи между предложениями.

🌐 5. Применение BERT на практике

BERT оказался чрезвычайно полезным для множества задач НЛП. Вот некоторые из основных областей применения:

📊 а) Классификация текста

Одним из наиболее распространенных применений BERT является классификация текста, при которой тексты делятся на заранее определенные категории. Примеры этого включают анализ настроений (например, определение того, является ли текст положительным или отрицательным) или категоризацию отзывов клиентов. BERT может предоставить более точные результаты, чем предыдущие модели, благодаря глубокому пониманию контекста слов.

❓б) Вопросно-ответные системы

BERT также используется в вопросно-ответных системах, где модель извлекает из текста ответы на поставленные вопросы. Эта возможность особенно важна в таких приложениях, как поисковые системы, чат-боты или виртуальные помощники. Благодаря своей двунаправленной архитектуре BERT может извлекать соответствующую информацию из текста, даже если вопрос сформулирован косвенно.

🌍 в) Перевод текста

Хотя сам BERT не предназначен непосредственно для модели перевода, его можно использовать в сочетании с другими технологиями для улучшения машинного перевода. Лучше понимая семантические отношения в предложении, BERT может помочь обеспечить более точные переводы, особенно для двусмысленных или сложных формулировок.

🏷️ г) Распознавание именованных объектов (NER)

Другая область применения — распознавание именованных объектов (NER), которое включает в себя идентификацию конкретных объектов, таких как имена, места или организации, в тексте. BERT оказался особенно эффективным в этой задаче, поскольку он полностью учитывает контекст предложения, улучшая распознавание объектов, даже если они имеют разное значение в разных контекстах.

✂️ д) Текстовое резюме

Способность BERT понимать весь контекст текста также делает его мощным инструментом для автоматического обобщения текста. Его можно использовать для извлечения наиболее важной информации из длинного текста и создания краткого резюме.

🌟 6. Важность BERT для исследований и промышленности.

Появление BERT открыло новую эру в исследованиях НЛП. Это была одна из первых моделей, которая в полной мере воспользовалась мощью двунаправленной архитектуры Transformer, установив планку для многих последующих моделей. Многие компании и исследовательские институты интегрировали BERT в свои конвейеры NLP, чтобы повысить производительность своих приложений.

Кроме того, BERT проложил путь для дальнейших инноваций в области языковых моделей. Например, впоследствии были разработаны такие модели, как GPT (генеративный предварительно обученный преобразователь) и T5 (трансформатор преобразования текста в текст), которые основаны на аналогичных принципах, но предлагают конкретные улучшения для разных вариантов использования.

🚧 7. Проблемы и ограничения BERT

Несмотря на свои многочисленные преимущества, BERT также имеет некоторые проблемы и ограничения. Одним из самых больших препятствий являются большие вычислительные усилия, необходимые для обучения и применения модели. Поскольку BERT — это очень большая модель с миллионами параметров, она требует мощного оборудования и значительных вычислительных ресурсов, особенно при обработке больших объемов данных.

Другая проблема — потенциальная погрешность, которая может существовать в обучающих данных. Поскольку BERT обучается на больших объемах текстовых данных, он иногда отражает предвзятости и стереотипы, присутствующие в этих данных. Однако исследователи постоянно работают над выявлением и решением этих проблем.

🔍 Незаменимый инструмент для современных приложений обработки языка

BERT значительно улучшил понимание машинами человеческого языка. Благодаря своей двунаправленной архитектуре и инновационным методам обучения он способен глубоко и точно улавливать контекст слов в предложении, что приводит к более высокой точности во многих задачах НЛП. Будь то классификация текста, системы вопросов-ответов или распознавание объектов — BERT зарекомендовал себя как незаменимый инструмент для современных приложений обработки языка.

Исследования в области обработки естественного языка, несомненно, будут продолжать развиваться, и BERT заложил основу для многих будущих инноваций. Несмотря на существующие проблемы и ограничения, BERT впечатляюще показывает, насколько далеко продвинулась технология за короткое время и какие захватывающие возможности еще откроются в будущем.

🌀 Трансформатор: революция в обработке естественного языка

🌟 В последние годы одним из наиболее значительных достижений в области обработки естественного языка (НЛП) стало внедрение модели трансформера, описанной в статье 2017 года «Внимание — это все, что вам нужно». Эта модель фундаментально изменила эту область, отказавшись от ранее использовавшихся рекуррентных или сверточных структур для задач преобразования последовательностей, таких как машинный перевод. Вместо этого он полагается исключительно на механизмы внимания. С тех пор конструкция Трансформера легла в основу многих моделей, которые представляют собой новейшие достижения в различных областях, таких как генерация языка, перевод и другие.

🔄 Трансформер: смена парадигмы

До появления Transformer большинство моделей для задач секвенирования были основаны на рекуррентных нейронных сетях (RNN) или сетях длинной краткосрочной памяти (LSTM), которые по своей сути являются последовательными. Эти модели шаг за шагом обрабатывают входные данные, создавая скрытые состояния, которые распространяются по последовательности. Хотя этот метод эффективен, он требует больших вычислительных затрат и его трудно распараллеливать, особенно для длинных последовательностей. Кроме того, RNN испытывают трудности с изучением долгосрочных зависимостей из-за так называемой проблемы «исчезающего градиента».

Центральное нововведение Transformer заключается в использовании механизмов самообслуживания, которые позволяют модели взвешивать важность разных слов в предложении относительно друг друга, независимо от их положения. Это позволяет модели более эффективно улавливать отношения между широко расположенными словами, чем RNN или LSTM, и делать это параллельно, а не последовательно. Это не только повышает эффективность обучения, но и производительность при выполнении таких задач, как машинный перевод.

🧩 Архитектура модели

Трансформатор состоит из двух основных компонентов: кодера и декодера, оба из которых состоят из нескольких слоев и в значительной степени полагаются на механизмы внимания с несколькими головками.

⚙️ Кодировщик

Кодер состоит из шести одинаковых слоев, каждый из которых имеет два подслоя:

1. Многоголовое внимание к себе

Этот механизм позволяет модели сосредоточиться на различных частях входного предложения при обработке каждого слова. Вместо того, чтобы обрабатывать внимание в одном пространстве, внимание нескольких голов проецирует входные данные в несколько разных пространств, позволяя фиксировать различные типы отношений между словами.

2. Позиционно полностью связанные сети прямого распространения.

После уровня внимания в каждой позиции независимо применяется полностью подключенная сеть прямой связи. Это помогает модели обрабатывать каждое слово в контексте и использовать информацию от механизма внимания.

Чтобы сохранить структуру входной последовательности, модель также содержит позиционные входы (позиционные кодировки). Поскольку Transformer не обрабатывает слова последовательно, эти кодировки имеют решающее значение для предоставления модели информации о порядке слов в предложении. Входные данные позиции добавляются к встраиваниям слов, чтобы модель могла различать разные позиции в последовательности.

🔍 Декодеры

Как и кодер, декодер также состоит из шести слоев, каждый из которых имеет дополнительный механизм внимания, который позволяет модели сосредоточиться на соответствующих частях входной последовательности при генерации выходных данных. Декодер также использует технику маскировки, чтобы предотвратить рассмотрение будущих позиций, сохраняя авторегрессионный характер генерации последовательностей.

🧠 Внимание нескольких голов и внимание точечного произведения

Сердцем Трансформера является механизм Multi-Head Attention, который является расширением более простого скалярного произведения внимания. Функцию внимания можно рассматривать как отображение между запросом и набором пар ключ-значение (ключи и значения), где каждый ключ представляет слово в последовательности, а значение представляет связанную с ним контекстную информацию.

Механизм внимания с несколькими головами позволяет модели одновременно концентрироваться на разных частях последовательности. Проецируя входные данные на несколько подпространств, модель может отразить более богатый набор отношений между словами. Это особенно полезно в таких задачах, как машинный перевод, где для понимания контекста слова требуется множество различных факторов, таких как синтаксическая структура и семантическое значение.

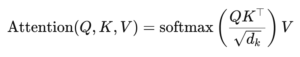

Формула внимания скалярного произведения такова:

Здесь (Q) — матрица запроса, (K) — матрица ключей и (V) — матрица значений. Термин (sqrt{d_k}) — это коэффициент масштабирования, который не позволяет скалярным произведениям становиться слишком большими, что могло бы привести к очень маленьким градиентам и замедлению обучения. Функция softmax применяется для обеспечения того, чтобы сумма весов внимания равнялась единице.

🚀 Преимущества трансформера

Трансформатор предлагает несколько ключевых преимуществ по сравнению с традиционными моделями, такими как RNN и LSTM:

1. Распараллеливание

Поскольку Transformer обрабатывает все токены в последовательности одновременно, он может быть высоко распараллелен и, следовательно, обучается гораздо быстрее, чем RNN или LSTM, особенно на больших наборах данных.

2. Долгосрочные зависимости

Механизм самообслуживания позволяет модели более эффективно улавливать отношения между удаленными словами, чем RNN, которые ограничены последовательным характером своих вычислений.

3. Масштабируемость

Transformer может легко масштабироваться до очень больших наборов данных и более длинных последовательностей, не испытывая при этом узких мест в производительности, связанных с RNN.

🌍 Приложения и эффекты

С момента своего появления Трансформер стал основой для широкого спектра моделей НЛП. Одним из наиболее ярких примеров является BERT (представления двунаправленного кодировщика от Transformers), который использует модифицированную архитектуру Transformer для достижения современного уровня во многих задачах НЛП, включая ответы на вопросы и классификацию текста.

Еще одной важной разработкой является GPT (Генераторный предварительно обученный преобразователь), который использует версию Transformer с ограниченными возможностями декодера для генерации текста. Модели GPT, включая GPT-3, теперь используются для множества приложений, от создания контента до завершения кода.

🔍 Мощная и гибкая модель

Трансформер фундаментально изменил наш подход к задачам НЛП. Он предоставляет мощную и гибкую модель, которую можно применять для решения самых разных задач. Его способность обрабатывать долгосрочные зависимости и эффективность обучения сделали его предпочтительным архитектурным подходом для многих самых современных моделей. По мере продвижения исследований мы, вероятно, увидим дальнейшие улучшения и корректировки Трансформера, особенно в таких областях, как обработка изображений и языка, где механизмы внимания показывают многообещающие результаты.

Мы здесь для вас - советы - планирование - реализация - управление проектами

☑️ Отраслевой эксперт со своим собственным отраслевым центром Xpert.Digital с более чем 2500 специальными статьями.

Буду рад стать вашим личным консультантом.

Вы можете связаться со мной, заполнив контактную форму ниже, или просто позвонить мне по телефону +49 89 89 674 804 (Мюнхен) .

Я с нетерпением жду нашего совместного проекта.

Xpert.Digital - Konrad Wolfenstein

Xpert.Digital — это промышленный центр с упором на цифровизацию, машиностроение, логистику/внутреннюю логистику и фотоэлектрическую энергетику.

С помощью нашего решения для развития бизнеса на 360° мы поддерживаем известные компании, начиная с нового бизнеса и заканчивая послепродажным обслуживанием.

Аналитика рынка, маркетинг, автоматизация маркетинга, разработка контента, PR, почтовые кампании, персонализированные социальные сети и привлечение потенциальных клиентов являются частью наших цифровых инструментов.

Дополнительную информацию можно узнать на сайте: www.xpert.digital - www.xpert.solar - www.xpert.plus