Trasa z przewodnikiem w transformacji AI: raport warsztatowy dla specjalistów i menedżerów

Przedpremierowe wydanie Xperta

Wybór głosu 📢

Opublikowano: 10 maja 2025 / Aktualizacja od: 10 maja 2025 r. - Autor: Konrad Wolfenstein

Trasa z przewodnikiem w AI Transformation: Raport warsztatowy dla specjalistów i menedżerów-Image: xpert.digital

Co menedżerowie powinni teraz wiedzieć z AI: Skorzystaj z okazji, zarządzaj ryzykiem, wiarygodnie (czas czytania: 32 min / bez reklamy / Brak Paywall)

Master the AI Revolution: Wprowadzenie do menedżerów

Przeprojektować moc transformacyjną AI: przeprojektowanie pracy i tworzenia wartości

Sztuczna inteligencja (AI) jest uważana za technologię, która otwiera się jak żadne inne nowe możliwości zasadniczego przemyślenia pracy i tworzenia wartości. Dla firm integracja AI jest kluczowym krokiem, aby zachować sukces i konkurencyjny w perspektywie długoterminowej, ponieważ promuje innowacje, zwiększa wydajność i zwiększa jakość. Ekonomiczne i społeczne skutki AI są znaczne; Jest to jeden z najważniejszych cyfrowych przyszłych tematów, rozwija się szybko i zawiera ogromny potencjał. Firmy coraz częściej rozpoznają zalety automatyzacji i zwiększania wydajności przez sztuczną inteligencję. To nie tylko zmiana technologiczna, ale fundamentalna zmiana modeli biznesowych, optymalizacji procesów i interakcji z klientami, które dostosowują się do potrzeby przetrwania w konkurencji.

Bardzo krytana „siła transformacyjna” sztucznej inteligencji wykracza poza czyste wprowadzenie nowych narzędzi; Oznacza to zmianę paradygmatu w myśleniu strategicznym. Menedżerowie są zobowiązani do ponownego oceny podstawowych procesów, obietnicy wartości, a nawet struktur branżowych. Jeśli uważasz tylko sztuczną inteligencję za narzędzie wydajności, ryzykujesz przeoczeniem swojego głębszego potencjału strategicznego. Szybki rozwój sztucznej inteligencji spotyka istniejący niedobór wykwalifikowanych pracowników. Stwarza to podwójne wyzwanie: z jednej strony istnieje pilna potrzeba szybkich kwalifikacji, aby móc korzystać z AI. Z drugiej strony KI oferuje możliwość zautomatyzowania zadań, a tym samym potencjalnie złagodzić niedobór wykwalifikowanych pracowników w niektórych obszarach, a jednocześnie pojawiają się nowe wymagania kwalifikacyjne. Wymaga to dopracowanego planowania personelu ze strony menedżerów.

Nadaje się do:

- Sztuczna inteligencja jako booster biznesu w firmie – kolejne praktyczne wskazówki dotyczące wprowadzenia AI w firmach od jedenastu interim managerów

Ważenie możliwości i ryzyka w epoce AI

Chociaż systemy AI oferują bardzo skuteczne możliwości, są one nierozerwalnie związane z ryzykiem, które należy zarządzać. Dyskurs wokół sztucznej inteligencji obejmuje uwzględnienie znacznego potencjału w stosunku do nieodłącznych napędów, co wymaga zrównoważonego podejścia do wykorzystania zalet i minimalizacji wad. Firmy stoją przed wyzwaniem promowania innowacji, a jednocześnie przestrzegając wytycznych dotyczących ochrony danych i etyki, co sprawia, że równowaga między postępem a zgodnością decyduje.

Ten akt równoważenia nie jest decyzją jednokrotną, ale ciągłą potrzebą strategiczną. Wraz z dalszym rozwojem technologii AI dla przykładu specjalistycznej sztucznej inteligencji w kierunku bardziej ogólnych umiejętności-rodzaj możliwości i ryzyka również się zmieni. Wymaga to ciągłej ponownej oceny i adaptacji zarządzania i strategii. Postrzeganie ryzyka i zalet AI może się znacznie różnić w organizacji. Na przykład aktywni użytkownicy AI są bardziej optymistyczni niż ci, którzy jeszcze nie wprowadzili sztucznej inteligencji. To ilustruje kluczowe wyzwanie w zarządzaniu zmianami dla menedżerów: tę lukę w percepcji musi zostać zakończona przez edukację, jasną komunikację i demonstrację namacalnych korzyści z jednoczesnym rozwiązywaniem problemów.

Zrozum krajobraz AI: podstawowe koncepcje i technologie

Generatywny Ki (Genai) i droga do sztucznej inteligencji ogólnej (AGI)

Generatywny ki (Genai)

Generative KI (Genai) oznacza modele AI, które zostały zaprojektowane do tworzenia nowych treści w formie tekstu pisanego, audio, obrazów lub filmów oraz oferowania szerokiej gamy aplikacji. Genai wspiera użytkowników w tworzeniu unikalnych, znaczących treści i może działać jako inteligentny system pytań lub asystent osobisty. Genai już zrewolucjonizuje tworzenie treści, marketingu i lojalności klientów poprzez szybką produkcję spersonalizowanych materiałów i automatyzację odpowiedzi.

Natychmiastowa dostępność i szeroki zakres aplikacji od Genai oznaczają, że często reprezentuje „AI podstawową AI” dla wielu organizacji. Ten pierwszy dotyk kształtuje postrzeganie i może prowadzić lub utrudniać szerszą adaptację AI. Menedżerowie muszą dokładnie kontrolować te pierwsze doświadczenia, aby stworzyć pozytywną dynamikę.

Sztuczna inteligencja ogólna (AGI)

Sztuczna inteligencja ogólna (AGI) odnosi się do hipotetycznej inteligencji maszyny, która jest w stanie zrozumieć lub nauczyć się wszelkich zadań intelektualnych, którym dana osoba może zarządzać, a tym samym naśladuje ludzkie umiejętności poznawcze. Chodzi o systemy AI, które mogą wykonywać szeroki zakres zadań zamiast specjalizować się w specyficznym.

Real AGI obecnie nie istnieje; Pozostaje koncepcją i celem badawczym. Openai, wiodąca firma w tym obszarze, definiuje AGI jako „wysokie systemy autonomiczne, które ludzie przekraczają w najbardziej cennej ekonomicznej pracy”. Do 2023 r. Osiągnięto tylko pierwszy z pięciu rosnących poziomów AGI, określany jako „Emerging AI”.

Niejednoznaczność i różne definicje AGI sugerują, że menedżerowie AGI powinni rozważyć długoterminowy, potencjalnie transformacyjny horyzont niż jako bezpośredni problem operacyjny. Należy skupić się na użyciu obecnej „potężnej AI”, a jednocześnie strategicznie obserwując postęp AGI. Ponad inwestycje w spekulacyjne scenariusze AGI mogą odwrócić uwagę zasobów od bardziej bezpośrednich możliwości AI. Rozwój specjalistycznej sztucznej inteligencji za pośrednictwem Genai w kierunku bieżących badań nad AGI implikuje rosnący poziom autonomii i wydajności systemów AI. Trend ten koreluje bezpośrednio ze rosnącą potrzebą solidnych warunków etycznych i zarządzania, ponieważ silniejszy AI ma większy potencjał nadużycia lub niezamierzonych konsekwencji.

Nadaje się do:

AII Asystent vs. AI Agent: Zdefiniuj role i umiejętności

Asystenci AI wspierają osoby w poszczególnych zadaniach, reagują na zapytania, odpowiadają na pytania i sugerują sugestie. Zazwyczaj są reaktywne i czekają na ludzkie polecenia. Wcześni asystenci byli regularnie oparte, ale nowoczesne opierają się na modelach uczenia maszynowego (ML) lub fundamentach. Natomiast agenci AI są bardziej autonomiczni i zdolni do realizacji celów i podejmowania decyzji niezależnie przy minimalnej interwencji człowieka. Są proaktywni, mogą wchodzić w interakcje z otoczeniem i dostosowywać je poprzez uczenie się.

Główne różnice polegają na autonomii, złożoności zadań, interakcji użytkownika i umiejętnościach decyzyjnych. Asystenci dostarczają informacji dla ludzkich decyzji, podczas gdy agenci mogą podejmować i przeprowadzać decyzje. W zakresie aplikacji asystenci poprawiają obsługę obsługi klienta, wspierają zadania HR w zapytaach bankowych i optymalizują. Z drugiej strony agenci mogą dostosować się do zachowania użytkownika w czasie rzeczywistym, proaktywnie zapobiegają oszustwom i automatyzować złożone procesy HR, takie jak Talenta Pancian.

Przejście od asystentów AI do agentów AI sygnalizują rozwój AI jako „narzędzie” do AI jako „współpracownika” lub nawet jako „autonomicznego pracownika”. Ma to głęboki wpływ na projektowanie, struktury zespołu i niezbędne umiejętności ludzkich pracowników, którzy coraz częściej muszą z nimi zarządzać i współpracować. Ponieważ agenci AI stają się coraz bardziej powszechne i są w stanie podejmować niezależne decyzje, „luka odpowiedzialności” staje się bardziej palącym problemem. Jeśli agent AI podejmuje nieprawidłową decyzję, alokacja odpowiedzialności staje się złożona. Podkreśla to krytyczną konieczność solidnego rządu AI, który dotyczy unikalnych wyzwań autonomicznych systemów.

Poniżej znajduje się porównanie najważniejszych cech wyróżniających:

Porównanie asystentów AI i agentów AI

Ta tabela oferuje menedżerom jasne zrozumienie podstawowych różnic w celu wybrania odpowiedniej technologii dla określonych potrzeb i przewidywania różnych stopni złożoności nadzoru i integracji.

Porównanie asystentów AI i agentów AI wykazuje znaczące różnice w ich cechach. Podczas gdy asystenci AI są raczej reaktywni i czekają na ludzkie polecenia, agenci AI działają proaktywnie i autonomicznie, działając niezależnie. Podstawowa funkcja asystenta AI polega na wykonywaniu zadań na żądanie, podczas gdy agent AI jest ukierunkowany na osiągnięcie celu. Asystenci AI wspierają ludzi w podejmowaniu decyzji, podczas gdy agenci AI niezależnie podejmują i wdrażają decyzje. Zachowanie uczenia się tych dwóch różni się również: asystent AI uczy się głównie ograniczonego i opartych na wersji, podczas gdy agenci AI są adaptacyjne i stale uczą się. Główne zastosowania asystentów AI obejmują chatboty i połączenie informacyjne, ale obszary zastosowania agentów AI obejmują automatyzację procesu, wykrywanie oszustw i rozwiązanie złożonych problemów. Interakcja z ludźmi wymaga stałego wkładu dla asystenta AI, podczas gdy minimalna interwencja człowieka jest konieczna dla agentów AI.

Maszyna: uczenie maszynowe, duże modele głosowe (LLM) i modele podstawowe

Uczenie maszynowe (ML)

Uczenie maszynowe jest pod -podstawową sztucznej inteligencji, w której komputery uczą się na podstawie danych i ulepszają się z doświadczeniem bez wyraźnego zaprogramowania. Algorytmy są szkolone w zakresie znajdowania wzorców w dużych zestawach danych oraz do podejmowania decyzji i prognoz na podstawie tego. Modele ML obejmują monitorowane uczenie się (uczenie się na podstawie wyraźnych danych), uczenie się nie do pokonania (znajdowanie wzorców w danych nie oznaczonych), częściowo monitorowane uczenie się (mieszanka danych zaznaczonych i nie zaznaczonych) i wzmacnianie uczenia się (uczenie się poprzez eksperymenty z nagrodami). ML zwiększa wydajność, minimalizuje błędy i wspiera podejmowanie decyzji w firmach.

Zrozumienie różnych rodzajów uczenia maszynowego jest nie tylko ważne dla menedżerów z technicznego punktu widzenia, ale także dla zrozumienia wymagań danych. Na przykład monitorowane uczenie się wymaga dużych ilości wysokiej jakości, oznaczonych danych danych, które mają wpływ na strategię danych i inwestycje. Chociaż identyfikacja problemów biznesowych powinna odbywać się na początku, możliwość zastosowania określonego typu ML będzie w dużej mierze zależeć od dostępności i rodzaju danych.

Duże modele głosowe (LLM)

Duże modele głosowe są rodzajem algorytmu głębokiego uczenia się, który jest szkolony w ogromnych rekordach danych i jest często używany w zastosowaniach przetwarzania języka naturalnego (NLP) w celu reagowania na zapytania w języku naturalnym. Przykładami tego są seria GPT z Openai. LLM mogą generować teksty podobne do ludzi, napędzać chatboty i obsługiwać zautomatyzowaną obsługę klienta. Możesz jednak przejmować niedokładności i zniekształcenia z danych szkoleniowych i podnieść obawy dotyczące praw autorskich i bezpieczeństwa.

Problem „zapamiętywania” w LLMS, w którym dosłownie wyprowadzasz tekst z danych szkoleniowych, zawiera znaczne ryzyko praw autorskich i plagiat dla firm wykorzystujących treści generowane przez LLM. Wymaga to starannych procesów przeglądu i zrozumienia pochodzenia wydań LLM.

Modele podstawowe

Podstawowe modele to duże modele AI, które zostały przeszkolone w zakresie szerokich danych i mogą być dostosowywane (dopracowane) do różnych zadań. Charakteryzują się pojawieniem się (nieoczekiwane umiejętności) i homogenizacja (architektura wspólna). Różnią się od klasycznych modeli AI tym, że są początkowo krajowe, używają uczenia się samokontroli, umożliwiają uczenie się transferu i często są multimodalnymi (przetwarzanie tekstu, obrazu, audio). LLM są rodzajem podstawowego modelu. Zalety obejmują szybszy dostęp do rynku i skalowalność, ale wyzwania to przejrzystość (problem „czarnej skrzynki”), ochronę danych i wysokie koszty lub wymagania infrastruktury.

Wzrost podstawowych modeli sygnalizuje zmianę w kierunku bardziej wszechstronnej i bardziej elastycznej sztucznej inteligencji. Jednak natura „czarnej skrzynki” i znaczne zasoby niezbędne do szkolenia lub dostrajania oznaczają, że dostęp i kontrola może być skoncentrowane, co powoduje potencjalnie zależność od kilku dużych dostawców. Ma to strategiczny wpływ na decyzje „Make-or-Buy” i ryzyko blokady dostawcy. Multimodalna zdolność wielu podstawowych modeli otwiera zupełnie nowe kategorie aplikacji, które mogą syntetyzować wyniki z różnych typów danych (np. Analiza raportów tekstowych wraz z monitorowaniem nagrań kamer). Wykracza to poza to, co mogą zrobić LLM skoncentrowane na tekście i wymaga szerszego myślenia o swoich dostępnych bazach danych.

Kompas regulacyjny: nawigacja w ramach prawnych i etycznych warunków

Ustawa UE KI: podstawowe przepisy i skutki dla firm

Ustawa UE KI, która weszła w życie 1 sierpnia 2024 r., Jest pierwszym na świecie kompleksowym prawem sztucznej inteligencji i ustanawia oparty na ryzyku system klasyfikacji AI.

Kategorie ryzyka:

- Nieakceptowalne ryzyko: systemy AI, które stanowią wyraźne zagrożenie dla bezpieczeństwa, środków utrzymania i praw są zabronione. Przykładami tego są punkty społeczne przez władze publiczne, poznawcze manipulacje zachowaniami i niezamówione czytanie zdjęć twarzy. Większość tych zakazów wchodzi w życie do 2 lutego 2025 r.

- Wysokie ryzyko: systemy AI, które negatywnie wpływają na bezpieczeństwo lub prawa podstawowe. Podlegają one ścisłym wymogom, w tym systemom zarządzania ryzykiem, zarządzaniu danymi, dokumentacji technicznej, nadzoru człowieka i ocen zgodności przed rynkiem. Przykładami są sztuczna inteligencja w infrastrukturze krytycznej, urządzeniach medycznych, zatrudnieniu i organach ścigania. Większość zasad AI wysokiego ryzyka ma zastosowanie od 2 sierpnia 2026 r.

- Ograniczone ryzyko: Systemy AI, takie jak chatboty lub te, które generują głębokie dokumenty, muszą spełniać zobowiązania dotyczące przejrzystości i informować użytkowników, że wchodzą w interakcje z AI lub że treść jest generowana przez AI.

- Minimalne ryzyko: systemy AI, takie jak filtry spamowe lub gry wideo oparte na AI. Ustawa umożliwia bezpłatne użytkowanie, chociaż zachęca się do dobrowolnych umiejętności behawioralnych.

Nadaje się do:

Ustawa określa obowiązki dla dostawców, importerów, handlowców i użytkowników (operatorów) systemów AI, w których dostawcy systemów wysokiego ryzyka podlegają najściślejszym wymaganiom. Ze względu na zastosowanie pozerytorialne wpływa również na firmy spoza UE, jeśli ich systemy AI są wykorzystywane na rynku UE. Szczegółowe zasady mają zastosowanie do modeli AI o ogólnym przeznaczeniu (modele GPAI), z dodatkowymi obowiązkami dla tych, które są klasyfikowane jako „ryzyko systemowe”. Zasady te mają zasadniczo od 2 sierpnia 2025 r. W przypadku niezgodności, istnieją znaczne grzywny, do 35 milionów euro lub 7 % globalnego rocznego obrotu dla zakazanych wniosków. Od lutego 2025 r. Artykuł 4 określa również odpowiedni poziom kompetencji AI dla personelu dostawców i operatorów niektórych systemów AI.

Podejście oparte na ryzyku ustawy UE AI wymaga fundamentalnej zmiany podejścia firm do rozwoju i wykorzystania AI. Nie chodzi już tylko o techniczną wykonalność ani wartość biznesową; Zgodność regulacyjna i redukcja ryzyka muszą być zintegrowane od początku cyklu życia AI („zgodność z projektem”). „Obowiązek kompetencji AI” jest ważnym, wczesnym determinacją. Oznacza to natychmiastową potrzebę oceny i wdrażania programów szkoleniowych, nie tylko dla zespołów technicznych, ale dla każdego, kto rozwija, używa lub monitoruje systemy AI. Wykracza to poza podstawową świadomość i obejmuje zrozumienie funkcjonalności, ograniczeń, a także ramy etycznych i prawnych. Koncentracja prawa na modelach GPAI, w szczególności tych z ryzykiem systemowym, wskazuje na regulację o szerokie i potencjalnie nieprzewidziane skutki tych potężnych, różnorodnych modeli. Firmy, które korzystają lub opracowują takie modele, podlegają zintensyfikowanym badaniu i obowiązkom, które wpływają na ich plany rozwoju i strategie wprowadzające rynkowe.

Przegląd kategorii ryzyka ustawy UE KI i podstawowych obowiązków

Ta tabela podsumowuje podstawową strukturę ustawy UE KI i pomaga menedżerom szybko rozpoznać, która kategoria ich systemy AI mogą się wpaść, i zrozumieć odpowiednie obciążenie i harmonogramy zgodności.

Przegląd kategorii ryzyka ustawy UE KI pokazuje, że systemy o niedopuszczalnym ryzyku, takie jak punktacja społeczna, manipulacja poznawcza i nieosiągalne skrobanie obrazów twarzy, są w pełni zakazane i nie mogą być stosowane od lutego 2025 r.. Hoch-Risiko-KI, na przykład, w infrastrukturze krytycznych, domach medycznych, zatrudnieniu, egzekucjach w zakresie edukacji. obowiązki. Między innymi dostawcy i operatorzy muszą mieć system zarządzania ryzykiem, zarządzanie jakością danych i dokumentację techniczną, również zapewnić przejrzystość, zapewnić nadzór człowieka i spełniać kryteria takie jak solidność, dokładność, bezpieczeństwo cybernetyczne i ocena zgodności. Odpowiednie środki wchodzą w życie od sierpnia 2026 r., Częściowo z sierpnia 2027 r. Ograniczone obawy związane z ryzykiem, takie jak chatboty, systemy wykrywania emocji, systemy kategoryzacji biometrycznej i głębsze. Zobowiązania dotyczące przejrzystości, takie jak etykietowanie jako system AI lub treść generowana przez AI, są również uważane za skuteczne od sierpnia 2026 r. Nie ma żadnych konkretnych zobowiązań dotyczących aplikacji AI o minimalnym ryzyku, takich jak filtry spamowe lub gry wideo z obsługiwaniami AI, z dobrowolnymi kodicesami behawioralnymi. Takie systemy można użyć natychmiast.

Pole napięcia Obliczenia innowacji: znajdź właściwą równowagę

Firmy muszą opanować obszar napięcia między promocją innowacji AI a gwarancją odpowiedzialności, ochrony danych (RODO) i wykorzystaniem etycznym. Zasady RODO (legalność, uczciwość, przejrzystość, powiązanie celu, minimalizacja danych, poprawność, rozliczalność) są fundamentalne dla odpowiedzialnej sztucznej inteligencji i wpływają na opracowywanie i wykorzystywanie systemów AI. Strategie równowagi obejmują wczesną integrację zespołów zgodności i ochrony danych, regularne audyty, korzystanie z zewnętrznej wiedzy specjalistycznej i korzystanie z specjalistycznych narzędzi zgodności. Niektórzy nie uważają wytycznych regulacyjnych za hamulce innowacyjne, ale jako akcelerator, który buduje zaufanie i zwiększają akceptację nowych technologii.

„Pole napięcia obowiązkowego obowiązku innowacji” nie jest statycznym kompromisem, ale dynamiczną równowagą. Firmy, które proaktywnie osadzają rozliczalność i względy etyczne w swoim cyklu innowacji AI, częściej budują zrównoważone, godne zaufania rozwiązania AI. Ostatecznie promuje to poważne innowacje, unikając kosztownego modernizacji, szkód reputacyjnych lub kar regulacyjnych. Wyzwanie utrzymania odpowiedzialności jest wzmacniane przez rosnącą złożoność i potencjalną „czarną skrzynkę” natury zaawansowanych modeli AI (jak omówiono w modelach podstawowych). Wymaga to silniejszego skupienia się na technikach wyjaśnień (XAI) i solidnych mechanizmach audytu, aby zapewnić, że decyzje podejmowane przez AI można zrozumieć, uzasadnione i kwestionowane, jeśli to konieczne.

🎯📊 Integracja niezależnej platformy AI w całej całej sieci cross 🤖🌐 dla wszystkich spraw firmowych

Integracja niezależnej platformy AI w całej całej sieci dla wszystkich firm Matters-Image: xpert.digital

Ki-Gamechanger: najbardziej elastyczne rozwiązania platformy AI, które obniżają koszty, poprawiają ich decyzje i zwiększają wydajność

Niezależna platforma AI: integruje wszystkie odpowiednie źródła danych firmy

- Ta platforma AI oddziałuje ze wszystkimi konkretnymi źródłami danych

- Od SAP, Microsoft, Jira, Confluence, Salesforce, Zoom, Dropbox i wielu innych systemów zarządzania danymi

- Szybka integracja AI: rozwiązania AI dostosowane do firm w ciągu kilku godzin lub dni zamiast miesięcy

- Elastyczna infrastruktura: oparta na chmurze lub hosting we własnym centrum danych (Niemcy, Europa, bezpłatny wybór lokalizacji)

- Najwyższe bezpieczeństwo danych: Wykorzystanie w kancelariach jest bezpiecznym dowodem

- Korzystaj z szerokiej gamy źródeł danych firmy

- Wybór własnych lub różnych modeli AI (DE, UE, USA, CN)

Wyzwania, które rozwiązuje nasza platforma AI

- Brak dokładności konwencjonalnych rozwiązań AI

- Ochrona danych i bezpieczne zarządzanie poufnymi danymi

- Wysokie koszty i złożoność indywidualnego rozwoju sztucznej inteligencji

- Brak kwalifikowanej sztucznej inteligencji

- Integracja sztucznej inteligencji z istniejącymi systemami informatycznymi

Więcej na ten temat tutaj:

Strategie AI dla menedżerów: praktyczne wytyczne i przykłady

AI w akcji: aplikacje, aplikacje i skuteczna interakcja

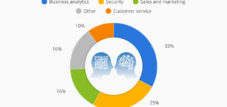

Uznanie możliwości: aplikacje i aplikacje AI w różnych branżach

KI oferuje szeroką gamę aplikacji, w tym tworzenie treści, spersonalizowane podejście klientów, optymalizację procesu w produkcji i logistyce, konserwację wyprzedzającą, a także wsparcie w finansach, zasobach ludzkich i IT.

Konkretne przykłady branżowe obejmują:

- Automobile/produkcja: AI i symulacja w badaniach (Arena2036), zautomatyzowana interakcja robota (FESTO), optymalizacja procesu i konserwacja predykcyjna w produkcji (Bosch).

- Usługi finansowe: Zwiększone bezpieczeństwo poprzez analizę dużych ilości danych na temat podejrzanych transakcji, zautomatyzowanej faktury, analizy inwestycji.

- Opieka zdrowotna: szybsze diagnozy, rozszerzony dostęp do opieki (np. Interpretacja obrazów medycznych), optymalizacja badań farmaceutycznych.

- Telekomunikacja: optymalizacja wydajności sieci, ulepszenia audiowizualne, zapobieganie migracji klientów.

- Detaliczna/e-commerce: spersonalizowane zalecenia, chatboty do obsługi klienta, automatyczne procesy kasjerów.

- Marketing i sprzedaż: Tworzenie treści (Chatgpt, Canva), zoptymalizowane kampanie, segmentacja klientów, prognozy sprzedaży.

Podczas gdy wiele aplikacji ma na celu automatyzację i wydajność, ważnym pojawiającym się trendem jest rola AI przy poprawie podejmowania decyzji przez ludzi i umożliwiającą nowe formy innowacji (np. Rozwój leku; rozwój produktu). Menedżerowie powinni spojrzeć poza obniżki kosztów w celu zidentyfikowania opcji wzrostu i innowacji opartych na AI. Najbardziej udane implementacje sztucznej inteligencji często obejmują integrację sztucznej inteligencji z istniejącymi podstawowymi procesami i systemami (np. SAP używa KI w oprogramowaniu korporacyjnym, Microsoft 365 Copilot) zamiast traktowania AI jako niezależnej, izolowanej technologii. Wymaga to całościowego spojrzenia na architekturę firmy.

Nadaje się do:

- Sztuczna inteligencja: pięć kluczowych strategii dla integracji transformacji AI dla zrównoważonego zarządzania korporacyjnego

Opanuj dialog: skuteczne monit o generatywną sztuczną inteligencję

Niezwłocznie inżynieria jest iteracyjnym, kontrolowanym przez test procesem poprawy wyjścia modelu, który wymaga jasnych celów i systematycznych testów. Skuteczne podpowiedzi zależą zarówno od treści (instrukcje, przykłady, kontekst), jak i struktura (zamówienie, znakowanie, separator).

Ważne elementy podpowiedzi są: cel/misja, instrukcje, ograniczenia (co zrobić/robić), dźwięk/styl, dane kontekstowe/tła, kilka strzałów, żądanie uzasadnienia (łańcuch) i pożądany format odpowiedzi.

Najlepsze praktyki obejmują:

- Ustaw jasne cele i użyj czasowników akcji.

- Podaj kontekst i informacje podstawowe.

- Zdefiniuj dokładnie grupę docelową.

- AI informują, czego nie powinien.

- Sformułuj szybki, zwięzły, zwięzły i z precyzyjnym wyborem słów.

- Dodaj granice wyjściowe, szczególnie do pisania zadań.

- Przypisz rolę (np. „Jesteś nauczycielem matematyki”).

- Poniższe łączenie (użycie wzajemnie powiązanych z wierszem) może generować ciągłe pomysły.

Skuteczne monitowanie jest mniejsze poszukiwanie pojedynczego „doskonałego podpowiedzi” niż opracowanie strategicznego podejścia do interakcji z LLM. Obejmuje to zrozumienie umiejętności modelowych, iteracyjnego udoskonalania podpowiedzi opartych na wyniku oraz zastosowanie technik takich jak alokacja ról i łańcuch, w celu poprowadzenia AI do pożądanych wyników. Jest to umiejętność, która wymaga ćwiczeń i krytycznego myślenia. Zdolność do zapewnienia odpowiedniego kontekstu i zdefiniowania ograniczeń ma ogromne znaczenie dla uzyskania cennych wyników z Genai. Oznacza to, że jakość treści generowanej przez AI jest często bezpośrednio proporcjonalna do jakości i swoistości wkładu człowieka, co podkreśla trwałe znaczenie ludzkiej wiedzy w tym procesie.

Najlepsza praktyka do tworzenia skutecznych podpowiedzi AI

Ta tabela oferuje praktyczne, możliwe do wdrożenia porady, które menedżerowie i specjaliści mogą natychmiast ubiegać się o poprawę interakcji z generatywnymi narzędziami AI.

Aby osiągnąć cenne wyniki w użyciu generatywnej sztucznej inteligencji, kluczowe jest rozwiązanie szczegółowo i wyraźnie, precyzyjnie zdefiniowanie celu i użycie czasowników akcji, takich jak „Utwórz listę kluczowych punktów, która podsumowuje najważniejsze wyniki papieru”. Równie ważne jest dostarczenie kontekstu, na przykład poprzez dostarczanie podstawowych informacji i odpowiednich danych, takich jak „na podstawie raportu finansowego, przeanalizuj rentowność ostatnich pięciu lat”. Grupa docelowa i pożądany dźwięk powinny być wyraźnie wyartykułowane, takie jak „Napisz opis produktu dla młodych dorosłych, którzy cenią zrównoważony rozwój”. AI można również przypisać konkretną rolę lub osobowość, na przykład „jesteś ekspertem marketingowym. Desort kampania dla ...”. Za pomocą kilku strzałów, takich jak „Wejście: Apple. Wyjście: Owoc. Wejście: Carrow. Wyjście:”, można lepiej zilustrować pożądany format wyjściowy. Dokładne formatowanie odpowiedzi jest również rozsądne, aby zdefiniować, w jaki sposób „sformatuj odpowiedź w Markdown”. Ograniczenia, takie jak „Unikaj żargonu technicznego. Odpowiedź nie powinna już być więcej niż 200 słowami”, pomaga zoptymalizować dane wyjściowe. Podejście iteracyjne, w którym monit jest dostosowywany i udoskonalany na podstawie poprzednich wyników, dodatkowo zwiększa jakość. Wreszcie łańcuch może być używany przez myśli (mimo że łańcuch), prosząc AI o wyjaśnienie procesu myślenia krok po kroku, takiego jak „Wyjaśnij swój argument krok po kroku”.

Spotkanie Invisible AI: Zrozum i zarządzaj aplikacjami Shadow (Shadow AI)

Schadten-Ki oznacza nieautoryzowane lub nieuregulowane użycie narzędzi AI przez pracowników, często w celu zwiększenia wydajności lub uniknięcia powolnych oficjalnych procesów. Jest to podkategoria cienia IT.

Ryzyko cienia Ki:

- Bezpieczeństwo danych i ochrona danych: Nieautoryzowane narzędzia mogą prowadzić do naruszeń ochrony danych, ujawnienia poufnych danych publicznych/firmy i niezgodności z RODPR/HIPAA.

- Zgodność i prawo: naruszenia przepisów dotyczących ochrony danych, problemy z prawami autorskimi, konflikty z wolnością informacji. Żądanie „kompetencji AI” ustawy UE KI z lutego 2025 r. Pilnie sprawia, że argument.

- Ekonomicznie/operacyjne: nieefektywne struktury równoległe, ukryte koszty poprzez indywidualne subskrypcje, brak kontroli nad licencjami, niezgodność z istniejącymi systemami, zakłócenie procesów pracy, zmniejszona wydajność.

- Jakość i kontrola: brak przejrzystości w przetwarzaniu danych, potencjał stronniczych lub wprowadzających w błąd wyników, erozja zaufania publicznego/wewnętrznego.

- Podważanie zarządzania: omijanie rządu IT, co utrudnia egzekwowanie wytycznych dotyczących bezpieczeństwa.

Strategie zarządzania Schadten-ki:

- Opracowanie wyraźnej strategii AI i ustanowienia odpowiedzialnych wytycznych AI.

- Zapewnienie oficjalnych, zatwierdzonych narzędzi AI jako alternatyw.

- Definicja jasnych wytycznych dotyczących korzystania z sztucznej inteligencji, przetwarzania danych i zatwierdzonych narzędzi.

- Szkolenie i uczulenie pracowników w celu odpowiedzialnego wykorzystania sztucznej inteligencji, ryzyka i najlepszych praktyk.

- Wdrożenie regularnych audytów w celu odkrycia niezautoryzowanej sztucznej inteligencji i zapewnienia zgodności.

- Akceptacja przyrostowego podejścia rządowego AI, zaczynając od niewielkich kroków i udoskonalania wytycznych.

- Promowanie współpracy między -zależnej i zaangażowania pracowników.

Schadten-ki jest często objawem niespełnionych potrzeb użytkowników lub nadmiernych biurokratycznych procesów we wprowadzaniu technologii. Podejście czysto restrykcyjne („Zakaz AI”) może cofnąć się. Skuteczne zarządzanie wymaga zrozumienia przyczyn i zapewnienia praktycznych, bezpiecznych alternatyw oprócz jasnego zarządzania. Wzrost łatwo dostępnych narzędzi Genai (takich jak Chatgpt) prawdopodobnie przyspieszył rozprzestrzenianie się Schatten-Ki. Pracownicy mogą szybko korzystać z tych narzędzi bez udziału IT. To sprawia, że proaktywne szkolenie kompetencji AI (zgodnie z wymogami UE KI Act), a jasna komunikacja za pośrednictwem zatwierdzonych narzędzi jest jeszcze ważniejsza.

Ryzyko cienia AI i reakcje strategiczne

Ta tabela zawiera ustrukturyzowany przegląd różnorodnych zagrożeń z nieuregulowanego użytkowania AI i konkretnych, wdrażanych strategii dla menedżerów.

Cień AI ma wiele ryzyka, na które firmy muszą się strategicznie spotkać. Wycieki danych, nieautoryzowany dostęp do poufnych informacji lub zakażenia złośliwego oprogramowania mogą wystąpić w obszarze bezpieczeństwa danych. Środki strategiczne obejmują wprowadzenie wytycznych dotyczących wykorzystania sztucznej inteligencji, tworzenie listy zatwierdzonych narzędzi, korzystanie z szyfrowania, wdrożenie ścisłej kontroli dostępu i szkolenie pracowników. W odniesieniu do ryzyka zgodności, takich jak naruszenie RODO, naruszenie przepisów branżowych lub naruszenia praw autorskich, regularne audyty, sekwencje ochrony danych oparte na danych (DSFA) dla nowych narzędzi, niezbędne są wyraźnie zdefiniowane wytyczne dotyczące przetwarzania danych i, jeśli to konieczne, porady prawne. Ryzyko finansowe wynikają z niekontrolowanych wydatków na subskrypcje, zwolnione licencje lub nieefektywność. Dlatego firmy powinny polegać na scentralizowanych zamówieniach, ścisłej kontroli budżetu i regularnym przeglądu używania narzędzi. Wyzwania operacyjne, takie jak niespójne wyniki, niezgodność z istniejącymi systemami firmy lub zaburzeniami procesowymi, można opanować poprzez dostarczanie znormalizowanych narzędzi, ich integrację z istniejącymi przepływami pracy i ciągłe kontrole jakości. Wreszcie ryzyko reputacyjne stanowi niebezpieczeństwo, na przykład utrata zaufania klienta w wyniku awarii danych lub niepoprawnej komunikacji generowanej przez AI. Przejrzysta komunikacja, zgodność z wytycznymi etyki i dobrze przemyślany plan reagowania na incydenty są kluczowymi środkami utrzymania zaufania do firmy i zminimalizowania możliwych szkód.

🎯🎯🎯 Skorzystaj z obszernej, pięciokrotnej wiedzy Xpert.Digital w kompleksowym pakiecie usług | Badania i rozwój, XR, PR i SEM

Maszyna do renderowania 3D AI i XR: pięciokrotna wiedza Xpert.Digital w kompleksowym pakiecie usług, R&D XR, PR i SEM - Zdjęcie: Xpert.Digital

Xpert.Digital posiada dogłębną wiedzę na temat różnych branż. Dzięki temu możemy opracowywać strategie „szyte na miarę”, które są dokładnie dopasowane do wymagań i wyzwań konkretnego segmentu rynku. Dzięki ciągłej analizie trendów rynkowych i śledzeniu rozwoju branży możemy działać dalekowzrocznie i oferować innowacyjne rozwiązania. Dzięki połączeniu doświadczenia i wiedzy generujemy wartość dodaną i dajemy naszym klientom zdecydowaną przewagę konkurencyjną.

Więcej na ten temat tutaj:

Jak przekształcić przywództwo i współpracę i wzmocnić umiejętności miękkie w przywództwie: przewaga ludzka w epoce AI

Jak przekształcić przywództwo i współpracę oraz wzmocnić umiejętności miękkie w przywództwie: przewaga ludzka w wieku AI: xpert.digital

Element ludzki: wpływ sztucznej inteligencji na przywództwo, współpracę i kreatywność

Zmiana przywództwa w dobie sztucznej inteligencji: nowe wymagania i kompetencje

AI wymaga zmiany przywództwa na unikalne umiejętności ludzkie: świadomość, współczucie, mądrość, empatia, zrozumienie społeczne, przejrzystą komunikację, krytyczne myślenie i zdolność adaptacyjną. Menedżerowie muszą rozwijać kompetencje technologiczne, aby podejmować uzasadnione decyzje dotyczące narzędzi AI i wiodących zespołów poprzez zmianę. Obejmuje to zrozumienie danych i krytyczną ocenę informacji generowanych przez AI.

Najważniejsze zadania zarządzania obejmują promowanie kultury kontrolowanej przez dane podejmowania decyzji, skutecznego zarządzania zmianami, rozważania etycznych za pośrednictwem rządu AI oraz promowanie innowacji i kreatywności. AI może złagodzić menedżerów rutynowych zadań, aby mogli skoncentrować się na strategicznych i ludzkich aspektach, takich jak motywacja i rozwój pracowników. Może powstać nowa rola „głównego oficera ds. Innowacji i transformacji” (CITO), która łączy wiedzę techniczną, wiedzę o zachowaniu i wizję strategiczną. Menedżerowie muszą poruszać się z złożonymi krajobrazami etycznymi, promować transformacje kulturowe, zarządzać współpracą między ludźmi i AI, napędzać integrację krzyżową i zapewnić odpowiedzialne innowacje.

Podstawowym wyzwaniem dla menedżerów w erze AI jest nie tylko zrozumienie AI, ale także prowadzenie ludzkiej reakcji na AI. Obejmuje to kultywację kultury uczenia się, radząc sobie z obawami przed utratą pracy i występowanie etycznego wykorzystania sztucznej inteligencji, co czyni umiejętności miękkich ważniejszych niż kiedykolwiek. Istnieje potencjalna rozbieżność w postrzeganiu relacji interpersonalnych w wieku AI: 82 % pracowników uważa je za konieczne, w porównaniu z tylko 65 % menedżerów. Ta luka może prowadzić do strategii przywództwa, które inwestują zbyt mało w powiązania ludzkie i potencjalnie upośledzają moralność i współpracę. Skuteczne wytyczne AI obejmują paradoksalny zestaw zdolności: akceptacja obiektywności kontrolowanej przez dane przez AI, jednocześnie wzmacniając subiektywne osądy ludzkie, intuicję i argument etyczny. Chodzi o rozszerzenie ludzkiej inteligencji, nie tworzenie sztucznej inteligencji.

Nadaje się do:

- Akceptacja wprowadzenia nowych technologii, takich jak sztuczna inteligencja, rzeczywistość rozszerzona i rozszerzona oraz sposoby ich promowania

Transformacja pracy zespołowej: wpływ sztucznej inteligencji na współpracę i dynamikę zespołu

AI może poprawić pracę zespołową poprzez automatyzację rutynowych zadań i umożliwia pracownikom koncentrowanie się na pracy strategicznej i twórczej. Systemy AI mogą wspierać lepsze podejmowanie decyzji, analizując dane i dając zespoły. Narzędzia AI mogą promować lepszą komunikację i koordynację, umożliwić współpracę w czasie rzeczywistym oraz wymianę informacji i zasobów. Zarządzanie wiedzą oparte na sztucznej inteligencji może ułatwić dostęp do scentralizowanej wiedzy, umożliwić inteligentne wyszukiwania i promować wymianę wiedzy. Połączenie ludzkich umiejętności twórczych, osądu i inteligencji emocjonalnej z analizą danych i umiejętnościami automatyzacji AI może prowadzić do bardziej wydajnej i uzasadnionej pracy.

Wyzwania obejmują gwarancję ochrony danych i obsługi etycznych danych w oparciu o wspólne narzędzia AI, potencjał „utraty kompetencji” wśród pracowników, jeśli AI podejmuje zbyt wiele zadań bez strategii dalszych kwalifikacji, a także obawa, że kontakty osobiste mogą stać się mniej powszechne.

Podczas gdy AI może poprawić wydajność współpracy (np. Szybsze zamówienia informacji, automatyzacja zadań), menedżerowie muszą aktywnie pracować nad utrzymaniem jakości interakcji człowieka i spójności zespołu. Oznacza to projektowanie procesów pracy w taki sposób, że członkowie zespołu AI uzupełniali zamiast izolowania i tworzą możliwości prawdziwych powiązań ludzkich. Udana integracja sztucznej inteligencji z pracą zespołową zdecydowanie zależy od zaufania do niezawodności i uczciwości technologii, a także zaufania wśród członków zespołu, w jaki sposób jest wykorzystywana wiedza oparta na sztucznej inteligencji. Brak zaufania może prowadzić do oporu i podlegać wspólnym wysiłkom.

AI jako kreatywny partner: ekspansja i redefinicja kreatywności w organizacjach

Generatywna sztuczna inteligencja może, jeśli zostanie wprowadzona strategicznie i ostrożnie, stworzyć środowisko, w którym ludzka kreatywność i AI współistnieją i współpracują. AI może promować kreatywność, działając jako partner, oferując nowe perspektywy i zmieniając granice możliwych w obszarach takich jak media, sztuka i muzyka. AI może zautomatyzować rutynowe akcje procesów twórczych, a tym samym uwolnić ludzi do bardziej konceptualnej i innowacyjnej pracy. Może to również pomóc rozpoznać nowe trendy lub przyspieszyć rozwój produktu poprzez eksperymenty oparte na AI.

Etyczne dylematy i wyzwania wynikają z faktu, że treści generowane przez AI kwestionujące tradycyjne idee autorstwa, oryginalności, autonomii i intencji. Zastosowanie danych chronionych prawem autorskim do szkolenia modeli AI i generowanie potencjalnie prawnych treści jest poważnymi obawami. Ponadto istnieje ryzyko nadmiernej zależności od sztucznej inteligencji, co może potencjalnie stłumić niezależną ludzką kreatywną eksplorację i rozwój kompetencji w perspektywie długoterminowej.

Integracja sztucznej inteligencji z procesami twórczymi jest nie tylko kwestią nowych narzędzi, ale także fundamentalną redefinicją samej kreatywności, modelem tworzenia człowieka-Ki-Ko. Wymaga to zmiany mentalności dla kreatywnych specjalistów i ich menedżerów, którzy podkreślili pracę z AI jako nową modalność. Rozważania etyczne związane z treściami generowanymi przez AI (autorstwo, uprzedzenie, głębokie szafki) oznaczają, że organizacje nie mogą po prostu przejąć kreatywnych narzędzi AI bez solidnych wytycznych etycznych i nadzoru. Menedżerowie muszą upewnić się, że sztuczna inteligencja jest wykorzystywana odpowiedzialnie do rozszerzenia kreatywności, a nie do oszustwa lub naruszenia.

Utwórz porządek: wdrożenie rządu AI w celu odpowiedzialnej transformacji

Potrzeba rządu AI: dlaczego jest to ważne dla jej firmy

Rząd AI zapewnia, że systemy AI są opracowywane i wykorzystywane etycznie, przejrzysty i zgodnie z ludzkimi wartościami i wymogami prawnymi.

Ważne przyczyny rządu AI to:

- Rozważania etyczne: odnosi się do potencjału stronniczych decyzji i niesprawiedliwych wyników, zapewnia uczciwość i poszanowanie praw człowieka.

- Zgodność prawna i regulacyjna: Zapewnia zgodność z opracowywaniem przepisów dotyczących AI (takich jak UE KI Ustawa) i istniejącymi przepisami dotyczącymi ochrony danych (RODO).

- Zarządzanie ryzykiem: oferuje ramy identyfikacji, oceny i kontrolowania ryzyka związanego z AI, takie jak utrata zaufania klientów, utrata kompetencji lub stronnicze procesy podejmowania decyzji.

- Nadzór: promuje przejrzystość i wyjaśnienie w przypadku decyzji AI i tworzy zaufanie wśród pracowników, klientów i interesariuszy.

- Maksymalizacja wartości: upewnij się, że użycie AI jest ukierunkowane na cele biznesowe, a jego zalety są skutecznie wdrażane.

Bez rozsądnego zarządzania AI może prowadzić do niezamierzonych szkód, naruszeń etycznych, kary prawnej i szkód reputacyjnych.

Rząd AI to nie tylko funkcja zgodności lub redukcji ryzyka, ale strategiczny pionier. Określając jasne zasady, obowiązki i wytyczne etyczne, organizacje mogą promować środowisko, w którym innowacje AI mogą się rozwijać odpowiedzialnie, co prowadzi do bardziej zrównoważonych i bardziej godnych zaufania rozwiązań AI. Potrzeba rządu AI jest bezpośrednio proporcjonalna do rosnącej autonomii i złożoności systemów AI. Jeśli organizacje z prostych asystentów AI przechodzą na bardziej wyrafinowane agentów AI i podstawowe modele, zakres i surowość zarządzania muszą być również rozwijane, aby poradzić sobie z nowymi wyzwaniami w zakresie obowiązku rachunkowości, przejrzystości i kontroli.

Prace ramowe i najlepsze praktyki dla skutecznego rządu AI

Podejścia do zarządzania obejmują nieformalne (oparte na wartościach korporacyjnych) do rozwiązań ad hoc (reakcja na określone problemy) po formalne (kompleksowe prace ramy).

Wiodące prace framework (przykłady):

- Ramy zarządzania ryzykiem NIST (AI RMF): Koncentruje się na wspieraniu organizacji w kontrolowaniu ryzyka związanego z AI poprzez funkcje takie jak podatki, mapowanie, pomiar i zarządzanie.

- ISO 42001: Ustanawia kompleksowy system zarządzania sztucznej inteligencji, który wymaga wytycznych, zarządzania ryzykiem i ciągłego doskonalenia.

- Zasady AI OECD: Promuj odpowiedzialne postępowanie w sprawie AI i podkreślają prawa człowieka, uczciwość, przejrzystość i odpowiedzialność.

Najlepsza praktyka do wdrażania:

- Budowanie wewnętrznych struktur zarządzania (np. Etyka AI, międzyfunkcyjne grupy robocze) z wyraźnymi rolami i obowiązkami.

- Wdrożenie systemu klasyfikacji opartego na ryzyku dla aplikacji AI.

- Zapewnienie solidnego rządu i zarządzania, w tym jakości danych, ochrony danych i przeglądu zniekształceń.

- Wdrożenie przeglądów zgodności i zgodności w oparciu o odpowiednie standardy i przepisy.

- Przepisuj nadzór człowieka, szczególnie w przypadku systemów wysokiego ryzyka i krytycznych decyzji.

- Integracja interesariuszy (pracowników, użytkowników, inwestorów) poprzez przejrzystą komunikację.

- Opracowanie jasnych wytycznych etycznych i ich integracja z cyklem rozwoju AI.

- Inwestycje w szkolenia i zarządzanie zmianami w celu zapewnienia zrozumienia i akceptacji wytycznych dotyczących zarządzania.

- Zacznij od jasno zdefiniowanych aplikacji i projektów pilotażowych, a następnie stopniowo skalowanie.

- Zarządzanie katalogiem systemów AI wykorzystywanych w firmie.

Skuteczny rząd AI nie jest rozwiązaniem jednostkowym. Organizacje muszą dostosowywać ramy, takie jak NIST AI RMF lub ISO 42001 do ich konkretnej branży, wielkości, ryzyka i rodzajów używanych przez nich sztucznej inteligencji. Czysto teoretyczne przejęcie ram bez praktycznej adaptacji prawdopodobnie nie jest skuteczne. „Czynnik ludzkiego” w rządzie AI jest równie kluczowy jak aspekty „proces” i „technologia”. Obejmuje to jasne przypisanie odpowiedzialności, kompleksowe szkolenie i promocję kultury, która docenia etyczne i odpowiedzialne wykorzystanie sztucznej inteligencji. Bez akceptacji i zrozumienia pracowników nawet najlepiej zaprojektowane ramy zarządzania zawiedzie.

Kluczowe elementy ram rządowych AI

Ta tabela oferuje kompleksową listę kontrolną i instrukcje dla menedżerów, którzy chcą ustanowić lub ulepszyć swój rząd AI.

Kluczowe elementy ram rządowych AI mają kluczowe znaczenie dla zapewnienia odpowiedzialnego i skutecznego użycia AI. Centralne zasady i wytyczne etyczne powinny odzwierciedlać wartości korporacyjne i orientować się w kierunku praw człowieka, uczciwości i przejrzystości. Role i obowiązki należy jasno określić; Obejmuje to Radę Etyki AI, kierowników danych i egzaminatorów modelowych, w których zadania, uprawnienia decyzyjne i obowiązek rozliczenia muszą być jasno ustalone. Skuteczne zarządzanie ryzykiem wymaga identyfikacji, oceny i zmniejszenia ryzyka, na przykład zdefiniowanych na podstawie kategorii prawa UE KI. Regularne oceny ryzyka, a także rozwój i monitorowanie strategii redukcji odgrywają tutaj centralną rolę. Zarządzanie danymi zapewnia, że wzięte pod uwagę aspekty takie jak jakość, ochrona danych, bezpieczeństwo i rozpoznawanie stronniczości, w tym zgodność z RODO i środki dyskryminacji. Modelowe zarządzanie cyklem życia obejmuje znormalizowane procesy rozwoju, walidacji, użytkowania, monitorowania i uruchamiania oraz kładzie szczególny nacisk na dokumentację, wersję i ciągłe monitorowanie wydajności. Przejrzystość i wyjaśnienie są niezbędne, aby zapewnić identyfikację decyzji AI i ujawnić zastosowanie AI. Zgodność z wymogami prawnymi, takimi jak ustawa UE KI i RODO, musi być również zapewnione poprzez bieżące przegląd i korekty procesów, a także współpracę z działem prawnym. Szkolenie i wyostrzenie świadomości dla programistów, użytkowników i menedżerów promują zrozumienie baz AI, aspekty etyczne i wytyczne dotyczące zarządzania. Wreszcie należy zagwarantować reakcję incydentu i naprawę, aby skutecznie rozwiązać awarie, naruszenia etyczne lub incydenty bezpieczeństwa. Obejmuje to ustalone trasy sprawozdawcze, procesy eskalacji i środki naprawcze, które umożliwiają szybką i ukierunkowaną interwencję.

Nadaje się do:

- Wyścig w dziedzinie sztucznej inteligencji (AI): 7 krajów, na które warto zwrócić uwagę – w tym Niemcy – pierwsza dziesiątka

Przygotuj się: strategiczny imperatyw transformacji AI

Kultywuj gotowość AI: rola ciągłego uczenia się i dalszych kwalifikacji

Oprócz wiedzy specjalistycznej menedżerowie potrzebują strategicznego zrozumienia sztucznej inteligencji, aby skutecznie rozwijać swoje firmy. Szkolenie AI dla menedżerów powinny obejmować bazy AI, udane studia przypadków, zarządzanie danymi, względy etyczne i identyfikację potencjału AI we własnej firmie. Od 2 lutego 2025 r. Ustawa UE KI (ART. 4) przepisuje „kompetencje AI” dla personelu zaangażowanego w opracowywanie lub korzystanie z systemów AI. Obejmuje to zrozumienie technologii AI, wiedzę o aplikacjach, krytyczne myślenie i ramy prawne.

Zalety szkolenia AI dla menedżerów obejmują możliwość zarządzania projektami AI, opracowywanie zrównoważonych strategii AI, optymalizację procesów, zabezpieczenie korzyści konkurencyjnych oraz zapewnienie etycznego i odpowiedzialnego wykorzystania sztucznej inteligencji. Brak kompetencji AI i umiejętności stanowi znaczną przeszkodę w adaptacji AI. Dostępne są różne formaty szkoleń: kursy certyfikatów, seminaria, kursy online, szkolenie obecności.

Gotowość AI oznacza nie tylko nabycie umiejętności technicznych, ale także promowanie sposobu myślenia o ciągłym uczeniu się i zdolności adaptacyjnej w całej organizacji. W związku z szybkim rozwojem sztucznej inteligencji, specyficzne szkolenie oparte na narzędziach może być nieaktualne. Dlatego podstawowa wiedza AI i umiejętności krytycznego myślenia są bardziej trwałe inwestycje. „Zobowiązanie kompetencji AI” z UE KI ACT jest kierowcą regulacyjnym do dalszych kwalifikacji, ale organizacje powinny postrzegać to jako okazję, a nie tylko jako obciążenie zgodności. Bardziej kompetentna siła robocza jest lepiej przygotowana do identyfikacji innowacyjnych aplikacji AI, skutecznego korzystania z narzędzi i do zrozumienia implikacji etycznych, co prowadzi do ogólnie lepszych wyników AI. Istnieje wyraźny związek między brakiem umiejętności/zrozumienia AI a rozprzestrzenianiem się AI. Inwestycje w kompleksowe tworzenie sztucznej inteligencji mogą bezpośrednio zmniejszyć ryzyko związane z nieautoryzowanym wykorzystaniem sztucznej inteligencji, umożliwiając pracownikom podejmowanie świadomych i odpowiedzialnych decyzji.

Szanse i ryzyko syntezy: mapa drogowa dla suwerennych przywództwa AI

Zarządzanie transformacją AI wymaga całościowego zrozumienia potencjału technologii (innowacji, wydajności, jakości) i jej nieodłącznego ryzyka (etycznego, prawnego, społecznego).

Proaktywny projekt podróży AI organizacji obejmuje suwerenne przywództwo AI:

- Ustanowienie solidnego rządu AI opartego na zasadach etycznych i ramach prawnych, takich jak UE KI Ustawa.

- Promowanie kultury ciągłego uczenia się i kompetencji AI na wszystkich poziomach.

- Identyfikacja strategiczna i priorytetyzacja aplikacji AI, które zapewniają namacalną wartość.

- Wzmocnienie ludzkich talentów poprzez skupienie się na umiejętnościach uzupełnionych zamiast zastępowania i zarządzania ludzkimi skutkami sztucznej inteligencji.

- Wyzwania proaktywne zarządzania, takie jak Schatten-ki.

Ostatecznym celem jest wykorzystanie sztucznej inteligencji jako strategicznego pioniera dla zrównoważonego wzrostu i korzyści konkurencyjnych, a jednocześnie zmniejszenie ich potencjalnych wad. Prawdziwe „suwerenne przywództwo AI” wykracza poza wewnętrzne zarządzanie organizacjami i obejmuje szersze zrozumienie skutków społecznych AI i roli firmy w tym ekosystemie. Oznacza to uczestnictwo w dyskusjach politycznych, przyczynianie się do ustalenia standardów etycznych i zapewnienie, że AI jest wykorzystywane do samopoczucia społecznego i nie tylko do zysku. Podróż transformacji AI nie jest liniowa i będzie zawierała nawigację poprzez dwuznaczności i nieoczekiwane wyzwania. Dlatego menedżerowie muszą kultywować zwinność organizacyjną i odporność, aby ich zespoły mogły dostosować się do nieprzewidzianego postępu technologicznego, zmian regulacyjnych lub zaburzeń związanych z rynkiem przez AI.

Nadaje się do:

- Pierwsza dziesiątka w zakresie doradztwa i planowania – Przegląd i wskazówki dotyczące sztucznej inteligencji: Różne modele sztucznej inteligencji i typowe obszary zastosowań

Zrozumienie i wykorzystanie technologii: AI bazy decydentów

Transformacja poprzez sztuczną inteligencję nie jest już odległą wizją przyszłości, ale obecną rzeczywistością, która rzuca wyzwanie firmom każdej wielkości i branż, a jednocześnie oferuje ogromne możliwości. Dla specjalistów i menedżerów oznacza to odgrywanie aktywnej roli w projektowaniu tej zmiany w celu odpowiedzialnego podnoszenia potencjału AI i pewnego zarządzania związanym z tym ryzykiem.

Podstawy sztucznej inteligencji, od modeli generatywnych po rozróżnienie między asystentami i agentami, przez czynniki technologiczne, takie jak uczenie maszynowe i podstawowe modele, stanowią podstawę do głębszego zrozumienia. Wiedza ta jest niezbędna, aby móc podejmować uzasadnione decyzje dotyczące wykorzystania i integracji systemów AI.

Ramy prawne, w szczególności ustawa UE KI, określa jasne wytyczne dotyczące opracowania i zastosowania AI. Podejście oparte na ryzyku i wynikające z tego obowiązki, szczególnie w przypadku systemów wysokiego ryzyka oraz w odniesieniu do wymaganych kompetencji AI pracowników, wymagają proaktywnej dyskusji i wdrażania solidnych struktur zarządzania. Obszar napięcia między dążeniem do innowacji a potrzebą rozliczalności musi zostać rozwiązany przez zintegrowaną strategię, która postrzega zgodność i etykę jako integralną część procesu innowacji.

Możliwe zastosowania sztucznej inteligencji są zróżnicowane i w różnych branżach. Identyfikacja odpowiednich przypadków użycia, kontrola skutecznych technik interakcji, takich jak monitowanie i świadome zastosowanie aplikacji cieni, są kluczowymi kompetencjami w celu wdrożenia wartości dodanej AI we własnym obszarze odpowiedzialności.

Wreszcie AI zmienia się w sposób zrównoważony sposób, podobnie jak prowadzony, pracował razem i żyje kreatywność. Menedżerowie są zobowiązani do dostosowania swoich umiejętności, aby bardziej skupić się na ludzkich umiejętnościach, takich jak empatia, krytyczne myślenie i zarządzanie zmianami oraz stworzyć kulturę, w której ludzie i maszyna pracują synergicznie. Promowanie współpracy i integracja sztucznej inteligencji jako kreatywnego partnera wymagają nowych sposobów myślenia i zarządzania.

Ustanowienie kompleksowego rządu AI nie jest opcjonalnym akcesorium, ale strategiczną koniecznością. Tworzy ramy etycznego, przejrzystego i bezpiecznego korzystania z AI, minimalizuje ryzyko i buduje zaufanie we wszystkich zainteresowanych stronach.

Transformacja AI to podróż, która wymaga ciągłego uczenia się, zdolności adaptacyjnych i jasnej wizji. Specjaliści i menedżerowie, którzy stoją przed tymi wyzwaniami i internalizują przedstawione tutaj zasady i praktyki, są dobrze przygotowani do zaprojektowania przyszłości swoich organizacji, obszarów i zespołów i pewnie w dobie sztucznej inteligencji.