Veröffentlicht am: 17. April 2025 / Update vom: 17. April 2025 – Verfasser: Konrad Wolfenstein

KI-Modell GPT-4.1 & mini & nano von OpenAI: Programmier-Boost für die Softwareentwicklung – Das Ende von GPT-4.5? – Bild: Xpert.Digital

OpenAI senkt Preise und verbessert GPT-4.1 massiv – Das kann die neue KI-Generation wirklich!

GPT-4.1 im Detail: Alle Neuerungen und Verbesserungen auf einen Blick

OpenAI hat eine bedeutende Weiterentwicklung seiner KI-Technologie vorgestellt: Die GPT-4.1-Modellfamilie repräsentiert einen wichtigen Fortschritt in der maschinellen Sprachverarbeitung und bietet erhebliche Verbesserungen bei gleichzeitiger Kostenreduzierung. Die neue Modelllinie umfasst drei Varianten mit unterschiedlichen Leistungsmerkmalen und Preisniveaus, alle mit einem erweiterten Wissensstand bis Juni 2024. Die Modelle zeichnen sich insbesondere durch Fortschritte in den Bereichen Programmierung, genauere Befolgung von Anweisungen und ein verbessertes Verständnis umfangreicher Kontexte aus.

Die GPT-4.1-Modellfamilie ist ausschließlich über die API verfügbar und richtet sich primär an Entwickler. Diese Modelle sind nicht direkt in der ChatGPT-Benutzeroberfläche zugänglich.

Passend dazu:

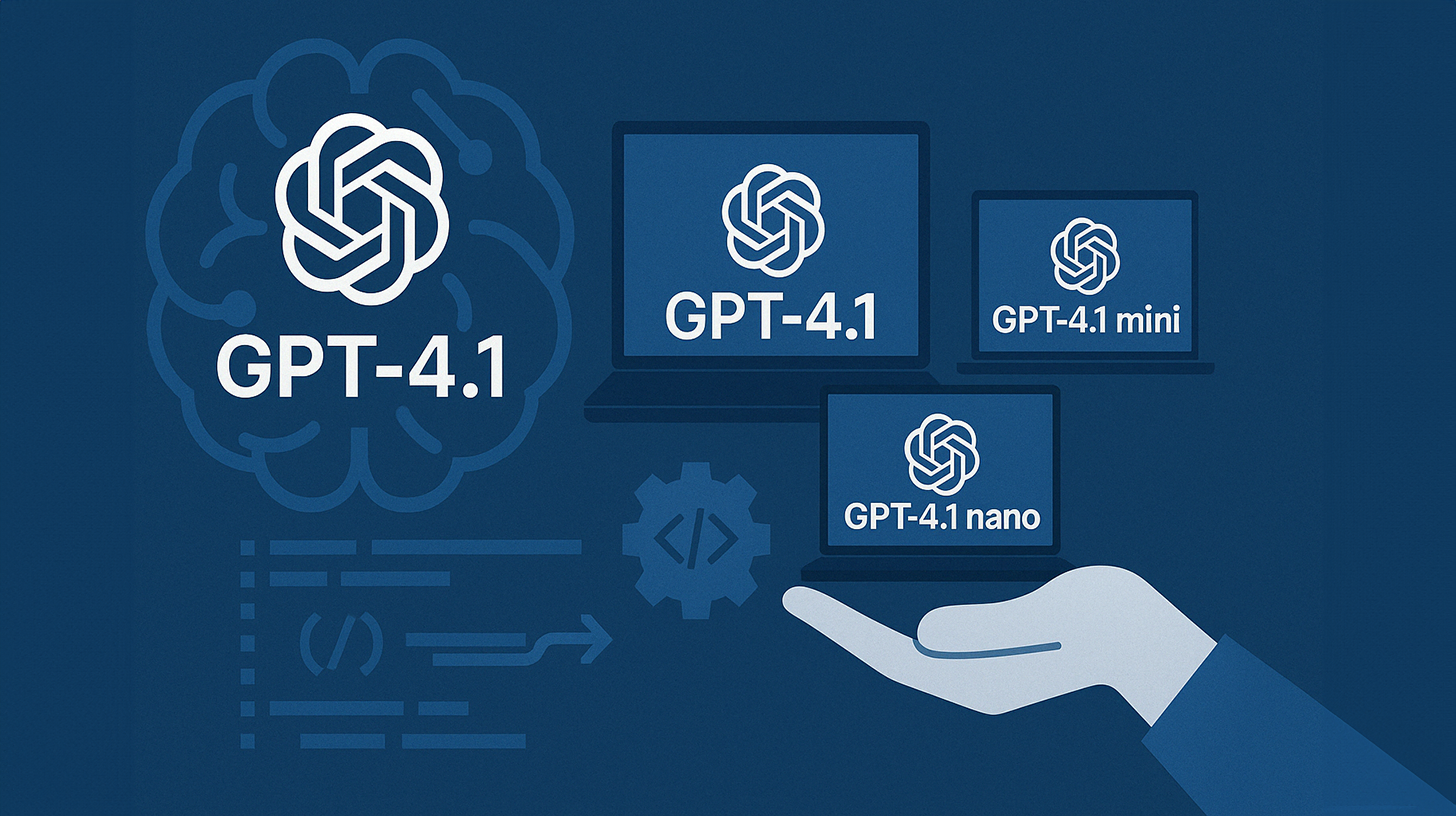

Die drei Varianten der GPT-4.1-Familie

Die neue Modellfamilie besteht aus drei unterschiedlichen Varianten, die jeweils für verschiedene Anwendungsfälle und Anforderungen optimiert wurden:

GPT-4.1: Das Flaggschiff-Modell

GPT-4.1 repräsentiert das leistungsstärkste Modell der Serie und richtet sich primär an professionelle Softwareentwickler und anspruchsvolle Anwendungsfälle. Es bietet die höchste Intelligenz der Familie mit einer Bewertung von 4/4 gemäß OpenAIs interner Skala und ist speziell auf komplexe Aufgaben zugeschnitten. Das Modell eignet sich besonders für wissenschaftliche Forschung, die Analyse komplexer Datensätze, die Entwicklung anspruchsvoller Software-Lösungen und die Erstellung nuancierter kreativer Inhalte. Durch seine herausragende Fähigkeit, Programmcode zu generieren und zu überarbeiten, positioniert sich GPT-4.1 als führendes Modell für Coding-Anwendungen.

GPT-4.1 mini: Der ausgewogene Allrounder

GPT-4.1 mini bietet eine ausgewogene Balance zwischen Intelligenz (Bewertung 3/4), Geschwindigkeit (4/5) und Kosten. Es stellt einen bedeutenden Fortschritt bei kleineren Modellen dar und übertrifft in vielen Benchmarks sogar das bisherige GPT-4o. Mit einer Geschwindigkeit, die fast doppelt so hoch ist wie die des Vorgängers, und Kosten, die bis zu 83% niedriger liegen, positioniert sich dieses Modell als vielseitiger Allrounder für eine breite Palette von Anwendungen. GPT-4.1 mini erreicht eine mit GPT-4o vergleichbare Leistung, allerdings mit geringerer Latenz und deutlich reduzierten Kosten.

GPT-4.1 nano: Effizientes Leichtgewicht

GPT-4.1 nano ist das schnellste und kostengünstigste Modell der Familie und wurde für latenzkritische oder besonders kostensensitive Anwendungen entwickelt. Es eignet sich hervorragend für einfachere Aufgaben wie Klassifikation, Autovervollständigung und Informationsextraktion. Trotz seiner kompakten Größe unterstützt es das volle Kontextfenster von einer Million Tokens und liefert beeindruckende Ergebnisse bei spezifischen Benchmarks wie MMLU (80,1%) und GPQA (50,3%).

Technische Verbesserungen und Leistungssteigerungen

Die GPT-4.1-Modellfamilie bringt signifikante technische Verbesserungen gegenüber den Vorgängermodellen:

Erweitertes Kontextfenster

Alle drei Modelle der GPT-4.1-Familie unterstützen ein erweitertes Kontextfenster von bis zu einer Million Tokens, was einer achtfachen Steigerung gegenüber früheren Versionen entspricht. Diese Erweiterung ermöglicht die Verarbeitung sehr umfangreicher Dokumente oder Codebases in einem einzigen Durchgang – zum Vergleich: der gesamte React-Quellcode würde achtmal in diesen Kontext passen. Die Modelle können somit bis zu etwa 750.000 Wörter in einer einzigen Anfrage verarbeiten.

Verbesserte Programmier- und Coding-Fähigkeiten

GPT-4.1 zeichnet sich durch deutlich verbesserte Programmier- und Coding-Fähigkeiten aus. Im SWE-bench Verified Benchmark erreicht das Modell einen beeindruckenden Score von 54,6%, was eine Verbesserung von 21,4 Prozentpunkten gegenüber GPT-4o und 26,6 Prozentpunkten gegenüber GPT-4.5 darstellt. Die Modelle können komplexere Programmieraufgaben bewältigen und präziseren Code in verschiedenen Programmiersprachen erstellen. Besonders hervorzuheben ist die Fähigkeit zur Front-end-Codierung mit minimaler Nachbearbeitung, wobei die menschlichen Bewerter in 80% der Fälle das Ergebnis von GPT-4.1 bevorzugten.

Optimierte Befolgung von Anweisungen

Eine der herausragenden Verbesserungen der GPT-4.1-Familie ist die präzisere Befolgung von Anweisungen. Auf der MultiChallenge-Benchmark, die die Fähigkeit zur Befolgung von Anweisungen misst, erzielt GPT-4.1 38,3%, was einer Steigerung von 10,5 Prozentpunkten gegenüber GPT-4o entspricht. Bei OpenAIs internem Instruction Following Test (Hard Subset) erreicht GPT-4.1 beeindruckende 49,1% gegenüber nur 29,2% bei GPT-4o. Dies bedeutet in der Praxis, dass GPT-4.1 deutlich besser darin ist, geordnete Schritte einzuhalten, fehlerhafte Eingaben abzulehnen und in dem gewünschten Format zu antworten.

Leistungsvergleiche im Benchmark-Kontext

Die Leistungsfähigkeit der neuen Modelle lässt sich anhand verschiedener Benchmarks quantifizieren:

Coding-Benchmarks

Im SWE-bench Verified Benchmark, der 500 von Menschen als lösbar klassifizierte Programmieraufgaben umfasst, erzielt GPT-4.1 mit 54,6% ein beeindruckendes Ergebnis. Obwohl es damit hinter vergleichbaren Modellen von Google (Gemini 2.5 Pro) und Anthropic (Claude 3.7 Sonnet), die beide etwa 63% erreichen, zurückbleibt, übertrifft es andere OpenAI-Modelle deutlich: GPT-4o (November 2024) erreichte 33%, GPT-4.5 38% und OpenAI o3-mini 49%.

Bei Aider’s Polyglot Benchmark, der die Fähigkeit zur Überarbeitung von Code in verschiedenen Programmiersprachen testet, erreicht GPT-4.1 etwa 53% der 225 Probleme, womit es hinter OpenAI o1 und o3-mini (jeweils etwa 60%) liegt, aber vor GPT-4o (18%).

Instruction-Following-Benchmarks

Im Bereich der Anweisungsbefolgung zeigt GPT-4.1 ebenfalls erhebliche Fortschritte. Bei IFEval, das die Einhaltung klar definierter Leistungsanforderungen prüft, erreicht GPT-4.1 87,4%, eine deutliche Verbesserung gegenüber GPT-4o mit 81%. Diese Verbesserungen umfassen verschiedene Aspekte der Anweisungsbefolgung, darunter Formatvorgaben, negative Anweisungen, geordnete Anweisungen, Inhaltsanforderungen und Rangfolgen.

Langkontext-Benchmarks

Bei Video-MME, einem Benchmark für multimodales Langkontextverständnis, setzt GPT-4.1 mit 72,0% in der Kategorie “lang, ohne Untertitel” einen neuen Maßstab, was eine Verbesserung von 6,7 Prozentpunkten gegenüber GPT-4o darstellt. Im Graphwalks-Benchmark, der mehrstufiges Schlussfolgern in langen Kontexten testet, erreicht GPT-4.1 61,7% – ein deutlicher Sprung gegenüber GPT-4o mit 41,7%.

Preisgestaltung und Kosteneffizienz

Ein wesentlicher Aspekt der GPT-4.1-Modellfamilie ist ihre verbesserte Kosteneffizienz:

Preismodelle der drei Varianten

Die Preisgestaltung der GPT-4.1-Familie differenziert zwischen Input-Tokens (an die API gesendete Tokens), Output-Tokens (vom Modell generierte Antworten) und Cached Input-Tokens (für wiederholte Anfragen):

- GPT-4.1: $2.00 pro Million Input-Tokens, $0.50 pro Million Cached Input-Tokens, $8.00 pro Million Output-Tokens

- GPT-4.1 mini: $0.40 pro Million Input-Tokens, $0.10 pro Million Cached Input-Tokens, $1.60 pro Million Output-Tokens

- GPT-4.1 nano: $0.10 pro Million Input-Tokens, $0.025 pro Million Cached Input-Tokens, $0.40 pro Million Output-Tokens

Kostenersparnisse gegenüber Vorgängermodellen

Die neue Modellfamilie bietet erhebliche Kostenvorteile: GPT-4.1 ist 26% günstiger als sein Vorgänger bei durchschnittlichen Anfragen. GPT-4.1 mini ist sogar 83% günstiger als GPT-4o bei ähnlicher oder besserer Leistung. GPT-4.1 nano positioniert sich als das kostengünstigste Modell im Portfolio von OpenAI.

Prompt-Caching und weitere Optimierungen

Für wiederkehrende Kontextanfragen wurde der Prompt-Caching-Rabatt auf 75% erhöht (früher 50%), was zusätzliche Kosteneinsparungen ermöglicht. Zudem bietet OpenAI lange Kontextanfragen ohne zusätzliche Kosten jenseits der standardmäßigen Token-Kosten an.

Passend dazu:

Anwendungsfälle und Einsatzmöglichkeiten

Die verschiedenen Modelle der GPT-4.1-Familie eignen sich für unterschiedliche Anwendungsfälle:

Anwendungen für Software-Entwickler

GPT-4.1 richtet sich primär an Software-Entwickler und bietet erhebliche Vorteile bei der Programmierung. Es eignet sich besonders für die Front-end-Codierung, bei der weniger Nachbearbeitung erforderlich ist, und für die Entwicklung von Schnittstellen, wo es sich für die Überarbeitung einzelner Codeblöcke anbietet, ohne die gesamte Datei zu ersetzen. Die Modelle können komplexere Programmieraufgaben bewältigen und präziseren Code in verschiedenen Programmiersprachen erstellen.

Unternehmensanwendungen

Für Unternehmen bietet die GPT-4.1-Familie vielseitige Einsatzmöglichkeiten. Das Flaggschiff-Modell GPT-4.1 eignet sich für wissenschaftliche Forschung, die Analyse komplexer Datensätze, die Entwicklung anspruchsvoller Software-Lösungen und die Erstellung nuancierter kreativer Inhalte. GPT-4.1 mini bietet eine ausgewogene Balance für alltägliche Anwendungen, während GPT-4.1 nano sich ideal für kostensensitive Aufgaben wie Klassifikation oder Autovervollständigung eignet.

Modellspezifische Anwendungsfälle

Jedes Modell der Familie hat spezifische Stärken:

- GPT-4.1: Ideal für komplexe Coding-Workflows, die Verarbeitung großer Dokumente und anspruchsvolle Aufgaben mit mehreren Schritten

- GPT-4.1 mini: Geeignet für interaktive Tools, die schnelle Antworten erfordern, bei gleichzeitig ausreichender Intelligenz, um detaillierte Anweisungen zu befolgen

- GPT-4.1 nano: Optimal für Aufgaben wie Autovervollständigung, Klassifikation und Informationsextraktion aus großen Dokumenten, bei denen Geschwindigkeit und Kosteneffizienz im Vordergrund stehen

Verfügbarkeit und Zukunftsaussichten

API-Verfügbarkeit und Integration

Die GPT-4.1-Modellfamilie ist ausschließlich über die OpenAI API verfügbar. Eine direkte Integration in ChatGPT ist laut OpenAI nicht geplant. Dennoch wurden einige Verbesserungen von GPT-4.1 bereits in die GPT-4o-Version des Chatbots überführt, und weitere Funktionen werden schrittweise hinzugefügt.

Fine-Tuning-Optionen

OpenAI bietet Fine-Tuning-Unterstützung für GPT-4.1 und GPT-4.1 mini ab dem Tag der Markteinführung an, während die Unterstützung für GPT-4.1 nano in Planung ist. Dies eröffnet zusätzliche Möglichkeiten für die Anpassung der Modelle an spezifische Geschäftsanforderungen und Anwendungsfälle.

Auswirkungen auf bestehende Modelle

Mit der Einführung von GPT-4.1 hat OpenAI angekündigt, die Unterstützung für das GPT-4.5-Modell in der API zu beenden, da GPT-4.1 ähnliche Funktionen unter günstigeren Bedingungen bietet. Dies unterstreicht die strategische Neuausrichtung von OpenAI auf leistungsfähigere und gleichzeitig kosteneffizientere Modelle.

Maßgeschneiderte KI-Power: GPT-4.1, Mini und Nano – Die perfekte KI-Lösung für jeden Bedarf

Die GPT-4.1-Modellfamilie repräsentiert einen bedeutenden Fortschritt in der KI-Technologie von OpenAI. Durch die Kombination aus verbesserter Leistung, erweiterten Funktionen und niedrigeren Kosten adressiert sie direkt die praktischen Anforderungen von Entwicklern und Unternehmen. Die Fokussierung auf Programmierung, präzisere Anweisungsbefolgung und erweitertes Kontextverständnis unterstreicht OpenAIs Bestreben, KI-Modelle zu entwickeln, die effektiver in realen Szenarien eingesetzt werden können.

Die differenzierte Positionierung der drei Modellvarianten ermöglicht es Nutzern, je nach Anforderung und Budget die passende Lösung zu wählen. Während GPT-4.1 für anspruchsvollste Aufgaben konzipiert ist, bieten GPT-4.1 mini und GPT-4.1 nano kosteneffiziente Alternativen für spezifische Anwendungsbereiche. Diese Strategie könnte dazu beitragen, die Verbreitung von KI-Technologien in unterschiedlichen Branchen und Anwendungsbereichen weiter zu beschleunigen.

Mit dieser Modellfamilie macht OpenAI einen weiteren Schritt in Richtung der Vision, KI-Systeme zu entwickeln, die als “agentic software engineer” fungieren können – also als eigenständige KI-Agenten, die komplexe Aufgaben von der Entwicklung bis zur Qualitätssicherung übernehmen können. Die Verbesserungen in der GPT-4.1-Familie könnten somit als wichtige Bausteine für die nächste Generation von KI-Anwendungen betrachtet werden.

Ihr globaler Marketing und Business Development Partner

☑️ Unsere Geschäftssprache ist Englisch oder Deutsch

☑️ NEU: Schriftverkehr in Ihrer Landessprache!

Gerne stehe ich Ihnen und mein Team als persönlicher Berater zur Verfügung.

Sie können mit mir Kontakt aufnehmen, indem Sie hier das Kontaktformular ausfüllen oder rufen Sie mich einfach unter +49 89 89 674 804 (München) an. Meine E-Mail Adresse lautet: wolfenstein∂xpert.digital

Ich freue mich auf unser gemeinsames Projekt.