AI e SEO con BERT – Bidirection Encoder Representations from Transformers – modello nel campo dell’elaborazione del linguaggio naturale (NLP)

Selezione vocale 📢

Pubblicato il: 4 ottobre 2024 / aggiornamento dal: 4 ottobre 2024 - Autore: Konrad Wolfenstein

AI e SEO con BERT – Rappresentazioni di encoder bidirezionali da Transformers – Modello nel campo dell'elaborazione del linguaggio naturale (NLP) – Immagine: Xpert.Digital

🚀💬 Sviluppato da Google: BERT e la sua importanza per la PNL - Perché la comprensione bidirezionale del testo è fondamentale

🔍🗣️ BERT, abbreviazione di Bidirection Encoder Representations from Transformers, è un modello importante nel campo dell'elaborazione del linguaggio naturale (NLP) sviluppato da Google. Ha rivoluzionato il modo in cui le macchine comprendono il linguaggio. A differenza dei modelli precedenti che analizzavano il testo in sequenza da sinistra a destra o viceversa, BERT consente l'elaborazione bidirezionale. Ciò significa che cattura il contesto di una parola sia dalla sequenza di testo precedente che da quella successiva. Questa capacità migliora significativamente la comprensione di contesti linguistici complessi.

🔍L'architettura di BERT

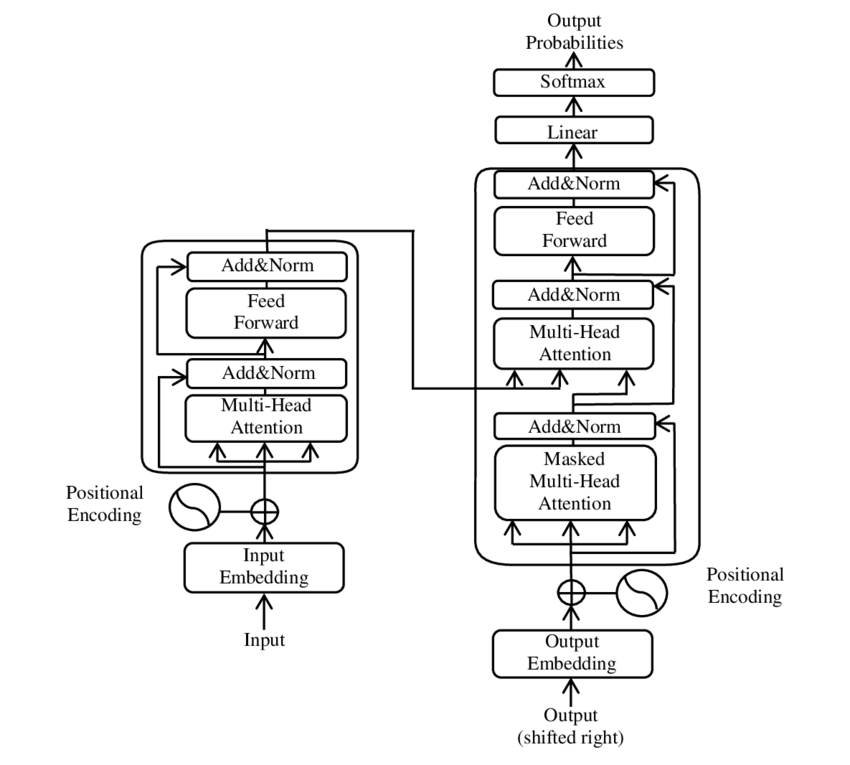

Negli ultimi anni, uno degli sviluppi più significativi nel campo dell'elaborazione del linguaggio naturale (NLP) si è verificato con l'introduzione del modello Transformer, come presentato nel documento PDF 2017 - L'attenzione è tutto ciò che serve - ( Wikipedia ). Questo modello ha cambiato radicalmente il campo abbandonando le strutture precedentemente utilizzate, come la traduzione automatica. Si basa invece esclusivamente su meccanismi di attenzione. Da allora, il design del Transformer ha costituito la base per molti modelli che rappresentano lo stato dell'arte in vari settori come la generazione del linguaggio, la traduzione e altro ancora.

BERT si basa su questa architettura Transformer. Questa architettura utilizza i cosiddetti meccanismi di auto-attenzione per analizzare le relazioni tra le parole in una frase. L'attenzione viene prestata a ciascuna parola nel contesto dell'intera frase, con il risultato di una comprensione più precisa delle relazioni sintattiche e semantiche.

Gli autori del documento "L'attenzione è tutto ciò che ti serve" sono:

- Ashish Vaswani (cervello di Google)

- Noam Shazeer (Google Brain)

- Niki Parmar (Ricerca Google)

- Jakob Uszkoreit (Ricerca Google)

- Lion Jones (Ricerca Google)

- Aidan N. Gomez (Università di Toronto, lavoro parzialmente svolto presso Google Brain)

- Lukasz Kaiser (cervello di Google)

- Illia Polosukhin (indipendente, precedente lavoro presso Google Research)

Questi autori hanno contribuito in modo significativo allo sviluppo del modello Transformer presentato in questo articolo.

🔄 Elaborazione bidirezionale

Una caratteristica distintiva di BERT è la sua capacità di elaborazione bidirezionale. Mentre i modelli tradizionali come le reti neurali ricorrenti (RNN) o le reti di memoria a lungo termine (LSTM) elaborano il testo solo in una direzione, BERT analizza il contesto di una parola in entrambe le direzioni. Ciò consente al modello di catturare meglio le sottili sfumature di significato e quindi di effettuare previsioni più accurate.

🕵️♂️ Modellazione del linguaggio mascherato

Un altro aspetto innovativo di BERT è la tecnica Masked Language Model (MLM). Si tratta di mascherare parole selezionate casualmente in una frase e addestrare il modello a prevedere queste parole in base al contesto circostante. Questo metodo costringe BERT a sviluppare una profonda comprensione del contesto e del significato di ogni parola nella frase.

🚀 Formazione e personalizzazione di BERT

BERT attraversa un processo di formazione in due fasi: pre-formazione e perfezionamento.

📚Pre-allenamento

Nella pre-formazione, BERT viene addestrato con grandi quantità di testo per apprendere modelli linguistici generali. Ciò include testi di Wikipedia e altri corpora di testi estesi. In questa fase, il modello apprende strutture e contesti linguistici di base.

🔧 Messa a punto

Dopo la formazione preliminare, BERT viene personalizzato per attività NLP specifiche, come la classificazione del testo o l'analisi del sentiment. Il modello viene addestrato con set di dati più piccoli relativi alle attività per ottimizzarne le prestazioni per applicazioni specifiche.

🌍 Aree di applicazione del BERT

BERT si è dimostrato estremamente utile in numerose aree dell'elaborazione del linguaggio naturale:

Ottimizzazione per i motori di ricerca

Google utilizza BERT per comprendere meglio le query di ricerca e mostrare risultati più pertinenti. Ciò migliora notevolmente l'esperienza dell'utente.

Classificazione del testo

BERT può classificare i documenti per argomento o analizzare lo stato d'animo dei testi.

Riconoscimento di entità denominate (NER)

Il modello identifica e classifica le entità denominate nei testi, come nomi di persone, luoghi o organizzazioni.

Sistemi di domande e risposte

BERT viene utilizzato per fornire risposte precise alle domande poste.

🧠 L'importanza di BERT per il futuro dell'IA

BERT ha stabilito nuovi standard per i modelli PNL e ha aperto la strada a ulteriori innovazioni. Grazie alla sua capacità di elaborazione bidirezionale e alla profonda comprensione del contesto linguistico, ha aumentato significativamente l’efficienza e la precisione delle applicazioni IA.

🔜 Sviluppi futuri

L’ulteriore sviluppo del BERT e di modelli simili mirerà probabilmente a creare sistemi ancora più potenti. Questi potrebbero gestire compiti linguistici più complessi ed essere utilizzati in una varietà di nuove aree di applicazione. L’integrazione di tali modelli nelle tecnologie quotidiane potrebbe cambiare radicalmente il modo in cui interagiamo con i computer.

🌟 Pietra miliare nello sviluppo dell'intelligenza artificiale

BERT rappresenta una pietra miliare nello sviluppo dell’intelligenza artificiale e ha rivoluzionato il modo in cui le macchine elaborano il linguaggio naturale. La sua architettura bidirezionale consente una comprensione più profonda delle relazioni linguistiche, rendendolo indispensabile per una varietà di applicazioni. Con l’avanzare della ricerca, modelli come BERT continueranno a svolgere un ruolo centrale nel miglioramento dei sistemi di intelligenza artificiale e nell’apertura di nuove possibilità per il loro utilizzo.

📣 Argomenti simili

- 📚 Presentazione di BERT: il modello PNL rivoluzionario

- 🔍 BERT e il ruolo della bidirezionalità nella PNL

- 🧠 Il modello Transformer: caposaldo del BERT

- 🚀 Modellazione del linguaggio mascherato: la chiave del successo di BERT

- 📈 Personalizzazione di BERT: dalla pre-formazione alla messa a punto

- 🌐 Gli ambiti di applicazione del BERT nella tecnologia moderna

- 🤖 L'influenza di BERT sul futuro dell'intelligenza artificiale

- 💡 Prospettive future: ulteriori sviluppi di BERT

- 🏆 BERT come pietra miliare nello sviluppo dell'IA

- 📰 Autori del documento Transformer “L'attenzione è tutto ciò di cui hai bisogno”: le menti dietro BERT

#️⃣ Hashtag: #PNL #IntelligenzaArtificiale #Modellazione del Linguaggio #Transformer #MachineLearning

🎯🎯🎯 Approfittate della quintuplice competenza estesa di Xpert.Digital in un pacchetto di servizi completo | Ricerca e sviluppo, XR, PR e SEM

Macchina per il rendering 3D AI e XR: la quintuplice esperienza di Xpert.Digital in un pacchetto di servizi completo, R&D XR, PR e SEM - Immagine: Xpert.Digital

Xpert.Digital ha una conoscenza approfondita di vari settori. Questo ci consente di sviluppare strategie su misura che si adattano esattamente alle esigenze e alle sfide del vostro specifico segmento di mercato. Analizzando continuamente le tendenze del mercato e seguendo gli sviluppi del settore, possiamo agire con lungimiranza e offrire soluzioni innovative. Attraverso la combinazione di esperienza e conoscenza, generiamo valore aggiunto e diamo ai nostri clienti un vantaggio competitivo decisivo.

Maggiori informazioni qui:

BERT: tecnologia rivoluzionaria 🌟 PNL

🚀 BERT, abbreviazione di Bidirection Encoder Representations from Transformers, è un modello linguistico avanzato sviluppato da Google che è diventato un passo avanti significativo nel campo dell'elaborazione del linguaggio naturale (NLP) sin dal suo lancio nel 2018. Si basa sull'architettura Transformer, che ha rivoluzionato il modo in cui le macchine comprendono ed elaborano il testo. Ma cosa rende BERT così speciale e a cosa serve esattamente? Per rispondere a questa domanda, dobbiamo approfondire i principi tecnici, le funzionalità e le aree di applicazione di BERT.

📚 1. Le basi dell'elaborazione del linguaggio naturale

Per comprendere appieno il significato di BERT, è utile rivedere brevemente le basi dell'elaborazione del linguaggio naturale (PNL). La PNL si occupa dell'interazione tra computer e linguaggio umano. L’obiettivo è insegnare alle macchine ad analizzare, comprendere e rispondere ai dati di testo. Prima dell’introduzione di modelli come BERT, l’elaborazione automatica del linguaggio spesso presentava sfide significative, in particolare a causa dell’ambiguità, della dipendenza dal contesto e della struttura complessa del linguaggio umano.

📈 2. Lo sviluppo di modelli di PNL

Prima che BERT entrasse in scena, la maggior parte dei modelli PNL erano basati sulle cosiddette architetture unidirezionali. Ciò significa che questi modelli leggono il testo solo da sinistra a destra o da destra a sinistra, il che significa che potevano prendere in considerazione solo una quantità limitata di contesto durante l’elaborazione di una parola in una frase. Questa limitazione spesso faceva sì che i modelli non catturassero completamente l’intero contesto semantico di una frase. Ciò ha reso difficile interpretare accuratamente parole ambigue o sensibili al contesto.

Un altro importante sviluppo nella ricerca sulla PNL prima del BERT è stato il modello word2vec, che ha permesso ai computer di tradurre le parole in vettori che riflettevano somiglianze semantiche. Ma anche qui il contesto era limitato alle immediate vicinanze di una parola. Successivamente sono stati sviluppati i modelli di Reti Neurali Ricorrenti (RNN) e in particolare di Memoria a Breve Termine (LSTM), che hanno permesso di comprendere meglio le sequenze di testo memorizzando informazioni su più parole. Tuttavia, questi modelli avevano anche i loro limiti, in particolare quando si trattava di testi lunghi e si comprendeva il contesto in entrambe le direzioni contemporaneamente.

🔄 3. La rivoluzione attraverso l'architettura Transformer

La svolta è arrivata con l’introduzione dell’architettura Transformer nel 2017, che costituisce la base per BERT. I modelli Transformer sono progettati per consentire l'elaborazione parallela del testo, tenendo conto del contesto di una parola sia del testo precedente che di quello successivo. Ciò avviene attraverso i cosiddetti meccanismi di auto-attenzione, che assegnano un valore di peso a ciascuna parola in una frase in base a quanto sia importante rispetto alle altre parole della frase.

A differenza degli approcci precedenti, i modelli Transformer non sono unidirezionali, ma bidirezionali. Ciò significa che possono estrarre informazioni sia dal contesto sinistro che da quello destro di una parola, producendo una rappresentazione più completa e accurata della parola e del suo significato.

🧠 4. BERT: Un modello bidirezionale

BERT porta le prestazioni dell'architettura Transformer a un nuovo livello. Il modello è progettato per catturare il contesto di una parola non solo da sinistra a destra o da destra a sinistra, ma in entrambe le direzioni contemporaneamente. Ciò consente a BERT di considerare l’intero contesto di una parola all’interno di una frase, con conseguente miglioramento significativo della precisione nelle attività di elaborazione del linguaggio.

Una caratteristica centrale di BERT è l’uso del cosiddetto Masked Language Model (MLM). Nell'addestramento di BERT, le parole selezionate casualmente in una frase vengono sostituite con una maschera e il modello viene addestrato a indovinare queste parole mascherate in base al contesto. Questa tecnica consente a BERT di apprendere relazioni più profonde e precise tra le parole in una frase.

Inoltre, BERT utilizza un metodo chiamato Next Sentence Prediction (NSP), in cui il modello impara a prevedere se una frase ne segue un'altra oppure no. Ciò migliora la capacità di BERT di comprendere testi più lunghi e di riconoscere relazioni più complesse tra frasi.

🌐 5. Applicazione del BERT nella pratica

BERT si è dimostrato estremamente utile per una varietà di compiti di PNL. Ecco alcuni dei principali ambiti di applicazione:

📊 a) Classificazione del testo

Uno degli usi più comuni di BERT è la classificazione dei testi, in cui i testi sono divisi in categorie predefinite. Esempi di ciò includono l'analisi del sentiment (ad esempio riconoscere se un testo è positivo o negativo) o la categorizzazione del feedback dei clienti. BERT può fornire risultati più precisi rispetto ai modelli precedenti grazie alla sua profonda comprensione del contesto delle parole.

❓b) Sistemi di domanda-risposta

BERT viene utilizzato anche nei sistemi domanda-risposta, dove il modello estrae le risposte alle domande poste da un testo. Questa capacità è particolarmente importante in applicazioni come motori di ricerca, chatbot o assistenti virtuali. Grazie alla sua architettura bidirezionale, BERT può estrarre informazioni rilevanti da un testo, anche se la domanda è formulata indirettamente.

🌍 c) Traduzione del testo

Sebbene BERT in sé non sia progettato direttamente come modello di traduzione, può essere utilizzato in combinazione con altre tecnologie per migliorare la traduzione automatica. Comprendendo meglio le relazioni semantiche in una frase, BERT può aiutare a generare traduzioni più accurate, soprattutto per formulazioni ambigue o complesse.

🏷️ d) Riconoscimento delle entità nominate (NER)

Un altro ambito di applicazione è il Named Entity Recognition (NER), che consiste nell’identificare entità specifiche come nomi, luoghi o organizzazioni in un testo. BERT si è dimostrato particolarmente efficace in questo compito perché tiene pienamente conto del contesto di una frase, migliorandola nel riconoscere le entità anche se hanno significati diversi in contesti diversi.

✂️ e) Riepilogo del testo

La capacità di BERT di comprendere l'intero contesto di un testo lo rende anche un potente strumento per il riepilogo automatico del testo. Può essere utilizzato per estrarre le informazioni più importanti da un testo lungo e creare un riassunto conciso.

🌟 6. L'importanza del BERT per la ricerca e l'industria

L’introduzione di BERT ha inaugurato una nuova era nella ricerca sulla PNL. È stato uno dei primi modelli a sfruttare appieno la potenza dell'architettura bidirezionale Transformer, fissando lo standard per molti modelli successivi. Molte aziende e istituti di ricerca hanno integrato BERT nelle loro pipeline di PNL per migliorare le prestazioni delle loro applicazioni.

Inoltre il BERT ha aperto la strada ad ulteriori innovazioni nel campo dei modelli linguistici. Ad esempio, successivamente sono stati sviluppati modelli come GPT (Generative Pretrained Transformer) e T5 (Text-to-Text Transfer Transformer), che si basano su principi simili ma offrono miglioramenti specifici per diversi casi d’uso.

🚧 7. Sfide e limiti del BERT

Nonostante i suoi numerosi vantaggi, BERT presenta anche alcune sfide e limitazioni. Uno degli ostacoli maggiori è l’elevato sforzo computazionale richiesto per addestrare e applicare il modello. Poiché BERT è un modello molto grande con milioni di parametri, richiede hardware potente e risorse di calcolo significative, soprattutto quando si elaborano grandi quantità di dati.

Un altro problema è la potenziale distorsione che potrebbe esistere nei dati di addestramento. Poiché BERT è addestrato su grandi quantità di dati di testo, a volte riflette i pregiudizi e gli stereotipi presenti in tali dati. Tuttavia, i ricercatori lavorano continuamente per identificare e affrontare questi problemi.

🔍 Strumento essenziale per le moderne applicazioni di elaborazione linguistica

BERT ha migliorato significativamente il modo in cui le macchine comprendono il linguaggio umano. Con la sua architettura bidirezionale e metodi di formazione innovativi, è in grado di catturare in modo profondo e accurato il contesto delle parole in una frase, garantendo una maggiore precisione in molti compiti di PNL. Che si tratti di classificazione di testi, sistemi di domande-risposte o riconoscimento di entità, BERT si è affermato come uno strumento indispensabile per le moderne applicazioni di elaborazione linguistica.

La ricerca sull’elaborazione del linguaggio naturale continuerà senza dubbio a progredire e BERT ha gettato le basi per molte innovazioni future. Nonostante le sfide e i limiti esistenti, BERT mostra in modo impressionante quanta strada ha fatto la tecnologia in breve tempo e quali interessanti opportunità si apriranno ancora in futuro.

🌀 Il trasformatore: una rivoluzione nell'elaborazione del linguaggio naturale

🌟 Negli ultimi anni, uno degli sviluppi più significativi nel campo dell'elaborazione del linguaggio naturale (PNL) è stata l'introduzione del modello Transformer, come descritto nel documento del 2017 "L'attenzione è tutto ciò di cui hai bisogno". Questo modello ha cambiato radicalmente il campo scartando le strutture ricorrenti o convoluzionali precedentemente utilizzate per attività di trasduzione di sequenze come la traduzione automatica. Si basa invece esclusivamente su meccanismi di attenzione. Da allora, il design del Transformer ha costituito la base per molti modelli che rappresentano lo stato dell'arte in vari settori come la generazione del linguaggio, la traduzione e altro ancora.

🔄 Il Trasformatore: un cambio di paradigma

Prima dell'introduzione del Transformer, la maggior parte dei modelli per le attività di sequenziamento erano basati su reti neurali ricorrenti (RNN) o reti di memoria a lungo termine (LSTM), che sono intrinsecamente sequenziali. Questi modelli elaborano i dati di input passo dopo passo, creando stati nascosti che si propagano lungo la sequenza. Sebbene questo metodo sia efficace, è computazionalmente costoso e difficile da parallelizzare, soprattutto per sequenze lunghe. Inoltre, le RNN hanno difficoltà ad apprendere le dipendenze a lungo termine a causa del cosiddetto problema del “gradiente di fuga”.

L'innovazione centrale del Transformer risiede nell'uso di meccanismi di auto-attenzione, che consentono al modello di valutare l'importanza delle diverse parole in una frase l'una rispetto all'altra, indipendentemente dalla loro posizione. Ciò consente al modello di catturare le relazioni tra parole ampiamente distanziate in modo più efficace rispetto agli RNN o agli LSTM e di farlo in modo parallelo anziché sequenziale. Ciò non solo migliora l’efficienza della formazione, ma anche le prestazioni in attività come la traduzione automatica.

🧩 Architettura del modello

Il Transformer è costituito da due componenti principali: un codificatore e un decodificatore, entrambi costituiti da più strati e si basano fortemente su meccanismi di attenzione multi-testa.

⚙️ Codificatore

Il codificatore è costituito da sei livelli identici, ciascuno con due sottolivelli:

1. Autoattenzione multi-testa

Questo meccanismo consente al modello di concentrarsi su diverse parti della frase di input mentre elabora ciascuna parola. Invece di calcolare l’attenzione in un unico spazio, l’attenzione multi-testa proietta l’input in diversi spazi diversi, consentendo di catturare diversi tipi di relazioni tra le parole.

2. Reti feedforward completamente connesse in termini di posizione

Dopo il livello di attenzione, una rete feedforward completamente connessa viene applicata in modo indipendente in ciascuna posizione. Ciò aiuta il modello a elaborare ogni parola nel contesto e a utilizzare le informazioni provenienti dal meccanismo di attenzione.

Per preservare la struttura della sequenza di input, il modello contiene anche input posizionali (codifiche posizionali). Poiché il Transformer non elabora le parole in sequenza, queste codifiche sono cruciali nel fornire al modello informazioni sull'ordine delle parole in una frase. Gli input di posizione vengono aggiunti agli incorporamenti di parole in modo che il modello possa distinguere tra le diverse posizioni nella sequenza.

🔍 Decodificatori

Come il codificatore, anche il decodificatore è costituito da sei strati, ciascuno dei quali ha un meccanismo di attenzione aggiuntivo che consente al modello di concentrarsi su parti rilevanti della sequenza di input mentre genera l'output. Il decodificatore utilizza inoltre una tecnica di mascheramento per impedirgli di considerare posizioni future, preservando la natura autoregressiva della generazione della sequenza.

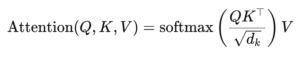

🧠 Attenzione multitesta e attenzione al prodotto punto

Il cuore del Transformer è il meccanismo Multi-Head Attention, che è un'estensione del più semplice sistema di attenzione del prodotto punto. La funzione di attenzione può essere vista come una mappatura tra una query e un insieme di coppie chiave-valore (chiavi e valori), dove ciascuna chiave rappresenta una parola nella sequenza e il valore rappresenta le informazioni contestuali associate.

Il meccanismo di attenzione multi-testa consente al modello di concentrarsi su diverse parti della sequenza contemporaneamente. Proiettando l'input in più sottospazi, il modello può catturare un insieme più ricco di relazioni tra le parole. Ciò è particolarmente utile in attività come la traduzione automatica, dove la comprensione del contesto di una parola richiede molti fattori diversi, come la struttura sintattica e il significato semantico.

La formula per l'attenzione del prodotto scalare è:

Qui (Q) è la matrice delle query, (K) è la matrice chiave e (V) è la matrice dei valori. Il termine (sqrt{d_k}) è un fattore di scala che impedisce ai prodotti scalari di diventare troppo grandi, il che porterebbe a gradienti molto piccoli e ad un apprendimento più lento. La funzione softmax viene applicata per garantire che la somma dei pesi dell'attenzione sia pari a uno.

🚀 Vantaggi del Trasformatore

Il Transformer offre numerosi vantaggi chiave rispetto ai modelli tradizionali come RNN e LSTM:

1. Parallelizzazione

Poiché Transformer elabora tutti i token in una sequenza contemporaneamente, può essere altamente parallelizzato ed è quindi molto più veloce da addestrare rispetto a RNN o LSTM, soprattutto su set di dati di grandi dimensioni.

2. Dipendenze a lungo termine

Il meccanismo di auto-attenzione consente al modello di catturare le relazioni tra parole distanti in modo più efficace rispetto agli RNN, che sono limitati dalla natura sequenziale dei loro calcoli.

3. Scalabilità

Il Transformer può facilmente adattarsi a set di dati molto grandi e sequenze più lunghe senza soffrire dei colli di bottiglia prestazionali associati alle RNN.

🌍 Applicazioni ed effetti

Fin dalla sua introduzione, il Transformer è diventato la base per un’ampia gamma di modelli PNL. Uno degli esempi più notevoli è BERT (Bidirection Encoder Representations from Transformers), che utilizza un'architettura Transformer modificata per raggiungere lo stato dell'arte in molte attività di PNL, tra cui la risposta alle domande e la classificazione del testo.

Un altro sviluppo significativo è GPT (Generative Pretrained Transformer), che utilizza una versione limitata del decoder del Transformer per la generazione del testo. I modelli GPT, incluso GPT-3, vengono ora utilizzati per una varietà di applicazioni, dalla creazione di contenuti al completamento del codice.

🔍 Un modello potente e flessibile

Il Transformer ha cambiato radicalmente il modo in cui affrontiamo i compiti della PNL. Fornisce un modello potente e flessibile che può essere applicato a una varietà di problemi. La sua capacità di gestire dipendenze a lungo termine e l'efficienza della formazione lo hanno reso l'approccio architetturale preferito per molti dei modelli più moderni. Con il progredire della ricerca, probabilmente vedremo ulteriori miglioramenti e aggiustamenti al Transformer, in particolare in aree come l’elaborazione delle immagini e del linguaggio, dove i meccanismi di attenzione mostrano risultati promettenti.

Siamo a vostra disposizione: consulenza, pianificazione, implementazione, gestione del progetto

☑️ Esperto del settore, qui con il proprio hub di settore Xpert.Digital con oltre 2.500 articoli specialistici

Sarei felice di fungere da tuo consulente personale.

Potete contattarmi compilando il modulo di contatto qui sotto o semplicemente chiamandomi al numero +49 89 89 674 804 (Monaco) .

Non vedo l'ora di iniziare il nostro progetto comune.

Xpert.Digital - Konrad Wolfenstein

Xpert.Digital è un hub per l'industria con focus su digitalizzazione, ingegneria meccanica, logistica/intralogistica e fotovoltaico.

Con la nostra soluzione di sviluppo aziendale a 360° supportiamo aziende rinomate dal nuovo business al post-vendita.

Market intelligence, smarketing, marketing automation, sviluppo di contenuti, PR, campagne email, social media personalizzati e lead nurturing fanno parte dei nostri strumenti digitali.

Potete saperne di più su: www.xpert.digital - www.xpert.solar - www.xpert.plus