Leadership nella trasformazione dell'intelligenza artificiale: un report di un workshop per specialisti e manager

Pre-release di Xpert

Selezione vocale 📢

Pubblicato il: 10 maggio 2025 / Aggiornato il: 10 maggio 2025 – Autore: Konrad Wolfenstein

Leadership nella trasformazione dell'intelligenza artificiale: un report di workshop per specialisti e manager – Immagine: Xpert.Digital

Ciò che i leader DEVONO sapere sull'intelligenza artificiale ora: cogliere le opportunità, gestire i rischi, guidare con sicurezza (Tempo di lettura: 32 min / Nessuna pubblicità / Nessun paywall)

Padroneggiare la rivoluzione dell'intelligenza artificiale: un'introduzione per i leader

Il potere trasformativo dell'intelligenza artificiale: riprogettare il lavoro e la creazione di valore

L'intelligenza artificiale (IA) è considerata una tecnologia che, come poche altre, apre nuove possibilità per ripensare radicalmente il lavoro e la creazione di valore. Per le aziende, l'integrazione dell'IA è un passo cruciale verso il successo e la competitività a lungo termine, poiché promuove l'innovazione, aumenta l'efficienza e migliora la qualità. L'impatto economico e sociale dell'IA è significativo; è uno dei temi digitali più importanti del futuro, si sta sviluppando rapidamente e ha un potenziale enorme. Le aziende stanno riconoscendo sempre più i vantaggi dell'automazione e dell'aumento dell'efficienza attraverso l'IA. Non si tratta semplicemente di un cambiamento tecnologico, ma di una trasformazione fondamentale dei modelli di business, dell'ottimizzazione dei processi e delle interazioni con i clienti, rendendo l'adattamento una necessità per la sopravvivenza nel panorama competitivo.

Il tanto citato "potere trasformativo" dell'IA va oltre la semplice introduzione di nuovi strumenti; implica un cambio di paradigma nel pensiero strategico. I leader sono chiamati a rivalutare i processi fondamentali, le proposte di valore e persino le strutture di settore. Chi considera l'IA semplicemente uno strumento di efficienza rischia di trascurarne il più profondo potenziale strategico. Il rapido sviluppo dell'IA coincide con un'attuale carenza di competenze. Ciò crea una duplice sfida: da un lato, c'è un'urgente necessità di un rapido aggiornamento delle competenze per utilizzare l'IA. Dall'altro, l'IA offre l'opportunità di automatizzare le attività e quindi potenzialmente alleviare la carenza di competenze in alcune aree, creando al contempo nuovi requisiti di qualificazione. Ciò richiede una pianificazione della forza lavoro articolata da parte dei leader.

Adatto a:

- L'intelligenza artificiale come motore di crescita aziendale: ulteriori consigli pratici per l'introduzione dell'IA nelle aziende da parte di undici interim manager

Valutare le opportunità e i rischi nell'era dell'intelligenza artificiale

Sebbene i sistemi di intelligenza artificiale offrano opportunità altamente efficaci, sono indissolubilmente legati a rischi che devono essere gestiti. Il dibattito sull'intelligenza artificiale implica la valutazione del suo potenziale significativo rispetto ai pericoli intrinseci, richiedendo un approccio equilibrato per sfruttare i vantaggi e minimizzare gli svantaggi. Le aziende si trovano ad affrontare la sfida di promuovere l'innovazione nel rispetto della privacy dei dati e delle linee guida etiche, rendendo cruciale l'equilibrio tra progresso e conformità.

Questo equilibrio non è una decisione una tantum, ma una necessità strategica continua. Con l'evoluzione delle tecnologie di intelligenza artificiale, ad esempio passando da un'intelligenza artificiale specializzata a capacità più generali, cambierà anche la natura delle opportunità e dei rischi. Ciò richiede una continua rivalutazione e un adattamento della governance e della strategia. La percezione dei rischi e dei benefici dell'intelligenza artificiale può variare considerevolmente all'interno di un'organizzazione. Ad esempio, gli utenti attivi dell'intelligenza artificiale tendono a essere più ottimisti di coloro che non l'hanno ancora adottata. Ciò evidenzia una sfida critica nella gestione del cambiamento per i leader: questo divario di percezione deve essere colmato attraverso la formazione, una comunicazione chiara e la dimostrazione di benefici tangibili, affrontando al contempo le preoccupazioni.

Comprendere il panorama dell'IA: concetti e tecnologie fondamentali

L'intelligenza artificiale generativa (GenAI) e il percorso verso l'intelligenza artificiale generale (AGI)

IA generativa (GenAI)

L'intelligenza artificiale generativa (GenAI) si riferisce a modelli di intelligenza artificiale progettati per generare nuovi contenuti sotto forma di testo scritto, audio, immagini o video, offrendo un'ampia gamma di applicazioni. GenAI aiuta gli utenti a creare contenuti unici e significativi e può funzionare come un sistema intelligente di domande e risposte o come un assistente personale. GenAI sta già rivoluzionando la creazione di contenuti, il marketing e il coinvolgimento dei clienti consentendo la rapida produzione di materiali personalizzati e l'automazione delle risposte.

L'accessibilità immediata e l'ampia gamma di applicazioni della GenAI la rendono spesso l'"intelligenza artificiale di base" per molte organizzazioni. Questa esperienza iniziale plasma la percezione e può favorire o ostacolare una più ampia adozione dell'intelligenza artificiale. I leader devono gestire attentamente queste prime esperienze per creare uno slancio positivo.

Intelligenza Artificiale Generale (AGI)

L'Intelligenza Artificiale Generale (AGI) si riferisce all'intelligenza ipotetica di una macchina in grado di comprendere o apprendere qualsiasi compito intellettuale che un essere umano possa svolgere, imitando così le capacità cognitive umane. Si concentra su sistemi di intelligenza artificiale in grado di svolgere un'ampia gamma di compiti, piuttosto che essere specializzati in uno specifico.

Attualmente, una vera e propria intelligenza artificiale (AGI) non esiste; rimane un concetto e un obiettivo di ricerca. OpenAI, azienda leader in questo campo, definisce l'AGI come "sistemi altamente autonomi che superano gli esseri umani nelle attività economicamente più redditizie". Entro il 2023, solo il primo dei cinque stadi ascendenti dell'AGI, noto come "IA emergente", era considerato raggiunto.

L'ambiguità e le diverse definizioni di AGI suggeriscono che i leader dovrebbero considerarla un orizzonte a lungo termine, potenzialmente trasformativo, piuttosto che una preoccupazione operativa immediata. L'attenzione dovrebbe essere rivolta allo sfruttamento dell'attuale "intelligenza artificiale potente", monitorando strategicamente i progressi dell'AGI. Investimenti eccessivi in scenari di AGI speculativi potrebbero distogliere risorse da opportunità di IA più immediate. L'evoluzione dall'IA specializzata, attraverso l'IA di generazione, alla ricerca in corso sull'AGI implica un crescente grado di autonomia e capacità nei sistemi di IA. Questa tendenza è direttamente correlata alla crescente necessità di solidi quadri etici e di governance, poiché un'IA più potente comporta un maggiore rischio di abusi o conseguenze indesiderate.

Adatto a:

Assistenti AI vs. Agenti AI: definizione di ruoli e capacità

Gli assistenti AI supportano le persone in compiti individuali, rispondono a richieste, rispondono a domande e forniscono suggerimenti. In genere sono reattivi e attendono i comandi umani. I primi assistenti erano basati su regole, ma quelli moderni si basano sull'apprendimento automatico (ML) o su modelli di base. Al contrario, gli agenti AI sono più autonomi e capaci di perseguire obiettivi e prendere decisioni in modo indipendente con un intervento umano minimo. Sono proattivi, possono interagire con l'ambiente e adattarsi attraverso l'apprendimento.

Le principali differenze risiedono nell'autonomia, nella complessità delle attività, nell'interazione con l'utente e nelle capacità decisionali. Gli assistenti forniscono informazioni per il processo decisionale umano, mentre gli agenti possono prendere ed eseguire decisioni. In pratica, gli assistenti migliorano l'esperienza del cliente, supportano le richieste bancarie e semplificano le attività delle risorse umane. Gli agenti, d'altra parte, possono adattarsi al comportamento dell'utente in tempo reale, prevenire proattivamente le frodi e automatizzare processi HR complessi come l'acquisizione di talenti.

La transizione dagli assistenti AI agli agenti AI segna un'evoluzione dall'IA come "strumento" all'IA come "collaboratore" o addirittura come "dipendente autonomo". Ciò ha profonde implicazioni per la progettazione del lavoro, le strutture dei team e le competenze richieste ai dipendenti umani che dovranno sempre più gestire e collaborare con questi agenti intelligenti. Man mano che gli agenti AI diventano più diffusi e capaci di prendere decisioni indipendenti, il "divario di responsabilità" diventa una questione più urgente. Se un agente AI prende una decisione errata, l'assegnazione delle responsabilità diventa complessa. Ciò sottolinea la necessità critica di una solida governance dell'IA che affronti le sfide specifiche dei sistemi autonomi.

Di seguito è riportato un confronto delle caratteristiche distintive più importanti:

Confronto tra assistenti AI e agenti AI

Questa tabella fornisce ai dirigenti una chiara comprensione delle differenze fondamentali per selezionare la tecnologia appropriata per esigenze specifiche e per anticipare i diversi livelli di supervisione e complessità di integrazione.

Un confronto tra assistenti AI e agenti AI rivela differenze significative nelle loro caratteristiche. Mentre gli assistenti AI tendono a essere reattivi e ad attendere i comandi umani, gli agenti AI agiscono in modo proattivo e autonomo, intraprendendo azioni indipendenti. La funzione principale di un assistente AI è eseguire attività su richiesta, mentre un agente AI è concentrato sul raggiungimento di un obiettivo specifico. Nel processo decisionale, gli assistenti AI supportano gli esseri umani, mentre gli agenti AI prendono e implementano decisioni in modo indipendente. Anche il loro comportamento di apprendimento è diverso: gli assistenti AI in genere apprendono in modo limitato e basato sulle versioni, mentre gli agenti AI apprendono in modo adattivo e continuo. Le principali applicazioni degli assistenti AI includono chatbot e recupero di informazioni, mentre gli agenti AI sono utilizzati nell'automazione dei processi, nel rilevamento delle frodi e nella risoluzione di problemi complessi. L'interazione con gli esseri umani richiede un input costante da parte degli assistenti AI, mentre gli agenti AI richiedono solo un intervento umano minimo.

La sala macchine: apprendimento automatico, modelli linguistici di grandi dimensioni (LLM) e modelli di base

Apprendimento automatico (ML)

L'apprendimento automatico è un sottocampo dell'intelligenza artificiale in cui i computer apprendono dai dati e migliorano con l'esperienza senza essere programmati esplicitamente. Gli algoritmi sono addestrati a individuare pattern in grandi set di dati e a prendere decisioni e previsioni basate su questi pattern. I modelli di apprendimento automatico includono l'apprendimento supervisionato (apprendimento da dati etichettati), l'apprendimento non supervisionato (individuazione di pattern in dati non etichettati), l'apprendimento semi-supervisionato (una combinazione di dati etichettati e non etichettati) e l'apprendimento per rinforzo (apprendimento per tentativi ed errori con ricompense). L'apprendimento automatico aumenta l'efficienza, riduce al minimo gli errori e supporta il processo decisionale nelle aziende.

Comprendere i diversi tipi di apprendimento automatico è importante per i manager non solo dal punto di vista tecnico, ma anche per comprendere i requisiti dei dati. L'apprendimento supervisionato, ad esempio, richiede grandi quantità di set di dati di alta qualità ed etichettati, il che ha implicazioni per la strategia e gli investimenti sui dati. Sebbene l'identificazione del problema aziendale debba essere il punto di partenza, l'applicabilità di un particolare tipo di apprendimento automatico dipenderà in larga misura dalla disponibilità e dalla natura dei dati.

Modelli linguistici di grandi dimensioni (LLM)

I modelli linguistici di grandi dimensioni (LLM) sono un tipo di algoritmo di deep learning addestrato su enormi set di dati e frequentemente utilizzato nelle applicazioni di elaborazione del linguaggio naturale (NLP) per rispondere a query in linguaggio naturale. Tra gli esempi figura la serie GPT di OpenAI. Gli LLM possono generare testo simile a quello umano, potenziare chatbot e supportare il servizio clienti automatizzato. Tuttavia, possono anche ereditare imprecisioni e distorsioni dai dati di training, sollevando problemi di copyright e sicurezza.

Il problema della "memorizzazione" negli LLM, dove il testo viene riprodotto letteralmente a partire dai dati di formazione, comporta significativi rischi di copyright e plagio per le aziende che utilizzano contenuti generati dagli LLM. Ciò richiede attenti processi di revisione e la comprensione dell'origine dei risultati degli LLM.

Modelli base

I modelli di base sono modelli di intelligenza artificiale di grandi dimensioni, addestrati su ampi set di dati e adattabili (ottimizzati) per una varietà di attività a valle. Sono caratterizzati da emergenza (capacità inaspettate) e omogeneizzazione (un'architettura comune). Differiscono dai modelli di intelligenza artificiale classici in quanto sono inizialmente indipendenti dal dominio, utilizzano l'apprendimento autosupervisionato, consentono l'apprendimento per trasferimento e sono spesso multimodali (elaborano testo, immagini e audio). I Learning Lifecycle Management (LLM) sono un tipo di modello di base. I vantaggi includono un accesso più rapido al mercato e la scalabilità; tuttavia, le sfide includono la trasparenza (il problema della "scatola nera"), la privacy dei dati e costi elevati o requisiti infrastrutturali.

L'ascesa dei modelli di base segnala un passaggio verso un'IA più versatile e adattabile. Tuttavia, la loro natura di "scatola nera" e le ingenti risorse richieste per l'addestramento o la messa a punto implicano che l'accesso e il controllo potrebbero concentrarsi, creando potenzialmente dipendenze da pochi grandi fornitori. Ciò ha implicazioni strategiche per le decisioni di "make-or-buy" e il rischio di "vendor lock-in". La capacità multimodale di molti modelli di base apre categorie di applicazioni completamente nuove in grado di sintetizzare informazioni da diverse tipologie di dati (ad esempio, analizzando report testuali insieme a filmati di telecamere di sorveglianza). Questo va oltre ciò che gli LLM incentrati sul testo possono fare e richiede ai dirigenti di pensare in modo più ampio alle risorse di dati disponibili.

La bussola normativa: orientarsi tra quadri giuridici ed etici

La legge UE sull'intelligenza artificiale: disposizioni chiave e implicazioni per le aziende

La legge dell'UE sull'intelligenza artificiale, entrata in vigore il 1° agosto 2024, è la prima legge completa al mondo sull'intelligenza artificiale e stabilisce un sistema di classificazione dell'intelligenza artificiale basato sul rischio.

Categorie di rischio:

- Rischio inaccettabile: i sistemi di intelligenza artificiale che rappresentano una chiara minaccia per la sicurezza, i mezzi di sussistenza e i diritti sono vietati. Tra gli esempi figurano il social scoring da parte delle autorità pubbliche, la manipolazione cognitiva del comportamento e la scansione indiscriminata delle immagini facciali. Questi divieti entreranno in vigore entro il 2 febbraio 2025.

- Alto rischio: sistemi di intelligenza artificiale che hanno un impatto negativo sulla sicurezza o sui diritti fondamentali. Questi sono soggetti a requisiti rigorosi, tra cui sistemi di gestione del rischio, governance dei dati, documentazione tecnica, supervisione umana e valutazioni di conformità pre-commercializzazione. Tra gli esempi figurano l'intelligenza artificiale nelle infrastrutture critiche, nei dispositivi medici, nel lavoro e nelle forze dell'ordine. La maggior parte delle norme per l'intelligenza artificiale ad alto rischio si applicherà a partire dal 2 agosto 2026.

- Rischio limitato: i sistemi di intelligenza artificiale come i chatbot o quelli che generano deepfake devono rispettare gli obblighi di trasparenza e informare gli utenti che stanno interagendo con l'intelligenza artificiale o che i contenuti sono generati dall'intelligenza artificiale.

- Rischio minimo: sistemi di intelligenza artificiale come filtri antispam o videogiochi basati sull'intelligenza artificiale. La legge ne consente il libero utilizzo, sebbene siano incoraggiati codici di condotta volontari.

Adatto a:

- Sistemi di intelligenza artificiale, sistemi ad alto rischio e legge sull'intelligenza artificiale per l'applicazione pratica nelle aziende e nelle autorità pubbliche

La legge stabilisce obblighi per fornitori, importatori, distributori e utenti (operatori) di sistemi di IA, con i fornitori di sistemi ad alto rischio soggetti ai requisiti più rigorosi. Data la sua applicazione extraterritoriale, interessa anche le aziende al di fuori dell'UE se i loro sistemi di IA vengono utilizzati sul mercato UE. Norme specifiche si applicano ai modelli di IA a scopo generale (GPAI), con obblighi aggiuntivi per quelli classificati come a "rischio sistemico". Queste norme si applicano generalmente a partire dal 2 agosto 2025. La legge prevede un'attuazione graduale: divieti (febbraio 2025), norme GPAI (agosto 2025), la maggior parte delle norme ad alto rischio (agosto 2026) e norme specifiche sui prodotti ad alto rischio (agosto 2027). La non conformità può comportare sanzioni sostanziali, fino a 35 milioni di euro o il 7% del fatturato annuo globale per le applicazioni vietate. L'articolo 4 stabilisce inoltre, a partire da febbraio 2025, un livello adeguato di competenza in materia di IA per il personale dei fornitori e degli operatori di determinati sistemi di IA.

L'approccio basato sul rischio della normativa UE sull'IA richiede un cambiamento radicale nel modo in cui le aziende affrontano lo sviluppo e l'implementazione dell'IA. Non si tratta più solo di fattibilità tecnica o valore aziendale; la conformità normativa e la mitigazione del rischio devono essere integrate fin dall'inizio del ciclo di vita dell'IA ("conformità fin dalla progettazione"). L'"obbligo di competenza in materia di IA" è una disposizione significativa e tempestiva. Ciò implica l'immediata necessità per le aziende di valutare e implementare programmi di formazione, non solo per i team tecnici, ma per tutti coloro che sviluppano, implementano o monitorano sistemi di IA. Ciò va oltre la semplice conoscenza di base e include la comprensione delle funzionalità, dei limiti e dei quadri etici e legali. L'attenzione della normativa sui modelli GPAI, in particolare quelli con rischio sistemico, indica una preoccupazione normativa circa gli impatti ampi e potenzialmente imprevisti di questi modelli potenti e versatili. Le aziende che utilizzano o sviluppano tali modelli saranno soggette a controlli e obblighi più severi, con un impatto sui loro piani di sviluppo e sulle strategie di commercializzazione.

Panoramica delle categorie di rischio della normativa UE sull'intelligenza artificiale e degli obblighi principali

Panoramica delle categorie di rischio della normativa UE sull'intelligenza artificiale e degli obblighi principali – Immagine: Xpert.Digital

Questa tabella riassume la struttura fondamentale della normativa UE sull'intelligenza artificiale e aiuta i dirigenti a identificare rapidamente in quale categoria potrebbero rientrare i loro sistemi di intelligenza artificiale e a comprendere gli oneri e le tempistiche di conformità corrispondenti.

Una panoramica delle categorie di rischio nella normativa UE sull'intelligenza artificiale mostra che i sistemi con un rischio inaccettabile, come il social scoring, la manipolazione cognitivo-comportamentale e l'acquisizione indiscriminata di immagini facciali, sono completamente vietati e non potranno più essere utilizzati a partire da febbraio 2025. L'intelligenza artificiale ad alto rischio, utilizzata, ad esempio, in infrastrutture critiche, dispositivi medici, lavoro, forze dell'ordine, istruzione o gestione delle migrazioni, è soggetta a obblighi estesi. Fornitori e operatori devono, tra le altre cose, dimostrare un sistema di gestione del rischio, una gestione della qualità dei dati e una documentazione tecnica, nonché garantire la trasparenza, garantire la supervisione umana e soddisfare criteri quali robustezza, accuratezza, sicurezza informatica e valutazione della conformità. Le misure corrispondenti entreranno in vigore da agosto 2026 e, in alcuni casi, da agosto 2027. Il rischio limitato si applica ad applicazioni di intelligenza artificiale come chatbot, sistemi di riconoscimento delle emozioni, sistemi di categorizzazione biometrica e deepfake. In questo caso si applicano obblighi di trasparenza, come l'etichettatura come sistema di intelligenza artificiale o contenuto generato dall'intelligenza artificiale, che entreranno in vigore anche da agosto 2026. Per le applicazioni di intelligenza artificiale con rischi minimi, come i filtri antispam o i videogiochi basati sull'intelligenza artificiale, non vi sono obblighi specifici, sebbene siano raccomandati codici di condotta volontari. Tali sistemi possono essere implementati immediatamente.

La tensione tra innovazione e responsabilità: trovare il giusto equilibrio

Le aziende devono gestire la tensione tra la promozione dell'innovazione nell'IA e la garanzia di responsabilità, protezione dei dati (GDPR) e utilizzo etico. I principi del GDPR (liceità, correttezza, trasparenza, limitazione delle finalità, minimizzazione dei dati, accuratezza e responsabilità) sono fondamentali per un'IA responsabile e influenzano il modo in cui i sistemi di IA vengono sviluppati e implementati. Le strategie per bilanciare questi principi includono il coinvolgimento tempestivo dei team di conformità e protezione dei dati, audit regolari, l'utilizzo di competenze esterne e l'impiego di strumenti di conformità specializzati. Alcuni considerano le linee guida normative non come ostacoli all'innovazione, ma come acceleratori che creano fiducia e aumentano l'adozione di nuove tecnologie.

La "tensione innovazione-responsabilità" non è un compromesso statico, ma un equilibrio dinamico. Le aziende che integrano proattivamente la responsabilità e le considerazioni etiche nel loro ciclo di innovazione in ambito IA hanno maggiori probabilità di sviluppare soluzioni IA sostenibili e affidabili. Questo, in ultima analisi, favorisce una maggiore innovazione a lungo termine, evitando costosi retrofit, danni alla reputazione o sanzioni normative. La sfida di mantenere la responsabilità è aggravata dalla crescente complessità e dalla potenziale natura "black box" dei modelli di IA avanzati (come alcuni discussi nei modelli base). Ciò richiede una maggiore attenzione alle tecniche di IA spiegabile (XAI) e a solidi meccanismi di audit per garantire che le decisioni basate sull'IA possano essere comprese, giustificate e, se necessario, contestate.

🎯📊 Integrazione di una piattaforma AI indipendente e incrociata a livello di fonte 🤖🌐 Per tutte le questioni aziendali

Integrazione di una piattaforma di intelligenza artificiale indipendente e incrociata per tutte le questioni aziendali: xpert.digital

Ki-GameChanger: le soluzioni più flessibili di fabbricazione della piattaforma AI che riducono i costi, migliorano le loro decisioni e aumentano l'efficienza

Piattaforma AI indipendente: integra tutte le fonti di dati aziendali pertinenti

- Questa piattaforma di intelligenza artificiale interagisce con tutte le origini dati specifiche

- Da SAP, Microsoft, Jira, Confluence, Salesforce, Zoom, Dropbox e molti altri sistemi di gestione dei dati

- Integrazione rapida AI: soluzioni AI su misura per le aziende in ore o giorni anziché mesi

- Infrastruttura flessibile: basata su cloud o hosting nel proprio data center (Germania, Europa, scelta libera della posizione)

- La massima sicurezza dei dati: l'uso negli studi legali è l'evidenza sicura

- Utilizzare attraverso un'ampia varietà di fonti di dati aziendali

- Scelta dei tuoi o vari modelli AI (DE, UE, USA, CN)

Sfide che la nostra piattaforma AI risolve

- Una mancanza di accuratezza delle soluzioni AI convenzionali

- Protezione dei dati e gestione sicura dei dati sensibili

- Alti costi e complessità dello sviluppo individuale dell'IA

- Mancanza di AI qualificata

- Integrazione dell'intelligenza artificiale nei sistemi IT esistenti

Maggiori informazioni qui:

Strategie di intelligenza artificiale per dirigenti: linee guida pratiche ed esempi

Strategie di intelligenza artificiale per dirigenti: linee guida pratiche ed esempi – Immagine: Xpert.Digital

L'intelligenza artificiale in azione: applicazioni, casi d'uso e interazione efficace

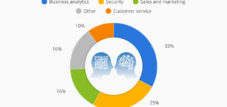

Riconoscere le opportunità: possibilità di applicazione dell'intelligenza artificiale e casi d'uso in tutti i settori

L'intelligenza artificiale offre diverse possibilità di applicazione, tra cui la creazione di contenuti, la comunicazione personalizzata con i clienti, l'ottimizzazione dei processi di produzione e logistica, la manutenzione predittiva e il supporto in ambito finanziario, delle risorse umane e dell'IT.

Esempi specifici del settore includono:

- Automotive/Produzione: intelligenza artificiale e simulazione nella ricerca (ARENA2036), interazione robot automatizzata (Festo), ottimizzazione dei processi e manutenzione predittiva nella produzione (Bosch).

- Servizi finanziari: maggiore sicurezza tramite l'analisi di grandi set di dati per transazioni sospette, fatturazione automatica, analisi degli investimenti.

- Assistenza sanitaria: diagnosi più rapide, accesso più ampio alle cure (ad esempio, interpretazione delle immagini mediche), ottimizzazione della ricerca farmaceutica.

- Telecomunicazioni: ottimizzazione delle prestazioni di rete, miglioramenti audiovisivi, prevenzione dell'abbandono dei clienti.

- Commercio al dettaglio/E-commerce: raccomandazioni personalizzate, chatbot per il servizio clienti, processi di pagamento automatizzati.

- Marketing e vendite: creazione di contenuti (ChatGPT, Canva), campagne ottimizzate, segmentazione dei clienti, previsioni di vendita.

Sebbene molti casi d'uso si concentrino su automazione ed efficienza, un trend emergente chiave è il ruolo dell'IA nel migliorare il processo decisionale umano e abilitare nuove forme di innovazione (ad esempio, sviluppo di farmaci; sviluppo di prodotti). I leader dovrebbero guardare oltre la riduzione dei costi per identificare opportunità di crescita e innovazione guidate dall'IA. Le implementazioni di IA di maggior successo spesso prevedono l'integrazione dell'IA nei processi e nei sistemi principali esistenti (ad esempio, SAP che utilizza l'IA nel software aziendale, Microsoft 365 Copilot), piuttosto che trattare l'IA come una tecnologia a sé stante e isolata. Ciò richiede una visione olistica dell'architettura aziendale.

Adatto a:

- Intelligenza artificiale: cinque strategie chiave per l'integrazione con maggiore trasformazione dell'IA per la gestione aziendale sostenibile

Padroneggiare il dialogo: suggerimenti efficaci per l'intelligenza artificiale generativa

Il prompt engineering è un processo iterativo basato su test per migliorare le prestazioni dei modelli, che richiede obiettivi chiari e test sistematici. L'efficacia dei prompt dipende sia dal loro contenuto (istruzioni, esempi, contesto) che dalla loro struttura (ordine, etichettatura, separatori).

I componenti importanti di un prompt includono: obiettivo/missione, istruzioni, vincoli (cosa fare/non fare), tono/stile, dati di contesto/background, esempi di poche riprese, catena di pensiero e formato di risposta desiderato.

Le migliori pratiche includono:

- Stabilisci obiettivi chiari e usa verbi d'azione.

- Fornire informazioni di contesto e di base.

- Definire con precisione il gruppo target.

- Di' all'IA cosa non deve fare.

- Formulare le richieste in modo chiaro, conciso e con una scelta precisa delle parole.

- Aggiungere limiti di output, in particolare per le attività di scrittura.

- Assegna un ruolo all'IA (ad esempio, "Sei un tutor di matematica").

- Il concatenamento di prompt (utilizzando prompt interconnessi) può generare idee continue.

Un prompt efficace non consiste tanto nel trovare un singolo "prompt perfetto", quanto nello sviluppare un approccio strategico all'interazione con gli LLM. Ciò implica la comprensione delle capacità del modello, il perfezionamento iterativo dei prompt in base all'output e l'utilizzo di tecniche come l'assegnazione dei ruoli e la catena di pensiero per guidare l'IA verso i risultati desiderati. È un'abilità che richiede pratica e pensiero critico. La capacità di fornire un contesto pertinente e definire vincoli è fondamentale per ottenere risultati preziosi dalla GenAI. Ciò significa che la qualità dei contenuti generati dall'IA è spesso direttamente proporzionale alla qualità e alla specificità dell'input umano, a sottolineare la continua importanza delle competenze umane nel processo.

Le migliori pratiche per creare prompt di intelligenza artificiale efficaci

Questa tabella offre consigli pratici e attuabili che manager e professionisti possono applicare immediatamente per migliorare le loro interazioni con gli strumenti di intelligenza artificiale generativa.

Per ottenere risultati di valore quando si utilizza l'IA generativa, è fondamentale procedere in modo specifico e chiaro, definendo con precisione l'obiettivo e utilizzando verbi d'azione, come "Creare un elenco puntato che riassuma i risultati chiave del documento". Altrettanto importante è fornire il contesto, ad esempio fornendo informazioni di base e dati rilevanti, come "Sulla base del report finanziario, analizzare la redditività degli ultimi cinque anni". Il pubblico di riferimento e il tono desiderato devono essere chiaramente articolati, ad esempio "Scrivi una descrizione del prodotto per i giovani adulti che apprezzano la sostenibilità". All'IA può anche essere assegnato un ruolo o una persona specifica, ad esempio "Sei un esperto di marketing. Progetta una campagna per...". Pochi esempi, come "Input: Mela. Output: Frutta. Input: Carota. Output:", possono aiutare a chiarire il formato di output desiderato. È inoltre consigliabile definire la formattazione precisa delle risposte, ad esempio "Formatta la tua risposta in Markdown". Restrizioni come "Evita termini tecnici. La risposta non deve superare le 200 parole" aiutano a ottimizzare l'output. Un approccio iterativo, in cui i prompt vengono adattati e perfezionati in base ai risultati precedenti, migliora ulteriormente la qualità. Infine, la catena di pensiero può essere utilizzata chiedendo all'IA di spiegare il suo processo di ragionamento passo dopo passo, ad esempio: "Spiega la tua argomentazione passo dopo passo".

Come affrontare l'intelligenza artificiale invisibile: comprendere e gestire le applicazioni ombra (intelligenza artificiale ombra)

Con "Shadow AI" si intende l'uso non autorizzato o non regolamentato di strumenti di intelligenza artificiale da parte dei dipendenti, spesso per aumentare la produttività o aggirare la lentezza dei processi ufficiali. È una sottocategoria dello shadow IT.

Rischi dell'intelligenza artificiale ombra:

- Sicurezza e privacy dei dati: strumenti non autorizzati possono portare a violazioni dei dati, alla divulgazione di dati pubblici/aziendali sensibili e alla mancata conformità al GDPR/HIPAA.

- Conformità e legislazione: violazioni delle leggi sulla protezione dei dati, problemi di copyright, conflitti con le leggi sulla libertà di informazione. Il requisito di "competenza in materia di IA" previsto dalla legge UE sull'intelligenza artificiale a partire da febbraio 2025 rende urgente affrontare queste problematiche.

- Economico/Operativo: strutture parallele inefficienti, costi nascosti dovuti ad abbonamenti individuali, mancanza di controllo sulle licenze, incompatibilità con i sistemi esistenti, interruzione dei flussi di lavoro, efficienza ridotta.

- Qualità e controllo: mancanza di trasparenza nell'elaborazione dei dati, potenziale rischio di risultati distorti o fuorvianti, erosione della fiducia pubblica/interna.

- Indebolimento della governance: elusione della governance IT, che rende più difficile l'applicazione delle policy di sicurezza.

Strategie per la gestione dell'intelligenza artificiale ombra:

- Sviluppo di una chiara strategia in materia di IA e definizione di una politica responsabile in materia di IA.

- Fornire strumenti di intelligenza artificiale ufficiali e approvati come alternative.

- Stabilire linee guida chiare per l'utilizzo dell'intelligenza artificiale, l'elaborazione dei dati e gli strumenti approvati.

- Formazione e sensibilizzazione dei dipendenti in merito all'uso responsabile dell'intelligenza artificiale, ai rischi e alle migliori pratiche.

- Eseguire audit regolari per individuare l'IA non autorizzata e garantire la conformità.

- Adottare un approccio di governance dell'IA incrementale, partendo da piccoli passi e perfezionando le policy.

- Promuovere la collaborazione interdipartimentale e il coinvolgimento dei dipendenti.

La shadow AI è spesso sintomo di esigenze degli utenti insoddisfatte o di processi di adozione tecnologica eccessivamente burocratici. Un approccio puramente restrittivo ("ban AI") può rivelarsi controproducente. Una gestione efficace richiede la comprensione delle cause profonde e la fornitura di alternative valide e sicure, oltre a una governance chiara. L'ascesa di strumenti GenAI facilmente reperibili (come ChatGPT) ha probabilmente accelerato la proliferazione della shadow AI. I dipendenti possono utilizzare rapidamente questi strumenti senza il coinvolgimento dell'IT. Ciò rende ancora più cruciali la formazione proattiva sulle competenze di IA (come richiesto dalla legislazione UE in materia di IA) e una comunicazione chiara sugli strumenti approvati.

Rischi dell'intelligenza artificiale ombra e risposte strategiche

Questa tabella fornisce una panoramica strutturata delle diverse minacce poste dall'uso non regolamentato dell'intelligenza artificiale e strategie concrete e attuabili per i manager.

L'intelligenza artificiale ombra (Shadow AI) presenta numerosi rischi che le aziende devono affrontare strategicamente. Nell'ambito della sicurezza dei dati, possono verificarsi fughe di dati, accessi non autorizzati a informazioni sensibili e infezioni da malware. Le misure strategiche includono l'implementazione di una policy di utilizzo dell'intelligenza artificiale, la creazione di un elenco di strumenti approvati, l'utilizzo della crittografia, l'implementazione di rigorosi controlli di accesso e la formazione dei dipendenti. Per quanto riguarda i rischi di conformità, come violazioni del GDPR, violazioni delle normative di settore o violazioni del copyright, sono essenziali audit regolari, valutazioni d'impatto sulla protezione dei dati (DPIA) basate sui dati per i nuovi strumenti, policy di elaborazione dei dati chiaramente definite e, se necessario, una consulenza legale. I rischi finanziari derivano da spese incontrollate per abbonamenti, licenze ridondanti o inefficienze. Pertanto, le aziende dovrebbero concentrarsi su acquisti centralizzati, un rigoroso controllo del budget e una revisione regolare dell'utilizzo degli strumenti. Le sfide operative come risultati incoerenti, incompatibilità con i sistemi aziendali esistenti o interruzioni dei processi possono essere affrontate fornendo strumenti standardizzati, integrandoli nei flussi di lavoro esistenti e implementando un controllo di qualità continuo. Anche i rischi reputazionali rappresentano una minaccia, ad esempio la perdita di fiducia dei clienti a causa di violazioni dei dati o di comunicazioni errate generate dall'intelligenza artificiale. Una comunicazione trasparente, il rispetto delle linee guida etiche e un piano di risposta agli incidenti ben progettato sono misure cruciali per mantenere la fiducia nell'azienda e ridurre al minimo i potenziali danni.

🎯🎯🎯 Approfitta della vasta e quintuplicata competenza di Xpert.Digital in un pacchetto di servizi completo | BD, R&D, XR, PR e ottimizzazione della visibilità digitale

Approfitta dell'ampia e quintuplicata competenza di Xpert.Digital in un pacchetto di servizi completo | Ottimizzazione di R&S, XR, PR e visibilità digitale - Immagine: Xpert.Digital

Xpert.Digital ha una conoscenza approfondita di vari settori. Questo ci consente di sviluppare strategie su misura che si adattano esattamente alle esigenze e alle sfide del vostro specifico segmento di mercato. Analizzando continuamente le tendenze del mercato e seguendo gli sviluppi del settore, possiamo agire con lungimiranza e offrire soluzioni innovative. Attraverso la combinazione di esperienza e conoscenza, generiamo valore aggiunto e diamo ai nostri clienti un vantaggio competitivo decisivo.

Maggiori informazioni qui:

Come l'intelligenza artificiale sta trasformando la leadership e la collaborazione e rafforzando le soft skill nella leadership: il vantaggio umano nell'era dell'intelligenza artificiale

Come l'intelligenza artificiale sta trasformando la leadership e la collaborazione e rafforzando le soft skill nella leadership: il vantaggio umano nell'era dell'intelligenza artificiale - Immagine: Xpert.Digital

L'elemento umano: l'impatto dell'intelligenza artificiale su leadership, collaborazione e creatività

Cambiamento della leadership nell'era dell'intelligenza artificiale: nuovi requisiti e competenze

L'intelligenza artificiale richiede un cambiamento nell'attenzione della leadership verso capacità esclusivamente umane: consapevolezza, compassione, saggezza, empatia, comprensione sociale, comunicazione trasparente, pensiero critico e adattabilità. I leader devono sviluppare competenze tecnologiche per prendere decisioni informate sugli strumenti di intelligenza artificiale e guidare i team attraverso la trasformazione. Ciò include la comprensione dei dati e la valutazione critica delle informazioni generate dall'intelligenza artificiale.

Le principali responsabilità della leadership includono la promozione di una cultura del processo decisionale basato sui dati, una gestione efficace del cambiamento, l'affrontare le considerazioni etiche attraverso la governance dell'IA e la promozione dell'innovazione e della creatività. L'IA può sollevare i leader da compiti di routine, consentendo loro di concentrarsi su aspetti strategici e umani come la motivazione e lo sviluppo dei dipendenti. Potrebbe emergere il nuovo ruolo di Chief Innovation and Transformation Officer (CITO), che combina competenze tecniche, conoscenze comportamentali e visione strategica. I leader dovranno destreggiarsi in scenari etici complessi, guidare la trasformazione culturale, gestire la collaborazione uomo-IA, promuovere l'integrazione interfunzionale e garantire un'innovazione responsabile.

La sfida principale per i leader nell'era dell'IA non è solo comprendere l'IA, ma guidare la risposta umana ad essa. Ciò include coltivare una cultura dell'apprendimento, affrontare i timori di perdita del lavoro e promuovere l'uso etico dell'IA, rendendo le competenze trasversali più importanti che mai. Esiste una potenziale discrepanza nella percezione dell'importanza delle relazioni interpersonali nell'era dell'IA: l'82% dei dipendenti le considera essenziali, rispetto a solo il 65% dei leader. Questo divario potrebbe portare a strategie di leadership che investono poco nelle relazioni umane, potenzialmente danneggiando il morale e la collaborazione. Una leadership efficace basata sull'IA implica un insieme di competenze paradossali: accettare l'obiettività basata sui dati dell'IA e rafforzare allo stesso tempo il giudizio soggettivo umano, l'intuizione e il ragionamento etico. Si tratta di aumentare l'intelligenza umana, non di arrendersi all'intelligenza artificiale.

Adatto a:

- L'accettazione dell'introduzione di nuove tecnologie come l'intelligenza artificiale, la realtà estesa e aumentata e come queste possano essere promosse

Trasformazione del lavoro di squadra: l'influenza dell'intelligenza artificiale sulla collaborazione e sulle dinamiche di squadra

L'intelligenza artificiale può migliorare il lavoro di squadra automatizzando le attività di routine, consentendo ai dipendenti di concentrarsi sul lavoro strategico e creativo. I sistemi di intelligenza artificiale possono supportare un processo decisionale migliore analizzando i dati e fornendo approfondimenti ai team. Gli strumenti di intelligenza artificiale possono promuovere una migliore comunicazione e un migliore coordinamento, consentendo la collaborazione in tempo reale e la condivisione di informazioni e risorse. La gestione della conoscenza basata sull'intelligenza artificiale può facilitare l'accesso a conoscenze centralizzate, consentire una ricerca intelligente e promuovere la condivisione della conoscenza. La combinazione di creatività umana, giudizio e intelligenza emotiva con le capacità di analisi dei dati e automazione dell'intelligenza artificiale può portare a un lavoro più efficiente e informato.

Le sfide includono la garanzia della protezione dei dati e la gestione etica dei dati negli strumenti di intelligenza artificiale collaborativa, il rischio di una "perdita di competenze" tra i dipendenti se l'intelligenza artificiale si assume troppi compiti senza una strategia per un'ulteriore formazione e il timore che i contatti personali possano diventare meno frequenti.

Sebbene l'intelligenza artificiale possa migliorare l'efficienza della collaborazione (ad esempio, una raccolta più rapida delle informazioni e l'automazione delle attività), i leader devono impegnarsi attivamente per mantenere la qualità dell'interazione umana e la coesione del team. Ciò significa progettare flussi di lavoro in modo che l'intelligenza artificiale integri i membri del team anziché isolarli, e creare opportunità per una vera connessione umana. Il successo dell'integrazione dell'intelligenza artificiale nel lavoro di squadra dipende in larga misura dalla fiducia: fiducia nell'affidabilità e nell'equità della tecnologia, nonché fiducia tra i membri del team nel modo in cui vengono utilizzate le informazioni basate sull'intelligenza artificiale. La mancanza di fiducia può portare a resistenze e minare gli sforzi collaborativi.

L'intelligenza artificiale come partner creativo: espandere e ridefinire la creatività nelle organizzazioni

L'intelligenza artificiale generativa, se implementata in modo strategico e ponderato, può creare un ambiente in cui la creatività umana e l'intelligenza artificiale coesistono e collaborano. L'intelligenza artificiale può promuovere la creatività agendo come un partner, offrendo nuove prospettive e spingendo i confini del possibile in settori come i media, l'arte e la musica. Può automatizzare gli aspetti di routine dei processi creativi, liberando le persone per attività più concettuali e innovative. Può anche aiutare a identificare tendenze emergenti o ad accelerare lo sviluppo di prodotti attraverso la sperimentazione basata sull'intelligenza artificiale.

Dilemmi e sfide etiche derivano dal fatto che i contenuti generati dall'IA mettono in discussione i concetti tradizionali di paternità, originalità, autonomia e intenzione. L'uso di dati protetti da copyright per addestrare modelli di IA e la generazione di contenuti potenzialmente lesivi dei diritti d'autore rappresentano preoccupazioni significative. Inoltre, esiste il rischio di un eccessivo affidamento all'IA, che potrebbe potenzialmente soffocare l'esplorazione creativa indipendente e lo sviluppo delle competenze umane a lungo termine.

Integrare l'IA nei processi creativi non è solo una questione di nuovi strumenti, ma una ridefinizione fondamentale della creatività stessa, verso un modello di co-creazione uomo-IA. Ciò richiede un cambiamento di mentalità tra i professionisti creativi e i loro leader, che enfatizzi la collaborazione con l'IA come nuova modalità. Le considerazioni etiche che circondano i contenuti generati dall'IA (paternità, pregiudizi, deepfake) implicano che le organizzazioni non possano semplicemente adottare strumenti di IA creativa senza solide linee guida etiche e una supervisione rigorosa. I leader devono garantire che l'IA venga utilizzata in modo responsabile per migliorare la creatività, non per ingannare o violare i diritti.

Creare ordine: implementare la governance dell'IA per una trasformazione responsabile

La necessità della governance dell'IA: perché è importante per la tua azienda

La governance dell'IA garantisce che i sistemi di IA siano sviluppati e implementati in modo etico, trasparente e in conformità con i valori umani e i requisiti legali.

Le ragioni principali per cui è necessaria la governance dell'IA includono:

- Considerazioni etiche: affronta il rischio di decisioni parziali e risultati ingiusti, garantendo equità e rispetto dei diritti umani.

- Conformità legale e normativa: garantisce la conformità alle leggi specifiche sull'intelligenza artificiale in continua evoluzione (come la legge UE sull'intelligenza artificiale) e alle normative vigenti sulla protezione dei dati (GDPR).

- Gestione del rischio: fornisce un quadro per identificare, valutare e controllare i rischi associati all'intelligenza artificiale, come la perdita di fiducia dei clienti, la perdita di competenza o processi decisionali distorti.

- Mantenere la fiducia: promuove la trasparenza e la spiegabilità nelle decisioni relative all'intelligenza artificiale e crea fiducia tra dipendenti, clienti e parti interessate.

- Massimizzazione del valore: garantisce che l'uso dell'intelligenza artificiale sia allineato agli obiettivi aziendali e che i suoi benefici siano effettivamente realizzati.

Senza una governance adeguata, l'intelligenza artificiale può causare danni involontari, violazioni etiche, sanzioni legali e danni alla reputazione.

La governance dell'IA non è semplicemente una funzione di conformità o mitigazione del rischio, ma un abilitatore strategico. Stabilendo regole, responsabilità e linee guida etiche chiare, le organizzazioni possono promuovere un ambiente in cui le innovazioni dell'IA possano prosperare in modo responsabile, portando a soluzioni di IA più sostenibili e affidabili. La necessità di una governance dell'IA è direttamente proporzionale alla crescente autonomia e complessità dei sistemi di IA. Man mano che le organizzazioni passano da semplici assistenti di IA ad agenti di IA e modelli di base più sofisticati, anche la portata e il rigore della governance devono evolversi per affrontare le nuove sfide legate a responsabilità, trasparenza e controllo.

Framework e best practice per una governance efficace dell'IA

Gli approcci di governance spaziano da quelli informali (basati sui valori aziendali) a soluzioni ad hoc (risposta a problemi specifici) a quelli formali (quadri completi).

Principali framework (esempi):

- NIST AI Risk Management Framework (AI RMF): si concentra sull'aiutare le organizzazioni a gestire i rischi correlati all'intelligenza artificiale attraverso funzioni quali controllo, mappatura, misurazione e gestione.

- ISO 42001: stabilisce un sistema completo di gestione dell'intelligenza artificiale che richiede politiche, gestione del rischio e miglioramento continuo.

- Principi OCSE sull'intelligenza artificiale: promuovere un uso responsabile dell'intelligenza artificiale e sottolineare i diritti umani, l'equità, la trasparenza e la responsabilità.

Buone pratiche per l'implementazione:

- Istituzione di strutture di governance interna (ad esempio, comitati etici per l'intelligenza artificiale, gruppi di lavoro interfunzionali) con ruoli e responsabilità chiari.

- Implementazione di un sistema di classificazione basato sul rischio per le applicazioni di intelligenza artificiale.

- Garantire una solida governance e gestione dei dati, inclusi qualità dei dati, protezione dei dati e verifica di eventuali pregiudizi.

- Esecuzione di valutazioni di conformità e di conformità sulla base di standard e normative pertinenti.

- Richiede la supervisione umana, soprattutto per i sistemi ad alto rischio e le decisioni critiche.

- Coinvolgimento delle parti interessate (dipendenti, utenti, investitori) attraverso una comunicazione trasparente.

- Sviluppo di linee guida etiche chiare e loro integrazione nel ciclo di sviluppo dell'IA.

- Investimenti nella formazione e nella gestione del cambiamento per garantire la comprensione e l'accettazione delle politiche di governance.

- Inizia con casi d'uso e progetti pilota chiaramente definiti, per poi aumentare gradualmente.

- Mantenere un elenco dei sistemi di intelligenza artificiale utilizzati in azienda.

Una governance efficace dell'IA non è una soluzione universale. Le organizzazioni devono adattare framework come il NIST AI RMF o lo standard ISO 42001 al loro specifico settore, alle dimensioni, alla propensione al rischio e alle tipologie di IA che implementano. Adottare semplicemente un framework teoricamente senza adattamenti pratici difficilmente sarà efficace. Il "fattore umano" nella governance dell'IA è cruciale tanto quanto gli aspetti di "processo" e "tecnologia". Ciò include l'assegnazione chiara delle responsabilità, la fornitura di una formazione completa e la promozione di una cultura che valorizzi un utilizzo etico e responsabile dell'IA. Senza l'accettazione e la comprensione da parte dei dipendenti, anche il framework di governance meglio progettato fallirà.

Componenti chiave di un quadro di governance dell'IA

Questa tabella fornisce una checklist completa e una guida per i dirigenti che desiderano stabilire o migliorare la propria governance dell'IA.

I componenti chiave di un quadro di governance dell'IA sono cruciali per garantire un uso responsabile ed efficace dell'IA. I principi fondamentali e le linee guida etiche dovrebbero riflettere i valori aziendali ed essere allineati ai diritti umani, all'equità e alla trasparenza. Ruoli e responsabilità devono essere chiaramente definiti; questi includono un comitato etico per l'IA, responsabili del trattamento dei dati e revisori dei modelli, con compiti, autorità decisionale e responsabilità chiaramente definiti. Una gestione efficace del rischio richiede l'identificazione, la valutazione e la mitigazione dei rischi, come definiti, ad esempio, dalle categorie della legislazione UE sull'IA. Valutazioni regolari del rischio, nonché lo sviluppo e il monitoraggio di strategie di mitigazione, svolgono un ruolo centrale in questo contesto. La governance dei dati garantisce che aspetti quali la qualità, la protezione dei dati, la sicurezza e l'individuazione di pregiudizi siano presi in considerazione, inclusa la conformità al GDPR e le misure antidiscriminatorie. La gestione del ciclo di vita del modello comprende processi standardizzati per lo sviluppo, la convalida, l'implementazione, il monitoraggio e la dismissione, con particolare attenzione alla documentazione, al controllo delle versioni e al monitoraggio continuo delle prestazioni. Trasparenza e spiegabilità sono essenziali per garantire la tracciabilità delle decisioni sull'IA e per divulgare l'uso dell'IA. La conformità ai requisiti legali, come la Direttiva UE sull'IA e il GDPR, deve essere garantita anche attraverso revisioni e adeguamenti continui dei processi, nonché attraverso la collaborazione con l'ufficio legale. Programmi di formazione e sensibilizzazione per sviluppatori, utenti e manager promuovono la comprensione dei fondamenti dell'IA, delle considerazioni etiche e delle linee guida di governance. Infine, è necessario garantire la risposta e la risoluzione degli incidenti per affrontare efficacemente malfunzionamenti, violazioni etiche o incidenti di sicurezza. Ciò include canali di segnalazione consolidati, processi di escalation e azioni correttive che consentano un intervento rapido e mirato.

Adatto a:

- La corsa all’intelligenza artificiale (IA): 7 paesi da tenere d’occhio – tra cui la Germania – I dieci migliori consigli

Prendere l'iniziativa: imperativi strategici per la trasformazione dell'intelligenza artificiale

Coltivare la prontezza all'intelligenza artificiale: il ruolo dell'apprendimento continuo e della formazione continua

Oltre alle competenze tecniche, i dirigenti necessitano principalmente di una comprensione strategica dell'IA per far progredire efficacemente le proprie aziende. La formazione sull'IA per i dirigenti dovrebbe comprendere i fondamenti dell'IA, casi di studio di successo, gestione dei dati, considerazioni etiche e l'identificazione del potenziale dell'IA all'interno della propria organizzazione. La Direttiva UE sull'IA (articolo 4) impone "competenze in materia di IA" per il personale coinvolto nello sviluppo o nell'implementazione di sistemi di IA, a partire dal 2 febbraio 2025. Ciò include la comprensione delle tecnologie di IA, la conoscenza delle applicazioni, capacità di pensiero critico e quadri normativi.

I vantaggi della formazione sull'IA per i manager includono la capacità di gestire progetti di IA, sviluppare strategie di IA sostenibili, ottimizzare i processi, garantire vantaggi competitivi e garantire un utilizzo etico e responsabile dell'IA. La mancanza di competenze e competenze in materia di IA rappresenta un ostacolo significativo all'adozione dell'IA. Sono disponibili diversi formati di formazione: programmi di certificazione, seminari, corsi online e formazione in presenza.

Essere pronti per l'IA non significa solo acquisire competenze tecniche; significa anche promuovere una mentalità di apprendimento continuo e adattabilità in tutta l'organizzazione. Dato il rapido ritmo di sviluppo dell'IA, la formazione basata su strumenti specifici può diventare rapidamente obsoleta. Pertanto, le conoscenze fondamentali sull'IA e le capacità di pensiero critico rappresentano investimenti più duraturi. L'obbligo di competenza in materia di IA previsto dalla legge UE sull'IA funge da motore normativo per l'aggiornamento delle competenze, ma le organizzazioni dovrebbero considerarlo un'opportunità, non solo un onere di conformità. Una forza lavoro più esperta in IA è meglio attrezzata per identificare applicazioni di IA innovative, utilizzare gli strumenti in modo efficace e comprenderne le implicazioni etiche, con conseguenti risultati complessivamente migliori in termini di IA. Esiste un chiaro legame tra la mancanza di competenze/comprensione in materia di IA e la proliferazione dell'IA ombra. Investire in una formazione completa sull'IA può mitigare direttamente i rischi associati all'uso non autorizzato dell'IA, consentendo ai dipendenti di prendere decisioni informate e responsabili.

Sintetizzare opportunità e rischi: una tabella di marcia per una leadership sovrana nell'intelligenza artificiale

Per guidare la trasformazione dell'IA è necessaria una comprensione olistica del potenziale della tecnologia (innovazione, efficienza, qualità) e dei suoi rischi intrinseci (etici, legali, sociali).

La leadership sovrana dell'IA implica la definizione proattiva del percorso dell'organizzazione verso l'IA attraverso:

- Stabilire una solida governance dell'IA basata su principi etici e quadri giuridici come la legge UE sull'IA.

- Promuovere una cultura di apprendimento continuo e di competenza in materia di intelligenza artificiale a tutti i livelli.

- Identificazione strategica e definizione delle priorità dei casi d'uso dell'IA che generano un valore tangibile.

- Rafforzare il talento umano concentrandosi sulle competenze che l'intelligenza artificiale integra anziché sostituire e gestire l'impatto umano dell'intelligenza artificiale.

- Gestione proattiva delle sfide emergenti come l'intelligenza artificiale ombra.

L'obiettivo finale è sfruttare l'IA come fattore strategico per una crescita sostenibile e un vantaggio competitivo, mitigandone al contempo i potenziali svantaggi. Una vera "leadership sovrana in materia di IA" va oltre la gestione organizzativa interna e comprende una più ampia comprensione dell'impatto sociale dell'IA e del ruolo dell'azienda all'interno di tale ecosistema. Ciò significa impegnarsi in discussioni politiche, contribuire alla definizione di standard etici e garantire che l'IA venga utilizzata per il bene comune, non solo per il profitto aziendale. Il percorso di trasformazione dell'IA non è lineare e comporterà la gestione di ambiguità e sfide inaspettate. I leader devono quindi coltivare agilità e resilienza organizzative affinché i loro team possano adattarsi a progressi tecnologici imprevisti, cambiamenti normativi o sconvolgimenti del mercato causati dall'IA.

Adatto a:

- Top ten per consulenza e pianificazione – Panoramica e suggerimenti sull'intelligenza artificiale: diversi modelli di intelligenza artificiale e campi di applicazione tipici

Comprendere e utilizzare le tecnologie: nozioni di base dell'intelligenza artificiale per i decisori

La trasformazione attraverso l'intelligenza artificiale non è più una visione lontana del futuro, ma una realtà presente che sfida le aziende di ogni dimensione e settore, offrendo al contempo immense opportunità. Per specialisti e manager, questo significa assumere un ruolo attivo nel plasmare questo cambiamento, al fine di sfruttare responsabilmente il potenziale dell'IA e gestire con sicurezza i rischi associati.

I fondamenti dell'IA, dai modelli generativi e dalla distinzione tra assistenti e agenti ai driver tecnologici come l'apprendimento automatico e i modelli di base, costituiscono la base per una comprensione più approfondita. Questa conoscenza è essenziale per prendere decisioni consapevoli sull'implementazione e l'integrazione dei sistemi di IA.

Il quadro giuridico, in particolare la Direttiva UE sull'IA, stabilisce linee guida chiare per lo sviluppo e l'applicazione dell'IA. L'approccio basato sul rischio e gli obblighi che ne derivano, in particolare per i sistemi ad alto rischio e per quanto riguarda le competenze richieste ai dipendenti in materia di IA, richiedono un approccio proattivo e l'implementazione di solide strutture di governance. La tensione tra la ricerca dell'innovazione e l'esigenza di responsabilità deve essere risolta attraverso una strategia integrata che consideri la conformità e l'etica come componenti integranti del processo di innovazione.

Le potenziali applicazioni dell'IA sono molteplici e spaziano in diversi settori. Identificare casi d'uso adeguati, padroneggiare tecniche di interazione efficaci come il prompting e gestire consapevolmente le applicazioni ombra sono competenze chiave per realizzare il valore aggiunto dell'IA nel proprio ambito di responsabilità.

Infine, ma non meno importante, l'intelligenza artificiale sta cambiando radicalmente il modo in cui guidiamo, collaboriamo e coltiviamo la creatività. I leader sono chiamati ad adattare le proprie competenze, a dare maggiore enfasi alle capacità umane come l'empatia, il pensiero critico e la gestione del cambiamento, e a creare una cultura in cui esseri umani e macchine lavorino in sinergia. Promuovere la collaborazione e integrare l'intelligenza artificiale come partner creativo richiede nuovi modi di pensare e approcci gestionali.

Stabilire una governance completa dell'IA non è un optional, ma una necessità strategica. Crea il quadro per un utilizzo etico, trasparente e sicuro dell'IA, riduce al minimo i rischi e crea fiducia tra tutti gli stakeholder.

La trasformazione dell'intelligenza artificiale è un percorso che richiede apprendimento continuo, adattabilità e una visione chiara. I professionisti e i manager che accettano queste sfide e interiorizzano i principi e le pratiche qui delineati sono ben equipaggiati per plasmare il futuro delle loro organizzazioni, dipartimenti e team in modo solido e sicuro nell'era dell'intelligenza artificiale.