AI dan SEO dengan BERT – Representasi Encoder Dua Arah dari Transformers – model di bidang pemrosesan bahasa alami (NLP)

Pemilihan suara 📢

Diterbitkan pada: 4 Oktober 2024 / Pembaruan dari: 4 Oktober 2024 - Penulis: Konrad Wolfenstein

AI dan SEO dengan BERT – Representasi Encoder Dua Arah dari Transformers – Model di bidang pemrosesan bahasa alami (NLP) – Gambar: Xpert.Digital

🚀💬 Dikembangkan oleh Google: BERT dan pentingnya NLP - Mengapa pemahaman teks dua arah sangat penting

🔍🗣️ BERT, kependekan dari BiDirectional Encoder Representations from Transformers, adalah model utama di bidang pemrosesan bahasa alami (NLP) yang dikembangkan oleh Google. Ini telah merevolusi cara mesin memahami bahasa. Berbeda dengan model sebelumnya yang menganalisis teks secara berurutan dari kiri ke kanan atau sebaliknya, BERT memungkinkan pemrosesan dua arah. Artinya, ini menangkap konteks sebuah kata dari rangkaian teks sebelumnya dan berikutnya. Kemampuan ini secara signifikan meningkatkan pemahaman konteks linguistik yang kompleks.

🔍 Arsitektur BERT

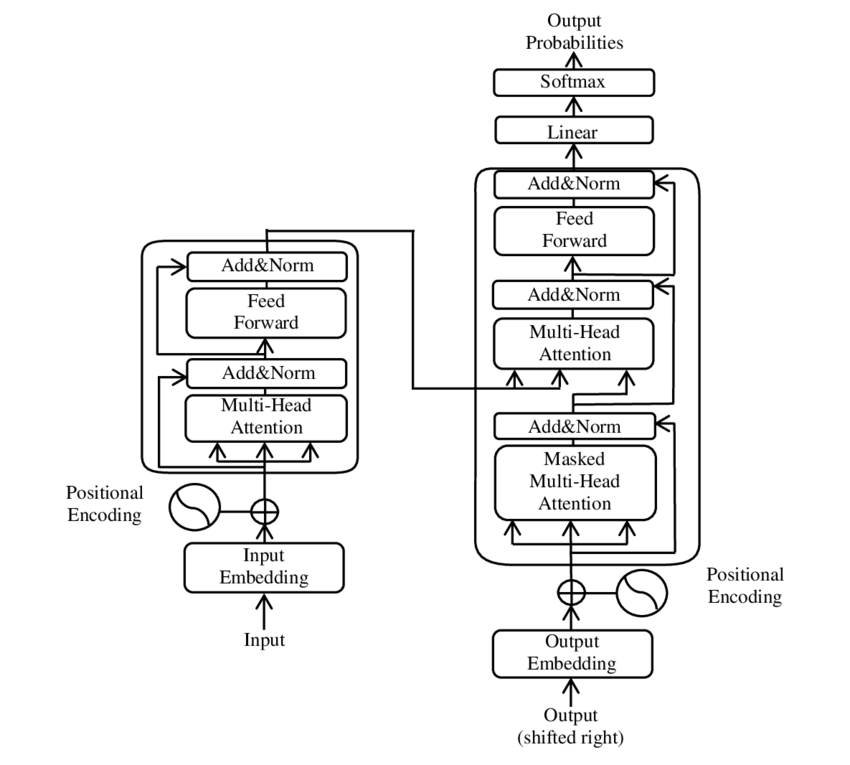

Dalam beberapa tahun terakhir, salah satu perkembangan paling signifikan di bidang Natural Language Processing (NLP) terjadi dengan diperkenalkannya model Transformer, seperti yang disajikan dalam PDF 2017 - Hanya perhatian yang Anda perlukan - kertas ( Wikipedia ). Model ini secara mendasar mengubah bidang ini dengan membuang struktur yang sebelumnya digunakan, seperti terjemahan mesin. Sebaliknya, hal ini hanya bergantung pada mekanisme perhatian. Sejak saat itu, desain Transformer telah menjadi dasar bagi banyak model yang mewakili kecanggihan di berbagai bidang seperti pembuatan bahasa, penerjemahan, dan lainnya.

BERT didasarkan pada arsitektur Transformer ini. Arsitektur ini menggunakan apa yang disebut mekanisme perhatian diri untuk menganalisis hubungan antar kata dalam sebuah kalimat. Perhatian diberikan pada setiap kata dalam konteks keseluruhan kalimat, sehingga menghasilkan pemahaman yang lebih tepat tentang hubungan sintaksis dan semantik.

Penulis makalah “Perhatian adalah yang Anda butuhkan” adalah:

- Ashish Vaswani (Otak Google)

- Noam Shazeer (Otak Google)

- Niki Parmar (Riset Google)

- Jakob Uszkoreit (Penelitian Google)

- Lion Jones (Penelitian Google)

- Aidan N. Gomez (Universitas Toronto, sebagian pekerjaan dilakukan di Google Brain)

- Lukasz Kaiser (Otak Google)

- Illia Polosukhin (Independen, bekerja sebelumnya di Google Research)

Para penulis ini memberikan kontribusi yang signifikan terhadap pengembangan model Transformer yang disajikan dalam makalah ini.

🔄 Pemrosesan dua arah

Fitur menonjol dari BERT adalah kemampuan pemrosesan dua arah. Meskipun model tradisional seperti jaringan saraf berulang (RNN) atau jaringan Memori Jangka Pendek Panjang (LSTM) hanya memproses teks dalam satu arah, BERT menganalisis konteks kata di kedua arah. Hal ini memungkinkan model untuk menangkap nuansa makna yang lebih baik sehingga menghasilkan prediksi yang lebih akurat.

🕵️♂️ Pemodelan bahasa bertopeng

Aspek inovatif lainnya dari BERT adalah teknik Masked Language Model (MLM). Ini melibatkan penyembunyian kata-kata yang dipilih secara acak dalam sebuah kalimat dan melatih model untuk memprediksi kata-kata tersebut berdasarkan konteks sekitarnya. Metode ini memaksa BERT untuk mengembangkan pemahaman mendalam tentang konteks dan makna setiap kata dalam kalimat.

🚀 Pelatihan dan penyesuaian BERT

BERT menjalani proses pelatihan dua tahap: pra-pelatihan dan penyesuaian.

📚 Pra-pelatihan

Dalam pra-pelatihan, BERT dilatih dengan teks dalam jumlah besar untuk mempelajari pola bahasa umum. Ini termasuk teks Wikipedia dan korpora teks ekstensif lainnya. Pada fase ini, model mempelajari struktur dan konteks linguistik dasar.

🔧 Penyempurnaan

Setelah pra-pelatihan, BERT disesuaikan untuk tugas NLP tertentu, seperti klasifikasi teks atau analisis sentimen. Model ini dilatih dengan kumpulan data terkait tugas yang lebih kecil untuk mengoptimalkan performanya untuk aplikasi tertentu.

🌍 Area penerapan BERT

BERT telah terbukti sangat berguna dalam berbagai bidang pemrosesan bahasa alami:

Optimasi Mesin Pencari

Google menggunakan BERT untuk lebih memahami permintaan pencarian dan menampilkan hasil yang lebih relevan. Ini sangat meningkatkan pengalaman pengguna.

Klasifikasi teks

BERT dapat mengkategorikan dokumen berdasarkan topik atau menganalisis mood dalam teks.

Pengakuan Entitas Bernama (NER)

Model ini mengidentifikasi dan mengklasifikasikan entitas bernama dalam teks, seperti nama pribadi, tempat, atau organisasi.

Sistem tanya jawab

BERT digunakan untuk memberikan jawaban yang tepat atas pertanyaan yang diajukan.

🧠 Pentingnya BERT untuk masa depan AI

BERT telah menetapkan standar baru untuk model NLP dan membuka jalan bagi inovasi lebih lanjut. Melalui kemampuan pemrosesan dua arah dan pemahaman mendalam tentang konteks bahasa, teknologi ini telah meningkatkan efisiensi dan akurasi aplikasi AI secara signifikan.

🔜 Perkembangan masa depan

Pengembangan lebih lanjut dari BERT dan model serupa kemungkinan besar bertujuan untuk menciptakan sistem yang lebih kuat. Ini dapat menangani tugas-tugas bahasa yang lebih kompleks dan digunakan dalam berbagai bidang penerapan baru. Mengintegrasikan model-model tersebut ke dalam teknologi sehari-hari dapat mengubah cara kita berinteraksi dengan komputer secara mendasar.

🌟 Tonggak sejarah dalam pengembangan kecerdasan buatan

BERT merupakan tonggak penting dalam pengembangan kecerdasan buatan dan telah merevolusi cara mesin memproses bahasa alami. Arsitektur dua arah memungkinkan pemahaman yang lebih mendalam tentang hubungan linguistik, sehingga sangat diperlukan untuk berbagai aplikasi. Seiring kemajuan penelitian, model seperti BERT akan terus memainkan peran penting dalam meningkatkan sistem AI dan membuka kemungkinan baru untuk penggunaannya.

📣 Topik serupa

- 📚 Memperkenalkan BERT: Model NLP Terobosan

- 🔍 BERT dan peran dua arah dalam NLP

- 🧠 Model Transformer: landasan BERT

- Pemodelan Bahasa Bertopeng: Kunci Sukses BERT

- 📈 Kustomisasi BERT: Dari pra-pelatihan hingga penyesuaian

- 🌐 Area penerapan BERT dalam teknologi modern

- 🤖 Pengaruh BERT terhadap masa depan kecerdasan buatan

- 💡 Prospek masa depan: Perkembangan BERT lebih lanjut

- 🏆 BERT sebagai tonggak sejarah pengembangan AI

- 📰 Penulis makalah Transformer “Yang Anda Butuhkan Perhatian”: Pikiran di balik BERT

#️⃣ Tagar: #NLP #Kecerdasan Buatan #Pemodelan Bahasa #Transformer #Pembelajaran Mesin

🎯🎯🎯 Manfaatkan keahlian Xpert.Digital yang luas dan lima kali lipat dalam paket layanan komprehensif | Litbang, XR, Humas & SEM

Mesin Rendering 3D AI & XR: Keahlian lima kali lipat dari Xpert.Digital dalam paket layanan komprehensif, R&D XR, PR & SEM - Gambar: Xpert.Digital

Xpert.Digital memiliki pengetahuan mendalam tentang berbagai industri. Hal ini memungkinkan kami mengembangkan strategi khusus yang disesuaikan secara tepat dengan kebutuhan dan tantangan segmen pasar spesifik Anda. Dengan terus menganalisis tren pasar dan mengikuti perkembangan industri, kami dapat bertindak dengan pandangan ke depan dan menawarkan solusi inovatif. Melalui kombinasi pengalaman dan pengetahuan, kami menghasilkan nilai tambah dan memberikan pelanggan kami keunggulan kompetitif yang menentukan.

Lebih lanjut tentang itu di sini:

BERT: Teknologi 🌟 NLP yang revolusioner

🚀 BERT, kependekan dari BiDirectional Encoder Representations from Transformers, adalah model bahasa canggih yang dikembangkan oleh Google yang telah menjadi terobosan signifikan di bidang Natural Language Processing (NLP) sejak diluncurkan pada tahun 2018. Hal ini didasarkan pada arsitektur Transformer, yang telah merevolusi cara mesin memahami dan memproses teks. Tapi apa sebenarnya yang membuat BERT begitu istimewa dan untuk apa sebenarnya BERT digunakan? Untuk menjawab pertanyaan ini, kita perlu mempelajari lebih dalam prinsip teknis, fungsionalitas, dan area penerapan BERT.

📚 1. Dasar-dasar pemrosesan bahasa alami

Untuk memahami sepenuhnya arti BERT, ada baiknya kita meninjau secara singkat dasar-dasar pemrosesan bahasa alami (NLP). NLP berkaitan dengan interaksi antara komputer dan bahasa manusia. Tujuannya adalah untuk mengajarkan mesin menganalisis, memahami, dan merespons data teks. Sebelum diperkenalkannya model seperti BERT, pemrosesan bahasa oleh mesin sering kali menghadirkan tantangan yang signifikan, terutama karena ambiguitas, ketergantungan konteks, dan struktur bahasa manusia yang kompleks.

📈 2. Pengembangan model NLP

Sebelum BERT muncul, sebagian besar model NLP didasarkan pada apa yang disebut arsitektur searah. Artinya, model ini hanya membaca teks dari kiri ke kanan atau dari kanan ke kiri, yang berarti model tersebut hanya dapat mempertimbangkan konteks dalam jumlah terbatas saat memproses kata dalam kalimat. Keterbatasan ini sering kali mengakibatkan model tidak sepenuhnya menangkap konteks semantik sebuah kalimat secara utuh. Hal ini menyulitkan penafsiran kata-kata yang ambigu atau peka konteks secara akurat.

Perkembangan penting lainnya dalam penelitian NLP sebelum BERT adalah model word2vec, yang memungkinkan komputer menerjemahkan kata menjadi vektor yang mencerminkan kesamaan semantik. Namun di sini juga konteksnya terbatas pada lingkungan sekitar sebuah kata. Kemudian, Recurrent Neural Networks (RNNs) dan khususnya model Long Short-Term Memory (LSTM) dikembangkan, yang memungkinkan untuk lebih memahami urutan teks dengan menyimpan informasi dalam beberapa kata. Namun, model-model ini juga mempunyai keterbatasan, terutama ketika berhadapan dengan teks yang panjang dan memahami konteks dari dua arah secara bersamaan.

🔄 3. Revolusi melalui arsitektur Transformer

Terobosan ini datang dengan diperkenalkannya arsitektur Transformer pada tahun 2017, yang menjadi dasar BERT. Model transformator dirancang untuk memungkinkan pemrosesan teks paralel, dengan mempertimbangkan konteks kata dari teks sebelumnya dan berikutnya. Hal ini dilakukan melalui apa yang disebut mekanisme perhatian diri, yang memberikan nilai bobot pada setiap kata dalam sebuah kalimat berdasarkan seberapa penting kata tersebut dalam kaitannya dengan kata lain dalam kalimat tersebut.

Berbeda dengan pendekatan sebelumnya, model Transformer tidak searah, melainkan dua arah. Artinya, mereka dapat menarik informasi dari konteks kiri dan kanan sebuah kata, sehingga menghasilkan representasi kata dan maknanya yang lebih lengkap dan akurat.

🧠 4. BERT: Model dua arah

BERT membawa kinerja arsitektur Transformer ke tingkat yang baru. Model ini dirancang untuk menangkap konteks sebuah kata tidak hanya dari kiri ke kanan atau kanan ke kiri, namun dalam dua arah secara bersamaan. Hal ini memungkinkan BERT untuk mempertimbangkan konteks penuh sebuah kata dalam sebuah kalimat, sehingga menghasilkan peningkatan akurasi yang signifikan dalam tugas pemrosesan bahasa.

Fitur utama BERT adalah penggunaan yang disebut Masked Language Model (MLM). Dalam pelatihan BERT, kata-kata yang dipilih secara acak dalam sebuah kalimat diganti dengan topeng, dan model dilatih untuk menebak kata-kata yang disamarkan tersebut berdasarkan konteksnya. Teknik ini memungkinkan BERT mempelajari hubungan antar kata dalam sebuah kalimat lebih dalam dan tepat.

Selain itu, BERT menggunakan metode yang disebut Next Sentence Prediction (NSP), di mana model tersebut belajar memprediksi apakah satu kalimat mengikuti kalimat lainnya atau tidak. Hal ini meningkatkan kemampuan BERT untuk memahami teks yang lebih panjang dan mengenali hubungan antar kalimat yang lebih kompleks.

🌐 5. Penerapan BERT dalam praktik

BERT telah terbukti sangat berguna untuk berbagai tugas NLP. Berikut adalah beberapa bidang penerapan utama:

📊 a) Klasifikasi teks

Salah satu penggunaan BERT yang paling umum adalah klasifikasi teks, di mana teks dibagi ke dalam kategori yang telah ditentukan sebelumnya. Contohnya termasuk analisis sentimen (misalnya mengenali apakah suatu teks positif atau negatif) atau kategorisasi umpan balik pelanggan. BERT dapat memberikan hasil yang lebih tepat dibandingkan model sebelumnya melalui pemahamannya yang mendalam terhadap konteks kata.

❓ b) Sistem tanya jawab

BERT juga digunakan dalam sistem tanya jawab, di mana model mengekstrak jawaban atas pertanyaan yang diajukan dari sebuah teks. Kemampuan ini sangat penting dalam aplikasi seperti mesin pencari, chatbots atau asisten virtual. Berkat arsitektur dua arah, BERT dapat mengekstrak informasi yang relevan dari sebuah teks, meskipun pertanyaannya dirumuskan secara tidak langsung.

🌍 c) Terjemahan teks

Meskipun BERT sendiri tidak dirancang secara langsung sebagai model terjemahan, BERT dapat digunakan bersama dengan teknologi lain untuk meningkatkan terjemahan mesin. Dengan lebih memahami hubungan semantik dalam sebuah kalimat, BERT dapat membantu menghasilkan terjemahan yang lebih akurat, terutama untuk kata-kata yang ambigu atau rumit.

🏷️ d) Pengakuan Entitas Bernama (NER)

Area penerapan lainnya adalah Named Entity Recognition (NER), yang melibatkan identifikasi entitas tertentu seperti nama, tempat, atau organisasi dalam sebuah teks. BERT terbukti sangat efektif dalam tugas ini karena sepenuhnya mempertimbangkan konteks kalimat, sehingga lebih baik dalam mengenali entitas meskipun entitas tersebut memiliki arti berbeda dalam konteks berbeda.

✂️ e) Ringkasan teks

Kemampuan BERT untuk memahami keseluruhan konteks teks juga menjadikannya alat yang ampuh untuk peringkasan teks otomatis. Ini dapat digunakan untuk mengekstrak informasi terpenting dari teks panjang dan membuat ringkasan singkat.

🌟 6. Pentingnya BERT bagi penelitian dan industri

Pengenalan BERT mengantarkan era baru dalam penelitian NLP. Ini adalah salah satu model pertama yang memanfaatkan sepenuhnya kekuatan arsitektur Transformer dua arah, yang menetapkan standar bagi banyak model berikutnya. Banyak perusahaan dan lembaga penelitian telah mengintegrasikan BERT ke dalam saluran NLP mereka untuk meningkatkan kinerja aplikasi mereka.

Selain itu, BERT telah membuka jalan bagi inovasi lebih lanjut di bidang model bahasa. Misalnya, model seperti GPT (Generative Pretrained Transformer) dan T5 (Text-to-Text Transfer Transformer) kemudian dikembangkan, yang didasarkan pada prinsip serupa tetapi menawarkan peningkatan khusus untuk kasus penggunaan yang berbeda.

🚧 7. Tantangan dan keterbatasan BERT

Meskipun memiliki banyak kelebihan, BERT juga memiliki beberapa tantangan dan keterbatasan. Salah satu rintangan terbesarnya adalah tingginya upaya komputasi yang diperlukan untuk melatih dan menerapkan model. Karena BERT adalah model yang sangat besar dengan jutaan parameter, maka BERT memerlukan perangkat keras yang kuat dan sumber daya komputasi yang signifikan, terutama saat memproses data dalam jumlah besar.

Masalah lainnya adalah potensi bias yang mungkin ada dalam data pelatihan. Karena BERT dilatih pada data teks dalam jumlah besar, terkadang BERT mencerminkan bias dan stereotip yang ada dalam data tersebut. Namun, para peneliti terus berupaya untuk mengidentifikasi dan mengatasi masalah ini.

🔍 Alat penting untuk aplikasi pemrosesan bahasa modern

BERT telah meningkatkan cara mesin memahami bahasa manusia secara signifikan. Dengan arsitektur dua arah dan metode pelatihan inovatif, ia mampu menangkap konteks kata dalam sebuah kalimat secara mendalam dan akurat, sehingga menghasilkan akurasi yang lebih tinggi dalam banyak tugas NLP. Baik dalam klasifikasi teks, sistem tanya jawab, atau pengenalan entitas – BERT telah memantapkan dirinya sebagai alat yang sangat diperlukan untuk aplikasi pemrosesan bahasa modern.

Penelitian dalam pemrosesan bahasa alami pasti akan terus maju, dan BERT telah meletakkan dasar bagi banyak inovasi di masa depan. Terlepas dari tantangan dan keterbatasan yang ada, BERT secara mengesankan menunjukkan sejauh mana kemajuan teknologi dalam waktu singkat dan peluang menarik apa yang masih terbuka di masa depan.

🌀 Transformer: Revolusi dalam Pemrosesan Bahasa Alami

🌟 Dalam beberapa tahun terakhir, salah satu perkembangan paling signifikan di bidang Pemrosesan Bahasa Alami (NLP) adalah diperkenalkannya model Transformer, seperti yang dijelaskan dalam makalah tahun 2017 “Yang Anda Butuhkan Perhatian.” Model ini secara mendasar mengubah bidang ini dengan membuang struktur berulang atau konvolusional yang sebelumnya digunakan untuk tugas transduksi urutan seperti terjemahan mesin. Sebaliknya, hal ini hanya bergantung pada mekanisme perhatian. Sejak saat itu, desain Transformer telah menjadi dasar bagi banyak model yang mewakili kecanggihan di berbagai bidang seperti pembuatan bahasa, penerjemahan, dan lainnya.

🔄 Sang Transformator: Pergeseran paradigma

Sebelum diperkenalkannya Transformer, sebagian besar model untuk tugas pengurutan didasarkan pada jaringan saraf berulang (RNN) atau jaringan memori jangka pendek (LSTM), yang pada dasarnya bersifat berurutan. Model ini memproses data masukan langkah demi langkah, menciptakan keadaan tersembunyi yang disebarkan sepanjang urutan. Meskipun metode ini efektif, namun secara komputasi mahal dan sulit untuk diparalelkan, terutama untuk rangkaian yang panjang. Selain itu, RNN mengalami kesulitan mempelajari ketergantungan jangka panjang karena apa yang disebut masalah “gradien hilang”.

Inovasi utama Transformer terletak pada penggunaan mekanisme perhatian diri, yang memungkinkan model untuk mempertimbangkan pentingnya kata-kata yang berbeda dalam sebuah kalimat relatif satu sama lain, terlepas dari posisinya. Hal ini memungkinkan model untuk menangkap hubungan antara kata-kata yang berjarak jauh lebih efektif dibandingkan RNN atau LSTM, dan melakukannya secara paralel, bukan secara berurutan. Hal ini tidak hanya meningkatkan efisiensi pelatihan, tetapi juga kinerja pada tugas-tugas seperti terjemahan mesin.

🧩 Arsitektur model

Transformer terdiri dari dua komponen utama: encoder dan decoder, keduanya terdiri dari banyak lapisan dan sangat bergantung pada mekanisme perhatian multi-head.

⚙️ Pembuat enkode

Encoder terdiri dari enam lapisan identik, masing-masing dengan dua sublapisan:

1. Perhatian Diri Multi-Kepala

Mekanisme ini memungkinkan model untuk fokus pada bagian kalimat masukan yang berbeda saat memproses setiap kata. Alih-alih menghitung perhatian dalam satu ruang, perhatian multi-kepala memproyeksikan masukan ke beberapa ruang berbeda, memungkinkan berbagai jenis hubungan antar kata ditangkap.

2. Jaringan feedforward yang terhubung sepenuhnya berdasarkan posisi

Setelah lapisan perhatian, jaringan feedforward yang terhubung sepenuhnya diterapkan secara independen di setiap posisi. Hal ini membantu model memproses setiap kata dalam konteks dan memanfaatkan informasi dari mekanisme perhatian.

Untuk mempertahankan struktur urutan masukan, model juga berisi masukan posisi (pengkodean posisi). Karena Transformer tidak memproses kata secara berurutan, pengkodean ini sangat penting dalam memberikan informasi model tentang urutan kata dalam sebuah kalimat. Input posisi ditambahkan ke kata embeddings sehingga model dapat membedakan berbagai posisi dalam urutan.

🔍 Dekoder

Seperti encoder, decoder juga terdiri dari enam lapisan, dengan setiap lapisan memiliki mekanisme perhatian tambahan yang memungkinkan model untuk fokus pada bagian yang relevan dari urutan masukan sambil menghasilkan keluaran. Decoder juga menggunakan teknik masking untuk mencegahnya mempertimbangkan posisi masa depan, menjaga sifat autoregresif dari pembuatan urutan.

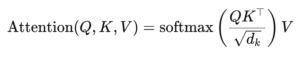

🧠 Perhatian multi-kepala dan perhatian produk titik

Inti dari Transformer adalah mekanisme Multi-Head Attention, yang merupakan perpanjangan dari perhatian produk titik yang lebih sederhana. Fungsi perhatian dapat dilihat sebagai pemetaan antara kueri dan sekumpulan pasangan kunci-nilai (kunci dan nilai), di mana setiap kunci mewakili sebuah kata dalam urutan dan nilai mewakili informasi kontekstual terkait.

Mekanisme perhatian multi-kepala memungkinkan model untuk fokus pada bagian-bagian berbeda dari rangkaian secara bersamaan. Dengan memproyeksikan masukan ke beberapa subruang, model dapat menangkap rangkaian hubungan antar kata yang lebih kaya. Hal ini sangat berguna dalam tugas-tugas seperti terjemahan mesin, di mana memahami konteks sebuah kata memerlukan banyak faktor berbeda, seperti struktur sintaksis dan makna semantik.

Rumus perhatian perkalian titik adalah:

Disini (Q) adalah matriks query, (K) adalah matriks kunci dan (V) adalah matriks nilai. Istilah (sqrt{d_k}) adalah faktor penskalaan yang mencegah perkalian titik menjadi terlalu besar, yang akan menyebabkan gradien sangat kecil dan pembelajaran lebih lambat. Fungsi softmax diterapkan untuk memastikan bahwa bobot perhatian berjumlah satu.

🚀 Keunggulan Trafo

Transformer menawarkan beberapa keunggulan utama dibandingkan model tradisional seperti RNN dan LSTM:

1. Paralelisasi

Karena Transformer memproses semua token secara berurutan pada saat yang sama, maka Transformer dapat diparalelkan sehingga jauh lebih cepat untuk dilatih dibandingkan RNN atau LSTM, terutama pada kumpulan data yang besar.

2. Ketergantungan jangka panjang

Mekanisme perhatian diri memungkinkan model untuk menangkap hubungan antara kata-kata yang jauh secara lebih efektif daripada RNN, yang dibatasi oleh sifat komputasi yang berurutan.

3. Skalabilitas

Transformer dapat dengan mudah menskalakan kumpulan data yang sangat besar dan urutan yang lebih panjang tanpa mengalami hambatan kinerja yang terkait dengan RNN.

🌍 Aplikasi dan efek

Sejak diperkenalkan, Transformer telah menjadi dasar berbagai model NLP. Salah satu contoh yang paling menonjol adalah BERT (Representasi Encoder Dua Arah dari Transformers), yang menggunakan arsitektur Transformer yang dimodifikasi untuk mencapai kecanggihan dalam banyak tugas NLP, termasuk menjawab pertanyaan dan klasifikasi teks.

Perkembangan signifikan lainnya adalah GPT (Generative Pretrained Transformer), yang menggunakan Transformer versi terbatas dekoder untuk pembuatan teks. Model GPT, termasuk GPT-3, kini digunakan untuk berbagai aplikasi, mulai dari pembuatan konten hingga penyelesaian kode.

🔍 Model yang kuat dan fleksibel

Transformer secara mendasar telah mengubah cara kita mendekati tugas-tugas NLP. Ini memberikan model yang kuat dan fleksibel yang dapat diterapkan pada berbagai masalah. Kemampuannya untuk menangani ketergantungan jangka panjang dan efisiensi pelatihan menjadikannya pendekatan arsitektur pilihan untuk banyak model paling modern. Seiring kemajuan penelitian, kita mungkin akan melihat peningkatan dan penyesuaian lebih lanjut pada Transformer, khususnya di bidang seperti pemrosesan gambar dan bahasa, di mana mekanisme perhatian menunjukkan hasil yang menjanjikan.

Kami siap membantu Anda - saran - perencanaan - implementasi - manajemen proyek

☑️ Pakar industri, dengan Xpert miliknya sendiri. Pusat industri digital dengan lebih dari 2.500 artikel spesialis

Saya akan dengan senang hati menjadi penasihat pribadi Anda.

Anda dapat menghubungi saya dengan mengisi formulir kontak di bawah ini atau cukup hubungi saya di +49 89 89 674 804 (Munich) .

Saya menantikan proyek bersama kita.

Xpert.Digital - Konrad Wolfenstein

Xpert.Digital adalah pusat industri dengan fokus pada digitalisasi, teknik mesin, logistik/intralogistik, dan fotovoltaik.

Dengan solusi pengembangan bisnis 360°, kami mendukung perusahaan terkenal mulai dari bisnis baru hingga purna jual.

Kecerdasan pasar, pemasaran, otomasi pemasaran, pengembangan konten, PR, kampanye surat, media sosial yang dipersonalisasi, dan pemeliharaan prospek adalah bagian dari alat digital kami.

Anda dapat mengetahui lebih lanjut di: www.xpert.digital - www.xpert.solar - www.xpert.plus