BERT के साथ AI और SEO - ट्रांसफॉर्मर्स से द्विदिश एनकोडर प्रतिनिधित्व - प्राकृतिक भाषा प्रसंस्करण (एनएलपी) के क्षेत्र में मॉडल

भाषा चयन 📢

प्रकाशित तिथि: 4 अक्टूबर, 2024 / अद्यतन तिथि: 4 अक्टूबर, 2024 – लेखक: Konrad Wolfenstein

BERT के साथ AI और SEO - ट्रांसफॉर्मर्स से द्विदिश एनकोडर प्रतिनिधित्व - प्राकृतिक भाषा प्रसंस्करण (एनएलपी) के क्षेत्र में मॉडल - छवि: Xpert.Digital

🚀💬 Google द्वारा विकसित: BERT और NLP के लिए इसका महत्व - द्विदिशात्मक पाठ समझ क्यों महत्वपूर्ण है

🔍🗣️ BERT, ट्रांसफार्मर से द्विदिशात्मक एनकोडर प्रतिनिधित्व के लिए संक्षिप्त, Google द्वारा विकसित प्राकृतिक भाषा प्रसंस्करण (एनएलपी) के क्षेत्र में एक प्रमुख मॉडल है। इसने मशीनों के भाषा समझने के तरीके में क्रांति ला दी है। पिछले मॉडलों के विपरीत, जो बाएं से दाएं या इसके विपरीत क्रमिक रूप से पाठ का विश्लेषण करते थे, बीईआरटी द्विदिश प्रसंस्करण को सक्षम बनाता है। इसका मतलब यह है कि यह किसी शब्द के संदर्भ को पूर्ववर्ती और बाद के पाठ अनुक्रम दोनों से पकड़ लेता है। यह क्षमता जटिल भाषाई संदर्भों की समझ में उल्लेखनीय रूप से सुधार करती है।

🔍 BERT की वास्तुकला

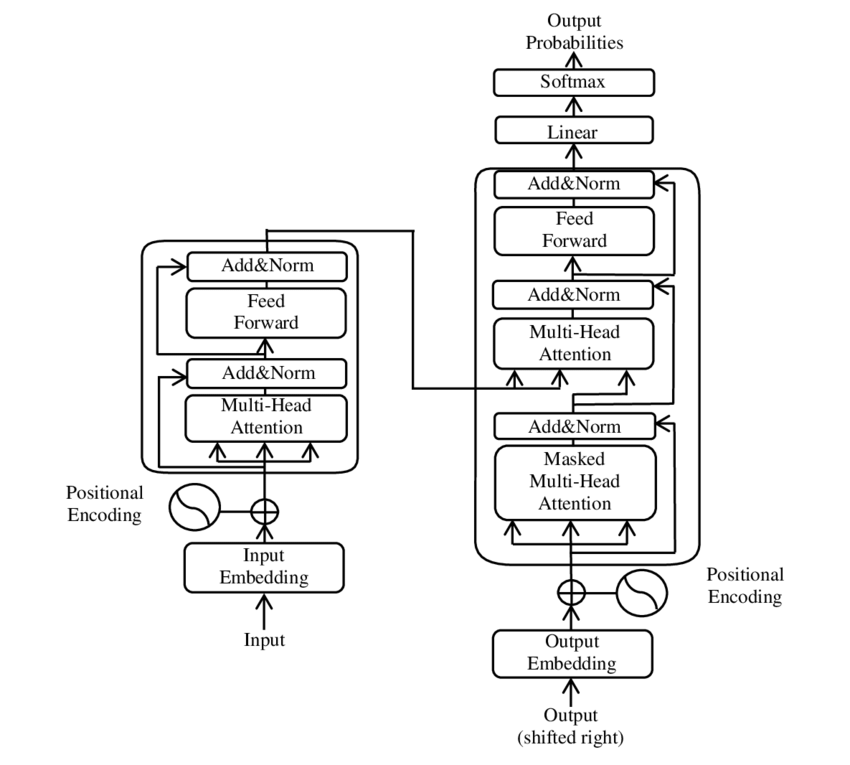

हाल के वर्षों में, प्राकृतिक भाषा प्रसंस्करण (एनएलपी) के क्षेत्र में सबसे महत्वपूर्ण विकास ट्रांसफार्मर मॉडल की शुरूआत के साथ हुआ है, जैसा कि पीडीएफ 2017 में प्रस्तुत किया गया है - आपको केवल ध्यान देने की आवश्यकता है - पेपर ( विकिपीडिया )। इस मॉडल ने मशीनी अनुवाद जैसी पहले इस्तेमाल की गई संरचनाओं को त्यागकर क्षेत्र को मौलिक रूप से बदल दिया। इसके बजाय, यह विशेष रूप से ध्यान तंत्र पर निर्भर करता है। तब से, ट्रांसफार्मर के डिज़ाइन ने कई मॉडलों का आधार बनाया है जो भाषा निर्माण, अनुवाद और उससे आगे जैसे विभिन्न क्षेत्रों में कला की स्थिति का प्रतिनिधित्व करते हैं।

BERT इसी ट्रांसफार्मर आर्किटेक्चर पर आधारित है। यह वास्तुकला एक वाक्य में शब्दों के बीच संबंधों का विश्लेषण करने के लिए तथाकथित आत्म-ध्यान तंत्र का उपयोग करती है। पूरे वाक्य के संदर्भ में प्रत्येक शब्द पर ध्यान दिया जाता है, जिसके परिणामस्वरूप वाक्य-विन्यास और अर्थ संबंधी संबंधों की अधिक सटीक समझ प्राप्त होती है।

कागज के लेखक "ध्यान आप सभी की आवश्यकता है":

- आशीष वासवानी (गूगल ब्रेन)

- नोम शज़ीर (गूगल ब्रेन)

- निकी परमार (गूगल रिसर्च)

- जैकब उस्ज़कोरिट (गूगल रिसर्च)

- लायन जोन्स (गूगल रिसर्च)

- ऐडन एन. गोमेज़ (टोरंटो विश्वविद्यालय, Google Brain में आंशिक रूप से किया गया कार्य)

- लुकाज़ कैसर (गूगल ब्रेन)

- इलिया पोलोसुखिन (स्वतंत्र, Google रिसर्च में पिछला कार्य)

इन लेखकों ने इस पेपर में प्रस्तुत ट्रांसफार्मर मॉडल के विकास में महत्वपूर्ण योगदान दिया।

🔄 द्विदिशीय प्रसंस्करण

BERT की एक असाधारण विशेषता इसकी द्विदिशात्मक प्रसंस्करण क्षमता है। जबकि पारंपरिक मॉडल जैसे आवर्ती तंत्रिका नेटवर्क (आरएनएन) या लॉन्ग शॉर्ट-टर्म मेमोरी (एलएसटीएम) नेटवर्क केवल एक दिशा में पाठ को संसाधित करते हैं, बीईआरटी दोनों दिशाओं में एक शब्द के संदर्भ का विश्लेषण करता है। यह मॉडल को अर्थ की सूक्ष्म बारीकियों को बेहतर ढंग से पकड़ने की अनुमति देता है और इसलिए अधिक सटीक भविष्यवाणियां करता है।

🕵️♂️ नकाबपोश भाषा मॉडलिंग

BERT का एक और नवीन पहलू मास्क्ड लैंग्वेज मॉडल (MLM) तकनीक है। इसमें एक वाक्य में बेतरतीब ढंग से चयनित शब्दों को छिपाना और आसपास के संदर्भ के आधार पर इन शब्दों की भविष्यवाणी करने के लिए मॉडल को प्रशिक्षित करना शामिल है। यह विधि BERT को वाक्य में प्रत्येक शब्द के संदर्भ और अर्थ की गहरी समझ विकसित करने के लिए बाध्य करती है।

🚀 BERT का प्रशिक्षण और अनुकूलन

BERT दो चरणों वाली प्रशिक्षण प्रक्रिया से गुजरता है: पूर्व-प्रशिक्षण और फाइन-ट्यूनिंग।

📚पूर्व प्रशिक्षण

पूर्व-प्रशिक्षण में, सामान्य भाषा पैटर्न सीखने के लिए BERT को बड़ी मात्रा में पाठ के साथ प्रशिक्षित किया जाता है। इसमें विकिपीडिया पाठ और अन्य व्यापक पाठ निगम शामिल हैं। इस चरण में, मॉडल बुनियादी भाषाई संरचनाओं और संदर्भों को सीखता है।

🔧 बढ़िया ट्यूनिंग

पूर्व-प्रशिक्षण के बाद, BERT को विशिष्ट एनएलपी कार्यों, जैसे पाठ वर्गीकरण या भावना विश्लेषण, के लिए अनुकूलित किया जाता है। मॉडल को विशिष्ट अनुप्रयोगों के लिए अपने प्रदर्शन को अनुकूलित करने के लिए छोटे, कार्य-संबंधित डेटा सेट के साथ प्रशिक्षित किया जाता है।

🌍बीईआरटी के अनुप्रयोग के क्षेत्र

प्राकृतिक भाषा प्रसंस्करण के कई क्षेत्रों में BERT बेहद उपयोगी साबित हुआ है:

सर्च इंजन अनुकूलन

Google खोज क्वेरी को बेहतर ढंग से समझने और अधिक प्रासंगिक परिणाम दिखाने के लिए BERT का उपयोग करता है। इससे उपयोगकर्ता अनुभव में काफी सुधार होता है।

पाठ वर्गीकरण

BERT दस्तावेज़ों को विषय के आधार पर वर्गीकृत कर सकता है या पाठों में मनोदशा का विश्लेषण कर सकता है।

नामित इकाई मान्यता (एनईआर)

मॉडल टेक्स्ट में नामित संस्थाओं की पहचान और वर्गीकरण करता है, जैसे व्यक्तिगत, स्थान या संगठन के नाम।

प्रश्न और उत्तर प्रणाली

BERT का उपयोग पूछे गए प्रश्नों के सटीक उत्तर प्रदान करने के लिए किया जाता है।

🧠 AI के भविष्य के लिए BERT का महत्व

बीईआरटी ने एनएलपी मॉडल के लिए नए मानक स्थापित किए हैं और आगे के नवाचारों के लिए मार्ग प्रशस्त किया है। अपनी द्विदिश प्रसंस्करण क्षमता और भाषा संदर्भ की गहरी समझ के माध्यम से, इसने एआई अनुप्रयोगों की दक्षता और सटीकता में उल्लेखनीय वृद्धि की है।

🔜 भविष्य के विकास

बीईआरटी और इसी तरह के मॉडलों के आगे के विकास का लक्ष्य संभवतः और भी अधिक शक्तिशाली सिस्टम बनाना होगा। ये अधिक जटिल भाषा कार्यों को संभाल सकते हैं और अनुप्रयोग के विभिन्न नए क्षेत्रों में उपयोग किए जा सकते हैं। ऐसे मॉडलों को रोजमर्रा की प्रौद्योगिकियों में एकीकृत करने से हम कंप्यूटर के साथ बातचीत करने के तरीके को मौलिक रूप से बदल सकते हैं।

🌟 कृत्रिम बुद्धिमत्ता के विकास में मील का पत्थर

BERT कृत्रिम बुद्धिमत्ता के विकास में एक मील का पत्थर है और इसने मशीनों द्वारा प्राकृतिक भाषा को संसाधित करने के तरीके में क्रांति ला दी है। इसकी द्विदिशीय वास्तुकला भाषाई संबंधों की गहरी समझ को सक्षम बनाती है, जो इसे विभिन्न अनुप्रयोगों के लिए अपरिहार्य बनाती है। जैसे-जैसे अनुसंधान आगे बढ़ता है, BERT जैसे मॉडल AI सिस्टम को बेहतर बनाने और उनके उपयोग के लिए नई संभावनाओं को खोलने में केंद्रीय भूमिका निभाते रहेंगे।

📣समान विषय

- 📚 परिचय BERT: द ब्रेकथ्रू एनएलपी मॉडल

- 🔍 BERT और एनएलपी में द्विदिशता की भूमिका

- 🧠 ट्रांसफार्मर मॉडल: BERT की आधारशिला

- 🚀 नकाबपोश भाषा मॉडलिंग: बर्ट की सफलता की कुंजी

- 📈 BERT का अनुकूलन: पूर्व-प्रशिक्षण से लेकर फाइन-ट्यूनिंग तक

- 🌐आधुनिक प्रौद्योगिकी में BERT के अनुप्रयोग के क्षेत्र

- 🤖 कृत्रिम बुद्धिमत्ता के भविष्य पर BERT का प्रभाव

- 💡 भविष्य की संभावनाएं: BERT का आगे का विकास

- 🏆 BERT AI विकास में एक मील का पत्थर है

- 📰 ट्रांसफॉर्मर पेपर "अटेंशन इज़ ऑल यू नीड" के लेखक: BERT के पीछे का दिमाग

#️⃣ हैशटैग: #एनएलपी #आर्टिफिशियलइंटेलिजेंस #लैंग्वेज मॉडलिंग #ट्रांसफॉर्मर #मशीनलर्निंग

🎯🎯🎯 एक व्यापक सेवा पैकेज में Xpert.Digital की व्यापक, पाँच-गुना विशेषज्ञता का लाभ उठाएँ | BD, R&D, XR, PR और डिजिटल दृश्यता अनुकूलन

Xpert.Digital की व्यापक, पाँच गुना विशेषज्ञता का लाभ एक व्यापक सेवा पैकेज में उठाएँ | R&D, XR, PR और डिजिटल दृश्यता अनुकूलन - छवि: Xpert.Digital

एक्सपर्ट.डिजिटल को विभिन्न उद्योगों का गहन ज्ञान है। यह हमें ऐसी अनुकूलित रणनीतियाँ विकसित करने की अनुमति देता है जो आपके विशिष्ट बाज़ार खंड की आवश्यकताओं और चुनौतियों के अनुरूप होती हैं। बाजार के रुझानों का लगातार विश्लेषण करके और उद्योग के विकास का अनुसरण करके, हम दूरदर्शिता के साथ कार्य कर सकते हैं और नवीन समाधान पेश कर सकते हैं। अनुभव और ज्ञान के संयोजन के माध्यम से, हम अतिरिक्त मूल्य उत्पन्न करते हैं और अपने ग्राहकों को निर्णायक प्रतिस्पर्धी लाभ देते हैं।

इसके बारे में यहां अधिक जानकारी:

बर्ट: क्रांतिकारी 🌟 एनएलपी तकनीक

🚀 BERT, ट्रांसफॉर्मर्स से द्विदिश एनकोडर रिप्रेजेंटेशन के लिए संक्षिप्त, Google द्वारा विकसित एक उन्नत भाषा मॉडल है जो 2018 में लॉन्च होने के बाद से प्राकृतिक भाषा प्रसंस्करण (एनएलपी) के क्षेत्र में एक महत्वपूर्ण सफलता बन गया है। यह ट्रांसफॉर्मर आर्किटेक्चर पर आधारित है, जिसने मशीनों द्वारा टेक्स्ट को समझने और संसाधित करने के तरीके में क्रांति ला दी है। लेकिन वास्तव में BERT को इतना खास क्या बनाता है और वास्तव में इसका उपयोग किस लिए किया जाता है? इस प्रश्न का उत्तर देने के लिए, हमें BERT के तकनीकी सिद्धांतों, कार्यक्षमता और अनुप्रयोग क्षेत्रों में गहराई से जाने की आवश्यकता है।

📚 1. प्राकृतिक भाषा प्रसंस्करण की मूल बातें

बीईआरटी के अर्थ को पूरी तरह से समझने के लिए, प्राकृतिक भाषा प्रसंस्करण (एनएलपी) की बुनियादी बातों की संक्षेप में समीक्षा करना सहायक होता है। एनएलपी कंप्यूटर और मानव भाषा के बीच बातचीत से संबंधित है। लक्ष्य मशीनों को टेक्स्ट डेटा का विश्लेषण करना, समझना और प्रतिक्रिया देना सिखाना है। बीईआरटी जैसे मॉडलों की शुरूआत से पहले, भाषा की मशीन प्रसंस्करण अक्सर महत्वपूर्ण चुनौतियां पेश करती थी, विशेष रूप से अस्पष्टता, संदर्भ निर्भरता और मानव भाषा की जटिल संरचना के कारण।

📈 2. एनएलपी मॉडल का विकास

बीईआरटी के परिदृश्य में आने से पहले, अधिकांश एनएलपी मॉडल तथाकथित यूनिडायरेक्शनल आर्किटेक्चर पर आधारित थे। इसका मतलब यह है कि ये मॉडल केवल बाएं से दाएं या दाएं से बाएं पाठ को पढ़ते हैं, जिसका अर्थ है कि वे किसी वाक्य में किसी शब्द को संसाधित करते समय केवल सीमित मात्रा में संदर्भ को ध्यान में रख सकते हैं। इस सीमा के परिणामस्वरूप अक्सर मॉडल किसी वाक्य के पूर्ण अर्थ संदर्भ को पूरी तरह से कैप्चर नहीं कर पाते हैं। इससे अस्पष्ट या संदर्भ-संवेदनशील शब्दों की सटीक व्याख्या करना मुश्किल हो गया।

BERT से पहले एनएलपी अनुसंधान में एक और महत्वपूर्ण विकास वर्ड2वेक मॉडल था, जिसने कंप्यूटर को शब्दों को वैक्टर में अनुवाद करने की अनुमति दी जो अर्थ संबंधी समानताएं दर्शाते थे। लेकिन यहां भी सन्दर्भ किसी शब्द के निकटतम परिवेश तक ही सीमित था। बाद में, आवर्ती तंत्रिका नेटवर्क (आरएनएन) और विशेष रूप से दीर्घकालिक अल्पकालिक मेमोरी (एलएसटीएम) मॉडल विकसित किए गए, जिससे कई शब्दों में जानकारी संग्रहीत करके पाठ अनुक्रमों को बेहतर ढंग से समझना संभव हो गया। हालाँकि, इन मॉडलों की भी अपनी सीमाएँ थीं, खासकर जब एक ही समय में लंबे पाठों और दोनों दिशाओं में संदर्भ को समझने का काम किया जाता था।

🔄 3. ट्रांसफार्मर वास्तुकला के माध्यम से क्रांति

सफलता 2017 में ट्रांसफॉर्मर आर्किटेक्चर की शुरुआत के साथ आई, जो BERT का आधार बनता है। ट्रांसफॉर्मर मॉडल को पूर्ववर्ती और बाद के पाठ दोनों से एक शब्द के संदर्भ को ध्यान में रखते हुए, पाठ के समानांतर प्रसंस्करण को सक्षम करने के लिए डिज़ाइन किया गया है। यह तथाकथित आत्म-ध्यान तंत्र के माध्यम से किया जाता है, जो वाक्य में प्रत्येक शब्द को इस आधार पर महत्व देता है कि यह वाक्य में अन्य शब्दों के संबंध में कितना महत्वपूर्ण है।

पिछले दृष्टिकोणों के विपरीत, ट्रांसफार्मर मॉडल यूनिडायरेक्शनल नहीं हैं, बल्कि द्विदिशात्मक हैं। इसका मतलब यह है कि वे किसी शब्द के बाएँ और दाएँ दोनों संदर्भों से जानकारी खींच सकते हैं, जिससे शब्द और उसके अर्थ का अधिक पूर्ण और सटीक प्रतिनिधित्व तैयार हो सकता है।

🧠 4. बर्ट: एक द्विदिश मॉडल

BERT ट्रांसफॉर्मर आर्किटेक्चर के प्रदर्शन को एक नए स्तर पर ले जाता है। मॉडल को किसी शब्द के संदर्भ को न केवल बाएं से दाएं या दाएं से बाएं, बल्कि दोनों दिशाओं में एक साथ कैप्चर करने के लिए डिज़ाइन किया गया है। यह BERT को एक वाक्य के भीतर किसी शब्द के पूर्ण संदर्भ पर विचार करने की अनुमति देता है, जिसके परिणामस्वरूप भाषा प्रसंस्करण कार्यों में सटीकता में काफी सुधार होता है।

बीईआरटी की एक केंद्रीय विशेषता तथाकथित मास्क्ड लैंग्वेज मॉडल (एमएलएम) का उपयोग है। BERT के प्रशिक्षण में, एक वाक्य में बेतरतीब ढंग से चयनित शब्दों को एक मुखौटे से बदल दिया जाता है, और मॉडल को संदर्भ के आधार पर इन नकाबपोश शब्दों का अनुमान लगाने के लिए प्रशिक्षित किया जाता है। यह तकनीक BERT को एक वाक्य में शब्दों के बीच गहरे और अधिक सटीक संबंधों को सीखने की अनुमति देती है।

इसके अतिरिक्त, BERT नेक्स्ट सेंटेंस प्रेडिक्शन (NSP) नामक एक विधि का उपयोग करता है, जहां मॉडल यह अनुमान लगाना सीखता है कि एक वाक्य दूसरे का अनुसरण करता है या नहीं। इससे BERT की लंबे पाठों को समझने और वाक्यों के बीच अधिक जटिल संबंधों को पहचानने की क्षमता में सुधार होता है।

🌐5. BERT का व्यवहार में अनुप्रयोग

BERT विभिन्न प्रकार के एनएलपी कार्यों के लिए बेहद उपयोगी साबित हुआ है। यहां आवेदन के कुछ मुख्य क्षेत्र दिए गए हैं:

📊 ए) पाठ वर्गीकरण

BERT का सबसे आम उपयोग पाठ वर्गीकरण है, जहां पाठ को पूर्वनिर्धारित श्रेणियों में विभाजित किया जाता है। इसके उदाहरणों में भावना विश्लेषण (उदाहरण के लिए यह पहचानना कि कोई पाठ सकारात्मक है या नकारात्मक) या ग्राहक प्रतिक्रिया का वर्गीकरण शामिल है। शब्दों के संदर्भ की गहरी समझ के माध्यम से BERT पिछले मॉडलों की तुलना में अधिक सटीक परिणाम प्रदान कर सकता है।

❓ बी) प्रश्न-उत्तर प्रणाली

BERT का उपयोग प्रश्न-उत्तर प्रणालियों में भी किया जाता है, जहां मॉडल किसी पाठ से पूछे गए प्रश्नों के उत्तर निकालता है। यह क्षमता खोज इंजन, चैटबॉट या वर्चुअल असिस्टेंट जैसे अनुप्रयोगों में विशेष रूप से महत्वपूर्ण है। अपनी द्विदिशीय वास्तुकला के लिए धन्यवाद, बीईआरटी किसी पाठ से प्रासंगिक जानकारी निकाल सकता है, भले ही प्रश्न अप्रत्यक्ष रूप से तैयार किया गया हो।

🌍 ग) पाठ अनुवाद

जबकि BERT को सीधे अनुवाद मॉडल के रूप में डिज़ाइन नहीं किया गया है, इसका उपयोग मशीनी अनुवाद को बेहतर बनाने के लिए अन्य तकनीकों के साथ संयोजन में किया जा सकता है। एक वाक्य में शब्दार्थ संबंधों को बेहतर ढंग से समझकर, BERT अधिक सटीक अनुवाद उत्पन्न करने में मदद कर सकता है, विशेष रूप से अस्पष्ट या जटिल शब्दों के लिए।

🏷️ डी) नामित इकाई मान्यता (एनईआर)

अनुप्रयोग का एक अन्य क्षेत्र नामांकित इकाई पहचान (एनईआर) है, जिसमें किसी पाठ में नाम, स्थान या संगठन जैसी विशिष्ट संस्थाओं की पहचान करना शामिल है। BERT इस कार्य में विशेष रूप से प्रभावी साबित हुआ है क्योंकि यह एक वाक्य के संदर्भ को पूरी तरह से ध्यान में रखता है, जिससे संस्थाओं को पहचानने में बेहतर बनाता है, भले ही उनके अलग-अलग संदर्भों में अलग-अलग अर्थ हों।

✂️ ई) पाठ सारांश

किसी पाठ के संपूर्ण संदर्भ को समझने की BERT की क्षमता इसे स्वचालित पाठ संक्षेपण के लिए एक शक्तिशाली उपकरण भी बनाती है। इसका उपयोग लंबे पाठ से सबसे महत्वपूर्ण जानकारी निकालने और संक्षिप्त सारांश बनाने के लिए किया जा सकता है।

🌟 6. अनुसंधान और उद्योग के लिए BERT का महत्व

बीईआरटी की शुरूआत ने एनएलपी अनुसंधान में एक नए युग की शुरुआत की। यह द्वि-दिशात्मक ट्रांसफार्मर वास्तुकला की शक्ति का पूरा लाभ उठाने वाले पहले मॉडलों में से एक था, जिसने बाद के कई मॉडलों के लिए मानक स्थापित किया। कई कंपनियों और अनुसंधान संस्थानों ने अपने अनुप्रयोगों के प्रदर्शन को बेहतर बनाने के लिए BERT को अपनी एनएलपी पाइपलाइनों में एकीकृत किया है।

इसके अलावा, BERT ने भाषा मॉडल के क्षेत्र में और अधिक नवाचारों का मार्ग प्रशस्त किया है। उदाहरण के लिए, GPT (जेनरेटिव प्रीट्रेंड ट्रांसफार्मर) और T5 (टेक्स्ट-टू-टेक्स्ट ट्रांसफर ट्रांसफार्मर) जैसे मॉडल बाद में विकसित किए गए, जो समान सिद्धांतों पर आधारित हैं लेकिन विभिन्न उपयोग के मामलों के लिए विशिष्ट सुधार प्रदान करते हैं।

🚧 7. BERT की चुनौतियाँ एवं सीमाएँ

इसके कई फायदों के बावजूद, BERT की कुछ चुनौतियाँ और सीमाएँ भी हैं। सबसे बड़ी बाधाओं में से एक मॉडल को प्रशिक्षित करने और लागू करने के लिए आवश्यक उच्च कम्प्यूटेशनल प्रयास है। क्योंकि BERT लाखों मापदंडों वाला एक बहुत बड़ा मॉडल है, इसके लिए शक्तिशाली हार्डवेयर और महत्वपूर्ण कंप्यूटिंग संसाधनों की आवश्यकता होती है, खासकर बड़ी मात्रा में डेटा संसाधित करते समय।

एक अन्य मुद्दा संभावित पूर्वाग्रह है जो प्रशिक्षण डेटा में मौजूद हो सकता है। क्योंकि BERT को बड़ी मात्रा में टेक्स्ट डेटा पर प्रशिक्षित किया जाता है, यह कभी-कभी उस डेटा में मौजूद पूर्वाग्रहों और रूढ़िवादिता को दर्शाता है। हालाँकि, शोधकर्ता इन मुद्दों की पहचान करने और उनका समाधान करने के लिए लगातार काम कर रहे हैं।

🔍आधुनिक भाषा प्रसंस्करण अनुप्रयोगों के लिए आवश्यक उपकरण

BERT ने मशीनों द्वारा मानव भाषा को समझने के तरीके में उल्लेखनीय सुधार किया है। अपनी द्विदिश वास्तुकला और नवीन प्रशिक्षण विधियों के साथ, यह एक वाक्य में शब्दों के संदर्भ को गहराई से और सटीक रूप से पकड़ने में सक्षम है, जिसके परिणामस्वरूप कई एनएलपी कार्यों में उच्च सटीकता होती है। चाहे पाठ वर्गीकरण, प्रश्न-उत्तर प्रणाली या इकाई पहचान में - बीईआरटी ने खुद को आधुनिक भाषा प्रसंस्करण अनुप्रयोगों के लिए एक अनिवार्य उपकरण के रूप में स्थापित किया है।

प्राकृतिक भाषा प्रसंस्करण में अनुसंधान निस्संदेह आगे बढ़ता रहेगा, और बीईआरटी ने भविष्य के कई नवाचारों की नींव रखी है। मौजूदा चुनौतियों और सीमाओं के बावजूद, BERT प्रभावशाली ढंग से दिखाता है कि कम समय में तकनीक कितनी आगे आ गई है और भविष्य में अभी भी कौन से रोमांचक अवसर खुलेंगे।

🌀 ट्रांसफार्मर: प्राकृतिक भाषा प्रसंस्करण में एक क्रांति

🌟 हाल के वर्षों में, प्राकृतिक भाषा प्रसंस्करण (एनएलपी) के क्षेत्र में सबसे महत्वपूर्ण विकासों में से एक ट्रांसफार्मर मॉडल की शुरूआत रही है, जैसा कि 2017 के पेपर "अटेंशन इज़ ऑल यू नीड" में वर्णित है। इस मॉडल ने मशीन अनुवाद जैसे अनुक्रम पारगमन कार्यों के लिए पहले से उपयोग की जाने वाली आवर्ती या दृढ़ संरचनाओं को त्यागकर क्षेत्र को मौलिक रूप से बदल दिया। इसके बजाय, यह विशेष रूप से ध्यान तंत्र पर निर्भर करता है। तब से, ट्रांसफार्मर के डिज़ाइन ने कई मॉडलों का आधार बनाया है जो भाषा निर्माण, अनुवाद और उससे आगे जैसे विभिन्न क्षेत्रों में कला की स्थिति का प्रतिनिधित्व करते हैं।

🔄 ट्रांसफार्मर: एक आदर्श बदलाव

ट्रांसफार्मर की शुरुआत से पहले, अनुक्रमण कार्यों के लिए अधिकांश मॉडल आवर्ती तंत्रिका नेटवर्क (आरएनएन) या दीर्घकालिक अल्पकालिक मेमोरी नेटवर्क (एलएसटीएम) पर आधारित थे, जो स्वाभाविक रूप से अनुक्रमिक हैं। ये मॉडल इनपुट डेटा को चरण दर चरण संसाधित करते हैं, छिपे हुए राज्य बनाते हैं जो अनुक्रम के साथ प्रसारित होते हैं। यद्यपि यह विधि प्रभावी है, यह कम्प्यूटेशनल रूप से महंगी है और इसे समानांतर करना कठिन है, विशेष रूप से लंबे अनुक्रमों के लिए। इसके अलावा, आरएनएन को तथाकथित "लुप्तप्राय ढाल" समस्या के कारण दीर्घकालिक निर्भरता सीखने में कठिनाई होती है।

ट्रांसफॉर्मर का केंद्रीय नवाचार आत्म-ध्यान तंत्र के उपयोग में निहित है, जो मॉडल को उनकी स्थिति की परवाह किए बिना, एक वाक्य में एक दूसरे के सापेक्ष विभिन्न शब्दों के महत्व को महत्व देने की अनुमति देता है। यह मॉडल को आरएनएन या एलएसटीएम की तुलना में व्यापक रूप से दूरी वाले शब्दों के बीच संबंधों को अधिक प्रभावी ढंग से पकड़ने की अनुमति देता है, और अनुक्रमिक के बजाय समानांतर तरीके से ऐसा करने की अनुमति देता है। इससे न केवल प्रशिक्षण दक्षता में सुधार होता है, बल्कि मशीनी अनुवाद जैसे कार्यों में प्रदर्शन में भी सुधार होता है।

🧩मॉडल वास्तुकला

ट्रांसफार्मर में दो मुख्य घटक होते हैं: एक एनकोडर और एक डिकोडर, दोनों में कई परतें होती हैं और मल्टी-हेड ध्यान तंत्र पर बहुत अधिक निर्भर होते हैं।

⚙️ एनकोडर

एनकोडर में छह समान परतें होती हैं, प्रत्येक में दो उपपरतें होती हैं:

1. बहु-प्रमुख आत्म-ध्यान

यह तंत्र मॉडल को इनपुट वाक्य के विभिन्न हिस्सों पर ध्यान केंद्रित करने की अनुमति देता है क्योंकि यह प्रत्येक शब्द को संसाधित करता है। एक ही स्थान पर ध्यान की गणना करने के बजाय, मल्टी-हेड ध्यान इनपुट को कई अलग-अलग स्थानों में प्रोजेक्ट करता है, जिससे शब्दों के बीच विभिन्न प्रकार के संबंधों को कैप्चर किया जा सकता है।

2. स्थिति-वार पूरी तरह से कनेक्टेड फीडफॉरवर्ड नेटवर्क

ध्यान परत के बाद, प्रत्येक स्थिति पर एक पूरी तरह से कनेक्टेड फीडफॉरवर्ड नेटवर्क स्वतंत्र रूप से लागू किया जाता है। यह मॉडल को प्रत्येक शब्द को संदर्भ में संसाधित करने और ध्यान तंत्र से जानकारी का उपयोग करने में मदद करता है।

इनपुट अनुक्रम की संरचना को संरक्षित करने के लिए, मॉडल में स्थितीय इनपुट (स्थितीय एन्कोडिंग) भी शामिल हैं। चूंकि ट्रांसफार्मर शब्दों को क्रमिक रूप से संसाधित नहीं करता है, इसलिए ये एन्कोडिंग एक वाक्य में शब्दों के क्रम के बारे में मॉडल को जानकारी देने में महत्वपूर्ण हैं। स्थिति इनपुट को शब्द एम्बेडिंग में जोड़ा जाता है ताकि मॉडल अनुक्रम में विभिन्न स्थितियों के बीच अंतर कर सके।

🔍डिकोडर

एनकोडर की तरह, डिकोडर में भी छह परतें होती हैं, प्रत्येक परत में एक अतिरिक्त ध्यान तंत्र होता है जो मॉडल को आउटपुट उत्पन्न करते समय इनपुट अनुक्रम के प्रासंगिक भागों पर ध्यान केंद्रित करने की अनुमति देता है। डिकोडर भविष्य की स्थितियों पर विचार करने से रोकने के लिए एक मास्किंग तकनीक का भी उपयोग करता है, जो अनुक्रम पीढ़ी की ऑटोरेग्रेसिव प्रकृति को संरक्षित करता है।

🧠 मल्टी-हेड ध्यान और डॉट उत्पाद ध्यान

ट्रांसफार्मर का हृदय मल्टी-हेड अटेंशन तंत्र है, जो सरल डॉट उत्पाद अटेंशन का विस्तार है। ध्यान फ़ंक्शन को एक क्वेरी और कुंजी-मूल्य जोड़े (कुंजी और मान) के सेट के बीच मैपिंग के रूप में देखा जा सकता है, जहां प्रत्येक कुंजी अनुक्रम में एक शब्द का प्रतिनिधित्व करती है और मान संबंधित प्रासंगिक जानकारी का प्रतिनिधित्व करता है।

मल्टी-हेड ध्यान तंत्र मॉडल को एक ही समय में अनुक्रम के विभिन्न हिस्सों पर ध्यान केंद्रित करने की अनुमति देता है। इनपुट को कई उप-स्थानों में प्रक्षेपित करके, मॉडल शब्दों के बीच संबंधों के एक समृद्ध सेट को कैप्चर कर सकता है। यह मशीनी अनुवाद जैसे कार्यों में विशेष रूप से उपयोगी है, जहां किसी शब्द के संदर्भ को समझने के लिए कई अलग-अलग कारकों की आवश्यकता होती है, जैसे वाक्यात्मक संरचना और अर्थ संबंधी अर्थ।

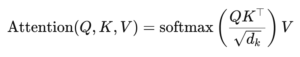

डॉट उत्पाद ध्यान का सूत्र है:

यहां (Q) क्वेरी मैट्रिक्स है, (K) कुंजी मैट्रिक्स है और (V) वैल्यू मैट्रिक्स है। शब्द (sqrt{d_k}) एक स्केलिंग कारक है जो डॉट उत्पादों को बहुत बड़ा होने से रोकता है, जिससे बहुत छोटे ग्रेडिएंट और धीमी सीख होगी। सॉफ्टमैक्स फ़ंक्शन को यह सुनिश्चित करने के लिए लागू किया जाता है कि ध्यान भार का योग एक हो।

🚀 ट्रांसफार्मर के फायदे

ट्रांसफार्मर आरएनएन और एलएसटीएम जैसे पारंपरिक मॉडलों पर कई प्रमुख लाभ प्रदान करता है:

1.समानांतरीकरण

क्योंकि ट्रांसफार्मर एक ही समय में सभी टोकन को एक क्रम में संसाधित करता है, इसे अत्यधिक समानांतर किया जा सकता है और इसलिए आरएनएन या एलएसटीएम की तुलना में प्रशिक्षित करना बहुत तेज़ है, खासकर बड़े डेटा सेट पर।

2. दीर्घकालिक निर्भरता

आत्म-ध्यान तंत्र मॉडल को आरएनएन की तुलना में दूर के शब्दों के बीच संबंधों को अधिक प्रभावी ढंग से पकड़ने की अनुमति देता है, जो उनकी गणना की अनुक्रमिक प्रकृति द्वारा सीमित हैं।

3. मापनीयता

ट्रांसफॉर्मर आरएनएन से जुड़ी प्रदर्शन बाधाओं से पीड़ित हुए बिना बहुत बड़े डेटासेट और लंबे अनुक्रमों को आसानी से स्केल कर सकता है।

🌍 अनुप्रयोग और प्रभाव

अपनी शुरुआत के बाद से, ट्रांसफार्मर एनएलपी मॉडल की एक विस्तृत श्रृंखला का आधार बन गया है। सबसे उल्लेखनीय उदाहरणों में से एक BERT (ट्रांसफॉर्मर्स से द्विदिश एनकोडर प्रतिनिधित्व) है, जो प्रश्न उत्तर और पाठ वर्गीकरण सहित कई एनएलपी कार्यों में अत्याधुनिक प्राप्त करने के लिए एक संशोधित ट्रांसफार्मर वास्तुकला का उपयोग करता है।

एक अन्य महत्वपूर्ण विकास जीपीटी (जेनरेटिव प्रीट्रेंड ट्रांसफार्मर) है, जो टेक्स्ट जेनरेशन के लिए ट्रांसफार्मर के डिकोडर-सीमित संस्करण का उपयोग करता है। GPT-3 सहित GPT मॉडल, अब सामग्री निर्माण से लेकर कोड पूरा करने तक विभिन्न प्रकार के अनुप्रयोगों के लिए उपयोग किए जाते हैं।

🔍 एक शक्तिशाली और लचीला मॉडल

ट्रांसफार्मर ने हमारे एनएलपी कार्यों को करने के तरीके को मौलिक रूप से बदल दिया है। यह एक शक्तिशाली और लचीला मॉडल प्रदान करता है जिसे विभिन्न प्रकार की समस्याओं पर लागू किया जा सकता है। दीर्घकालिक निर्भरता और प्रशिक्षण दक्षता को संभालने की इसकी क्षमता ने इसे कई आधुनिक मॉडलों के लिए पसंदीदा वास्तुशिल्प दृष्टिकोण बना दिया है। जैसे-जैसे अनुसंधान आगे बढ़ता है, हम संभवतः ट्रांसफार्मर में और सुधार और समायोजन देखेंगे, विशेष रूप से छवि और भाषा प्रसंस्करण जैसे क्षेत्रों में, जहां ध्यान तंत्र आशाजनक परिणाम दिखाते हैं।

हम आपके लिए हैं - सलाह - योजना - कार्यान्वयन - परियोजना प्रबंधन

☑️ उद्योग विशेषज्ञ, 2,500 से अधिक विशेषज्ञ लेखों के साथ यहां अपने स्वयं के विशेषज्ञ.डिजिटल उद्योग केंद्र के साथ

मुझे आपके निजी सलाहकार के रूप में सेवा करने में खुशी होगी।

आप नीचे दिए गए संपर्क फ़ॉर्म को भरकर मुझसे संपर्क कर सकते हैं या बस मुझे +49 89 89 674 804 (म्यूनिख) ।

मैं हमारी संयुक्त परियोजना की प्रतीक्षा कर रहा हूं।

एक्सपर्ट.डिजिटल - Konrad Wolfenstein

एक्सपर्ट.डिजिटल डिजिटलाइजेशन, मैकेनिकल इंजीनियरिंग, लॉजिस्टिक्स/इंट्रालॉजिस्टिक्स और फोटोवोल्टिक्स पर फोकस के साथ उद्योग का केंद्र है।

अपने 360° व्यवसाय विकास समाधान के साथ, हम नए व्यवसाय से लेकर बिक्री के बाद तक प्रसिद्ध कंपनियों का समर्थन करते हैं।

मार्केट इंटेलिजेंस, स्मार्केटिंग, मार्केटिंग ऑटोमेशन, कंटेंट डेवलपमेंट, पीआर, मेल अभियान, वैयक्तिकृत सोशल मीडिया और लीड पोषण हमारे डिजिटल टूल का हिस्सा हैं।

आप यहां अधिक जानकारी प्राप्त कर सकते हैं: www.xpert.digital - www.xpert.solar - www.xpert.plus