AI a SEO s BERT – Bidirectional Encoder Representations from Transformers – model v oblasti zpracování přirozeného jazyka (NLP)

Výběr hlasu 📢

Publikováno dne: 4. října 2024 / Aktualizace od: 4. října 2024 - Autor: Konrad Wolfenstein

AI a SEO s BERT – Reprezentace obousměrného kodéru od Transformers – Model v oblasti zpracování přirozeného jazyka (NLP) – Obrázek: Xpert.Digital

🚀💬 Vyvinuto společností Google: BERT a jeho význam pro NLP – proč je obousměrné porozumění textu klíčové

🔍🗣️ BERT, zkratka pro Bidirectional Encoder Representations od Transformers, je hlavní model v oblasti zpracování přirozeného jazyka (NLP) vyvinutý společností Google. Změnil způsob, jakým stroje rozumějí jazyku. Na rozdíl od předchozích modelů, které analyzovaly text postupně zleva doprava nebo naopak, umožňuje BERT obousměrné zpracování. To znamená, že zachycuje kontext slova z předchozí i následující textové sekvence. Tato schopnost výrazně zlepšuje porozumění složitým jazykovým souvislostem.

🔍 Architektura BERT

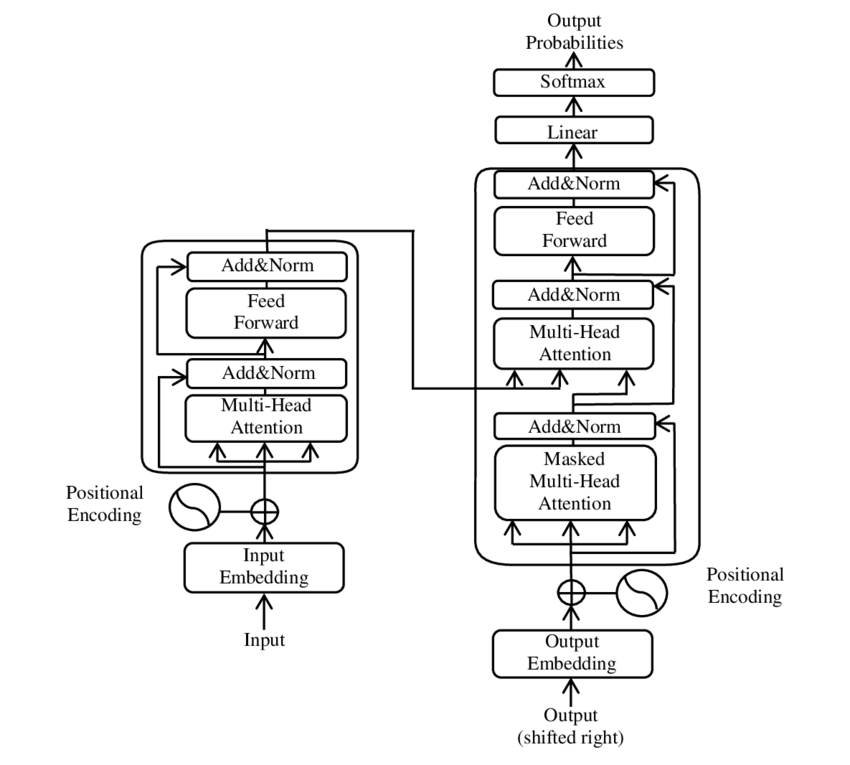

V posledních letech došlo k jednomu z nejvýznamnějších pokroků v oblasti zpracování přirozeného jazyka (NLP) zavedením modelu Transformer, jak je prezentováno v dokumentu PDF 2017 – Attention is all you need – paper ( Wikipedia ). Tento model zásadně změnil pole tím, že zahodil dříve používané struktury, jako je strojový překlad. Místo toho se spoléhá výhradně na mechanismy pozornosti. Od té doby se design Transformeru stal základem mnoha modelů, které reprezentují stav techniky v různých oblastech, jako je generování jazyků, překlady a další.

BERT je založen na této architektuře Transformer. Tato architektura využívá k analýze vztahů mezi slovy ve větě takzvané mechanismy sebepozorování. Pozornost je věnována každému slovu v kontextu celé věty, což vede k přesnějšímu pochopení syntaktických a sémantických vztahů.

Autoři příspěvku „Pozornost je vše, co potřebujete“, jsou:

- Ashish Vaswani (Google Brain)

- Noam Shazeer (Google Brain)

- Niki Parmar (Google Research)

- Jakob Uszkoreit (Google Research)

- Lion Jones (Google Research)

- Aidan N. Gomez (University of Toronto, práce částečně provedena v Google Brain)

- Lukasz Kaiser (Google Brain)

- Illia Polosukhin (nezávislý, předchozí práce ve výzkumu Google)

Tito autoři významně přispěli k vývoji modelu Transformer prezentovaného v tomto příspěvku.

🔄 Obousměrné zpracování

Vynikající funkcí BERT je jeho obousměrná schopnost zpracování. Zatímco tradiční modely, jako jsou rekurentní neuronové sítě (RNN) nebo sítě Long Short-Term Memory (LSTM), zpracovávají text pouze v jednom směru, BERT analyzuje kontext slova v obou směrech. To umožňuje modelu lépe zachytit jemné významové nuance, a proto provádět přesnější předpovědi.

🕵️♂️ Modelování maskovaného jazyka

Dalším inovativním aspektem BERT je technika maskovaného jazykového modelu (MLM). Zahrnuje maskování náhodně vybraných slov ve větě a trénování modelu, aby tato slova předpovídal na základě okolního kontextu. Tato metoda nutí BERT rozvíjet hluboké porozumění kontextu a významu každého slova ve větě.

🚀 Školení a přizpůsobení BERT

BERT prochází dvoufázovým tréninkovým procesem: předtréninkem a doladěním.

📚 Předtrénink

Během předškolního vzdělávání je BERT trénován s velkým množstvím textu, aby se naučil obecné jazykové vzorce. To zahrnuje texty Wikipedie a další rozsáhlé textové korpusy. V této fázi se model učí základním jazykovým strukturám a souvislostem.

🔧 Jemné doladění

Po předběžném školení je BERT přizpůsoben pro konkrétní úkoly NLP, jako je klasifikace textu nebo analýza sentimentu. Model je trénován s menšími datovými sadami souvisejícími s úkoly, aby se optimalizoval jeho výkon pro konkrétní aplikace.

🌍 Oblasti použití BERT

BERT se ukázal jako mimořádně užitečný v mnoha oblastech zpracování přirozeného jazyka:

Optimalizace pro vyhledávače

Google používá BERT k lepšímu pochopení vyhledávacích dotazů a zobrazení relevantnějších výsledků. To výrazně zlepšuje uživatelský zážitek.

Klasifikace textu

BERT může kategorizovat dokumenty podle témat nebo analyzovat náladu v textech.

Rozpoznávání pojmenované entity (NER)

Model identifikuje a klasifikuje pojmenované entity v textech, jako jsou jména osob, míst nebo organizací.

Systémy otázek a odpovědí

BERT se používá k poskytování přesných odpovědí na položené otázky.

🧠 Význam BERT pro budoucnost AI

BERT nastavil nové standardy pro modely NLP a připravil půdu pro další inovace. Díky své schopnosti obousměrného zpracování a hlubokému porozumění jazykovému kontextu výrazně zvýšil efektivitu a přesnost aplikací AI.

🔜 Budoucí vývoj

Další vývoj BERT a podobných modelů bude pravděpodobně směřovat k vytvoření ještě výkonnějších systémů. Ty by mohly zvládnout složitější jazykové úlohy a mohly by být použity v různých nových oblastech použití. Integrace takových modelů do každodenních technologií by mohla zásadně změnit způsob, jakým komunikujeme s počítači.

🌟 Milník ve vývoji umělé inteligence

BERT je milníkem ve vývoji umělé inteligence a způsobil revoluci ve způsobu, jakým stroje zpracovávají přirozený jazyk. Jeho obousměrná architektura umožňuje hlubší pochopení lingvistických vztahů, díky čemuž je nepostradatelný pro různé aplikace. Jak výzkum pokročí, modely jako BERT budou i nadále hrát ústřední roli při zlepšování systémů umělé inteligence a otevírání nových možností pro jejich použití.

📣 Podobná témata

- 📚 Představujeme BERT: Průlomový model NLP

- 🔍 BERT a role obousměrnosti v NLP

- 🧠 Model Transformer: základní kámen BERT

- 🚀 Maskované jazykové modelování: BERTův klíč k úspěchu

- 📈 Přizpůsobení BERT: Od předtréninku po jemné doladění

- 🌐 Oblasti použití BERT v moderní technologii

- 🤖 Vliv BERT na budoucnost umělé inteligence

- 💡 Budoucí vyhlídky: Další vývoj BERT

- 🏆 BERT jako milník ve vývoji AI

- 📰 Autoři článku Transformer „Attention Is All You Need“: Mysl za BERTem

#️⃣ Hashtagy: #NLP #Artificial Intelligence #Language Modeling #Transformer #MachineLearning

🎯🎯🎯 Využijte rozsáhlé, pětinásobné odborné znalosti Xpert.Digital v komplexním balíčku služeb | R&D, XR, PR & SEM

AI & XR 3D rendering Machine: Pětinásobná odbornost od Xpert.Digital v komplexním balíčku služeb, R&D XR, PR & SEM - Obrázek: Xpert.Digital

Xpert.Digital má hluboké znalosti z různých odvětví. To nám umožňuje vyvíjet strategie šité na míru, které jsou přesně přizpůsobeny požadavkům a výzvám vašeho konkrétního segmentu trhu. Neustálou analýzou tržních trendů a sledováním vývoje v oboru můžeme jednat s prozíravostí a nabízet inovativní řešení. Kombinací zkušeností a znalostí vytváříme přidanou hodnotu a poskytujeme našim zákazníkům rozhodující konkurenční výhodu.

Více o tom zde:

BERT: Revoluční 🌟 technologie NLP

🚀 BERT, zkratka pro Bidirectional Encoder Representations od Transformers, je pokročilý jazykový model vyvinutý společností Google, který se od svého uvedení v roce 2018 stal významným průlomem v oblasti zpracování přirozeného jazyka (NLP). Je založen na architektuře Transformer, která způsobila revoluci ve způsobu, jakým stroje chápou a zpracovávají text. Čím je ale BERT tak výjimečný a k čemu přesně slouží? Abychom na tuto otázku odpověděli, musíme se hlouběji ponořit do technických principů, funkčnosti a aplikačních oblastí BERT.

📚 1. Základy zpracování přirozeného jazyka

Abychom plně pochopili význam BERT, je užitečné stručně zopakovat základy zpracování přirozeného jazyka (NLP). NLP se zabývá interakcí mezi počítači a lidským jazykem. Cílem je naučit stroje analyzovat, rozumět a reagovat na textová data. Před zavedením modelů, jako je BERT, představovalo strojové zpracování jazyka často značné problémy, zejména kvůli nejednoznačnosti, závislosti na kontextu a složité struktuře lidského jazyka.

📈 2. Vývoj modelů NLP

Než přišel BERT na scénu, většina NLP modelů byla založena na takzvaných jednosměrných architekturách. To znamená, že tyto modely čtou text pouze zleva doprava nebo zprava doleva, což znamenalo, že při zpracování slova ve větě mohly vzít v úvahu pouze omezené množství kontextu. Toto omezení často vedlo k tomu, že modely plně nezachytily plný sémantický kontext věty. To ztěžovalo přesnou interpretaci nejednoznačných nebo kontextově citlivých slov.

Dalším důležitým vývojem ve výzkumu NLP před BERT byl model word2vec, který umožňoval počítačům překládat slova do vektorů, které odrážely sémantické podobnosti. Ale i zde byl kontext omezen na bezprostřední okolí slova. Později byly vyvinuty modely Recurrent Neural Networks (RNN) a zejména modely Long Short-Term Memory (LSTM), které umožnily lépe porozumět textovým sekvencím ukládáním informací přes více slov. I tyto modely však měly svá omezení, zejména při práci s dlouhými texty a porozumění kontextu v obou směrech současně.

🔄 3. Revoluce prostřednictvím architektury Transformer

Průlom přišel s představením architektury Transformer v roce 2017, která tvoří základ pro BERT. Modely transformátorů jsou navrženy tak, aby umožňovaly paralelní zpracování textu s přihlédnutím ke kontextu slova z předchozího i následujícího textu. Děje se tak pomocí takzvaných mechanismů sebepozornosti, které každému slovu ve větě přiřadí váhu podle toho, jak je důležité ve vztahu k ostatním slovům ve větě.

Na rozdíl od předchozích přístupů nejsou modely Transformer jednosměrné, ale obousměrné. To znamená, že mohou čerpat informace z levého i pravého kontextu slova a vytvářet úplnější a přesnější vyjádření slova a jeho významu.

🧠 4. BERT: Obousměrný model

BERT posouvá výkon architektury Transformer na novou úroveň. Model je navržen tak, aby zachytil kontext slova nejen zleva doprava nebo zprava doleva, ale v obou směrech současně. To umožňuje BERT zvážit celý kontext slova ve větě, což má za následek výrazně lepší přesnost v úlohách zpracování jazyka.

Ústředním rysem BERT je použití tzv. Masked Language Model (MLM). Při trénování BERT jsou náhodně vybraná slova ve větě nahrazena maskou a model je trénován, aby tato maskovaná slova odhadl na základě kontextu. Tato technika umožňuje BERTu naučit se hlubší a přesnější vztahy mezi slovy ve větě.

BERT navíc používá metodu nazvanou Next Sentence Prediction (NSP), kde se model učí předpovídat, zda jedna věta následuje za druhou nebo ne. To zlepšuje schopnost BERT porozumět delším textům a rozpoznávat složitější vztahy mezi větami.

🌐 5. Aplikace BERT v praxi

BERT se ukázal jako extrémně užitečný pro různé úkoly NLP. Zde jsou některé z hlavních oblastí použití:

📊 a) Klasifikace textu

Jedním z nejběžnějších použití BERT je klasifikace textu, kde jsou texty rozděleny do předem definovaných kategorií. Mezi příklady patří analýza sentimentu (např. rozpoznání, zda je text pozitivní nebo negativní) nebo kategorizace zpětné vazby od zákazníků. BERT může poskytnout přesnější výsledky než předchozí modely díky svému hlubokému porozumění kontextu slov.

❓ b) Systémy otázka-odpověď

BERT se také používá v systémech otázka-odpověď, kde model extrahuje odpovědi na položené otázky z textu. Tato schopnost je zvláště důležitá v aplikacích, jako jsou vyhledávače, chatboti nebo virtuální asistenti. Díky své obousměrné architektuře může BERT extrahovat relevantní informace z textu, i když je otázka formulována nepřímo.

🌍 c) Překlad textu

I když samotný BERT není přímo navržen jako překladový model, lze jej použít v kombinaci s dalšími technologiemi ke zlepšení strojového překladu. Díky lepšímu pochopení sémantických vztahů ve větě může BERT pomoci generovat přesnější překlady, zejména pro nejednoznačné nebo složité formulace.

🏷️ d) Rozpoznání pojmenované entity (NER)

Další oblastí použití je Named Entity Recognition (NER), která zahrnuje identifikaci konkrétních entit, jako jsou jména, místa nebo organizace v textu. BERT se v tomto úkolu ukázal jako obzvláště účinný, protože plně zohledňuje kontext věty, takže lépe rozpoznává entity, i když mají v různých kontextech různé významy.

✂️ e) Textové shrnutí

Schopnost BERT porozumět celému kontextu textu z něj také dělá výkonný nástroj pro automatickou sumarizaci textu. Lze jej použít k vytažení nejdůležitějších informací z dlouhého textu a vytvoření stručného shrnutí.

🌟 6. Význam BERT pro výzkum a průmysl

Zavedení BERT zahájilo novou éru ve výzkumu NLP. Byl to jeden z prvních modelů, který plně využil sílu obousměrné architektury transformátoru a nastavil laťku pro mnoho následujících modelů. Mnoho společností a výzkumných ústavů integrovalo BERT do svých NLP potrubí, aby zlepšily výkon svých aplikací.

Kromě toho BERT vydláždil cestu dalším inovacím v oblasti jazykových modelů. Následně byly například vyvinuty modely jako GPT (Generative Pretrained Transformer) a T5 (Text-to-Text Transfer Transformer), které jsou založeny na podobných principech, ale nabízejí specifická vylepšení pro různé případy použití.

🚧 7. Výzvy a omezení BERT

Navzdory mnoha výhodám má BERT také některé výzvy a omezení. Jednou z největších překážek je vysoké výpočetní úsilí potřebné k trénování a aplikaci modelu. Protože BERT je velmi velký model s miliony parametrů, vyžaduje výkonný hardware a značné výpočetní zdroje, zejména při zpracování velkého množství dat.

Dalším problémem je potenciální zkreslení, které může existovat v trénovacích datech. Protože je BERT trénován na velkém množství textových dat, někdy odráží zkreslení a stereotypy přítomné v těchto datech. Vědci však neustále pracují na identifikaci a řešení těchto problémů.

🔍 Základní nástroj pro moderní aplikace pro zpracování jazyka

BERT výrazně zlepšil způsob, jakým stroje rozumějí lidské řeči. Díky své obousměrné architektuře a inovativním tréninkovým metodám dokáže hluboce a přesně zachytit kontext slov ve větě, což má za následek vyšší přesnost v mnoha úkolech NLP. Ať už jde o klasifikaci textu, systémy otázek a odpovědí nebo rozpoznávání entit – BERT se etabloval jako nepostradatelný nástroj pro moderní aplikace pro zpracování jazyka.

Výzkum v oblasti zpracování přirozeného jazyka bude nepochybně pokračovat vpřed a BERT položil základy mnoha budoucích inovací. Navzdory stávajícím výzvám a omezením BERT působivě ukazuje, jak daleko tato technologie v krátké době pokročila a jaké vzrušující příležitosti se v budoucnu ještě otevřou.

🌀 Transformátor: Revoluce ve zpracování přirozeného jazyka

🌟 V posledních letech bylo jedním z nejvýznamnějších pokroků v oblasti zpracování přirozeného jazyka (NLP) představení modelu Transformer, jak je popsáno v dokumentu z roku 2017 „Attention Is All You Need“. Tento model zásadně změnil pole tím, že vyřadil dříve používané rekurentní nebo konvoluční struktury pro úlohy sekvenční transdukce, jako je strojový překlad. Místo toho se spoléhá výhradně na mechanismy pozornosti. Od té doby se design Transformeru stal základem mnoha modelů, které reprezentují stav techniky v různých oblastech, jako je generování jazyků, překlady a další.

🔄 Transformer: Změna paradigmatu

Před představením Transformeru byla většina modelů pro úlohy sekvenování založena na rekurentních neuronových sítích (RNN) nebo sítích s dlouhou krátkodobou pamětí (LSTM), které jsou ze své podstaty sekvenční. Tyto modely zpracovávají vstupní data krok za krokem a vytvářejí skryté stavy, které se šíří podél sekvence. Přestože je tato metoda efektivní, je výpočetně nákladná a obtížně se paralelizuje, zejména u dlouhých sekvencí. Kromě toho mají RNN potíže s učením se dlouhodobým závislostem kvůli takzvanému problému „mizejícího gradientu“.

Ústřední inovace Transformeru spočívá v použití mechanismů sebepozornosti, které umožňují modelu vážit důležitost různých slov ve větě vůči sobě navzájem, bez ohledu na jejich pozici. To umožňuje modelu zachytit vztahy mezi široce rozmístěnými slovy efektivněji než RNN nebo LSTM, a to spíše paralelně než sekvenčně. To nejen zlepšuje efektivitu školení, ale také výkon při úkolech, jako je strojový překlad.

🧩 Architektura modelu

Transformátor se skládá ze dvou hlavních součástí: kodéru a dekodéru, které se skládají z více vrstev a do značné míry se spoléhají na mechanismy pozornosti s více hlavami.

⚙️ Kodér

Kodér se skládá ze šesti stejných vrstev, z nichž každá má dvě podvrstvy:

1. Vícehlavá sebepozornost

Tento mechanismus umožňuje modelu zaměřit se při zpracování každého slova na různé části vstupní věty. Namísto počítání pozornosti v jediném prostoru, vícehlavá pozornost promítá vstup do několika různých prostorů, což umožňuje zachytit různé typy vztahů mezi slovy.

2. Polohově plně propojené dopředné sítě

Po vrstvě pozornosti je na každé pozici nezávisle aplikována plně připojená dopředná síť. To pomáhá modelu zpracovat každé slovo v kontextu a využít informace z mechanismu pozornosti.

Pro zachování struktury vstupní sekvence obsahuje model také poziční vstupy (poziční kódování). Protože Transformer nezpracovává slova sekvenčně, jsou tato kódování klíčová pro poskytování informací modelu o pořadí slov ve větě. Vstupy pozic jsou přidány k vloženým slovům, takže model může rozlišovat mezi různými pozicemi v sekvenci.

🔍 Dekodéry

Stejně jako kodér se i dekodér skládá ze šesti vrstev, přičemž každá vrstva má další mechanismus pozornosti, který umožňuje modelu zaměřit se na relevantní části vstupní sekvence při generování výstupu. Dekodér také používá maskovací techniku, aby se zabránilo zvažování budoucích pozic, přičemž zachovává autoregresivní povahu generování sekvence.

🧠 Vícehlavá pozornost a tečková pozornost produktu

Srdcem Transformeru je mechanismus Multi-Head Attention, který je rozšířením pozornosti jednoduššího bodového produktu. Na funkci pozornosti lze nahlížet jako na mapování mezi dotazem a sadou párů klíč-hodnota (klíče a hodnoty), kde každý klíč představuje slovo v sekvenci a hodnota představuje související kontextové informace.

Mechanismus pozornosti s více hlavami umožňuje modelu soustředit se na různé části sekvence současně. Promítnutím vstupu do více podprostorů může model zachytit bohatší sadu vztahů mezi slovy. To je užitečné zejména v úlohách, jako je strojový překlad, kde pochopení kontextu slova vyžaduje mnoho různých faktorů, jako je syntaktická struktura a sémantický význam.

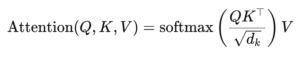

Vzorec pro pozornost bodového produktu je:

Zde (Q) je matice dotazů, (K) je klíčová matice a (V) je matice hodnot. Termín (sqrt{d_k}) je měřítkový faktor, který zabraňuje tomu, aby se bodové produkty příliš zvětšily, což by vedlo k velmi malým gradientům a pomalejšímu učení. Funkce softmax se používá k zajištění toho, aby se váhy pozornosti součet jednaly.

🚀 Výhody transformátoru

Transformer nabízí několik klíčových výhod oproti tradičním modelům, jako jsou RNN a LSTM:

1. Paralelizace

Protože Transformer zpracovává všechny tokeny v sekvenci současně, může být vysoce paralelizován, a proto je mnohem rychlejší trénovat než RNN nebo LSTM, zejména na velkých souborech dat.

2. Dlouhodobé závislosti

Mechanismus sebepozorování umožňuje modelu zachytit vztahy mezi vzdálenými slovy efektivněji než RNN, které jsou omezeny sekvenční povahou jejich výpočtů.

3. Škálovatelnost

Transformer lze snadno škálovat na velmi velké datové sady a delší sekvence, aniž by trpěl omezením výkonu spojeným s RNN.

🌍 Aplikace a efekty

Od svého představení se Transformer stal základem pro širokou škálu modelů NLP. Jedním z nejpozoruhodnějších příkladů je BERT (Bidirectional Encoder Representations from Transformers), který využívá upravenou architekturu Transformer k dosažení nejmodernějšího stavu v mnoha úlohách NLP, včetně odpovídání na otázky a klasifikace textu.

Dalším významným vývojem je GPT (Generative Pretrained Transformer), který pro generování textu používá verzi Transformeru omezenou na dekodér. Modely GPT, včetně GPT-3, se nyní používají pro různé aplikace, od vytváření obsahu až po dokončování kódu.

🔍 Výkonný a flexibilní model

Transformer zásadně změnil způsob, jakým přistupujeme k úkolům NLP. Poskytuje výkonný a flexibilní model, který lze použít na různé problémy. Jeho schopnost zvládnout dlouhodobé závislosti a efektivita školení z něj udělaly preferovaný architektonický přístup pro mnoho nejmodernějších modelů. Jak výzkum pokročí, pravděpodobně uvidíme další vylepšení a úpravy Transformeru, zejména v oblastech, jako je zpracování obrazu a jazyka, kde mechanismy pozornosti vykazují slibné výsledky.

Jsme tu pro Vás - poradenství - plánování - realizace - projektové řízení

☑️ Odborník v oboru, zde se svým vlastním průmyslovým centrem Xpert.Digital s více než 2 500 odbornými články

Rád posloužím jako váš osobní poradce.

Můžete mě kontaktovat vyplněním kontaktního formuláře níže nebo mi jednoduše zavolejte na číslo +49 89 89 674 804 (Mnichov) .

Těším se na náš společný projekt.

Xpert.Digital - Konrad Wolfenstein

Xpert.Digital je centrum pro průmysl se zaměřením na digitalizaci, strojírenství, logistiku/intralogistiku a fotovoltaiku.

S naším 360° řešením pro rozvoj podnikání podporujeme známé společnosti od nových obchodů až po poprodejní služby.

Market intelligence, smarketing, automatizace marketingu, vývoj obsahu, PR, e-mailové kampaně, personalizovaná sociální média a péče o potenciální zákazníky jsou součástí našich digitálních nástrojů.

Více se dozvíte na: www.xpert.digital - www.xpert.solar - www.xpert.plus