الذكاء الاصطناعي وتحسين محركات البحث مع BERT – تمثيلات التشفير ثنائية الاتجاه من المحولات – نموذج في مجال معالجة اللغة الطبيعية (NLP)

اختيار اللغة 📢

تم نشره على: 4 أكتوبر 2024 / تحديث من: 4 أكتوبر 2024 - المؤلف: Konrad Wolfenstein

الذكاء الاصطناعي وتحسين محركات البحث مع BERT – تمثيلات التشفير ثنائي الاتجاه من المحولات – نموذج في مجال معالجة اللغات الطبيعية (NLP) – الصورة: Xpert.Digital

🚀💬 تم تطويره بواسطة Google: BERT وأهميته في البرمجة اللغوية العصبية - لماذا يعد فهم النص ثنائي الاتجاه أمرًا بالغ الأهمية

🔍🗣️ BERT، اختصار لـ Bidirectional Encoder Representations from Transformers، هو نموذج رئيسي في مجال معالجة اللغات الطبيعية (NLP) تم تطويره بواسطة Google. لقد أحدثت ثورة في الطريقة التي تفهم بها الآلات اللغة. على عكس النماذج السابقة التي قامت بتحليل النص بشكل تسلسلي من اليسار إلى اليمين أو العكس، يتيح BERT المعالجة ثنائية الاتجاه. وهذا يعني أنه يلتقط سياق الكلمة من تسلسل النص السابق واللاحق. تعمل هذه القدرة على تحسين فهم السياقات اللغوية المعقدة بشكل كبير.

🔍 عمارة بيرت

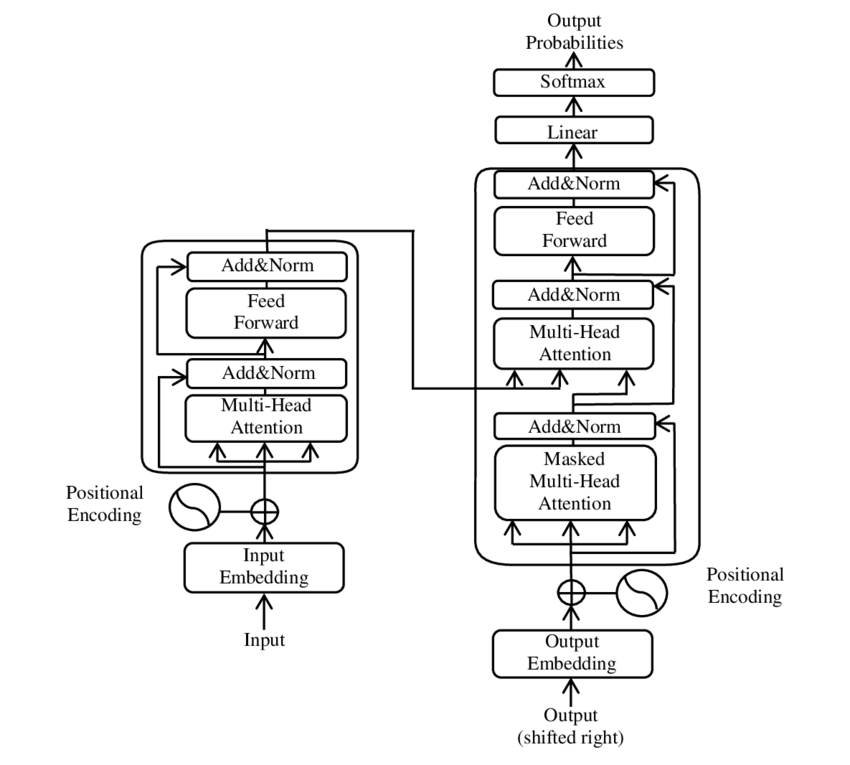

في السنوات الأخيرة، حدث أحد أهم التطورات في مجال معالجة اللغات الطبيعية (NLP) مع تقديم نموذج المحول، كما هو معروض في ملف PDF 2017 - الانتباه هو كل ما تحتاجه - ورقة ( ويكيبيديا ). أدى هذا النموذج إلى تغيير جذري في هذا المجال من خلال التخلص من الهياكل المستخدمة سابقًا، مثل الترجمة الآلية. وبدلاً من ذلك، فهو يعتمد حصريًا على آليات الانتباه. منذ ذلك الحين، شكل تصميم المحول الأساس للعديد من النماذج التي تمثل أحدث ما توصلت إليه التكنولوجيا في مجالات مختلفة مثل توليد اللغة والترجمة وما بعدها.

يعتمد BERT على بنية المحولات هذه. تستخدم هذه البنية ما يسمى بآليات الاهتمام الذاتي لتحليل العلاقات بين الكلمات في الجملة. يتم الاهتمام بكل كلمة في سياق الجملة بأكملها، مما يؤدي إلى فهم أكثر دقة للعلاقات النحوية والدلالية.

مؤلفو الورقة "الانتباه كل ما تحتاجه" هم:

- أشيش فاسواني (جوجل برين)

- نعوم شازير (Google Brain)

- نيكي بارمار (أبحاث جوجل)

- جاكوب أوزكوريت (أبحاث جوجل)

- ليون جونز (أبحاث جوجل)

- إيدان إن. جوميز (جامعة تورونتو، تم إنجاز العمل جزئيًا في Google Brain)

- لوكاش كايزر (جوجل برين)

- إيليا بولوسوخين (مستقل، عمل سابق في Google Research)

ساهم هؤلاء المؤلفون بشكل كبير في تطوير نموذج المحول المقدم في هذه الورقة.

🔄 معالجة ثنائية الاتجاه

الميزة البارزة لـ BERT هي قدرتها على المعالجة ثنائية الاتجاه. في حين أن النماذج التقليدية مثل الشبكات العصبية المتكررة (RNNs) أو شبكات الذاكرة طويلة المدى (LSTM) تعالج النص في اتجاه واحد فقط، يقوم BERT بتحليل سياق الكلمة في كلا الاتجاهين. يتيح ذلك للنموذج التقاط الفروق الدقيقة في المعنى بشكل أفضل وبالتالي إجراء تنبؤات أكثر دقة.

🕵️♂️ نمذجة اللغة المقنعة

جانب مبتكر آخر لـ BERT هو تقنية نموذج اللغة المقنعة (MLM). يتضمن إخفاء الكلمات المختارة عشوائيًا في الجملة وتدريب النموذج على التنبؤ بهذه الكلمات بناءً على السياق المحيط. تجبر هذه الطريقة بيرت على تطوير فهم عميق لسياق ومعنى كل كلمة في الجملة.

🚀 تدريب وتخصيص BERT

يمر BERT بعملية تدريب على مرحلتين: التدريب المسبق والضبط الدقيق.

📚 التدريب المسبق

في التدريب المسبق، يتم تدريب BERT على كميات كبيرة من النصوص لتعلم أنماط اللغة العامة. يتضمن ذلك نصوص ويكيبيديا وغيرها من المجموعات النصية الشاملة. في هذه المرحلة، يتعلم النموذج الهياكل والسياقات اللغوية الأساسية.

🔧ضبط دقيق

بعد التدريب المسبق، يتم تخصيص BERT لمهام البرمجة اللغوية العصبية المحددة، مثل تصنيف النص أو تحليل المشاعر. يتم تدريب النموذج باستخدام مجموعات بيانات أصغر متعلقة بالمهمة لتحسين أدائه لتطبيقات محددة.

🌍 مجالات تطبيق BERT

لقد أثبت BERT أنه مفيد للغاية في العديد من مجالات معالجة اللغة الطبيعية:

تحسين محرك البحث

تستخدم Google BERT لفهم استعلامات البحث بشكل أفضل وإظهار نتائج أكثر صلة. وهذا يحسن تجربة المستخدم بشكل كبير.

تصنيف النص

يستطيع BERT تصنيف المستندات حسب الموضوع أو تحليل الحالة المزاجية في النصوص.

التعرف على الكيان المسمى (NER)

يقوم النموذج بتحديد وتصنيف الكيانات المسماة في النصوص، مثل الأسماء الشخصية أو أسماء الأماكن أو أسماء المنظمات.

أنظمة الأسئلة والأجوبة

يستخدم BERT لتقديم إجابات دقيقة على الأسئلة المطروحة.

🧠 أهمية BERT لمستقبل الذكاء الاصطناعي

لقد وضع BERT معايير جديدة لنماذج البرمجة اللغوية العصبية ومهّد الطريق لمزيد من الابتكارات. ومن خلال قدرته على المعالجة ثنائية الاتجاه والفهم العميق لسياق اللغة، فقد أدى إلى زيادة كبيرة في كفاءة ودقة تطبيقات الذكاء الاصطناعي.

🔜 التطورات المستقبلية

من المرجح أن يهدف التطوير الإضافي لـ BERT والنماذج المماثلة إلى إنشاء أنظمة أكثر قوة. يمكن أن تتعامل هذه مع مهام لغوية أكثر تعقيدًا ويمكن استخدامها في مجموعة متنوعة من مجالات التطبيق الجديدة. إن دمج مثل هذه النماذج في التقنيات اليومية يمكن أن يغير بشكل جذري الطريقة التي نتفاعل بها مع أجهزة الكمبيوتر.

🌟 علامة فارقة في تطور الذكاء الاصطناعي

يعد BERT علامة فارقة في تطور الذكاء الاصطناعي وقد أحدث ثورة في الطريقة التي تعالج بها الآلات اللغة الطبيعية. تتيح بنيته ثنائية الاتجاه فهمًا أعمق للعلاقات اللغوية، مما يجعله لا غنى عنه لمجموعة متنوعة من التطبيقات. ومع تقدم الأبحاث، ستستمر نماذج مثل BERT في لعب دور مركزي في تحسين أنظمة الذكاء الاصطناعي وفتح إمكانيات جديدة لاستخدامها.

📣 مواضيع مشابهة

- 📚 تقديم بيرت: نموذج البرمجة اللغوية العصبية الاختراقي

- 🔍 بيرت ودور ثنائية الاتجاه في البرمجة اللغوية العصبية

- 🧠 نموذج المحول: حجر الزاوية في بيرت

- 🚀 نمذجة اللغة المقنعة: مفتاح بيرت للنجاح

- 📈 تخصيص BERT: من التدريب المسبق إلى الضبط الدقيق

- 🌐مجالات تطبيق BERT في التكنولوجيا الحديثة

- 🤖 تأثير بيرت على مستقبل الذكاء الاصطناعي

- 💡 الآفاق المستقبلية: تطورات أخرى لـ BERT

- 🏆 بيرت كعلامة فارقة في تطوير الذكاء الاصطناعي

- 📰 مؤلفو ورقة المحولات "الانتباه هو كل ما تحتاجه": العقول التي تقف وراء بيرت

#️⃣ الوسوم: #البرمجة اللغوية العصبية #الذكاء الاصطناعي #نمذجة اللغة #المحول #التعلم_الآلي

🎯🎯🎯 استفد من خبرة Xpert.Digital الواسعة والخماسية في حزمة خدمات شاملة | البحث والتطوير، XR، العلاقات العامة والتسويق عبر محرك البحث

آلة العرض ثلاثية الأبعاد AI وXR: خبرة خمسة أضعاف من Xpert.Digital في حزمة خدمات شاملة، R&D XR، PR وSEM - الصورة: Xpert.Digital

تتمتع Xpert.Digital بمعرفة متعمقة بمختلف الصناعات. يتيح لنا ذلك تطوير استراتيجيات مصممة خصيصًا لتناسب متطلبات وتحديات قطاع السوق المحدد لديك. ومن خلال التحليل المستمر لاتجاهات السوق ومتابعة تطورات الصناعة، يمكننا التصرف ببصيرة وتقديم حلول مبتكرة. ومن خلال الجمع بين الخبرة والمعرفة، فإننا نولد قيمة مضافة ونمنح عملائنا ميزة تنافسية حاسمة.

المزيد عنها هنا:

بيرت: تقنية البرمجة اللغوية العصبية (NLP) الثورية

🚀 BERT، اختصار لـ Bidirectional Encoder Representations from Transformers، هو نموذج لغوي متقدم طورته Google والذي أصبح طفرة كبيرة في مجال معالجة اللغات الطبيعية (NLP) منذ إطلاقه في عام 2018. وهو يعتمد على بنية المحولات، التي أحدثت ثورة في الطريقة التي تفهم بها الأجهزة النص وتعالجه. ولكن ما الذي يجعل BERT مميزًا جدًا وما هو استخدامه بالضبط؟ للإجابة على هذا السؤال، نحتاج إلى التعمق في المبادئ التقنية والوظائف ومجالات تطبيق BERT.

📚 1. أساسيات معالجة اللغة الطبيعية

لفهم معنى BERT بشكل كامل، من المفيد مراجعة أساسيات معالجة اللغة الطبيعية (NLP) بإيجاز. تتعامل البرمجة اللغوية العصبية مع التفاعل بين أجهزة الكمبيوتر واللغة البشرية. الهدف هو تعليم الآلات كيفية تحليل البيانات النصية وفهمها والاستجابة لها. قبل إدخال نماذج مثل BERT، غالبًا ما كانت المعالجة الآلية للغة تمثل تحديات كبيرة، لا سيما بسبب الغموض والاعتماد على السياق والبنية المعقدة للغة البشرية.

📈 2. تطوير نماذج البرمجة اللغوية العصبية

قبل ظهور BERT على الساحة، كانت معظم نماذج البرمجة اللغوية العصبية تعتمد على ما يسمى بالمعماريات أحادية الاتجاه. وهذا يعني أن هذه النماذج تقرأ النص فقط من اليسار إلى اليمين أو من اليمين إلى اليسار، مما يعني أنها لا تستطيع أن تأخذ في الاعتبار سوى قدر محدود من السياق عند معالجة كلمة في جملة. غالبًا ما أدى هذا القيد إلى عدم التقاط النماذج بشكل كامل للسياق الدلالي الكامل للجملة. وهذا جعل من الصعب تفسير الكلمات الغامضة أو الحساسة للسياق بدقة.

تطور مهم آخر في أبحاث البرمجة اللغوية العصبية قبل BERT كان نموذج word2vec، والذي سمح لأجهزة الكمبيوتر بترجمة الكلمات إلى متجهات تعكس أوجه التشابه الدلالية. ولكن هنا أيضًا كان السياق مقتصرًا على المحيط المباشر للكلمة. في وقت لاحق، تم تطوير الشبكات العصبية المتكررة (RNNs) وخاصة نماذج الذاكرة طويلة المدى (LSTM)، مما جعل من الممكن فهم تسلسل النص بشكل أفضل عن طريق تخزين المعلومات عبر كلمات متعددة. إلا أن هذه النماذج أيضا كانت لها حدودها، خاصة عند التعامل مع النصوص الطويلة وفهم السياق في كلا الاتجاهين في نفس الوقت.

🔄 3. الثورة من خلال هندسة المحولات

جاء هذا الإنجاز مع طرح بنية المحولات في عام 2017، والتي تشكل الأساس لـ BERT. تم تصميم نماذج المحولات لتمكين المعالجة المتوازية للنص، مع مراعاة سياق الكلمة من النص السابق واللاحق. ويتم ذلك من خلال ما يسمى بآليات الاهتمام الذاتي، والتي تحدد قيمة وزنية لكل كلمة في جملة بناءً على مدى أهميتها بالنسبة للكلمات الأخرى في الجملة.

وعلى النقيض من الأساليب السابقة، فإن نماذج المحولات ليست أحادية الاتجاه، ولكنها ثنائية الاتجاه. وهذا يعني أنه يمكنهم سحب المعلومات من السياق الأيمن والأيسر للكلمة، مما ينتج تمثيلًا أكثر اكتمالًا ودقة للكلمة ومعناها.

🧠 4. بيرت: نموذج ثنائي الاتجاه

يأخذ BERT أداء بنية المحولات إلى مستوى جديد. تم تصميم النموذج لالتقاط سياق الكلمة ليس فقط من اليسار إلى اليمين أو من اليمين إلى اليسار، ولكن في كلا الاتجاهين في وقت واحد. يتيح ذلك لـ BERT مراعاة السياق الكامل للكلمة داخل الجملة، مما يؤدي إلى تحسين الدقة بشكل ملحوظ في مهام معالجة اللغة.

السمة الرئيسية لـ BERT هي استخدام ما يسمى بنموذج اللغة المقنعة (MLM). في تدريب BERT، يتم استبدال الكلمات المختارة عشوائيًا في الجملة بقناع، ويتم تدريب النموذج على تخمين هذه الكلمات المقنعة بناءً على السياق. تسمح هذه التقنية لـ BERT بمعرفة علاقات أعمق وأكثر دقة بين الكلمات في الجملة.

بالإضافة إلى ذلك، يستخدم BERT طريقة تسمى التنبؤ بالجمل التالية (NSP)، حيث يتعلم النموذج التنبؤ بما إذا كانت جملة واحدة تتبع أخرى أم لا. يؤدي ذلك إلى تحسين قدرة بيرت على فهم النصوص الأطول والتعرف على العلاقات الأكثر تعقيدًا بين الجمل.

🌐 5. تطبيق BERT عملياً

لقد أثبت BERT أنه مفيد للغاية لمجموعة متنوعة من مهام البرمجة اللغوية العصبية. فيما يلي بعض مجالات التطبيق الرئيسية:

📊 أ) تصنيف النص

أحد الاستخدامات الأكثر شيوعًا لـ BERT هو تصنيف النص، حيث يتم تقسيم النصوص إلى فئات محددة مسبقًا. تتضمن الأمثلة على ذلك تحليل المشاعر (على سبيل المثال التعرف على ما إذا كان النص إيجابيًا أم سلبيًا) أو تصنيف تعليقات العملاء. يستطيع BERT تقديم نتائج أكثر دقة من النماذج السابقة من خلال فهمه العميق لسياق الكلمات.

❓ ب) أنظمة الأسئلة والأجوبة

يُستخدم BERT أيضًا في أنظمة الأسئلة والأجوبة، حيث يستخرج النموذج إجابات الأسئلة المطروحة من النص. تعتبر هذه القدرة مهمة بشكل خاص في تطبيقات مثل محركات البحث أو برامج الدردشة الآلية أو المساعدين الافتراضيين. بفضل بنيته ثنائية الاتجاه، يستطيع BERT استخلاص المعلومات ذات الصلة من النص، حتى لو تمت صياغة السؤال بشكل غير مباشر.

🌍 ج) ترجمة نصية

في حين أن BERT نفسه لم يتم تصميمه بشكل مباشر كنموذج ترجمة، إلا أنه يمكن استخدامه مع تقنيات أخرى لتحسين الترجمة الآلية. من خلال فهم العلاقات الدلالية في الجملة بشكل أفضل، يمكن أن يساعد BERT في إنشاء ترجمات أكثر دقة، خاصة للكلمات الغامضة أو المعقدة.

🏷️ د) التعرف على الكيانات المسماة (NER)

مجال آخر للتطبيق هو التعرف على الكيانات المسماة (NER)، والذي يتضمن تحديد كيانات محددة مثل الأسماء أو الأماكن أو المنظمات في النص. أثبت BERT فعاليته بشكل خاص في هذه المهمة لأنه يأخذ في الاعتبار سياق الجملة بشكل كامل، مما يجعله أفضل في التعرف على الكيانات حتى لو كان لها معاني مختلفة في سياقات مختلفة.

✂️ ه) ملخص النص

إن قدرة BERT على فهم السياق الكامل للنص تجعله أيضًا أداة قوية لتلخيص النص تلقائيًا. ويمكن استخدامه لاستخراج أهم المعلومات من نص طويل وإنشاء ملخص موجز.

🌟 6. أهمية BERT للبحث والصناعة

كان تقديم BERT بمثابة بداية حقبة جديدة في أبحاث البرمجة اللغوية العصبية. لقد كان أحد النماذج الأولى التي استفادت بشكل كامل من قوة بنية المحولات ثنائية الاتجاه، مما وضع المعيار للعديد من النماذج اللاحقة. قامت العديد من الشركات والمعاهد البحثية بدمج BERT في مسارات البرمجة اللغوية العصبية الخاصة بها لتحسين أداء تطبيقاتها.

بالإضافة إلى ذلك، مهد BERT الطريق لمزيد من الابتكارات في مجال النماذج اللغوية. على سبيل المثال، تم تطوير نماذج مثل GPT (المحول المولد مسبقًا المدرب) وT5 (محول نقل النص إلى النص) لاحقًا، والتي تعتمد على مبادئ مماثلة ولكنها تقدم تحسينات محددة لحالات استخدام مختلفة.

🚧 7. تحديات وقيود BERT

على الرغم من مزاياه العديدة، فإن BERT لديه أيضًا بعض التحديات والقيود. إحدى أكبر العقبات هي الجهد الحسابي العالي المطلوب لتدريب النموذج وتطبيقه. نظرًا لأن BERT نموذج كبير جدًا يحتوي على ملايين المعلمات، فإنه يتطلب أجهزة قوية وموارد حاسوبية كبيرة، خاصة عند معالجة كميات كبيرة من البيانات.

هناك مشكلة أخرى وهي التحيز المحتمل الذي قد يكون موجودًا في بيانات التدريب. نظرًا لأن BERT يتم تدريبه على كميات كبيرة من البيانات النصية، فإنه يعكس أحيانًا التحيزات والقوالب النمطية الموجودة في تلك البيانات. ومع ذلك، يعمل الباحثون باستمرار على تحديد هذه المشكلات ومعالجتها.

🔍 أداة أساسية لتطبيقات معالجة اللغات الحديثة

لقد قام BERT بتحسين الطريقة التي تفهم بها الآلات اللغة البشرية بشكل كبير. بفضل بنيته ثنائية الاتجاه وأساليب التدريب المبتكرة، فهو قادر على التقاط سياق الكلمات في الجملة بعمق ودقة، مما يؤدي إلى دقة أعلى في العديد من مهام البرمجة اللغوية العصبية. سواء كان ذلك في تصنيف النصوص أو أنظمة الأسئلة والأجوبة أو التعرف على الكيانات، فقد أثبت BERT نفسه كأداة لا غنى عنها لتطبيقات معالجة اللغة الحديثة.

لا شك أن الأبحاث في مجال معالجة اللغة الطبيعية سوف تستمر في التقدم، وقد وضع BERT الأساس للعديد من الابتكارات المستقبلية. على الرغم من التحديات والقيود الحالية، يُظهر BERT بشكل مثير للإعجاب إلى أي مدى وصلت التكنولوجيا في وقت قصير وما هي الفرص المثيرة التي ستظل متاحة في المستقبل.

🌀المحول: ثورة في معالجة اللغات الطبيعية

🌟 في السنوات الأخيرة، كان أحد أهم التطورات في مجال معالجة اللغات الطبيعية (NLP) هو تقديم نموذج المحول، كما هو موضح في ورقة بحثية عام 2017 بعنوان "الانتباه هو كل ما تحتاجه". قام هذا النموذج بتغيير المجال بشكل أساسي من خلال التخلص من الهياكل المتكررة أو التلافيفية المستخدمة مسبقًا لمهام نقل التسلسل مثل الترجمة الآلية. وبدلاً من ذلك، فهو يعتمد حصريًا على آليات الانتباه. منذ ذلك الحين، شكل تصميم المحول الأساس للعديد من النماذج التي تمثل أحدث ما توصلت إليه التكنولوجيا في مجالات مختلفة مثل توليد اللغة والترجمة وما بعدها.

🔄المحول: نقلة نوعية

قبل تقديم المحول، كانت معظم نماذج مهام التسلسل تعتمد على الشبكات العصبية المتكررة (RNNs) أو شبكات الذاكرة الطويلة قصيرة المدى (LSTMs)، والتي تكون متسلسلة بطبيعتها. تقوم هذه النماذج بمعالجة البيانات المدخلة خطوة بخطوة، مما يؤدي إلى إنشاء حالات مخفية يتم نشرها على طول التسلسل. على الرغم من أن هذه الطريقة فعالة، إلا أنها مكلفة من الناحية الحسابية ويصعب موازنتها، خاصة بالنسبة للتسلسلات الطويلة. بالإضافة إلى ذلك، تواجه شبكات RNN صعوبة في تعلم التبعيات طويلة المدى بسبب ما يسمى بمشكلة "التدرج المتلاشي".

يكمن الابتكار المركزي لـ Transformer في استخدام آليات الاهتمام الذاتي، التي تسمح للنموذج بتقييم أهمية الكلمات المختلفة في الجملة بالنسبة لبعضها البعض، بغض النظر عن موقعها. يسمح هذا للنموذج بالتقاط العلاقات بين الكلمات المتباعدة على نطاق واسع بشكل أكثر فعالية من RNNs أو LSTMs، والقيام بذلك بطريقة متوازية بدلاً من التسلسل. وهذا لا يؤدي إلى تحسين كفاءة التدريب فحسب، بل يؤدي أيضًا إلى تحسين الأداء في مهام مثل الترجمة الآلية.

🧩الهندسة المعمارية النموذجية

يتكون المحول من مكونين رئيسيين: جهاز التشفير وجهاز فك التشفير، وكلاهما يتكون من طبقات متعددة ويعتمدان بشكل كبير على آليات الانتباه متعددة الرؤوس.

⚙️ التشفير

يتكون المشفر من ست طبقات متطابقة، تحتوي كل منها على طبقتين فرعيتين:

1. الاهتمام الذاتي متعدد الرؤوس

تسمح هذه الآلية للنموذج بالتركيز على أجزاء مختلفة من جملة الإدخال أثناء معالجة كل كلمة. بدلاً من حساب الانتباه في مساحة واحدة، يقوم الانتباه متعدد الرؤوس بإسقاط المدخلات في عدة مساحات مختلفة، مما يسمح بالتقاط أنواع مختلفة من العلاقات بين الكلمات.

2. شبكات التغذية الأمامية المتصلة بالكامل من حيث الموقع

بعد طبقة الانتباه، يتم تطبيق شبكة تغذية للأمام متصلة بالكامل بشكل مستقل في كل موضع. وهذا يساعد النموذج على معالجة كل كلمة في سياقها والاستفادة من المعلومات من آلية الانتباه.

للحفاظ على بنية تسلسل الإدخال، يحتوي النموذج أيضًا على مدخلات موضعية (الترميزات الموضعية). وبما أن المحول لا يعالج الكلمات بشكل تسلسلي، فإن هذه الترميزات تعتبر حاسمة في إعطاء النموذج معلومات حول ترتيب الكلمات في الجملة. تتم إضافة مدخلات الموضع إلى تضمينات الكلمات حتى يتمكن النموذج من التمييز بين المواضع المختلفة في التسلسل.

🔍 أجهزة فك التشفير

مثل جهاز التشفير، يتكون جهاز فك التشفير أيضًا من ست طبقات، حيث تحتوي كل طبقة على آلية اهتمام إضافية تسمح للنموذج بالتركيز على الأجزاء ذات الصلة من تسلسل الإدخال أثناء توليد الإخراج. يستخدم مفكك التشفير أيضًا تقنية الإخفاء لمنعه من التفكير في المواقع المستقبلية، مع الحفاظ على طبيعة الانحدار الذاتي لتوليد التسلسل.

🧠 انتباه متعدد الرؤوس واهتمام بالمنتج النقطي

قلب المحول هو آلية الانتباه متعدد الرؤوس، وهي امتداد لانتباه المنتج النقطي الأبسط. يمكن النظر إلى وظيفة الانتباه على أنها تعيين بين استعلام ومجموعة من أزواج القيمة الرئيسية (المفاتيح والقيم)، حيث يمثل كل مفتاح كلمة في التسلسل وتمثل القيمة المعلومات السياقية المرتبطة بها.

تسمح آلية الانتباه متعدد الرؤوس للنموذج بالتركيز على أجزاء مختلفة من التسلسل في نفس الوقت. ومن خلال إسقاط المدخلات في مساحات فرعية متعددة، يمكن للنموذج التقاط مجموعة أكثر ثراءً من العلاقات بين الكلمات. وهذا مفيد بشكل خاص في مهام مثل الترجمة الآلية، حيث يتطلب فهم سياق الكلمة العديد من العوامل المختلفة، مثل البنية النحوية والمعنى الدلالي.

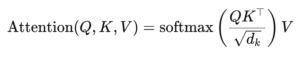

صيغة الاهتمام بالمنتج النقطي هي:

هنا (Q) هي مصفوفة الاستعلام، (K) هي المصفوفة الرئيسية و (V) هي مصفوفة القيمة. المصطلح (sqrt{d_k}) هو عامل تحجيم يمنع المنتجات النقطية من أن تصبح كبيرة جدًا، مما قد يؤدي إلى تدرجات صغيرة جدًا وتعلم أبطأ. يتم تطبيق وظيفة softmax للتأكد من أن مجموع أوزان الانتباه يساوي واحدًا.

🚀 مميزات المحول

يقدم المحول العديد من المزايا الرئيسية مقارنة بالنماذج التقليدية مثل RNNs وLSTMs:

1. التوازي

نظرًا لأن المحول يعالج جميع الرموز المميزة في تسلسل في نفس الوقت، فيمكن أن يكون متوازيًا بدرجة كبيرة وبالتالي يكون تدريبه أسرع بكثير من شبكات RNN أو LSTMs، خاصة في مجموعات البيانات الكبيرة.

2. التبعيات طويلة المدى

تسمح آلية الانتباه الذاتي للنموذج بالتقاط العلاقات بين الكلمات البعيدة بشكل أكثر فعالية من شبكات RNN، والتي تكون محدودة بالطبيعة التسلسلية لحساباتها.

3. قابلية التوسع

يمكن للمحول التوسع بسهولة إلى مجموعات بيانات كبيرة جدًا وتسلسلات أطول دون المعاناة من اختناقات الأداء المرتبطة بشبكات RNN.

🌍 التطبيقات والمؤثرات

منذ طرحه، أصبح المحول الأساس لمجموعة واسعة من نماذج البرمجة اللغوية العصبية. أحد أبرز الأمثلة هو BERT (تمثيلات التشفير ثنائية الاتجاه من المحولات)، والتي تستخدم بنية محولات معدلة لتحقيق أحدث ما توصلت إليه التكنولوجيا في العديد من مهام البرمجة اللغوية العصبية، بما في ذلك الإجابة على الأسئلة وتصنيف النص.

التطور المهم الآخر هو GPT (المحول التوليدي المُدرب مسبقًا)، والذي يستخدم نسخة محدودة من وحدة فك التشفير من المحول لإنشاء النص. تُستخدم الآن نماذج GPT، بما في ذلك GPT-3، لمجموعة متنوعة من التطبيقات، بدءًا من إنشاء المحتوى وحتى إكمال التعليمات البرمجية.

🔍 نموذج قوي ومرن

لقد غيّر برنامج Transformer بشكل جذري الطريقة التي نتعامل بها مع مهام البرمجة اللغوية العصبية. إنه يوفر نموذجًا قويًا ومرنًا يمكن تطبيقه على مجموعة متنوعة من المشكلات. إن قدرته على التعامل مع التبعيات طويلة المدى وكفاءة التدريب جعلته النهج المعماري المفضل للعديد من النماذج الحديثة. مع تقدم الأبحاث، من المحتمل أن نرى المزيد من التحسينات والتعديلات على المحول، خاصة في مجالات مثل معالجة الصور واللغة، حيث تظهر آليات الانتباه نتائج واعدة.

نحن هنا من أجلك - المشورة - التخطيط - التنفيذ - إدارة المشاريع

☑️ خبير في الصناعة، هنا مع Xpert الخاص به. مركز الصناعة الرقمية الذي يضم أكثر من 2500 مقالة متخصصة

سأكون سعيدًا بالعمل كمستشار شخصي لك.

يمكنك الاتصال بي عن طريق ملء نموذج الاتصال أدناه أو ببساطة اتصل بي على +49 89 89 674 804 (ميونخ) .

إنني أتطلع إلى مشروعنا المشترك.

Xpert.Digital - كونراد ولفنشتاين

تعد Xpert.Digital مركزًا للصناعة مع التركيز على الرقمنة والهندسة الميكانيكية والخدمات اللوجستية/اللوجستية الداخلية والخلايا الكهروضوئية.

من خلال حل تطوير الأعمال الشامل الذي نقدمه، فإننا ندعم الشركات المعروفة بدءًا من الأعمال الجديدة وحتى خدمات ما بعد البيع.

تعد معلومات السوق والتسويق وأتمتة التسويق وتطوير المحتوى والعلاقات العامة والحملات البريدية ووسائل التواصل الاجتماعي المخصصة ورعاية العملاء المحتملين جزءًا من أدواتنا الرقمية.

يمكنك معرفة المزيد على: www.xpert.digital - www.xpert.solar - www.xpert.plus