تم النشر على: 13 يونيو 2025 / تحديث من: 13 يونيو 2025 - المؤلف: Konrad Wolfenstein

للروبوتات وغيرها من عوامل الذكاء الاصطناعى: نموذج الذكاء الاصطناعى V-Jepa 2 من Meta-AI الذي يفهم صورتنا البدنية: xpert.digital

Meta يعرض V-Jepa 2: نظام الذكاء الاصطناعى يتعلم التنبؤات حول العالم المادي

Meta تنشر V-Jepa 2: نموذج عالم منظمة العفو الدولية الثوري لمستقبل الذكاء الاصطناعي

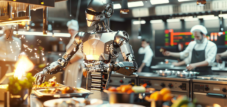

مع V-Jepa 2 ، قدمت Meta نظام AI الرائد الذي يتبع نهجًا أساسيًا من النماذج الصوتية الكبيرة التقليدية. تم تطوير نموذج العالم القوي البالغ 1.2 مليار معلمة لمساعدة الروبوتات وعوامل الذكاء الاصطناعى الآخرين لفهم العالم المادي والتنبؤ بكيفية رد فعله على تصرفاته.

ما هو V-Jepa 2 وكيف يختلف عن النماذج الصوتية؟

تعني V-Jepa 2 "لتصنيع مفصل الفيديو التنبئي 2" ويستند إلى بنية مختلفة تمامًا عن النماذج الصوتية التقليدية. في حين أن النماذج الصوتية مثل ChatGPT أو GPT-4 تجعل التنبؤات الاحتمالية حول تسلسل النص ، فإن V-JEPA 2 يعمل في غرفة تمثيل مجردة وتركز على فهم القوانين المادية.

الفرق الحاسم في طريقة التعلم: تتطلب نماذج اللغة كميات كبيرة من البيانات المسمى والتعلم من خلال التدريب المراقب. من ناحية أخرى ، يستخدم V-Jepa 2 التعلم المراقب الذاتي واستخراج المعرفة من مقاطع الفيديو غير المتجهة ، مما يقلل بشكل كبير من تكاليف إعداد البيانات. لا يتعلم النموذج من خلال إعادة بناء البيكسل ، ولكن من خلال التمثيل التجريدي لمحتوى الفيديو.

بنية JEPA: التعلم بالتنبؤ

تم تطوير العمارة التنبؤية للتضمين المشتركة (JEPA) بواسطة Yann Lecun ، عالم منظمة العفو الدولية Metas ، ويمثل بديلاً لنماذج الذكاء الاصطناعي. على عكس الأساليب التوليدية التي تحاول إعادة بناء كل بكسل مفقود ، يعمل V-Jepa 2 مع أشجار الفيديو المقنعة ويتعلم التنبؤ بالمفاهيم المجردة.

يستخدم النظام نهج تدريب اثنين من المراحل:

المرحلة الأولى: التعلم الذاتي

- التدريب مع أكثر من مليون ساعة من مواد الفيديو ومليون صورة

- تعلم أنماط التفاعل الجسدي بدون شرح بشري

- تطوير نموذج داخلي للعالم المادي

المرحلة الثانية: التكيف المرتبط بالإجراء

- ضبط دقيق مع 62 ساعة فقط من بيانات التحكم في الروبوت من مجموعة بيانات droid

- تكامل تصرفات الوكيل في المهارات التنبؤية

- تمكين التخطيط والتحكم في دائرة التحكم المغلق

أداء فائق في الممارسة العملية

يوضح V-Jepa 2 أداءً مثيرًا للإعجاب في مجالات مختلفة:

فهم الفيديو واكتشاف الحركة

- 77.3 ٪ أعلى 1 دقة في شيء ما مجموعة بيانات V2

- 39.7 ٪ استدعاء-AT-5 لتوقعات العمل Epic-Kitchens-100 (تحسن 44 ٪ مقارنة بالنماذج السابقة)

- أحدث الأداء في مختلف مهام الرد على أسئلة الفيديو

التحكم بالروبوت

- معدل نجاح 65-80 ٪ للمهام الاختيار في بيئات غير معروفة

- التحكم في الروبوت صفر طلقة بدون تدريب محدد

- استخدم في مختبرين مختلفين مع Arms Franka Robot

الكفاءة مقارنة بالمنافسة

V-Jepa 2 أسرع 30 مرة من نموذج Cosmos في Nvidia ويحتاج فقط إلى 16 ثانية للتخطيط لعمل روبوت ، بينما يحتاج Cosmos إلى 4 دقائق.

الابتكارات الفنية والخصائص الرئيسية

يتميز النموذج بخمسة اختراقات فنية مركزية:

- التعلم ذاتيًا: يلغي الحاجة إلى كميات كبيرة من البيانات المسمى

- آلية التقنيع: تدرب النموذج من خلال التنبؤ بمناطق الفيديو الخفية

- التعلم التمثيلي التجريدي: التركيز على المعاني الدلالية بدلاً من تفاصيل البكسل

- الهندسة المعمارية النموذجية العالمية: إنشاء فهم داخلي للقوانين الفيزيائية

- تعلم النقل الفعال: مهارات التعلم المتميزة صفراً

معايير جديدة حدود واضحة لمنظمة العفو الدولية الحالية

أصدرت Meta ثلاثة معايير جديدة بالتوازي مع V-Jepa 2 التي تختبر الفهم المادي لأنظمة الذكاء الاصطناعي:

intphys 2

يختبر القدرة على التمييز بين السيناريوهات الجسدية والمستحيلة. حتى النماذج المتقدمة لا تزال قريبة من المستوى العشوائي هنا.

MVPBNCH

يستخدم بصريًا سيارات فيديو مماثلة مع إجابات متعارضة على نفس السؤال. يصل V-Jepa 2 إلى 44.5 ٪ دقة مقترنة-أفضل أداء لجميع الأنظمة التي تم اختبارها.

causalvqa

يفحص الفهم السببي والتفكير المضاد. تظهر النتائج أن أنظمة الذكاء الاصطناعى الحالية يمكن أن تصف ما يرونه ولكن تواجه صعوبة في التنبؤ بدورات بديلة.

الذكاء الاصطناعى بدون جوع للبيانات: كيف يجعل التعلم الآلي V-jepa 2 أكثر كفاءة

يرى Yann Lecun مفتاح الجيل القادم من تطوير الذكاء الاصطناعي في نماذج العالم مثل V-Jepa 2. يمكن أن يحدث النموذج ثورة في مجالات التطبيق المختلفة:

الروبوتات ومساعدي الميزانية

من المفترض أن تنشر نماذج العالم عصرًا جديدًا من الروبوتات التي يمكن لوكيل الذكاء الاصطناعي فيها إدارة المهام الحقيقية دون مبالغ فلكية من بيانات التدريب.

المركبات المستقلة

يمكن أن يكون الفهم المكاني للوقت الفعلي من V-Jepa 2 أمرًا بالغ الأهمية للمركبات المستقلة وروبوتات المستودعات وأنظمة توصيل الطائرات بدون طيار.

الواقع الممتد (AR) والمساعدين الظاهري

تخطط Meta لتوسيع وظائف V-JEPA 2 من خلال دمج تحليل الصوت وفهم الفيديو الموسع لنظارات AR والمساعدين الظاهريين.

توافر المصادر المفتوحة وترويج البحوث

أصدرت Meta V-Jepa 2 بموجب ترخيص CC-By-NC كمصدر مفتوح للترويج لأبحاث الذكاء الاصطناعي العالمي. رمز النموذج متاح على Github ويمكن تنفيذه على منصات مثل Google Colab و Kaggle. يتناقض هذا الانفتاح مع العديد من نماذج الذكاء الاصطناعى الكبيرة الأخرى ، ويهدف إلى تعزيز تطور نماذج العالم في الروبوتات وتجسد الذكاء الاصطناعي.

تحول نموذج في تنمية الذكاء الاصطناعي

يمثل V-Jepa 2 تحولًا أساسيًا من النموذج من معالجة اللغة النقية إلى فهم أعمق للعالم المادي. بينما تعتمد معظم شركات الذكاء الاصطناعي على النماذج التوليدية ، تتبع Meta رؤية بديلة لمستقبل الذكاء الاصطناعي من خلال نهجها النموذجي العالمي. إن القدرة على التعلم من الحد الأدنى من البيانات وتمكين التحكم في الروبوت الصفراء يمكن أن تمهد الطريق لجيل جديد من الأنظمة الذكية التي لا تفهم فحسب ، بل يمكنها أيضًا التصرف في العالم الحقيقي.

مناسب ل:

شريكك العالمي في التسويق وتطوير الأعمال

☑️ لغة العمل لدينا هي الإنجليزية أو الألمانية

☑️ جديد: المراسلات بلغتك الوطنية!

سأكون سعيدًا بخدمتك وفريقي كمستشار شخصي.

يمكنك الاتصال بي عن طريق ملء نموذج الاتصال أو ببساطة اتصل بي على +49 89 89 674 804 (ميونخ) . عنوان بريدي الإلكتروني هو: ولفنشتاين ∂ xpert.digital

إنني أتطلع إلى مشروعنا المشترك.