القيادة في التحول الرقمي باستخدام الذكاء الاصطناعي: تقرير ورشة عمل للمتخصصين والمديرين

الإصدار المسبق لـ Xpert

اختيار اللغة 📢

نُشر في: ١٠ مايو ٢٠٢٥ / حُدِّث في: ١٠ مايو ٢٠٢٥ – بقلم: Konrad Wolfenstein

القيادة في التحول الرقمي باستخدام الذكاء الاصطناعي: تقرير ورشة عمل للمتخصصين والمديرين – الصورة: Xpert.Digital

ما يجب على القادة معرفته عن الذكاء الاصطناعي الآن: اغتنام الفرص، وإدارة المخاطر، والقيادة بثقة (مدة القراءة: 32 دقيقة / بدون إعلانات / بدون جدار دفع)

إتقان ثورة الذكاء الاصطناعي: مقدمة للقادة

القوة التحويلية للذكاء الاصطناعي: إعادة تصميم العمل وخلق القيمة

يُعتبر الذكاء الاصطناعي تقنيةً فريدةً من نوعها، تفتح آفاقًا جديدةً لإعادة التفكير جذريًا في العمل وخلق القيمة. بالنسبة للشركات، يُعدّ دمج الذكاء الاصطناعي خطوةً حاسمةً نحو النجاح والتنافسية على المدى الطويل، إذ يُعزز الابتكار، ويرفع الكفاءة، ويُحسّن الجودة. للذكاء الاصطناعي أثرٌ اقتصاديٌ واجتماعيٌ بالغ الأهمية؛ فهو من أهم المواضيع الرقمية المستقبلية، ويتطور بوتيرةٍ متسارعة، ويحمل في طياته إمكاناتٍ هائلة. تُدرك الشركات بشكلٍ متزايد مزايا الأتمتة وزيادة الكفاءة بفضل الذكاء الاصطناعي. لا يقتصر الأمر على مجرد تحوّلٍ تكنولوجي، بل هو تحوّلٌ جذريٌ في نماذج الأعمال، وتحسين العمليات، وتفاعلات العملاء، مما يجعل التكيّف ضرورةً للبقاء في بيئةٍ تنافسيةٍ شرسة.

إن "القوة التحويلية" للذكاء الاصطناعي، التي يُشار إليها كثيرًا، تتجاوز مجرد إدخال أدوات جديدة؛ فهي تنطوي على تحول جذري في التفكير الاستراتيجي. ويواجه القادة تحديًا لإعادة تقييم العمليات الأساسية، وعروض القيمة، وحتى هياكل الصناعة. أما أولئك الذين ينظرون إلى الذكاء الاصطناعي كمجرد أداة لرفع الكفاءة، فيخاطرون بتجاهل إمكاناته الاستراتيجية الأعمق. ويتزامن التطور السريع للذكاء الاصطناعي مع نقص قائم في المهارات، مما يخلق تحديًا مزدوجًا: فمن جهة، ثمة حاجة ملحة لرفع مستوى المهارات بسرعة لاستخدام الذكاء الاصطناعي. ومن جهة أخرى، يتيح الذكاء الاصطناعي فرصة لأتمتة المهام، وبالتالي التخفيف من نقص المهارات في بعض المجالات، مع استحداث متطلبات تأهيل جديدة في الوقت نفسه. وهذا يستلزم تخطيطًا دقيقًا للقوى العاملة من جانب القادة.

مناسب ل:

- الذكاء الاصطناعي كمعزز للأعمال في الشركة - نصائح عملية إضافية لإدخال الذكاء الاصطناعي في الشركات من أحد عشر مديرًا مؤقتًا

تقييم الفرص والمخاطر في عصر الذكاء الاصطناعي

رغم ما توفره أنظمة الذكاء الاصطناعي من فرص فعّالة للغاية، إلا أنها مرتبطة ارتباطًا وثيقًا بمخاطر يجب إدارتها. يدور النقاش حول الذكاء الاصطناعي حول الموازنة بين إمكاناته الهائلة ومخاطره الكامنة، مما يستلزم اتباع نهج متوازن للاستفادة من المزايا وتقليل العيوب. تواجه الشركات تحدي دفع عجلة الابتكار مع الالتزام بخصوصية البيانات والمبادئ الأخلاقية، مما يجعل التوازن بين التقدم والامتثال أمرًا بالغ الأهمية.

إنّ تحقيق هذا التوازن ليس قرارًا يُتخذ لمرة واحدة، بل ضرورة استراتيجية مستمرة. فمع تطور تقنيات الذكاء الاصطناعي - على سبيل المثال، من الذكاء الاصطناعي المتخصص إلى القدرات العامة - ستتغير طبيعة الفرص والمخاطر أيضًا. وهذا يتطلب إعادة تقييم مستمرة وتكييفًا للحوكمة والاستراتيجية. وقد يتباين تصور مخاطر وفوائد الذكاء الاصطناعي بشكل كبير داخل المؤسسة الواحدة. فعلى سبيل المثال، يميل مستخدمو الذكاء الاصطناعي النشطون إلى أن يكونوا أكثر تفاؤلًا من أولئك الذين لم يتبنوه بعد. وهذا يُبرز تحديًا حاسمًا لإدارة التغيير أمام القادة: إذ يجب سد فجوة التصور هذه من خلال التوعية والتواصل الواضح وإظهار الفوائد الملموسة مع معالجة المخاوف في الوقت نفسه.

فهم مشهد الذكاء الاصطناعي: المفاهيم والتقنيات الأساسية

الذكاء الاصطناعي التوليدي (GenAI) والمسار نحو الذكاء الاصطناعي العام (AGI)

الذكاء الاصطناعي التوليدي (GenAI)

يشير الذكاء الاصطناعي التوليدي (GenAI) إلى نماذج الذكاء الاصطناعي المصممة لإنشاء محتوى جديد على شكل نصوص مكتوبة أو ملفات صوتية أو صور أو مقاطع فيديو، مما يوفر نطاقًا واسعًا من التطبيقات. يساعد الذكاء الاصطناعي التوليدي المستخدمين على إنشاء محتوى فريد وهادف، ويمكنه العمل كنظام ذكي للإجابة على الأسئلة أو كمساعد شخصي. يُحدث الذكاء الاصطناعي التوليدي ثورة في مجال إنشاء المحتوى والتسويق والتفاعل مع العملاء، وذلك من خلال تمكين الإنتاج السريع للمواد المُخصصة وأتمتة الردود.

بفضل سهولة الوصول الفوري إلى الذكاء الاصطناعي العام ونطاق تطبيقاته الواسع، يُعدّ هذا النوع من الذكاء الاصطناعي بمثابة "المستوى المبتدئ" للعديد من المؤسسات. يُشكّل هذا التعرّف الأولي التصورات، وقد يُسهم في دفع عجلة تبني الذكاء الاصطناعي على نطاق أوسع أو إعاقتها. لذا، يجب على القادة إدارة هذه التجارب المبكرة بعناية لخلق زخم إيجابي.

الذكاء العام الاصطناعي (AGI)

يشير مصطلح الذكاء الاصطناعي العام (AGI) إلى الذكاء الافتراضي لآلة قادرة على فهم أو تعلم أي مهمة فكرية يمكن للإنسان القيام بها، وبالتالي محاكاة القدرات المعرفية البشرية. ويركز هذا المصطلح على أنظمة الذكاء الاصطناعي التي يمكنها أداء مجموعة واسعة من المهام بدلاً من التخصص في مهام محددة.

لا يوجد حاليًا ذكاء اصطناعي عام حقيقي؛ فهو لا يزال مجرد مفهوم وهدف بحثي. تُعرّف شركة OpenAI، الرائدة في هذا المجال، الذكاء الاصطناعي العام بأنه "أنظمة ذاتية التشغيل بدرجة عالية تتفوق على البشر في معظم الأعمال ذات القيمة الاقتصادية". وبحلول عام 2023، لم يُعتبر قد تم تحقيق سوى المرحلة الأولى من المراحل الخمس المتصاعدة للذكاء الاصطناعي العام، والمعروفة باسم "الذكاء الاصطناعي الناشئ".

يشير غموض تعريفات الذكاء الاصطناعي العام (AGI) وتعددها إلى ضرورة أن ينظر إليه القادة كأفق طويل الأمد ذي إمكانات تحويلية، بدلاً من اعتباره مسألة تشغيلية آنية. ينبغي التركيز على الاستفادة من الذكاء الاصطناعي القوي الحالي مع المراقبة الاستراتيجية لتقدم الذكاء الاصطناعي العام. قد يؤدي الإفراط في الاستثمار في سيناريوهات الذكاء الاصطناعي العام التخمينية إلى تحويل الموارد عن فرص الذكاء الاصطناعي الأكثر إلحاحاً. يشير التطور من الذكاء الاصطناعي المتخصص إلى الذكاء الاصطناعي العام وصولاً إلى البحث المستمر في الذكاء الاصطناعي العام إلى زيادة درجة الاستقلالية والقدرة في أنظمة الذكاء الاصطناعي. يرتبط هذا التوجه ارتباطاً مباشراً بالحاجة المتزايدة إلى أطر أخلاقية وحوكمة متينة، حيث يحمل الذكاء الاصطناعي الأكثر قوة احتمالاً أكبر لسوء الاستخدام أو العواقب غير المقصودة.

مناسب ل:

المساعدون الآليون مقابل وكلاء الذكاء الاصطناعي: تحديد الأدوار والقدرات

تُقدّم المساعدات الذكية التي تعمل بالذكاء الاصطناعي الدعم للأفراد في مهامهم الفردية، وتستجيب لطلباتهم، وتجيب على استفساراتهم، وتقدّم لهم الاقتراحات. وهي عادةً ما تكون تفاعلية وتنتظر الأوامر البشرية. كانت المساعدات الأولى تعتمد على قواعد محددة، بينما تعتمد المساعدات الحديثة على التعلّم الآلي أو النماذج الأساسية. في المقابل، تتميّز وكلاء الذكاء الاصطناعي بمزيد من الاستقلالية والقدرة على تحقيق الأهداف واتخاذ القرارات بشكل مستقل مع الحد الأدنى من التدخل البشري. فهي استباقية، وتستطيع التفاعل مع بيئتها، والتكيّف من خلال التعلّم.

تكمن الاختلافات الرئيسية في الاستقلالية، وتعقيد المهام، وتفاعل المستخدم، وقدرات اتخاذ القرار. يقدم المساعدون المعلومات اللازمة لاتخاذ القرارات البشرية، بينما يمكن للوكلاء اتخاذ القرارات وتنفيذها. عمليًا، يُحسّن المساعدون تجربة العملاء، ويدعمون الاستفسارات المصرفية، ويُبسّطون مهام الموارد البشرية. أما الوكلاء، فيمكنهم التكيف مع سلوك المستخدم في الوقت الفعلي، ومنع الاحتيال بشكل استباقي، وأتمتة عمليات الموارد البشرية المعقدة مثل استقطاب المواهب.

يمثل الانتقال من مساعدي الذكاء الاصطناعي إلى وكلاء الذكاء الاصطناعي تطورًا من الذكاء الاصطناعي كأداة إلى الذكاء الاصطناعي كشريك أو حتى موظف مستقل. ولهذا التحول آثار عميقة على تصميم الوظائف، وهياكل الفرق، والمهارات المطلوبة من الموظفين الذين سيحتاجون بشكل متزايد إلى إدارة هذه الوكلاء الأذكياء والتعاون معهم. ومع ازدياد انتشار وكلاء الذكاء الاصطناعي وقدرتهم على اتخاذ قرارات مستقلة، تصبح "فجوة المساءلة" قضية ملحة. فإذا اتخذ وكيل الذكاء الاصطناعي قرارًا خاطئًا، يصبح تحديد المسؤولية أمرًا معقدًا. وهذا يؤكد الحاجة الماسة إلى حوكمة قوية للذكاء الاصطناعي تعالج التحديات الفريدة للأنظمة المستقلة.

فيما يلي مقارنة لأهم السمات المميزة:

مقارنة بين مساعدي الذكاء الاصطناعي ووكلاء الذكاء الاصطناعي

يوفر هذا الجدول للمديرين التنفيذيين فهمًا واضحًا للاختلافات الأساسية لاختيار التكنولوجيا المناسبة للاحتياجات المحددة ولتوقع المستويات المختلفة من الإشراف وتعقيد التكامل.

تكشف المقارنة بين مساعدي الذكاء الاصطناعي ووكلاء الذكاء الاصطناعي عن اختلافات جوهرية في خصائصهم. فبينما يميل مساعدو الذكاء الاصطناعي إلى التفاعل وانتظار الأوامر البشرية، يتصرف وكلاء الذكاء الاصطناعي بشكل استباقي ومستقل، ويتخذون إجراءات مستقلة. وتتمثل الوظيفة الأساسية لمساعد الذكاء الاصطناعي في تنفيذ المهام عند الطلب، بينما يركز وكيل الذكاء الاصطناعي على تحقيق هدف محدد. وفي عملية صنع القرار، يدعم مساعدو الذكاء الاصطناعي البشر، بينما يتخذ وكلاء الذكاء الاصطناعي القرارات وينفذونها بشكل مستقل. كما يختلف سلوك التعلم لديهم: فمساعدو الذكاء الاصطناعي يتعلمون عادةً بطريقة محدودة تعتمد على الإصدارات، بينما يتعلم وكلاء الذكاء الاصطناعي بشكل تكيفي ومستمر. وتشمل التطبيقات الرئيسية لمساعدي الذكاء الاصطناعي برامج الدردشة الآلية واسترجاع المعلومات، بينما يُستخدم وكلاء الذكاء الاصطناعي في أتمتة العمليات، وكشف الاحتيال، وحل المشكلات المعقدة. ويتطلب التفاعل مع البشر مدخلات مستمرة من مساعدي الذكاء الاصطناعي، بينما لا يتطلب وكلاء الذكاء الاصطناعي سوى الحد الأدنى من التدخل البشري.

غرفة المحرك: التعلم الآلي، ونماذج اللغة الكبيرة (LLMs)، والنماذج الأساسية

التعلم الآلي (ML)

يُعدّ التعلّم الآلي فرعًا من فروع الذكاء الاصطناعي، حيث تتعلّم الحواسيب من البيانات وتتحسّن مع الخبرة دون الحاجة إلى برمجة صريحة. تُدرَّب الخوارزميات على اكتشاف الأنماط في مجموعات البيانات الضخمة، واتخاذ القرارات والتنبؤات بناءً على هذه الأنماط. تشمل نماذج التعلّم الآلي التعلّم الخاضع للإشراف (التعلّم من البيانات المصنّفة)، والتعلّم غير الخاضع للإشراف (اكتشاف الأنماط في البيانات غير المصنّفة)، والتعلّم شبه الخاضع للإشراف (مزيج من البيانات المصنّفة وغير المصنّفة)، والتعلّم المعزّز (التعلّم من خلال التجربة والخطأ مع المكافآت). يُسهم التعلّم الآلي في زيادة الكفاءة، وتقليل الأخطاء، ودعم عملية اتخاذ القرارات في الشركات.

يُعدّ فهم أنواع التعلّم الآلي المختلفة أمرًا بالغ الأهمية للمديرين، ليس فقط من الناحية التقنية، بل أيضًا لفهم متطلبات البيانات. فعلى سبيل المثال، يتطلب التعلّم الخاضع للإشراف كميات كبيرة من مجموعات البيانات عالية الجودة والمُصنّفة، مما يؤثر على استراتيجية البيانات والاستثمار فيها. وبينما يُفترض أن يكون تحديد المشكلة التجارية نقطة البداية، فإنّ مدى ملاءمة نوع مُعيّن من التعلّم الآلي يعتمد بشكل كبير على توافر البيانات وطبيعتها.

نماذج اللغة الكبيرة (LLMs)

نماذج اللغة الكبيرة (LLMs) هي نوع من خوارزميات التعلم العميق التي تُدرَّب على مجموعات بيانات ضخمة، وتُستخدم بكثرة في تطبيقات معالجة اللغة الطبيعية (NLP) للاستجابة لاستفسارات اللغة الطبيعية. ومن الأمثلة على ذلك سلسلة GPT من OpenAI. تستطيع نماذج اللغة الكبيرة توليد نصوص شبيهة بنصوص البشر، وتشغيل روبوتات المحادثة، ودعم خدمة العملاء الآلية. مع ذلك، قد ترث هذه النماذج أيضًا أخطاءً وتحيزات من بيانات التدريب، مما يثير مخاوف تتعلق بحقوق النشر والأمان.

تُشكّل مشكلة "الحفظ" في نماذج التعلم الآلي، حيث تُنتج هذه النماذج نصوصًا حرفية من بيانات التدريب، مخاطر كبيرة على حقوق النشر والانتحال للشركات التي تستخدم المحتوى المُولّد بواسطة هذه النماذج. وهذا يستلزم عمليات مراجعة دقيقة وفهمًا لمصدر مخرجات نماذج التعلم الآلي.

النموذج الأساسي

النماذج الأساسية هي نماذج ذكاء اصطناعي ضخمة تُدرَّب على مجموعات بيانات واسعة النطاق، وقابلة للتكيّف (الضبط الدقيق) لمجموعة متنوعة من المهام اللاحقة. وتتميز هذه النماذج بظهور قدرات غير متوقعة وتجانسها (بنية مشتركة). وتختلف عن نماذج الذكاء الاصطناعي التقليدية في كونها مستقلة عن المجال في البداية، وتستخدم التعلّم الذاتي، وتُمكّن من نقل التعلّم، وغالبًا ما تكون متعددة الوسائط (تعالج النصوص والصور والصوت). تُعدّ إدارة دورة حياة التعلّم (LLMs) نوعًا من النماذج الأساسية. تشمل مزاياها سرعة الوصول إلى السوق وقابلية التوسع؛ إلا أن تحدياتها تشمل الشفافية (مشكلة "الصندوق الأسود")، وخصوصية البيانات، والتكاليف المرتفعة أو متطلبات البنية التحتية.

يشير صعود النماذج الأساسية إلى تحول نحو ذكاء اصطناعي أكثر تنوعًا وقابلية للتكيف. مع ذلك، فإن طبيعتها "المبهمة" والموارد الكبيرة اللازمة لتدريبها أو ضبطها بدقة تعني أن الوصول والتحكم فيها قد يتركزان، مما قد يخلق تبعية لعدد قليل من الموردين الكبار. وهذا له آثار استراتيجية على قرارات التصنيع أو الشراء، وخطر الوقوع في فخ احتكار الموردين. تتيح القدرة متعددة الوسائط للعديد من النماذج الأساسية فئات جديدة كليًا من التطبيقات التي يمكنها استخلاص رؤى من أنواع بيانات مختلفة (مثل تحليل التقارير النصية جنبًا إلى جنب مع لقطات كاميرات المراقبة). يتجاوز هذا ما يمكن أن تفعله نماذج التعلم الآلي النصية، ويتطلب من المديرين التنفيذيين التفكير بشكل أوسع في أصول البيانات المتاحة لديهم.

البوصلة التنظيمية: الإبحار في الأطر القانونية والأخلاقية

قانون الاتحاد الأوروبي بشأن الذكاء الاصطناعي: الأحكام الرئيسية وآثارها على الشركات

قانون الذكاء الاصطناعي للاتحاد الأوروبي، الذي دخل حيز التنفيذ في 1 أغسطس 2024، هو أول قانون شامل للذكاء الاصطناعي في العالم، ويؤسس نظام تصنيف قائم على المخاطر للذكاء الاصطناعي.

فئات المخاطر:

- مخاطر غير مقبولة: يُحظر استخدام أنظمة الذكاء الاصطناعي التي تُشكّل تهديدًا واضحًا للأمن وسبل العيش والحقوق. ومن الأمثلة على ذلك التقييم الاجتماعي من قِبل السلطات العامة، والتلاعب المعرفي بالسلوك، والمسح العشوائي لصور الوجوه. وستدخل هذه المحظورات حيز التنفيذ في معظمها بحلول 2 فبراير 2025.

- المخاطر العالية: أنظمة الذكاء الاصطناعي التي تؤثر سلبًا على السلامة أو الحقوق الأساسية. تخضع هذه الأنظمة لمتطلبات صارمة، تشمل أنظمة إدارة المخاطر، وحوكمة البيانات، والوثائق التقنية، والإشراف البشري، وتقييمات المطابقة قبل طرحها في السوق. ومن الأمثلة على ذلك الذكاء الاصطناعي في البنية التحتية الحيوية، والأجهزة الطبية، والتوظيف، وإنفاذ القانون. ستُطبق معظم قواعد الذكاء الاصطناعي عالي المخاطر اعتبارًا من 2 أغسطس 2026.

- مخاطر محدودة: يجب على أنظمة الذكاء الاصطناعي مثل برامج الدردشة الآلية أو تلك التي تولد التزييف العميق أن تمتثل لالتزامات الشفافية وأن تُعلم المستخدمين بأنهم يتفاعلون مع الذكاء الاصطناعي أو أن المحتوى تم إنشاؤه بواسطة الذكاء الاصطناعي.

- مخاطر ضئيلة: أنظمة الذكاء الاصطناعي مثل مرشحات البريد العشوائي أو ألعاب الفيديو المدعومة بالذكاء الاصطناعي. يسمح القانون باستخدامها بحرية، مع تشجيع وضع مدونات سلوك طوعية.

مناسب ل:

يحدد القانون التزامات موردي ومستوردي وموزعي ومستخدمي (مشغلي) أنظمة الذكاء الاصطناعي، مع خضوع موردي الأنظمة عالية المخاطر لأشد المتطلبات صرامة. ونظرًا لتطبيقه خارج حدود الاتحاد الأوروبي، فإنه يؤثر أيضًا على الشركات خارج الاتحاد الأوروبي إذا استُخدمت أنظمة الذكاء الاصطناعي الخاصة بها في سوق الاتحاد الأوروبي. وتُطبق قواعد محددة على نماذج الذكاء الاصطناعي للأغراض العامة، مع التزامات إضافية لتلك المصنفة على أنها تشكل "خطرًا نظاميًا". وتُطبق هذه القواعد عمومًا اعتبارًا من 2 أغسطس 2025. ويتم تنفيذ القانون على مراحل: الحظر (فبراير 2025)، وقواعد الذكاء الاصطناعي للأغراض العامة (أغسطس 2025)، وقواعد معظم الأنظمة عالية المخاطر (أغسطس 2026)، وقواعد محددة خاصة بالمنتجات عالية المخاطر (أغسطس 2027). ويمكن أن يؤدي عدم الامتثال إلى غرامات باهظة، تصل إلى 35 مليون يورو أو 7% من إجمالي الإيرادات السنوية العالمية للتطبيقات المحظورة. كما تنص المادة 4، اعتبارًا من فبراير 2025، على مستوى مناسب من الكفاءة في مجال الذكاء الاصطناعي لموظفي مزودي ومشغلي أنظمة الذكاء الاصطناعي المحددة.

يتطلب النهج القائم على المخاطر في قانون الذكاء الاصطناعي للاتحاد الأوروبي تحولاً جذرياً في كيفية تعامل الشركات مع تطوير ونشر الذكاء الاصطناعي. لم يعد الأمر يقتصر على الجدوى التقنية أو القيمة التجارية فحسب، بل يجب دمج الامتثال التنظيمي وتخفيف المخاطر منذ بداية دورة حياة الذكاء الاصطناعي ("الامتثال بالتصميم"). يُعد "التزام الكفاءة في مجال الذكاء الاصطناعي" بنداً هاماً وذا أثر مبكر. وهذا يعني ضرورة فورية للشركات لتقييم وتنفيذ برامج تدريبية، ليس فقط للفرق التقنية، بل لكل من يقوم بتطوير أو نشر أو مراقبة أنظمة الذكاء الاصطناعي. ويتجاوز هذا مجرد الوعي الأساسي ليشمل فهم الوظائف والقيود والأطر الأخلاقية والقانونية. ويشير تركيز القانون على نماذج الذكاء الاصطناعي للأغراض العامة، ولا سيما تلك التي تنطوي على مخاطر نظامية، إلى قلق الجهات التنظيمية بشأن الآثار الواسعة النطاق وغير المتوقعة المحتملة لهذه النماذج القوية والمتعددة الاستخدامات. وستخضع الشركات التي تستخدم أو تطور مثل هذه النماذج لتدقيق والتزامات مُشددة، مما سيؤثر على خططها التطويرية واستراتيجياتها التسويقية.

نظرة عامة على فئات المخاطر في قانون الذكاء الاصطناعي للاتحاد الأوروبي والالتزامات الرئيسية

نظرة عامة على فئات المخاطر في قانون الاتحاد الأوروبي بشأن الذكاء الاصطناعي والالتزامات الرئيسية – الصورة: Xpert.Digital

يلخص هذا الجدول الهيكل الأساسي لقانون الذكاء الاصطناعي في الاتحاد الأوروبي ويساعد المديرين التنفيذيين على تحديد الفئة التي قد تندرج ضمنها أنظمة الذكاء الاصطناعي الخاصة بهم بسرعة وفهم عبء الامتثال والجداول الزمنية المقابلة.

يُظهر استعراض فئات المخاطر في قانون الذكاء الاصطناعي للاتحاد الأوروبي أن الأنظمة ذات المخاطر غير المقبولة، مثل أنظمة التقييم الاجتماعي، والتلاعب السلوكي المعرفي، واستخراج صور الوجه بشكل عشوائي، محظورة تمامًا، ولا يجوز استخدامها اعتبارًا من فبراير 2025. ويخضع الذكاء الاصطناعي عالي المخاطر، المستخدم على سبيل المثال في البنية التحتية الحيوية، والأجهزة الطبية، والتوظيف، وإنفاذ القانون، والتعليم، وإدارة الهجرة، لالتزامات واسعة النطاق. ويتعين على مقدمي الخدمات والمشغلين، من بين أمور أخرى، إثبات وجود نظام لإدارة المخاطر، وإدارة جودة البيانات، والوثائق التقنية، بالإضافة إلى ضمان الشفافية، وضمان الإشراف البشري، واستيفاء معايير مثل المتانة، والدقة، والأمن السيبراني، وتقييم المطابقة. وستدخل التدابير ذات الصلة حيز التنفيذ اعتبارًا من أغسطس 2026، وفي بعض الحالات اعتبارًا من أغسطس 2027. أما المخاطر المحدودة فتُطبق على تطبيقات الذكاء الاصطناعي مثل برامج الدردشة الآلية، وأنظمة التعرف على المشاعر، وأنظمة التصنيف البيومترية، وتقنية التزييف العميق. تُطبّق هنا التزامات الشفافية، مثل تصنيف النظام على أنه نظام ذكاء اصطناعي أو محتوى مُولّد بواسطة الذكاء الاصطناعي، والتي ستدخل حيز التنفيذ اعتبارًا من أغسطس 2026. أما بالنسبة لتطبيقات الذكاء الاصطناعي ذات المخاطر المنخفضة، مثل مرشحات البريد العشوائي أو ألعاب الفيديو المدعومة بالذكاء الاصطناعي، فلا توجد التزامات محددة، مع التوصية بوضع مدونات سلوك طوعية. ويمكن نشر هذه الأنظمة فورًا.

التوتر بين الابتكار والمساءلة: إيجاد التوازن الصحيح

يتعين على الشركات الموازنة بين تعزيز ابتكارات الذكاء الاصطناعي وضمان المساءلة وحماية البيانات (وفقًا للائحة العامة لحماية البيانات) والاستخدام الأخلاقي. تُعدّ مبادئ اللائحة العامة لحماية البيانات (الشرعية، والإنصاف، والشفافية، وتحديد الغرض، وتقليل البيانات، والدقة، والمساءلة) أساسيةً للذكاء الاصطناعي المسؤول، وتؤثر على كيفية تطوير أنظمة الذكاء الاصطناعي ونشرها. تشمل استراتيجيات تحقيق التوازن بين هذه المبادئ إشراك فرق الامتثال وحماية البيانات في وقت مبكر، وإجراء عمليات تدقيق دورية، والاستفادة من الخبرات الخارجية، وتوظيف أدوات امتثال متخصصة. ويرى البعض أن التوجيهات التنظيمية ليست عائقًا أمام الابتكار، بل عوامل محفزة تبني الثقة وتزيد من تبني التقنيات الجديدة.

إنّ "التوتر بين الابتكار والمساءلة" ليس حلاً وسطاً ثابتاً، بل هو توازن ديناميكي. فالشركات التي تُدمج المساءلة والاعتبارات الأخلاقية بشكل استباقي في دورة ابتكار الذكاء الاصطناعي لديها، هي الأرجح لبناء حلول ذكاء اصطناعي مستدامة وجديرة بالثقة. وهذا بدوره يُعزز الابتكار على المدى البعيد من خلال تجنب عمليات التحديث المكلفة، والإضرار بالسمعة، أو العقوبات التنظيمية. ويتفاقم تحدي الحفاظ على المساءلة بسبب تزايد تعقيد نماذج الذكاء الاصطناعي المتقدمة، واحتمالية كونها "صندوقاً أسود" (كما هو الحال في بعض النماذج الأساسية). وهذا يستلزم تركيزاً أكبر على تقنيات الذكاء الاصطناعي القابل للتفسير (XAI) وآليات التدقيق القوية لضمان فهم القرارات التي يقودها الذكاء الاصطناعي، وتبريرها، والطعن فيها عند الضرورة.

🎯📊 دمج منصة AI مستقلة وعلى مستوى المصدر 🤖🌐 لجميع مسائل الشركة

Ki-GameChanger: الحلول الأكثر مرونة في منصة الذكاء الاصطناعي التي تقلل من التكاليف ، وتحسين قراراتها وزيادة الكفاءة

منصة الذكاء الاصطناعى المستقلة: يدمج جميع مصادر بيانات الشركة ذات الصلة

- يتفاعل منصة الذكاء الاصطناعى مع جميع مصادر البيانات المحددة

- من SAP و Microsoft و JIRA و Confluence و Salesforce و Zoom و Dropbox والعديد من أنظمة إدارة البيانات الأخرى

- تكامل FAST AI: حلول الذكاء الاصطناعى المصممة خصيصًا للشركات في ساعات أو أيام بدلاً من أشهر

- البنية التحتية المرنة: قائمة على السحابة أو الاستضافة في مركز البيانات الخاص بك (ألمانيا ، أوروبا ، اختيار مجاني للموقع)

- أعلى أمن البيانات: الاستخدام في شركات المحاماة هو الدليل الآمن

- استخدم عبر مجموعة واسعة من مصادر بيانات الشركة

- اختيار نماذج الذكاء الاصطناعي الخاصة بك أو مختلف (DE ، الاتحاد الأوروبي ، الولايات المتحدة الأمريكية ، CN)

التحديات التي تحلها منصة الذكاء الاصطناعى

- عدم دقة حلول الذكاء الاصطناعي التقليدية

- حماية البيانات والإدارة الآمنة للبيانات الحساسة

- ارتفاع التكاليف وتعقيد تطوير الذكاء الاصطناعي الفردي

- عدم وجود منظمة العفو الدولية المؤهلة

- دمج الذكاء الاصطناعي في أنظمة تكنولوجيا المعلومات الحالية

المزيد عنها هنا:

استراتيجيات الذكاء الاصطناعي للمديرين التنفيذيين: إرشادات عملية وأمثلة

الذكاء الاصطناعي في العمل: التطبيقات، وحالات الاستخدام، والتفاعل الفعال

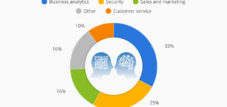

إدراك الفرص: إمكانيات تطبيق الذكاء الاصطناعي وحالات استخدامه في مختلف القطاعات

يوفر الذكاء الاصطناعي إمكانيات تطبيق متنوعة، بما في ذلك إنشاء المحتوى، والتواصل الشخصي مع العملاء، وتحسين العمليات في الإنتاج والخدمات اللوجستية، والصيانة التنبؤية، والدعم في مجالات التمويل والموارد البشرية وتكنولوجيا المعلومات.

تشمل الأمثلة الصناعية المحددة ما يلي:

- السيارات / التصنيع: الذكاء الاصطناعي والمحاكاة في البحث (ARENA2036)، التفاعل الآلي للروبوت (Festo)، تحسين العمليات والصيانة التنبؤية في الإنتاج (Bosch).

- الخدمات المالية: تعزيز الأمن من خلال تحليل مجموعات البيانات الكبيرة للمعاملات المشبوهة، والفواتير الآلية، وتحليل الاستثمار.

- الرعاية الصحية: تشخيص أسرع، وتوسيع نطاق الوصول إلى الرعاية (على سبيل المثال، تفسير الصور الطبية)، وتحسين البحوث الصيدلانية.

- الاتصالات السلكية واللاسلكية: تحسين أداء الشبكة، والتحسينات السمعية والبصرية، ومنع فقدان العملاء.

- تجارة التجزئة/التجارة الإلكترونية: توصيات شخصية، روبوتات محادثة لخدمة العملاء، عمليات دفع آلية.

- التسويق والمبيعات: إنشاء المحتوى (ChatGPT، Canva)، الحملات المُحسّنة، تجزئة العملاء، توقعات المبيعات.

بينما تركز العديد من حالات الاستخدام على الأتمتة والكفاءة، يبرز اتجاهٌ رئيسيٌّ ناشئٌ يتمثل في دور الذكاء الاصطناعي في تعزيز عملية اتخاذ القرارات البشرية وتمكين أشكال جديدة من الابتكار (مثل تطوير الأدوية وتطوير المنتجات). ينبغي على القادة النظر إلى ما هو أبعد من مجرد خفض التكاليف لتحديد فرص النمو والابتكار المدفوعة بالذكاء الاصطناعي. غالبًا ما تتضمن أنجح تطبيقات الذكاء الاصطناعي دمجه في العمليات والأنظمة الأساسية القائمة (مثل استخدام SAP للذكاء الاصطناعي في برامج المؤسسات، وMicrosoft 365 Copilot)، بدلاً من التعامل معه كتقنية مستقلة ومنعزلة. وهذا يتطلب نظرة شاملة لهيكل المؤسسة.

مناسب ل:

- الذكاء الاصطناعي: خمس استراتيجيات رئيسية للتكامل الناجح لتحويل الذكاء الاصطناعي لإدارة الشركات المستدامة

إتقان الحوار: التوجيه الفعال للذكاء الاصطناعي التوليدي

هندسة التوجيهات هي عملية تكرارية تعتمد على الاختبار لتحسين أداء النموذج، وتتطلب أهدافًا واضحة واختبارًا منهجيًا. وتعتمد التوجيهات الفعالة على كل من محتواها (التعليمات، والأمثلة، والسياق) وبنيتها (الترتيب، والتصنيف، والفواصل).

تشمل المكونات المهمة للموجه ما يلي: الهدف/المهمة، والتعليمات، والقيود (ما يجب فعله/عدم فعله)، والنبرة/الأسلوب، والسياق/بيانات الخلفية، وأمثلة قليلة، وسلسلة الأفكار، وشكل الاستجابة المطلوب.

تشمل أفضل الممارسات ما يلي:

- حدد أهدافًا واضحة واستخدم أفعالًا تدل على الحركة.

- قدّم السياق والمعلومات الأساسية.

- حدد المجموعة المستهدفة بدقة.

- أخبر الذكاء الاصطناعي بما لا يجب عليه فعله.

- صغ الأسئلة بوضوح وإيجاز وباختيار دقيق للكلمات.

- أضف حدودًا للإنتاج، خاصةً لمهام الكتابة.

- قم بتعيين دور للذكاء الاصطناعي (على سبيل المثال، "أنت مدرس رياضيات").

- يمكن لتسلسل المطالبات (باستخدام مطالبات مترابطة) أن يولد أفكارًا متواصلة.

لا يقتصر التوجيه الفعال على إيجاد "توجيه مثالي" واحد، بل يتعداه إلى تطوير نهج استراتيجي للتفاعل مع نماذج التعلم الآلي. يتضمن ذلك فهم قدرات النموذج، وتحسين التوجيهات بشكل متكرر بناءً على المخرجات، واستخدام تقنيات مثل تحديد الأدوار وتسلسل الأفكار لتوجيه الذكاء الاصطناعي نحو النتائج المرجوة. إنها مهارة تتطلب الممارسة والتفكير النقدي. تُعد القدرة على توفير السياق المناسب وتحديد القيود أمرًا بالغ الأهمية للحصول على نتائج قيّمة من الذكاء الاصطناعي العام. هذا يعني أن جودة المحتوى المُولّد بواسطة الذكاء الاصطناعي غالبًا ما تتناسب طرديًا مع جودة ودقة المدخلات البشرية، مما يؤكد الأهمية المستمرة للخبرة البشرية في هذه العملية.

أفضل الممارسات لإنشاء مطالبات فعالة للذكاء الاصطناعي

يقدم هذا الجدول نصائح عملية وقابلة للتنفيذ يمكن للمديرين والمهنيين تطبيقها على الفور لتحسين تفاعلاتهم مع أدوات الذكاء الاصطناعي التوليدي.

لتحقيق نتائج قيّمة عند استخدام الذكاء الاصطناعي التوليدي، من الضروري اتباع نهج دقيق وواضح، مع تحديد الهدف بدقة واستخدام أفعال تدل على العمل، مثل: "أنشئ قائمة منقّطة تلخص النتائج الرئيسية للورقة البحثية". ومن المهم أيضًا توفير السياق، على سبيل المثال، من خلال تقديم معلومات أساسية وبيانات ذات صلة، مثل: "استنادًا إلى التقرير المالي، حلّل الربحية على مدى السنوات الخمس الماضية". يجب تحديد الجمهور المستهدف والأسلوب المطلوب بوضوح، مثل: "اكتب وصفًا لمنتج موجه للشباب الذين يُقدّرون الاستدامة". يمكن أيضًا إسناد دور أو شخصية محددة للذكاء الاصطناعي، على سبيل المثال: "أنت خبير تسويق. صمّم حملة لـ...". يمكن أن تساعد الأمثلة القصيرة، مثل: "المدخلات: تفاحة. المخرجات: فاكهة. المدخلات: جزرة. المخرجات:"، في توضيح تنسيق المخرجات المطلوب. يُنصح أيضًا بتحديد التنسيق الدقيق للإجابات، مثل: "نسّق إجابتك باستخدام Markdown". تساعد القيود، مثل: "تجنّب المصطلحات التقنية. يجب ألا تتجاوز الإجابة 200 كلمة"، في تحسين المخرجات. يُسهم اتباع نهج تكراري، حيث يتم تعديل التعليمات وتحسينها بناءً على النتائج السابقة، في تحسين الجودة بشكل أكبر. وأخيرًا، يمكن الاستفادة من تسلسل الأفكار من خلال مطالبة الذكاء الاصطناعي بشرح عملية التفكير خطوة بخطوة، على سبيل المثال: "اشرح حجتك خطوة بخطوة".

معالجة الذكاء الاصطناعي غير المرئي: فهم وإدارة التطبيقات الخفية (الذكاء الاصطناعي الخفي)

يشير مصطلح الذكاء الاصطناعي الخفي إلى استخدام الموظفين لأدوات الذكاء الاصطناعي بشكل غير مصرح به أو غير منظم، وغالبًا ما يكون ذلك لزيادة الإنتاجية أو تجاوز الإجراءات الرسمية البطيئة. وهو نوع فرعي من تكنولوجيا المعلومات الخفية.

مخاطر الذكاء الاصطناعي الخفي:

- أمن البيانات والخصوصية: يمكن أن تؤدي الأدوات غير المصرح بها إلى اختراقات البيانات، والكشف عن البيانات العامة/الخاصة بالشركة الحساسة، وعدم الامتثال للائحة العامة لحماية البيانات/قانون HIPAA.

- الامتثال والقانون: انتهاكات قوانين حماية البيانات، وقضايا حقوق النشر، والتعارض مع قوانين حرية المعلومات. إن اشتراط قانون الاتحاد الأوروبي بشأن "الكفاءة في مجال الذكاء الاصطناعي" اعتبارًا من فبراير 2025 يجعل معالجة هذه القضايا أمرًا ملحًا.

- الجوانب الاقتصادية/التشغيلية: هياكل متوازية غير فعالة، وتكاليف خفية من خلال الاشتراكات الفردية، وعدم السيطرة على التراخيص، وعدم التوافق مع الأنظمة الحالية، وتعطيل سير العمل، وانخفاض الكفاءة.

- الجودة والرقابة: انعدام الشفافية في معالجة البيانات، واحتمالية الحصول على نتائج متحيزة أو مضللة، وتآكل الثقة العامة/الداخلية.

- تقويض الحوكمة: التحايل على حوكمة تكنولوجيا المعلومات، مما يجعل من الصعب تطبيق سياسات الأمن.

استراتيجيات إدارة الذكاء الاصطناعي الخفي:

- تطوير استراتيجية واضحة للذكاء الاصطناعي ووضع سياسة مسؤولة للذكاء الاصطناعي.

- توفير أدوات الذكاء الاصطناعي الرسمية والمعتمدة كبدائل.

- وضع مبادئ توجيهية واضحة لاستخدام الذكاء الاصطناعي ومعالجة البيانات والأدوات المعتمدة.

- تدريب الموظفين ورفع مستوى وعيهم بشأن الاستخدام المسؤول للذكاء الاصطناعي والمخاطر وأفضل الممارسات.

- إجراء عمليات تدقيق منتظمة للكشف عن الذكاء الاصطناعي غير المصرح به وضمان الامتثال.

- تبني نهج حوكمة الذكاء الاصطناعي التدريجي، بدءًا بخطوات صغيرة وتحسين السياسات.

- تعزيز التعاون بين الأقسام المختلفة ومشاركة الموظفين.

غالباً ما يكون الذكاء الاصطناعي الخفي عرضاً لاحتياجات المستخدمين غير المُلبّاة أو لإجراءات تبني التكنولوجيا المُعقدة. وقد يأتي اتباع نهج تقييدي بحت ("حظر الذكاء الاصطناعي") بنتائج عكسية. تتطلب الإدارة الفعّالة فهم الأسباب الجذرية وتوفير بدائل آمنة وقابلة للتطبيق إلى جانب حوكمة واضحة. من المرجح أن يكون انتشار أدوات الذكاء الاصطناعي العام (مثل ChatGPT) قد ساهم في تسريع انتشار الذكاء الاصطناعي الخفي. يستطيع الموظفون استخدام هذه الأدوات بسرعة دون تدخل قسم تقنية المعلومات. وهذا ما يجعل التدريب الاستباقي على مهارات الذكاء الاصطناعي (كما هو مطلوب بموجب تشريعات الاتحاد الأوروبي الخاصة بالذكاء الاصطناعي) والتواصل الواضح بشأن الأدوات المعتمدة أكثر أهمية.

مخاطر الذكاء الاصطناعي الخفي والاستجابات الاستراتيجية

يقدم هذا الجدول نظرة عامة منظمة على التهديدات المتنوعة التي يشكلها استخدام الذكاء الاصطناعي غير المنظم، بالإضافة إلى استراتيجيات عملية وملموسة للمديرين.

يشكل الذكاء الاصطناعي الخفي مخاطر عديدة يجب على الشركات معالجتها استراتيجياً. ففي مجال أمن البيانات، قد تحدث تسريبات للبيانات، ووصول غير مصرح به إلى المعلومات الحساسة، وإصابات بالبرمجيات الخبيثة. وتشمل التدابير الاستراتيجية تطبيق سياسة لاستخدام الذكاء الاصطناعي، وإنشاء قائمة بالأدوات المعتمدة، واستخدام التشفير، وتطبيق ضوابط وصول صارمة، وتدريب الموظفين. أما فيما يتعلق بمخاطر الامتثال، مثل انتهاكات اللائحة العامة لحماية البيانات (GDPR)، أو خرق لوائح القطاع، أو انتهاكات حقوق النشر، فإن عمليات التدقيق المنتظمة، وتقييمات أثر حماية البيانات (DPIA) القائمة على البيانات للأدوات الجديدة، وسياسات معالجة البيانات المحددة بوضوح، والاستعانة بمستشار قانوني عند الضرورة، أمور ضرورية. وتنشأ المخاطر المالية من الإنفاق غير المنضبط على الاشتراكات، أو التراخيص الزائدة، أو أوجه القصور. لذلك، ينبغي على الشركات التركيز على الشراء المركزي، والتحكم الصارم في الميزانية، والمراجعة الدورية لاستخدام الأدوات. ويمكن معالجة التحديات التشغيلية، مثل النتائج غير المتسقة، أو عدم التوافق مع أنظمة المؤسسة الحالية، أو اضطرابات العمليات، من خلال توفير أدوات موحدة، ودمجها في سير العمل الحالي، وتطبيق مراقبة الجودة المستمرة. تشكل المخاطر المتعلقة بالسمعة تهديدًا أيضًا، كفقدان ثقة العملاء نتيجة اختراقات البيانات أو الاتصالات المعيبة التي يُنشئها الذكاء الاصطناعي. ويُعدّ التواصل الشفاف والالتزام بالمعايير الأخلاقية ووضع خطة استجابة فعّالة للحوادث إجراءات بالغة الأهمية للحفاظ على ثقة العملاء بالشركة والحدّ من الأضرار المحتملة.

🎯🎯🎯 استفد من خبرة Xpert.Digital الواسعة والمتنوعة في حزمة خدمات شاملة | تطوير الأعمال، والبحث والتطوير، والمحاكاة الافتراضية، والعلاقات العامة، وتحسين الرؤية الرقمية

استفد من الخبرة الواسعة التي تقدمها Xpert.Digital في حزمة خدمات شاملة | البحث والتطوير، والواقع المعزز، والعلاقات العامة، وتحسين الرؤية الرقمية - الصورة: Xpert.Digital

تتمتع Xpert.Digital بمعرفة متعمقة بمختلف الصناعات. يتيح لنا ذلك تطوير استراتيجيات مصممة خصيصًا لتناسب متطلبات وتحديات قطاع السوق المحدد لديك. ومن خلال التحليل المستمر لاتجاهات السوق ومتابعة تطورات الصناعة، يمكننا التصرف ببصيرة وتقديم حلول مبتكرة. ومن خلال الجمع بين الخبرة والمعرفة، فإننا نولد قيمة مضافة ونمنح عملائنا ميزة تنافسية حاسمة.

المزيد عنها هنا:

كيف يُحدث الذكاء الاصطناعي تحولاً في القيادة والتعاون، ويعزز المهارات الشخصية في القيادة: الميزة البشرية في عصر الذكاء الاصطناعي

كيف يُحدث الذكاء الاصطناعي تحولاً في القيادة والتعاون، ويعزز المهارات الشخصية في القيادة: الميزة البشرية في عصر الذكاء الاصطناعي – الصورة: Xpert.Digital

العنصر البشري: تأثير الذكاء الاصطناعي على القيادة والتعاون والإبداع

تغيير القيادة في عصر الذكاء الاصطناعي: متطلبات ومهارات جديدة

يتطلب الذكاء الاصطناعي تحولاً في تركيز القيادة نحو القدرات البشرية الفريدة: الوعي، والتعاطف، والحكمة، والتفهم الاجتماعي، والتواصل الشفاف، والتفكير النقدي، والقدرة على التكيف. يجب على القادة تطوير كفاءتهم التقنية لاتخاذ قرارات مدروسة بشأن أدوات الذكاء الاصطناعي وتوجيه فرق العمل خلال عملية التحول. ويشمل ذلك فهم البيانات وتقييم المعلومات التي يولدها الذكاء الاصطناعي تقييماً نقدياً.

تشمل مسؤوليات القيادة الرئيسية تعزيز ثقافة اتخاذ القرارات القائمة على البيانات، وإدارة التغيير بفعالية، ومعالجة الاعتبارات الأخلاقية من خلال حوكمة الذكاء الاصطناعي، وتشجيع الابتكار والإبداع. يمكن للذكاء الاصطناعي أن يُخفف عن القادة أعباء المهام الروتينية، مما يسمح لهم بالتركيز على الجوانب الاستراتيجية والبشرية، مثل تحفيز الموظفين وتطويرهم. وقد يظهر دور جديد لمنصب رئيس قسم الابتكار والتحول، يجمع بين الخبرة التقنية والمعرفة السلوكية والرؤية الاستراتيجية. سيحتاج القادة إلى التعامل مع بيئات أخلاقية معقدة، وقيادة التحول الثقافي، وإدارة التعاون بين الإنسان والذكاء الاصطناعي، وتعزيز التكامل بين مختلف الأقسام، وضمان الابتكار المسؤول.

لا يقتصر التحدي الأساسي للقادة في عصر الذكاء الاصطناعي على فهم الذكاء الاصطناعي فحسب، بل يتعداه إلى قيادة الاستجابة البشرية له. ويشمل ذلك تنمية ثقافة التعلم، ومعالجة مخاوف فقدان الوظائف، والدعوة إلى الاستخدام الأخلاقي للذكاء الاصطناعي، مما يجعل المهارات الشخصية أكثر أهمية من أي وقت مضى. ثمة تباين محتمل في إدراك أهمية العلاقات الشخصية في عصر الذكاء الاصطناعي: إذ يعتبرها 82% من الموظفين أساسية، مقارنةً بـ 65% فقط من القادة. قد تؤدي هذه الفجوة إلى استراتيجيات قيادية لا تستثمر بالقدر الكافي في العلاقات الإنسانية، مما قد يضر بالروح المعنوية والتعاون. تتطلب القيادة الفعالة في مجال الذكاء الاصطناعي مجموعة مهارات تبدو متناقضة: قبول الموضوعية القائمة على البيانات من الذكاء الاصطناعي، مع تعزيز الحكم البشري الذاتي والحدس والتفكير الأخلاقي في الوقت نفسه. إنها تتعلق بتعزيز الذكاء البشري، لا الاستسلام للذكاء الاصطناعي.

مناسب ل:

تحوّل العمل الجماعي: تأثير الذكاء الاصطناعي على التعاون وديناميكيات الفريق

يمكن للذكاء الاصطناعي تحسين العمل الجماعي من خلال أتمتة المهام الروتينية، مما يتيح للموظفين التركيز على العمل الاستراتيجي والإبداعي. كما يمكن لأنظمة الذكاء الاصطناعي دعم اتخاذ قرارات أفضل من خلال تحليل البيانات وتزويد الفرق برؤى ثاقبة. وتساهم أدوات الذكاء الاصطناعي في تعزيز التواصل والتنسيق، مما يتيح التعاون الفوري وتبادل المعلومات والموارد. ويمكن لإدارة المعرفة القائمة على الذكاء الاصطناعي تسهيل الوصول إلى المعرفة المركزية، وتمكين البحث الذكي، وتعزيز تبادل المعرفة. إن الجمع بين الإبداع البشري والحكم السليم والذكاء العاطفي مع قدرات الذكاء الاصطناعي في تحليل البيانات والأتمتة من شأنه أن يؤدي إلى عمل أكثر كفاءة واستنارة.

وتشمل التحديات ضمان حماية البيانات والتعامل الأخلاقي مع البيانات في أدوات الذكاء الاصطناعي التعاونية، واحتمالية "فقدان المهارات" بين الموظفين إذا تولى الذكاء الاصطناعي الكثير من المهام دون وجود استراتيجية لمزيد من التدريب، والخوف من أن تصبح الاتصالات الشخصية أقل تواتراً.

مع أن الذكاء الاصطناعي يُحسّن كفاءة التعاون (مثل تسريع جمع المعلومات وأتمتة المهام)، إلا أنه يتعين على القادة العمل بجدّ للحفاظ على جودة التفاعل البشري وتماسك الفريق. وهذا يعني تصميم سير العمل بحيث يُكمّل الذكاء الاصطناعي أعضاء الفريق بدلاً من عزلهم، وخلق فرص للتواصل الإنساني الحقيقي. يعتمد نجاح دمج الذكاء الاصطناعي في العمل الجماعي بشكل كبير على الثقة - الثقة في موثوقية التكنولوجيا ونزاهتها، وكذلك ثقة أعضاء الفريق في كيفية استخدام الرؤى المُستمدة من الذكاء الاصطناعي. ويمكن أن يؤدي انعدام الثقة إلى المقاومة وتقويض الجهود التعاونية.

الذكاء الاصطناعي كشريك إبداعي: توسيع نطاق الإبداع وإعادة تعريفه في المؤسسات

يمكن للذكاء الاصطناعي التوليدي، عند تطبيقه استراتيجياً وبدقة، أن يخلق بيئةً تتعايش فيها الإبداعات البشرية مع الذكاء الاصطناعي وتتعاون فيما بينها. يستطيع الذكاء الاصطناعي تعزيز الإبداع من خلال العمل كشريك، وتقديم رؤى جديدة، وتوسيع آفاق الممكن في مجالات مثل الإعلام والفنون والموسيقى. كما يمكنه أتمتة الجوانب الروتينية للعمليات الإبداعية، مما يتيح للأفراد التفرغ لأعمال أكثر ابتكاراً وتأملاً. ويمكنه أيضاً المساعدة في تحديد الاتجاهات الناشئة أو تسريع تطوير المنتجات من خلال التجارب المدعومة بالذكاء الاصطناعي.

تنشأ المعضلات والتحديات الأخلاقية من كون المحتوى المُولّد بواسطة الذكاء الاصطناعي يُشكك في المفاهيم التقليدية للتأليف والأصالة والاستقلالية والنية. ويُعدّ استخدام البيانات المحمية بحقوق الطبع والنشر لتدريب نماذج الذكاء الاصطناعي، وتوليد محتوى قد ينتهك هذه الحقوق، من المخاوف الجدية. علاوة على ذلك، ثمة خطر الإفراط في الاعتماد على الذكاء الاصطناعي، الأمر الذي قد يُعيق على المدى البعيد الاستكشاف الإبداعي البشري المستقل وتنمية المهارات.

إن دمج الذكاء الاصطناعي في العمليات الإبداعية ليس مجرد مسألة أدوات جديدة، بل هو إعادة تعريف جوهرية للإبداع نفسه، نحو نموذج للإبداع المشترك بين الإنسان والذكاء الاصطناعي. ويتطلب هذا تحولاً في طريقة تفكير المبدعين وقادتهم، تحولاً يُركز على التعاون مع الذكاء الاصطناعي كأسلوب جديد. وتعني الاعتبارات الأخلاقية المحيطة بالمحتوى المُولّد بالذكاء الاصطناعي (حقوق التأليف، والتحيز، والتزييف العميق) أنه لا يمكن للمؤسسات ببساطة تبني أدوات الذكاء الاصطناعي الإبداعية دون وجود مبادئ توجيهية أخلاقية صارمة وإشراف دقيق. ويجب على القادة ضمان استخدام الذكاء الاصطناعي بمسؤولية لتعزيز الإبداع، لا للخداع أو انتهاك الحقوق.

إرساء النظام: تطبيق حوكمة الذكاء الاصطناعي من أجل تحول مسؤول

ضرورة حوكمة الذكاء الاصطناعي: لماذا هي مهمة لشركتك

تضمن حوكمة الذكاء الاصطناعي تطوير ونشر أنظمة الذكاء الاصطناعي بشكل أخلاقي وشفاف، ووفقًا للقيم الإنسانية والمتطلبات القانونية.

تشمل الأسباب الرئيسية لحوكمة الذكاء الاصطناعي ما يلي:

- الاعتبارات الأخلاقية: تتناول احتمالية اتخاذ قرارات متحيزة ونتائج غير عادلة، وتضمن العدالة واحترام حقوق الإنسان.

- الامتثال القانوني والتنظيمي: يضمن الامتثال للقوانين المتطورة الخاصة بالذكاء الاصطناعي (مثل قانون الذكاء الاصطناعي للاتحاد الأوروبي) ولوائح حماية البيانات الحالية (GDPR).

- إدارة المخاطر: توفر إطارًا لتحديد وتقييم ومراقبة المخاطر المرتبطة بالذكاء الاصطناعي، مثل فقدان ثقة العملاء، أو فقدان الكفاءة، أو عمليات صنع القرار المتحيزة.

- الحفاظ على الثقة: يعزز الشفافية وقابلية التفسير في قرارات الذكاء الاصطناعي ويخلق الثقة بين الموظفين والعملاء وأصحاب المصلحة.

- تعظيم القيمة: يضمن أن استخدام الذكاء الاصطناعي يتماشى مع أهداف العمل وأن فوائده تتحقق بشكل فعال.

بدون حوكمة سليمة، يمكن أن يؤدي الذكاء الاصطناعي إلى أضرار غير مقصودة، وانتهاكات أخلاقية، وعقوبات قانونية، وتشويه السمعة.

لا تقتصر حوكمة الذكاء الاصطناعي على مجرد الامتثال أو تخفيف المخاطر، بل هي عامل تمكين استراتيجي. فمن خلال وضع قواعد ومسؤوليات ومبادئ توجيهية أخلاقية واضحة، تستطيع المؤسسات تهيئة بيئة تزدهر فيها ابتكارات الذكاء الاصطناعي بمسؤولية، مما يؤدي إلى حلول ذكاء اصطناعي أكثر استدامة وموثوقية. وتتناسب الحاجة إلى حوكمة الذكاء الاصطناعي طرديًا مع تزايد استقلالية أنظمة الذكاء الاصطناعي وتعقيدها. ومع انتقال المؤسسات من مساعدي الذكاء الاصطناعي البسيطين إلى وكلاء ونماذج ذكاء اصطناعي أكثر تطورًا، يجب أن يتطور نطاق الحوكمة ودقتها لمواجهة التحديات الجديدة المتعلقة بالمساءلة والشفافية والتحكم.

أطر عمل وأفضل الممارسات لحوكمة الذكاء الاصطناعي الفعالة

تتراوح أساليب الحوكمة من غير الرسمية (القائمة على قيم الشركة) إلى الحلول المخصصة (الاستجابة لمشاكل محددة) إلى الرسمية (الأطر الشاملة).

أطر العمل الرائدة (أمثلة):

- إطار إدارة مخاطر الذكاء الاصطناعي التابع للمعهد الوطني للمعايير والتكنولوجيا (AI RMF): يركز على مساعدة المؤسسات في إدارة المخاطر المتعلقة بالذكاء الاصطناعي من خلال وظائف مثل التحكم، ورسم الخرائط، والقياس، والإدارة.

- ISO 42001: يضع نظامًا شاملاً لإدارة الذكاء الاصطناعي يتطلب سياسات وإدارة مخاطر وتحسينًا مستمرًا.

- مبادئ منظمة التعاون الاقتصادي والتنمية بشأن الذكاء الاصطناعي: تعزيز الاستخدام المسؤول للذكاء الاصطناعي والتأكيد على حقوق الإنسان والإنصاف والشفافية والمساءلة.

أفضل الممارسات للتنفيذ:

- إنشاء هياكل حوكمة داخلية (مثل مجالس أخلاقيات الذكاء الاصطناعي، ومجموعات العمل متعددة الوظائف) بأدوار ومسؤوليات واضحة.

- تطبيق نظام تصنيف قائم على المخاطر لتطبيقات الذكاء الاصطناعي.

- ضمان حوكمة وإدارة قوية للبيانات، بما في ذلك جودة البيانات وحماية البيانات والتحقق من التحيز.

- إجراء تقييمات الامتثال والمطابقة بناءً على المعايير واللوائح ذات الصلة.

- يتطلب الأمر إشرافاً بشرياً، لا سيما بالنسبة للأنظمة عالية المخاطر والقرارات الحاسمة.

- إشراك أصحاب المصلحة (الموظفين والمستخدمين والمستثمرين) من خلال التواصل الشفاف.

- تطوير مبادئ توجيهية أخلاقية واضحة ودمجها في دورة تطوير الذكاء الاصطناعي.

- الاستثمار في التدريب وإدارة التغيير لضمان فهم وقبول سياسات الحوكمة.

- ابدأ بحالات استخدام محددة بوضوح ومشاريع تجريبية، ثم قم بالتوسع تدريجياً.

- الاحتفاظ بدليل لأنظمة الذكاء الاصطناعي المستخدمة في الشركة.

لا يُعدّ تطبيق حوكمة الذكاء الاصطناعي الفعّالة حلاً واحداً يناسب الجميع. يجب على المؤسسات تكييف أطر عمل مثل إطار إدارة مخاطر الذكاء الاصطناعي التابع للمعهد الوطني للمعايير والتكنولوجيا (NIST AI RMF) أو معيار ISO 42001 مع قطاعها وحجمها ومستوى تقبّلها للمخاطر وأنواع الذكاء الاصطناعي التي تستخدمها. من غير المرجّح أن يكون تبنّي إطار عمل نظرياً دون تكييفه عملياً فعالاً. يُعدّ "العامل البشري" في حوكمة الذكاء الاصطناعي بنفس أهمية "العمليات" و"التكنولوجيا". ويشمل ذلك تحديد المسؤوليات بوضوح، وتوفير تدريب شامل، وتعزيز ثقافة تُقدّر الاستخدام الأخلاقي والمسؤول للذكاء الاصطناعي. فبدون قبول الموظفين وفهمهم، حتى أفضل أطر الحوكمة تصميماً ستفشل.

المكونات الرئيسية لإطار حوكمة الذكاء الاصطناعي

يوفر هذا الجدول قائمة مرجعية شاملة ودليلًا للمديرين التنفيذيين الذين يرغبون في إنشاء أو تحسين حوكمة الذكاء الاصطناعي الخاصة بهم.

تُعدّ المكونات الأساسية لإطار حوكمة الذكاء الاصطناعي بالغة الأهمية لضمان استخدامه المسؤول والفعّال. ينبغي أن تعكس المبادئ الأساسية والمبادئ التوجيهية الأخلاقية قيم المؤسسة وأن تتوافق مع حقوق الإنسان والعدالة والشفافية. يجب تحديد الأدوار والمسؤوليات بوضوح، بما في ذلك لجنة أخلاقيات الذكاء الاصطناعي، ومراقبي البيانات، ومراجعي النماذج، مع تحديد واجباتهم وسلطة اتخاذ القرار والمساءلة بشكل واضح. تتطلب الإدارة الفعّالة للمخاطر تحديدها وتقييمها والتخفيف من آثارها، وفقًا لتصنيفات تشريعات الاتحاد الأوروبي للذكاء الاصطناعي، على سبيل المثال. وتلعب التقييمات الدورية للمخاطر، فضلًا عن تطوير استراتيجيات التخفيف ومراقبتها، دورًا محوريًا في هذا الصدد. تضمن حوكمة البيانات مراعاة جوانب مثل الجودة وحماية البيانات والأمن وكشف التحيز، بما في ذلك الامتثال للائحة العامة لحماية البيانات (GDPR) وتدابير مكافحة التمييز. تشمل إدارة دورة حياة النموذج عمليات موحدة للتطوير والتحقق والنشر والمراقبة والإيقاف، مع التركيز بشكل خاص على التوثيق والترقيم والمراقبة المستمرة للأداء. تُعدّ الشفافية وقابلية التفسير أساسيتين لضمان تتبع قرارات الذكاء الاصطناعي والإفصاح عن استخدامه. يجب ضمان الامتثال للمتطلبات القانونية، مثل توجيه الاتحاد الأوروبي بشأن الذكاء الاصطناعي واللائحة العامة لحماية البيانات (GDPR)، من خلال المراجعة المستمرة وتعديل العمليات، بالإضافة إلى التعاون مع الإدارة القانونية. وتُعزز برامج التدريب والتوعية للمطورين والمستخدمين والمديرين فهم أساسيات الذكاء الاصطناعي والاعتبارات الأخلاقية ومبادئ الحوكمة. وأخيرًا، يجب ضمان الاستجابة للحوادث وحلها بفعالية لمعالجة الأعطال والانتهاكات الأخلاقية والحوادث الأمنية. ويشمل ذلك قنوات إبلاغ مُعتمدة، وإجراءات تصعيد، وإجراءات تصحيحية تُمكّن من التدخل السريع والمُوجّه.

مناسب ل:

أخذ زمام المبادرة: الضرورات الاستراتيجية للتحول في مجال الذكاء الاصطناعي

تنمية الجاهزية للذكاء الاصطناعي: دور التعلم المستمر والتدريب الإضافي

إلى جانب الخبرة التقنية، يحتاج المديرون التنفيذيون في المقام الأول إلى فهم استراتيجي للذكاء الاصطناعي للارتقاء بشركاتهم بفعالية. ينبغي أن يشمل التدريب على الذكاء الاصطناعي للمديرين التنفيذيين أساسيات الذكاء الاصطناعي، ودراسات الحالة الناجحة، وإدارة البيانات، والاعتبارات الأخلاقية، وتحديد إمكانات الذكاء الاصطناعي داخل مؤسساتهم. ينص توجيه الاتحاد الأوروبي بشأن الذكاء الاصطناعي (المادة 4) على ضرورة امتلاك "الكفاءة في مجال الذكاء الاصطناعي" للعاملين المشاركين في تطوير أو نشر أنظمة الذكاء الاصطناعي، اعتبارًا من 2 فبراير 2025. ويشمل ذلك فهم تقنيات الذكاء الاصطناعي، ومعرفة تطبيقاتها، ومهارات التفكير النقدي، والأطر القانونية ذات الصلة.

تشمل فوائد التدريب على الذكاء الاصطناعي للمديرين القدرة على إدارة مشاريع الذكاء الاصطناعي، ووضع استراتيجيات مستدامة له، وتحسين العمليات، واكتساب مزايا تنافسية، وضمان استخدام أخلاقي ومسؤول له. ويُعدّ نقص الكفاءة والمهارات في مجال الذكاء الاصطناعي عائقًا كبيرًا أمام تبنّيه. تتوفر أشكال تدريبية متنوعة، منها برامج الشهادات، والندوات، والدورات التدريبية عبر الإنترنت، والتدريب الحضوري.

إنّ الاستعداد للذكاء الاصطناعي يتجاوز مجرد اكتساب المهارات التقنية؛ فهو يعني أيضاً تعزيز عقلية التعلّم المستمر والتكيّف في جميع أنحاء المؤسسة. ونظراً للوتيرة السريعة لتطوير الذكاء الاصطناعي، قد يصبح التدريب القائم على أدوات محددة قديماً بسرعة. لذا، تُعدّ المعرفة الأساسية بالذكاء الاصطناعي ومهارات التفكير النقدي استثمارات أكثر استدامة. يعمل "التزام الكفاءة في الذكاء الاصطناعي" في قانون الاتحاد الأوروبي كحافز تنظيمي لرفع مستوى المهارات، ولكن ينبغي للمؤسسات أن تنظر إلى هذا كفرصة، لا كعبء امتثال فحسب. فالقوى العاملة الأكثر إلماماً بالذكاء الاصطناعي تكون أكثر قدرة على تحديد تطبيقات الذكاء الاصطناعي المبتكرة، واستخدام الأدوات بفعالية، وفهم الآثار الأخلاقية، مما يؤدي إلى نتائج أفضل في مجال الذكاء الاصطناعي بشكل عام. ثمة ارتباط واضح بين نقص مهارات/فهم الذكاء الاصطناعي وانتشار الذكاء الاصطناعي غير المصرح به. ويمكن للاستثمار في تعليم شامل للذكاء الاصطناعي أن يُخفف بشكل مباشر من المخاطر المرتبطة بالاستخدام غير المصرح به للذكاء الاصطناعي من خلال تمكين الموظفين من اتخاذ قرارات مستنيرة ومسؤولة.

توليف الفرص والمخاطر: خارطة طريق للريادة السيادية في مجال الذكاء الاصطناعي

إن قيادة التحول في مجال الذكاء الاصطناعي تتطلب فهمًا شاملاً لإمكانات التكنولوجيا (الابتكار، والكفاءة، والجودة) ومخاطرها الكامنة (الأخلاقية، والقانونية، والاجتماعية).

تتضمن القيادة السيادية للذكاء الاصطناعي تشكيل مسار الذكاء الاصطناعي للمنظمة بشكل استباقي من خلال:

- إرساء حوكمة قوية للذكاء الاصطناعي تستند إلى المبادئ الأخلاقية والأطر القانونية مثل قانون الذكاء الاصطناعي للاتحاد الأوروبي.

- تعزيز ثقافة التعلم المستمر والكفاءة في مجال الذكاء الاصطناعي على جميع المستويات.

- تحديد أولويات حالات استخدام الذكاء الاصطناعي بشكل استراتيجي والتي تقدم قيمة ملموسة.

- تعزيز المواهب البشرية من خلال التركيز على المهارات التي يكملها الذكاء الاصطناعي بدلاً من استبدالها، وإدارة التأثير البشري للذكاء الاصطناعي.

- الإدارة الاستباقية للتحديات الناشئة مثل الذكاء الاصطناعي الخفي.

الهدف الأسمى هو تسخير الذكاء الاصطناعي كعامل تمكين استراتيجي لتحقيق نمو مستدام وميزة تنافسية، مع الحد من سلبياته المحتملة. تتجاوز القيادة السيادية الحقيقية للذكاء الاصطناعي الإدارة الداخلية للمؤسسة، لتشمل فهمًا أوسع لتأثير الذكاء الاصطناعي على المجتمع ودور الشركة ضمن هذا النظام. وهذا يعني المشاركة في مناقشات السياسات، والمساهمة في وضع المعايير الأخلاقية، وضمان استخدام الذكاء الاصطناعي للصالح العام، وليس فقط لتحقيق الربح للشركات. إن رحلة التحول نحو الذكاء الاصطناعي غير خطية، وستتضمن التعامل مع الغموض والتحديات غير المتوقعة. لذا، يجب على القادة تنمية المرونة والقدرة على التكيف لدى مؤسساتهم، لكي تتمكن فرقهم من التكيف مع التطورات التكنولوجية غير المتوقعة، والتغيرات التنظيمية، أو اضطرابات السوق الناجمة عن الذكاء الاصطناعي.

مناسب ل:

- العشرة الأوائل للاستشارات والتخطيط - نظرة عامة ونصائح حول الذكاء الاصطناعي: نماذج الذكاء الاصطناعي المختلفة ومجالات التطبيق النموذجية

فهم واستخدام التقنيات: أساسيات الذكاء الاصطناعي لصناع القرار

لم يعد التحول عبر الذكاء الاصطناعي مجرد رؤية مستقبلية بعيدة، بل أصبح واقعاً ملموساً يفرض تحديات على الشركات من جميع الأحجام والقطاعات، وفي الوقت نفسه يتيح فرصاً هائلة. بالنسبة للمتخصصين والمديرين، يعني هذا الاضطلاع بدور فاعل في صياغة هذا التغيير، من أجل الاستفادة بمسؤولية من إمكانيات الذكاء الاصطناعي وإدارة المخاطر المصاحبة له بثقة.

تُشكّل أساسيات الذكاء الاصطناعي، بدءًا من النماذج التوليدية والتمييز بين المساعدين والوكلاء، وصولًا إلى المحركات التكنولوجية كالتعلّم الآلي والنماذج الأساسية، حجر الزاوية لفهم أعمق. هذه المعرفة ضرورية لاتخاذ قرارات مدروسة بشأن نشر أنظمة الذكاء الاصطناعي ودمجها.

يُحدد الإطار القانوني، ولا سيما توجيه الاتحاد الأوروبي بشأن الذكاء الاصطناعي، مبادئ توجيهية واضحة لتطوير الذكاء الاصطناعي وتطبيقه. ويستلزم النهج القائم على المخاطر والالتزامات المترتبة عليه، خاصةً فيما يتعلق بالأنظمة عالية المخاطر والكفاءة المطلوبة للموظفين في مجال الذكاء الاصطناعي، اتباع نهج استباقي وتطبيق هياكل حوكمة متينة. ويجب حل التوتر القائم بين السعي نحو الابتكار وضرورة المساءلة من خلال استراتيجية متكاملة تُراعي الامتثال والأخلاقيات كعنصرين أساسيين في عملية الابتكار.

تتنوع التطبيقات المحتملة للذكاء الاصطناعي وتمتد عبر مختلف القطاعات. ويُعدّ تحديد حالات الاستخدام المناسبة، وإتقان تقنيات التفاعل الفعّالة مثل التوجيه، والإدارة الواعية للتطبيقات غير المستخدمة، من الكفاءات الأساسية لتحقيق القيمة المضافة للذكاء الاصطناعي ضمن نطاق مسؤولية الفرد.

وأخيرًا وليس آخرًا، يُحدث الذكاء الاصطناعي تغييرًا جذريًا في أساليب القيادة والتعاون وتنمية الإبداع. ويواجه القادة تحديًا يتمثل في تطوير مهاراتهم، وإيلاء مزيد من الاهتمام للقدرات البشرية كالتّعاطف والتفكير النقدي وإدارة التغيير، وخلق بيئة عمل تتكامل فيها جهود الإنسان والآلة. ويتطلب تعزيز التعاون ودمج الذكاء الاصطناعي كشريك إبداعي أساليب تفكير وإدارة جديدة.

إنّ إرساء حوكمة شاملة للذكاء الاصطناعي ليس أمراً اختيارياً، بل ضرورة استراتيجية. فهو يُرسي إطاراً لاستخدام الذكاء الاصطناعي بشكل أخلاقي وشفاف وآمن، ويُقلل المخاطر، ويبني الثقة بين جميع الأطراف المعنية.

إن التحول نحو الذكاء الاصطناعي رحلة تتطلب التعلم المستمر، والقدرة على التكيف، ورؤية واضحة. إن المهنيين والمدراء الذين يتقبلون هذه التحديات ويستوعبون المبادئ والممارسات الموضحة هنا، يكونون مؤهلين تماماً لتشكيل مستقبل مؤسساتهم وأقسامهم وفرقهم بطريقة سليمة وواثقة في عصر الذكاء الاصطناعي.